来源:venturebeat,编辑:张佳

近日,美国国会众议院情报常设委员会与一个法律和人工智能专家小组进行了交谈,讨论了人工智能操纵媒体的潜力,如利用Deepfake削弱对民主机构和新闻媒体的公信力,以及外国对手用它干扰人们对于真实内容的感知。

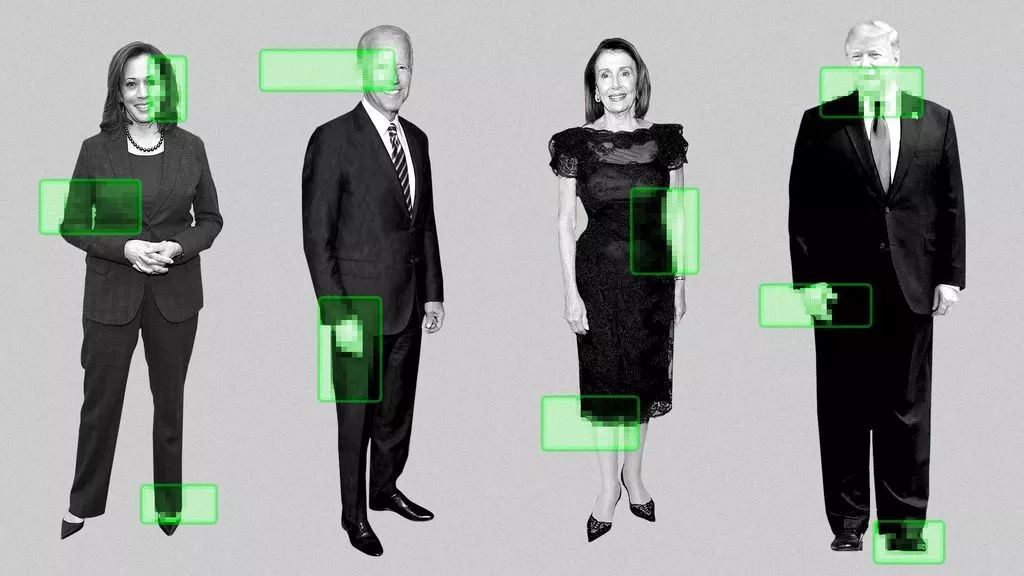

参会者们很想知道,在即将到来的选举年,如果民主党总统候选人Joe Biden等深陷deepfake诽谤,或者媒体、情报机构或军事组织再也不能核实视频中所看到事件的真实性,会发生什么。

在商业领域,听证会上考虑的一个Deepfake情景是在IPO前发布的一段模仿CEO的恶意视频,导致公司交易的第一天股票大跌。

攻击性网络时代已经到来

委员会主席、众议员Adam Schiff (D-CA) 说:“即使后来确定他们所看到的是假的,那种负面印象也会挥之不去。”

Schiff和国会其他多名议员去年秋天呼吁联邦政府对Deepfake采取行动。

“如果一个信息消费者不知道该相信什么,他们不能从虚构中辨别事实,那么他们要么相信一切,要么什么都不相信。如果他们什么都不相信,那就会导致长期的冷漠,这对美国是有害的,”外交政策研究所研究员Clint Watts告诉委员会。

Watts表示,社交媒体公司、州和国家选举官员必须做好Deepfake视频将在2020年选举出现却声称是声称投票机出现故障的准备。他说:“我认为攻击性网络时代已经到来。”

在情报委员会听证会之前,特朗普总统发布了一段由Facebook支持的众议院发言人Nancy Pelosi的篡改视频,以及Facebook首席执行官马克·扎克伯格本周早些时候发布在Instagram上的一段Deepfake视频,这两个视频都经过了详细讨论。

美联社报道,电脑生成的图片被用来伪造与美国公共政策和外交官员有关的LinkedIn档案。新智元对此也进行了报道:《AI版007恐怖上演!间谍用GAN生成假头像,大肆网钓政客大V》。

皮尤研究中心美国趋势小组在2月至3月进行的一项调查发现,假新闻被视为比暴力犯罪、种族主义、非法移民或恐怖主义更大的问题。

对抗Deepfake不仅是政府的事

与委员会交谈的专家一致提出了共同标准,并在Facebook和Twitter等社交媒体公司之间分享信息,以对抗Deepfake。University of Maryland Francis King Carey School of Law教授Danielle Citron也希望修改《通信规范法案》(Communications Decency Act)第230条(现在大意为“互联网服务不必为其用户的行为负责”),使社交媒体平台必须采取“合理的内容节制”(Rational Content Moderation),以保留诽谤诉讼的法律豁免权。

Citron说:“我们不想进入一个思想市场失灵的地方。”当大法官Oliver Wendell Holmes提出思想市场(marketplace of ideas)的概念时,他是一个愤世嫉俗的人。他并不是在暗示真相总是会消失,他担心人性,但在我们民主基础上的更广泛的努力是,我们可以有一套公认的真理,这样我们就可以进行真正有意义的政策对话。我们不能放弃这个项目。”

研究工作正在各种环境下进行,以打击Deepfake。作为DARPA媒体取证小组的负责人,去年,人工智能研究所主任David Doermann博士和研究人员,通过追踪不规则眼球运动等方式开始创造AI系统,艾伦人工智能研究所(Allen Institute for Manificial Intelligence)还分享了Grover,一种声称达到92%准确率的Deepfake检测算法。

Deepfake检测研讨会将在国际机器学习大会(ICML)和国际计算机视觉与模式识别会议(CVPR)上举行,这两个年度人工智能大会将在加利福尼亚长滩举行。

尽管如此,Doormann表示,能够操纵的生成模型(比如Facebook听起来像比尔·盖茨的MelNet或英伟达的StyleGAN制造假人脸)远远比能够检测操纵的多。Doermann同意社交媒体公司之间的共同标准是必要的,但个人标准才是最重要的。

“我们需要把工具和过程掌握在个人手中,而不是完全依赖政府或社交媒体平台来监管内容,”他说:“事实上,分享这些东西的人是问题的一部分,即使他们不知道。”

为此,Doermann支持教育公众的努力,但也提出了一种可能性,即最终,对抗Deepfake“可能是一场永远无法取胜的战争”。

与该小组交谈的专家包括OpenAI政策主管Jack Clark。OpenAI是一家创建于2015年的非盈利组织,拥有超过10亿美元的支持,2月份由于担心GPT-2语言理解模型可能被误用而拒绝共享代码。

Clark认为大型技术平台应该在个人账户和平台层面上开发和共享用于检测恶意合成媒体的工具,就像他们今天在网络安全方面所做的那样。标准化可以帮助那些似乎在“黑暗中摸索”政策以解决难题的社交媒体公司。

“我们将继续对这一领域的技术进步感到惊讶,因为很多这方面的知识都是因为这些人(人工智能从业者)认为他们是莱特兄弟,你知道他们觉得,他们都在忙着创造东西,弄清楚他们建造的东西的二阶效应是困难的,”Clark说:“因此,我认为我们确实需要构建基础设施,这样就有了一些第三方来衡量这些技术的进展,这样就可以预测其他事情了。”

Deepfake并非一无是处,但需要谨慎使用

专家组几乎一致同意,除了错误信息外,生成模型有积极的应用。用于模仿其他视觉训练数据的合成数据正被Landing.ai和Element AI等公司用于改进具有少量数据的训练AI系统。用于训练AI系统的合成数据比实际数据更便宜且更容易收集。

该小组还提醒委员会,基本上任何拥有体面计算机的新手都可以访问免费提供的开源软件来生成Deepfake。 “deepfake”一词源于2017年提供的软件,用于将名人的脸放在色情明星的身上。

Citron还敦促政治候选人在即将到来的选举年进行政治斗争时,避免使用Deepfake。

参考链接

https://venturebeat.com/2019/06/13/u-s-congress-targets-deepfakes-ahead-of-2020-election/

声明:本文来自新智元,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。