俗话说“眼见为实,耳听为虚”,而当科技发展至今,人们亲眼所见也不一定就是“真相”。前一段时间异常火爆的换脸 app ZAO,用户只需上传自己的面部照片,就能在 AI 的帮助下替换掉影视剧中演员的脸,让明星们变成用户的“替身”。虽然 ZAO 没有披露应用的技术细节,但其与开源的 Deepfakes“换脸”技术有着极强的相似性。

而 Deepfakes 技术最早起源于两年前,目前有九成以上的应用都落在色情领域。在 2017 年,第一批应用该技术制作的换脸视频被用户传到了 Reddit 论坛上。只要有脸部照片,这项技术就能将视频中的人脸替换成任何一个你想看的人,而且效果十分逼真,肉眼难辨真假。

随着 AI 技术的飞速发展,其在一些应用领域带来的安全风险与日俱增。尤其是人脸识别,作为 AI 技术落地最广泛的场景之一,面临的安全、伦理和道德等挑战愈发严峻。人脸信息作为个人隐私中十分重要且敏感的一部分,已经和智能设备解锁、支付,甚至一些公共设施、政府类等业务的身份验证直接绑定在一起。一旦出现问题,不论是在金融、还是公共安全等领域都将造成巨大威胁。

针对该问题,美国学术界、政府机构和一些企业已经着手研究反制措施。通过设计独特的图像与视频验证技术、标记技术等手段,比如在拍摄时自动添加时间、定位等信息内容,来对抗“AI 换脸”带来的威胁。

在我国,也已经有研究人员对此展开深入探索。近日,IEEE(电气与电子工程师协会)在北京举行了年度媒体交流会,邀请到了 IEEE 高级会员、中国科学院自动化研究所副研究员、 中国人工智能学会理事董晶博士,对外分享如何以 AI 技术赋能图像识别,通过视频内容取证来应对威胁。会后,董晶也接受了 DeepTech 的独家专访。

图 | 董晶博士(来源:IEEE)

内容取证以反制“AI 赝品”

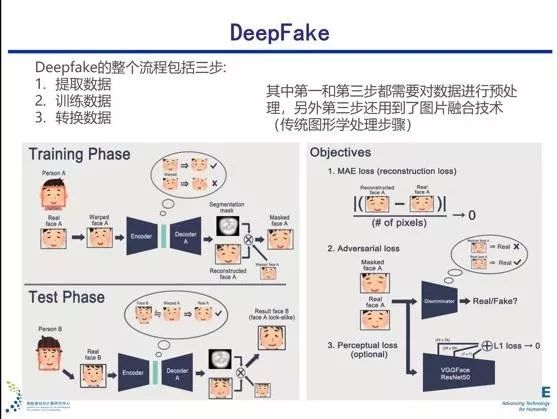

“换脸”技术如今愈发大众化的原因,在于其突破了传统技术特点,传统的“换脸”技术以计算机图形学为基础,技术门槛较高,模型拥有一定商业价值,所以算法的源码或模型并没有公开。同时,其对人员的专业技术水平和设备要求都很高,模型也多为公共干预生成。

而现在的“换脸”则应用生成对抗网络(GANs)技术,以其为基础的算法源代码、数据库和训练模型也有很多都已经公开,从而降低了使用门槛和操作难度。生成对抗网络有两个模块,一个负责生成伪图,另一个负责鉴别生成图片的质量,并通过对抗博弈的方式不断进化,从而达到以假乱真的水平。

这样一来,有一定计算机专业基础、掌握函数接口调用的人就可以上手操作设计出相关应用。总之,生成对抗网络将“换脸”变得智能、自主,并且可进化。

生成对抗网络的提出也是继深度神经网络之后的又一革命性进展,在 2018 年被《麻省理工科技评论》评为当年“全球十大突破性技术”(10 Breakthrough Technologies 2018)。

图 | DeepFake(来源:董晶)

董晶目前的研究方向是从视觉系统与数字成像系统的认知差异性出发,面向海量数据的视觉内容取证的理论与应用方法。简单来说,人们肉眼判断视觉内容的真实程度和完整度,是通过感官分析和主观意识来进行判断的。但使用计算机,可以通过数据获取、特征分析,以及分类识别的方式进行视觉内容取证并判断。

“对于已经公开的算法模型,目前采用针对性的模式识别(反制)的效果是很好的,因为已经‘知己知彼’了么。但该方向的学术研究意义较小,在学术界尚未成熟。”董晶说,“而通用性的模式识别方法,目前来说是可行的,但难度较大。”

通用性模式识别的关键,在于找到生成的“赝品”数据目标中难以做到与“正品”一致的部分。就是说,即便是“换脸”视频制作得十分精良,很好地模仿了人眼视觉系统(Human Visual System,HVS),在感观层面做到以假乱真,但在其他方面却未必如此。

董晶带领她的课题组,从传统的取证方法中“取其精华”,将像素层、场景层和语义层三种取证分析方式相结合,在深度取证领域取得了一定突破。她表示:“我们首先要确定人类视觉系统和计算机视觉系统在识别特定信息的认知特性、机理与计算方法;进而从两者的认知差异性出发,通过计算的差异性和关联性来鉴别图像真伪。”

目前,董晶的研究可以利用 AI 通过市场上普通的摄像头远程分析出人的心率、呼吸频率等生理特征,进而辨别视频中人像的真伪。在 AI 的帮助下,原本肉眼无法看到的人脸颊上极为微小的起伏变化等生理信号,也能以数据化的形式显示出来,突破人眼视觉系统的盲区,从而达到深度鉴别的目的。

但如果想真正地在信息内容真伪识别中广泛且有效地应用 AI 技术,就和杀毒软件与病毒之间的关系一样,需要不断研究“魔高一尺,道高一丈”的 AI 反制技术,通过不断地研发升级,为信息安全筑建“铜墙铁壁”。

图 | 通过普通摄像头进行心率监测(来源:IEEE)

关于 AI 研究与应用的看法

人工智能,自 1956 年被提出,几经波折,最终在 2012 年以后迎来爆发。而在 2018 ~ 2019 年里,AI 领域的论文数量激增,所谓“灌水”之声也随之而来。

针对 AI 领域学术论文“灌水”一说,董晶表示:“首先,‘灌水’这件事情是不可能长期灌下去的。因为技术本身是有验证性的,同时,期刊和相关会议都有成熟的审稿机制。但话说来,会出现‘灌水’说法的原因其实是让业内科研人员比较欣慰的,说明有越来越多的人关注这个领域。”

“在这一年里,一些有关 AI 的会议从之前参会的三四百人,到如今开个大会至少有三四千人来参加。实际上,这个会议里有那么多专家么?没有的,有很多人是来探探风口,了解一下转到这个方向来是不是合适。”董晶说。

她表示,首先要鼓励更多的与 AI 相关的科研人员都来关注 AI 领域,这样一些研究才可能进步。个人的奋斗在科研领域是非常艰难的事情,所以参与的人多了,是值得鼓励的。而且,目前所谓的“灌水”,很大一部分原因是在于 AI 实在是一个涉及面太广的领域了。有些新观点的提出,专家也并不了解,可能就觉得有趣。但最终,时间会辨别技术实力的真伪。

此外,董晶也说:“实际从科研力量上看,我们的队伍增长是没有那么快的。目前给大家带来发展迅猛感觉的原因,是很多企业大量地投入到了相关 AI 应用的研发中,越来越多的工程师也进到这个领域中。”

企业对于 AI 的关注,肯定离不开它所能带来的商业价值。董晶对目前 AI 落地应用比较看好的还是 AR 和 VR 领域,这两个方向,已历经了从最初爆红的风口,再至被刺破泡沫的沉寂,如今又重新回归大众视野。“首先技术是需要积累的,另外市场也有一个成熟度问题。一些热点技术在刚冒头时候,可能会受到风险投资的追捧,但最终还是会趋于理智地遵从技术的发展周期。”

“计算机视觉技术有很多内容,如果不通过 AR 和 VR 搭载的话,是实现不出来的。”她说道。

鉴于目前人们对社交网络媒体的需求,以及其背后蕴含的广泛市场空间,如果说短视频是当下继图文分享状态之后的一个“突破点”,那么未来下一个阶段的社交媒体突破点,极有可能要通过 VR 或者 AR 技术来体现。

(来源:Pixabay)

关于 AI 的未来发展计划

学术与产业的平衡问题,是许多科研学者都很难避开的,对于 AI 研究也是如此。董晶表示,自己未来的发展重心依然还是在学术角度,会在计算机视觉方向进一步拓展自己的认知。

为了反制 AI“换脸”而研究出的人体生理信号检测,其实在商业应用角度也有很大的发展空间。即便目前一些手环等随身携带的电子设备已经可以做到实时监控个人心率等信息,但仍然存在一定的使用限制,比如需要充电、也要时刻想着佩戴等。但通过视频就可以检测人体生理信号,这对于即将步入“老龄化”社会的我们,在家庭医疗角度可能会带来极大便利。

对于将技术转化为应用,董晶说:“一个人的精力是有限的,我更想深入探寻计算机视觉技术的美妙。因为一旦进行商用化,就需要对相应场景进行定制化设计和研究,这会很耗费精力。不过,这也是我课题组的研究方向,还是接受和外界进行合作的。当然,怎么选择的话,看缘分。”

而且,对于涉及计算机视觉的应用,她也表示:由于这些技术都利用了生物信息,而生物信息本身具有不可撤销性。因此,一旦发生信息泄露或者滥用等问题,都会给用户带来严重且永久的后果。更有甚者,可能会对司法调查、保险鉴定等这些严肃、敏感的领域带来冲击。

但对于技术本身,她还是希望能坚持“百家齐鸣、百花齐放“的状态。董晶表示:“大环境在鼓励创新时,那么每个地方可能都会开花。而且,技术本身并没有好坏之说,要看它应用在什么角度。所以,我们应该鼓励创新,但不能随便滥用。技术的应用是有边界的。”

就以“换脸”技术来说,它从丰富大众社交娱乐角度,或是还原一些经典影视剧人物都会给人们带来好处,甚至其本身也是很好的“生物防伪”技术基础。但如果滥用,其后果也将十分严重。

图 | 17 个可持续发展目标(Wiki)

一种技术如果想得到长期的稳定发展,那么一定需要专家和相关人员达成共识。而这个共识是要考虑到社会大众等多方面的,靠大家共同建立起一个良好的技术生态。联合国在 2015 年正式通过的 17 个可持续发展目标(Sustainable Development Goals),就包括创新技术上的内容。该目标旨在到 2030 年将以综合方式彻底解决社会、经济和环境三个维度的发展问题,转向可持续发展道路。

“科技是人类社会生态中重要的一分子,陷入单打独斗就会逐渐变成一座孤岛。随着技术的不断发展,尤其像 AI 这种涉及广泛的交叉学科,其带来的伦理与安全问题一定要考虑周全,把道德规范与技术应用的边界定义得清楚明确。”董晶如是说。(杨大可)

声明:本文来自DeepTech深科技,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。