原文作者简介:

Finale Doshi-Velez,哈佛大学计算机科学助理教授。她以马歇尔学者的身份获得剑桥大学硕士学位,麻省理工学院博士学位,哈佛医学院博士后学位。她的研究领域在于机器学习、医疗保健和可解释性的交叉点。Doshi-Velez教授曾在AI顶会上发表多篇论文,研究成果颇丰。

Mason Kortz,哈佛法学院网络法诊所的临床教学研究员,该诊所隶属于伯克曼克莱恩互联网与社会中心(Berkman Klein Center)。他拥有哈佛法学院的法学博士学位和达特茅斯学院的计算机科学和哲学学士学位。他的研究领域包括在线言论和隐私、人工智能法,以及利用数据产品促进社会公正。

这篇文章还邀请了多位跨学科的专家进行讨论并修改完善。

法律体系下负责任的AI:“解释”的相关原理与作用

本文是法律学者、计算机科学家以及认知科学家跨学科合作的产物,主要论述了在目前法律体系下负责任的人工智能系统的可解释性的原理与作用。文章认为当前AI系统在社会生活中的应用愈发广泛,从临床决策支持到自动驾驶再到警务预测,AI系统提供了前所未有的数据处理能力,但是,AI系统在常识推理方面的能力依旧十分落后。因此人们对于AI是否会有意无意制造负面后果的担忧是非常合理的,综合来看,解决AI系统使用与责任承担这一矛盾最重要的方法就是“可解释性”,在合适的时间要求解释有助于防止AI系统带来的负面影响。

文章主要介绍了以下几个方面问题:

1. 解释的内涵

在文章中,作者们首先对解释的内涵进行了界定,将其定义为决策者接受一组特定输入之后得到特定结论这一人类可以理解的过程叙述(human-interpretable description)。解释必须同时具有正确的内容类型,并应当遵循以下内容指导原则:一个解释应当允许观察者明确某个特定输入对输出决定或者影响的程度。换言之,解释应当至少回答以下问题的其中一个:1.决定的主要因素是什么?2.改变某个因素是否会改变决定?3. 为什么两个外观相似的输入会得到不同的决定?反之亦然。

2.解释的场景

文章紧接着探讨了在社会生活中人们要求决策者作出解释的情形,认为通常人类决策者作出一般人不理解或者认为不理想的决策时,人们就会要求作出解释。由于作出解释需要时间及精力,因此解释的效用至少要与生产解释的成本相当。作者们认为存在以下三种解释的效用大于成本且社会认为决策者有道德、社会规范或者法律义务作出解释的情形:1. 执行决策会对决策者以外的人产生影响;2. 知晓决策正确与否这一问题本身即具有价值;3. 有理由认为决策过程中存在错误。

3.美国法律体系中的解释

文章专门举例说明了美国法律体系中的解释,通常法律规定的解释需求内容较为复杂,具体包括解释的作用,解释的主体,以及对触发解释义务的证据要求。在严格责任、离婚、歧视、行政决策、法官和陪审团等情况中,决策的性质、决策者对外部影响的敏感性、道德和社会规范、解释的可感知成本和收益以及一定时期的历史事件等多种因素都会影响是否需要人工决策者来解释决策。

研究发现,虽然要求解释的情境千差万别,但是存在极强的一致性:当需要作出解释时,通常人们想知道的是某些输入因素是否影响以及如何影响最终的决定或结果。

4.技术上的可行性

在谈论上述法律相关问题后,作者们转而讨论从AI系统提取解释的技术上的可行性,与通常认为AI系统是一个黑匣子的观点不同的是,作者们认为为AI系统设定与人类解释水平相当标准的需求在技术层面是可行的,这种可行性的根源在于解释并不等同于透明性,理解AI系统给出的解释并不需要理解通过AI系统的比特流就如同理解人类给出的解释并不需要理解通过神经系统的信号流一样。依据此前的论述,解释的核心在于回答在特定情况下是如何使用某些因素来得出结果的,作者们认为在AI系统中可以基于局部解释(local explanation)与反事实忠诚(counterfactual faithfulness)来实现上述目的。所谓局部解释即为在AI世界中对特定决定进行解释而非对系统整体行为进行解释,原因在于我们不希望微小的输入扰动会对输出产生巨大而混乱的影响,如此以来便可以系统地探测以确定对结果影响最大的输入是什么,就可以回答“决定中最重要的因素是什么”这一问题,之所以局部解释是因为在不同情况下重要的因素可能是不同的。反事实忠诚则意味着如果我们在决策过程中改变了因素,那么结果就应该改变。反事实忠诚这一属性可以回答“某个因素是否决定了结果”以及“相关的因素是如何导致结果差异”这两个问题,使得解释具备因果性的而非仅具备相关性。更重要的是以上两个属性可以在不清楚AI系统细节的基础上满足解释的需要,这极大减少了商业公司对于商业秘密泄露问题的担忧。

5.人类与AI系统解释能力的比较

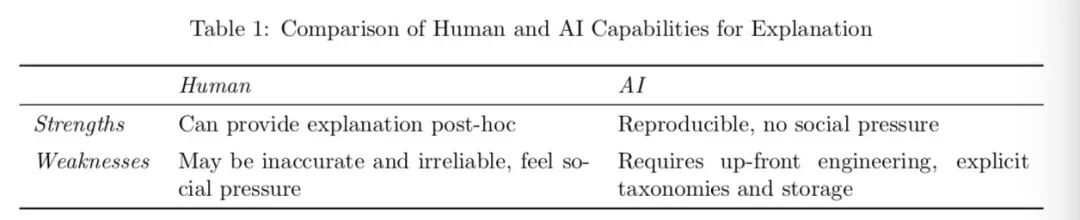

作者们同样谈到了人类与AI系统解释能力的比较。太多外部因素和内在因素可能影响人和AI系统的解释:无论决策者是人还是AI系统,外部因素(决策的重要性、相关的社会规范等)都可能是相同的;但是内在因素可能有很大差异,AI与人类之间的一个重要区别是人类需要预先计划解释。在做出决定的过程中,人类会为解释生成并存储所需的信息。因此,可以在请求解释时对人工解释的成本和收益进行具体评估。相反,AI系统不会自动存储有关其决策的信息,是否将资源分配给解释生成是系统设计的问题。同时,AI系统不会遭受使人类解释不可靠的认知偏见,且不易受到社会压力的影响。

6.备选解释方案

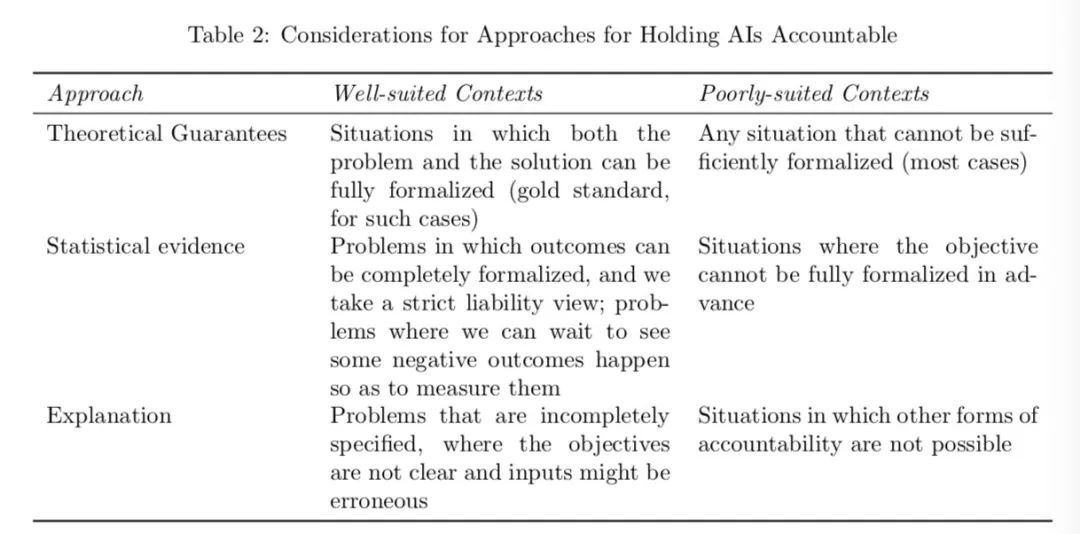

作者们还指出解释并非唯一的问责手段,实证证据与理论保障在某些情况下也可以作为问责方案,三者各有优劣,可以依据情况选择合适的问责工具。

7.建议

综上所述,本文认为要求快速发展的AI系统提供解释,虽然可行,但会增加工程量并将阻碍AI系统发展,因此需要考虑为何解释以及何时解释才能足够有用并使得效用超过成本。在目前情况下,AI系统作出解释的任务并不是那么繁重,应该参照人类解释要求向人工智能系统要求解释,将来技术成熟时有希望对AI设立单独的标准。但由于没有足够的数据来确定要求AI系统生成解释的实际成本,还必须不时重新评估解释在确保问责制中的作用,以适应不断变化的技术格局。

本文作者:

郭金龙,清华大学法学院2019级计算法学方向法律硕士研究生。

李天涵,清华大学法学院2019级计算法学方向法律硕士研究生。

声明:本文来自清华大学智能法治研究院,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。