我们几乎每天都能听到新的创新和发展,这表明,我们正处于各个领域的技术革命的风口浪尖。人工智能技术能够彻底改变我们的工作方式:令人难以置信的创新可以提高我们的准确性,生产力和效率,提高我们的创造力和创新能力。

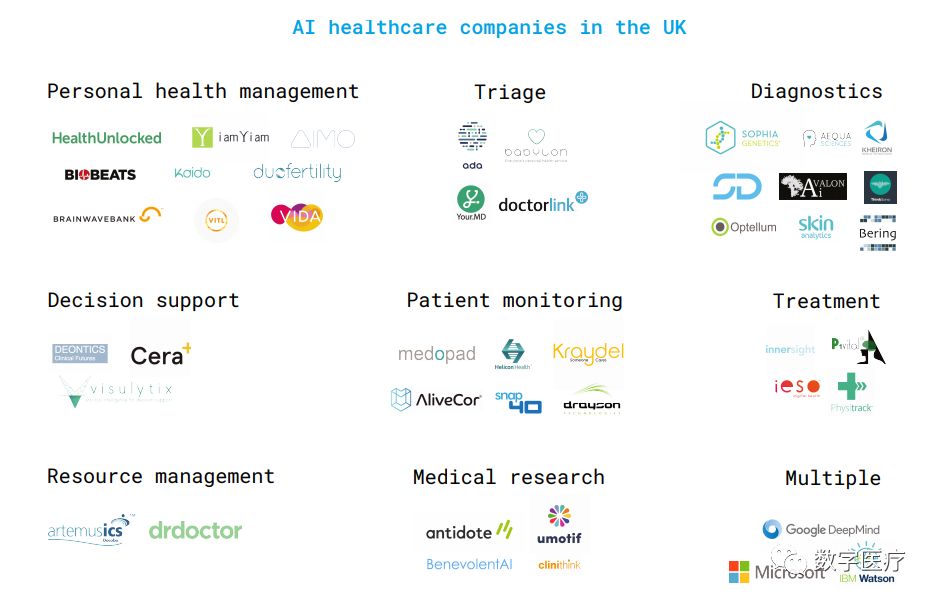

人工智能(AI)有潜力改变NHS提供医疗服务的方式。从使患者能够医疗自助和管理自己的慢性疾病,到推进分诊、诊断、治疗、科研和资源管理,再到人工智能可改善患者结果并提高效率。然而,要实现这些潜力,需要应对一系列伦理、社会、法律和技术方面的挑战。本报告在医疗的背景下描述了这些挑战,并提出了前进的方向。

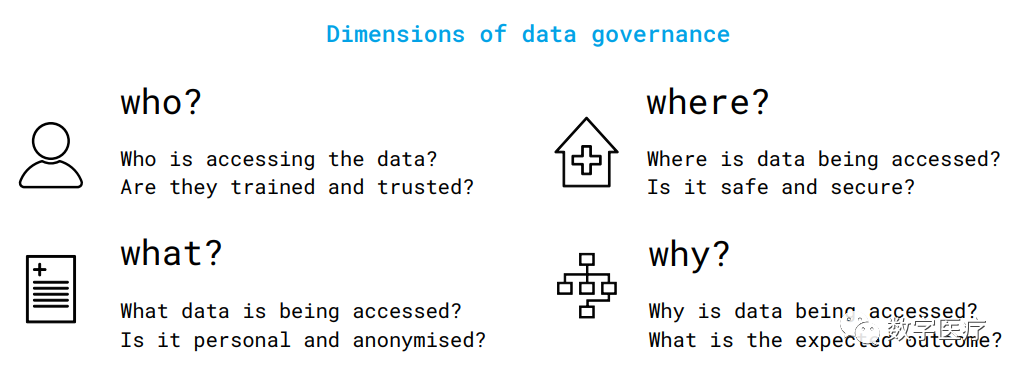

人工智能辅助的医疗保健将要求更好地收集和共享NHS、行业和学术界之间的健康数据。这需要一个数据治理系统,以确保健康数据的伦理管理,并使其能够用于改善医疗服务。数据共享必须得到患者的支持。最近推出的NHS数据选择退出计划是一个重要的起点,需要对这一计划进行监测,以确保它的透明度和清晰度,避免利用公众的意识及理解缺失。数据共享也必须精简并互惠互利。当前的NHS数据共享实践是脱节的,很难从行业和NHS的角度进行协商。随着“传统”的医疗保健数据与商业App和可穿戴设备数据的日益融合,这一问题变得更加复杂。找到评估数据的方法,并考虑患者、NHS及其合作伙伴如何从数据共享中受益,是开发数据共享框架的关键。最后,数据共享应以能够确保网络安全和问责制的数字化基础条件为支撑。

开发和部署人工智能辅助医疗,需要高质量的数字化数据。这就要求NHS进行有效的数字化,特别是在医院这样的医疗机构,不仅包括将纸质医疗记录转化为数字化数据,而且还包括改进质量保证措施和加强数据间的衔接与联系。除了数据数字化,很多IT基础设施也需要升级,包括使用可穿戴技术和NHS和各医疗机构机构之间的互操作能力的提升等创新。这不仅要提高人工智能开发的数据可用性,还将为患者提供无缝的医疗服务,使NHS成为医疗创新的先锋。

最近人工智能的进步和围绕人工智能的炒作意味着,整个行业内人工智能辅助医疗的发展仍然是偶然的,质量难以确定,或者差别很大。如果没有足够的产品验证(包括在真实环境中),就会有意想不到的风险或非故意的性能风险,例如由不恰当的人机交互引起的社会人口偏见或错误。有必要开发标准化的方法来探索数据的训练,就临床相关的效果基准达成一致,并设计出用于评估生产性的人机交互的算法的可解释性。在所有这些领域,标准化并不一定意味着一刀切。这些问题需要在医疗环境中应对和处理AI的具体细节,同时考虑用户的专业知识、他们的环境和产品的预期用途。这需要一个基本的跨学科的方法,包括人工智能、医学、伦理学、认知科学、易用性设计等方面的专家。

尽管人工智能辅助的医疗保健产品已被认可为医疗设备,但英国药品及医疗保健产品监管局和欧盟委员会目前尚未出台详细的涉及人工智能产品的分类、验证和监测等问题的指南。此外,围绕英国脱欧的不确定性,以及英国与欧洲药品管理局未来的关系,也加剧了这种不确定性。缺乏明确的监管可能危及病人的安全,并阻碍人工智能辅助医疗的发展。需要与监管机构、业界各方、医疗机构和独立的人工智能相关机构建立密切的工作伙伴关系,以便在确保患者安全的同时实现创新。

人工智能将成为医务工作者的工具。利用它的效用来满足和改善医疗行业对医务人员和员工队伍的不断增长的需求,医疗行业未来所需要的这些医务人员和员工必须拥有发展人工智能的能力和随着AI技术普及而富有成效地利用AI所必需的数字化技能。人工智能的发展能力将涉及想尽办法来增加临床信息专家的数量,因为只有这些既懂临床又懂信息技术的专家才能领导人工智能技术的开发、采购和采用,同时确保创新并使医疗服务不失其人性化。总的来说,医疗专业人员需要通过培训来补充他们的社会情感和认知技能,以便能够很好地解释人工智能产品提供的信息,并有效地与同事和患者沟通。尽管就人工智能在多大程度上影响到人们的工作和就业,有很多的研究和预测,但要了解其对医疗职工队伍的影响,需要考察工作将会如何变化,而不仅仅是有多少工作将发生变化。

人工智能辅助医疗对法律责任框架会有影响:涉及人工智能出现医疗差错时,谁该负责?解决责任问题将涉及到理解医疗专业人员的医疗责任将如何受到技术使用的影响。这与医疗专业人员缺乏安全有效地使用人工智能的培训标准有关,也与算法可解释性的挑战性有关,“黑箱”系统迫使医疗专业人员盲目地信任或不信任他们的输出。总之,有必要审查医疗保健专业人员、NHS和行业合作伙伴的法律责任,提出有关医疗伦理、员工队伍培训、产品监管和公众支持的问题。

声明:本文来自数字医疗,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。