本文作者:阙天舒 张纪腾

本文刊登于《国际安全研究》实体期刊 2020年第1期

内容提要

作为新一轮科技革命和产业变革的核心驱动力量,人工智能技术的发展与应用在为社会提供强大发展动力的同时,也对国家安全治理造成了一系列影响。实际上,人工智能技术与国家安全之间存在一种结构性互动的关系。一方面,人工智能技术能够基于进化赋能的实践应用,从传统安全、非传统安全以及两者间的重叠领域,为国家安全提供更为有效的维护和保障机制;另一方面,人工智能技术的应用也存在着超出预期设想的可能性。因此,人工智能在国家安全治理中的应用就极易在“界域与有效性”“效能与可靠性”以及“竞争与稳定性”之间出现矛盾。尤其是在因人工智能技术嵌入所导致的力量失衡以及安全格局的转变下,国家安全就极有可能在国家竞争的稳定性、社会治理的有序性与技术应用的稳定性三方面遭受巨大的冲击。需要指出的是,目前人工智能技术所导致的国家安全风险已经逐步显现,而全面评估人工智能技术对国家安全治理带来的机遇与挑战将是解决这一技术安全悖论的关键所在。为此,中国应在紧抓人工智能技术发展契机的同时,更要加强对这一技术发展潜在风险的研判和预防,从而维护好中国的国家安全与人民利益。

【关键词】 人工智能;国家安全;应用范式;安全悖论;路径选择

【作者简介】 阙天舒,华东政法大学中国法治战略研究中心副主任、教授;张纪腾,华东政法大学政治学研究院硕士研究生。

引言

一般认为,科学技术的发展及应用是维护国家安全的重要基础之一。实际上,技术发展本身是以一国的综合实力为基础,并且技术应用形态的多样化、指涉对象的多元化和涉及领域的广泛性更是进一步扩大了各国间的力量对比。[①] 与此同时,技术应用在推动社会发展的同时也导致了一系列社会问题的出现,这些问题往往无法在现有的社会框架下得到妥善解决。随着互联网时代下计算机性能的提升和大数据时代下海量数据的积累,人工智能技术依托算力的提高、数据的几何增长以及算法的优化,终于进入到新一轮高速发展期。事实上,人工智能的技术包容度与统摄力使其具备主导技术发展和推动社会形态转变的基本潜质。因此,人工智能被世界各国视为推动新一轮科技革命的关键力量。

从国家安全治理来看,人工智能技术在信息收集、决策制定、方案执行和监控实施等认知域和物理域的应用将极大程度地提升国家在安全领域的治理水平,进而能够有效地推动国家安全的内涵及其治理范式的转型与升级。正如人工智能领域的先驱、美国计算机科学家佩德罗•多明戈斯(Pedro Domingos)所言:“人工智能是保护国家的重要壁垒。”[②] 然而,人工智能技术的嵌入在提升国家安全治理效能的同时,还将深化国家安全的向度和扩展国家安全的维度,进而也会催生一种技术安全悖论。英国哲学家、牛津大学人类未来研究所创始者尼克·博斯特罗姆(Nick Bostrom)指出:“人工智能不仅仅是一种颠覆性技术,它也可能是人类遇到的最具破坏性的技术。”[③]

目前,多数发达国家政府不仅相继出台了战略规划和配套政策来促进本国人工智能的发展,也对人工智能与国家安全的研究同样给予了高度关注。例如,2017年7月,美国哈佛大学肯尼迪政府学院贝尔弗科学与国际事务中心发布了《人工智能与国家安全》报告,率先就人工智能与国家安全之间的关系进行了分析,并从隐私、安全、透明、责任等方面对人工智能技术进行了评估。[④] 又如,2018年2月,来自英国剑桥大学、牛津大学与美国耶鲁大学的26名学者、专家联合撰写的《人工智能的恶意使用:预测、预防和缓解》报告,将人工智能技术可能带来的风险划分为“数字威胁、物理威胁和政治威胁”,并从技术安全的维度对这些问题进行了具体的分析。[5] 近些年,中国学术界也开始关注人工智能在经济、社会以及伦理等领域中的应用。那么,人工智能将对国家安全带来哪些挑战?又如何有效地应对这些挑战?为此,本文旨在分析人工智能在国家安全治理中的应用范式,剖析国家安全在人工智能时代可能面临的风险,继而探讨中国在维护人工智能技术发展的路径选择。

[①] Robert Jervis, “Cooperation under the Security Dilemma,” World Politics, Vol. 30, No. 2, 1978, pp. 167-168.

[②] Pedro Domingos, The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World, New York: Basic Books Press, 2015, pp. 24-25.

[③] Nick Bostrom, Superintelligence: Paths, Dangers, and Strategies, Oxford: Oxford University Press, 2014, pp. 8-9.

[④] Gregory Allen and Taniel Chan, “Artificial Intelligence and National Security,” The Belfer Center Study, July 24, 2017, https://statewatch.org/news/2017/jul/usa-belfer-center-national-security- and-ai-report.pdf.

[5] Miles Brundage, Shahar Avin, Jack Clark, et al., “The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation,” February 23, 2018, https://arxiv.org/ftp/arxiv/papers/1802/ 1802.07228.pdf.

一 人工智能:作为新的历史起点的深刻技术革命

在正式讨论人工智能与国家安全的关系前,我们需要对人工智能这一技术进行简单的梳理。自约翰·麦卡锡(John McCarthy)、马文·明斯基(Marvin Minsky)与纳撒尼尔·罗切斯特(Nathaniel Rochester)等计算机专家于1956 年首次提出“人工智能”(Artificial Intelligent)的概念以来,这一技术在概念和应用上不断扩展和演进。[1] 然而,在此后的几十年内,由于受到诸多主客观条件的限制,人工智能并未真正在产业层面实现技术应用,相关研究也主要集中于如何运用人工智能进行模式识别以及数据归纳等基础层面。例如,尽管机器学习概念和浅层学习算法早于多年前就被提出,但是由于当时缺乏海量数据的积累以及与之相匹配的高水平计算能力的支撑,故而这些算法模型始终无法得到持续的优化与突破性的进步。[2]

进入21世纪以来,随着技术的发展与突破,人工智能技术逐渐步入了新一轮蓬勃发展期。[3] 从本质上说,本轮人工智能技术发展热潮是建立在图形处理器通用计算(General-purpose computing on graphics processing units, GPGPU)高性能运算架构所形成的计算资源与移动互联网兴起所产生的大量数据的基础上的,而在这两者的催化下又形成了基于套嵌式的多层次模式识别的深度学习算法。互联网所孕育的大数据时代为深度学习算法的优化提供了海量、多维度的训练数据,并且图形处理器(GPGPU)芯片弥补了中央处理器(CPU)在并行计算上的短板,为深度学习的训练提供了大规模、高速率的算力支撑。与此同时,深度学习能够通过组合低层特征形成更加抽象的高层属性与类别,并以自主学习数据的分布特点进行特征判别和逻辑推测,进而构建了以“数据挖掘、自动学习和自主认知”为基本分析路径的机器学习范式。因此,在“数据、算力与算法”三者的共振下,人工智能就逐渐进化为一种能够进行自我学习、自我推理以及自我适应的技术,并具备以近乎“人类思维”处理复杂问题的能力。

人工智能的进一步发展还催生了强化学习、迁移学习、生成对抗网络等新型算法,并推动了算法模型、图像识别、自然语言处理等方面出现迭代式的技术突破。[4] 正如图灵奖得主吉姆·格雷(Jim Gray)所言,新的信息技术推动了科学研究的“第四范式”出现——数据密集型科学发现(Data-Intensive Scientific Discovery)。[5] 而基于数据、算法与算力驱动的人工智能技术是这一范式的典型技术代表。实际上,由于人工智能的广泛应用将对交通、医疗、教育、法律、金融、传媒等诸多社会领域产生巨大影响,因此,多数研究将人工智能视为第四次工业革命的引领性技术,也将这次革命称为“智能革命”。

目前,学界尚未对人工智能研究及应用的领域形成统一的认识,但就当前人工智能的技术研究和应用代表来说,可以将其分为以下六个子研究领域:一是机器学习(machine learning),即通过设定模型、输入数据对机器进行训练,让机器生成特定的算法,并利用这一经由归纳、聚合而形成的算法对未知数据进行识别、判断与预测。[6] 二是深度学习(deep learning),主要是指一种基于对数据表征学习的机器学习方法,强调使用特定的表示方法从实例中对机器进行训练。三是自然语言处理(natural language processing),主要是指实现人与计算机之间用自然语言进行有效通信的理论与方法。[7] 四是计算机视觉(compute version),主要是指使机器能够对环境及其中的刺激进行可视化分析的学科。[8] 五是过程自动化(automation),是指采用自动化脚本的方法实现机器的自我运作,并使表征其工作状态的物理参数尽可能接近设定值的一项技术。六是机器人技术(robotics),主要是指具备一定程度的人工智能的多轴可编程设备,是多项人工智能技术的集成与融合发展的结果。基于上述领域,人工智能技术就形成了以纵向的计算芯片、数据平台技术与开源算法为代表的技术生态系统和以横向的智能安防、智能制造、智能医疗与智能零售为代表的应用生态系统。

不同于其他领域的高新科技,人工智能技术具有更强的适用性和前瞻性,并具有以下特性:

第一,通用目的性,即人工智能技术能够同其他各类技术以及物质力量相结合,形成新型综合性集成解决方案(integrated solution)或场景化的一体化应用。因此,作为一种底层的平台性技术,人工智能能够向各类创新性的应用场景和不同行业快速渗透融合。[9]

第二,自我学习与进化,即人工智能技术基于规则系统、思维逻辑模拟系统以及学习与交互系统,并结合多类交叉学科知识,根据环境的响应和优化规则来实现自我算法的优化。因此,人工智能技术也是一种自感受、自处理、自反馈与自进化的循环系统集成。

第三,技术的开源性,即人工智能技术以通用性较强的开源框架和分布式的数据库为基础,并且广泛支持Python、Java和Scala等流行开发语言。当然,人工智能技术的开源性主要集中在基础的开发技术上,多数的受训模型和数据库仍未实现广泛的共享。目前来看,主流的开源机器学习框架有各公司开发的TensorFlow(谷歌)、Spark(阿帕奇)、CNTK(微软)以及PyTorch(脸书)等。

第四,研发的系统性,即人工智能技术的研发对数据、人力以及资本有着一定的前期要求,并且人工智能也具备很强的学科交叉性,涵盖知识抽象、学习策略以及推理机制等主题。因此,技术强国往往在该领域具有一定的先行优势。

第五,数字性的依赖,即人工智能技术的核心驱动要素为算法、算力与数据,并且这三者要素形成相互融合、优势互补的良好关系。这也意味着,哪个国家拥有的计算资源越多、研发的算法越先进、掌握的数据越多,就越有可能在人工智能领域获得更大的优势。

当然,人工智能技术的发展也存在着特定的阶段性。第一,根据学习方式的差异可以将人工智能技术分为反应型的机器学习阶段(运用一系列初级算法从事实经验中进行归纳学习)、有限记忆型的机器智能阶段(运用一系列高级算法从历史经验中进行预测学习)以及自我意识型的机器自主阶段(不需要外部数据就能从经验中进行自我学习)。[10] 第二,根据技术解决问题的能力可以将人工智能技术分为弱人工智能(又称“狭义人工智能”,Artificial Narrow Intelligence)、强人工智能(又称“通用人工智能”,Artificial General Intelligence)。弱人工智能主要是指针对特定任务而设计和训练的人工智能技术,强人工智能则是指具备足够的智能解决不熟悉的问题以及具备通用化应用能力的人工智能技术。[11] 第三,根据应用层级可将人工智能技术分为推动社会生产力进步的通用技术、改革社会秩序的信息化技术以及实现社会形态转变的智能化技术。当然,这一递进式的发展以人工智能技术在全行业、全领域的爆发性应用为基础。[12]

就当下而言,尽管人工智能技术取得了较大的突破,逐步成为传统行业转型与升级的关键,但是目前的人工智能发展成果主要集中在弱人工智能域内,并且在一些重难点问题上仍旧无法形成实质性的突破,能够跨领域解决问题的通用人工智能的前景仍具有较大的不确定性。因此,人类社会也将在相当长的一段时间内处于人工智能技术的初级阶段。与此同时,尽管人工智能技术已经形成了一定的先期能力优势,但这一技术发展的范式迁移必然有一个过程。在这一纵深发展的过程中,人工智能所造成的社会影响既有其内生的不确定性,又有外部延递的模糊性。因此,对于国家安全而言,人工智能的创新性蕴涵了高度的战略价值,但其演进路径的不确定性则带来了相应的风险。

[1] John MaCarthy, et al., “A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence,” AI Magazine, Vol. 27, No. 4, 2006, pp. 12-14.

[2] Marvin Minsky and Simon Papert, Perceptrons: An Introduction to Computational Geometry, Cambridge, MA: The MIT Press, 1987, pp. 12-15.

[3] 其标志性事件便是“神经网络之父”杰弗里·辛顿(Geoffrey Hinton)及其研究团队将神经网络带入到人工智能技术研究之中,并于2006年首次提出深度学习(Deep Learning)算法,进而使人工智能获得了突破性进展。参见Geoffrey Hinton, Simon Osindero and Yee-Whye Teh, “A Fast Learning Algorithm for Deep Belief Nets,” Neural Computation, Vol. 18, No. 7, 2006, pp. 1527-1554。

[4] [美] 雷·库兹韦尔:《奇点临近》,盛杨燕译,杭州:浙江人民出版社2016年版,第80-82页。

[5] Tony Hey, Stewart Tansley and Kristin Tolle, The Fourth Paradigm: Data-intensive Scientific Discovery, Redmond, WA: Microsoft Research, 2009, pp.1-2.

[6] 机器学习主要分为以下五大类:一是监督学习(supervised learning):以人为标注的数据集作为训练集,训练目标为从训练集中学习出新函数,以对新的数据进行标注。二是无监督学习(unsupervised learning):训练集没有人为标注的结果,但训练目标也是对新的数据进行标注。三是增强学习(reinforcement learning):又被称为强化学习,训练对象在特定的环境进行持续性的自我训练,并根据周围环境的反馈来做出各种特定行为,以实现最优的映射学习行为与决策。四是迁移学习(transfer learning):将已经训练好的源任务(source tasks)的知识或模型的参数迁移到新的目标领域(target domain)。五是半监督学习(semi-supervised learning):是一种介于监督学习与无监督学习之间的方法,更强调让训练对象不依赖外界交互、自动地利用未标记的样本来提升学习性能。关于机器学习的具体介绍,可以参见Christopher Bishop, Pattern Recognition and Machine Learning, New York: Springer Press, 2007; Kevin Murphy, Machine Learning: A Probabilistic Perspective, Cambridge, MA: The MIT Press, 2012; 周志华:《机器学习》,北京:清华大学出版社2016年版,第2-18页。

[7] 自然语言处理的研究主要包括自动摘要、指代消解、语篇分析、机器翻译、语素切分、命名实体识别和词性标注等方向。关于自然语言处理的具体介绍,参见Steven Bird, Ewan Klein and Edward Loper, Natural Language Processing with Python, Sebastopol, CA: O’Reilly Media Press, 2009; Daniel Jurafsky and James Martin, Speech and Language Processing, Upper Saddle River, NJ: The Prentice Hall Press, 2018; 吴军:《数学之美(第二版)》,北京:人民邮电出版社2012年版。

[8] 英国机器视觉协会(BMVA)将计算机视觉定义为“一种对单张图像或一系列图像的有用信息进行自动提取、分析和理解的技术”。常见的计算机视觉应用主要包括对数字化文档识别的字符处理技术、对图像进行分析的图像处理技术(image processing)、从动态视频获取有效信息的视频分析技术(video analysis)以及支持增强现实技术(AR)和虚拟现实技术(VR)的虚拟智能技术。关于计算机视觉的具体介绍,可以参见Simon Prince, Computer Vision: Models, Learning, and Inference, Cambridge: Cambridge University Press, 2012; Richard Hartley and Andrew Zisserman, Multiple View Geometry in Computer Vision (Second Edition), Cambridge: Cambridge University Press, 2004。

[9] 麦肯锡全球研究院的研究人员对涵盖19个行业以及9个业务功能中的400多个用例进行了分析,发现人工智能可以在69%的潜在用例中改进传统分析技术,并且能够为16%的用例提供“绿灯区”(greenfield)式的解决方案,即针对原有无法被解决的难题提供有效的解决方案。参见The McKinsey Global Institute, “The Promise and Challenge of the Age of Artificial Intelligence,” Mckinsey, October 2018, https://www.mckinsey.it/idee/the-promise-and-challenge-of- the-age-of-artificial-intelligence。

[10] Ruslan Bragin, “Understanding Different Types of Artificial Intelligence Technology,” Zeomag, October 18, 2017, https://www.zeolearn.com/magazine/understanding-different-types-of- artificial-intelligence-technology.

[11] Max Tegmark, Life 3.0: Being Human in the Age of Artificial Intelligence, New York: Vintage Books, 2017, pp. 50-51.

[12] Miles Brundage, Shahar Avin, Jack Clark, et al., “The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation,” February 23, 2018, https://arxiv.org/ftp/arxiv/papers/1802/ 1802.07228.pdf.

二 技术多维嵌入:人工智能在国家安全治理中的应用范式

作为国际政治与军事战略领域所关注的一大重要议题,“国家安全”(National Security)这一概念最初来自世界强国对于战争与外交实践的总结。根据理论内涵与实践范畴的差异,国家安全大致经历了“以军事安全为内涵主体的起始阶段、以经济安全为重要关注的双轨发展阶段及以实现综合安全为要求的全面治理阶段”三个主要阶段。[1] 尽管不同时期、不同国家对于国家安全的界定、认识与需求各不相同,但从整体发展趋势来看,国家安全的关注点逐步从传统的军事领域、经济领域向上游区间的科学与技术领域转移,其他有形要素在国家安全中的比重则相对下降。正如英国伦敦政治经济学院教授巴里·布赞(Barry Buzan)所言,新技术演进以及它们在威胁、攻击和稳定战略关系中的作用与影响不仅是国家安全治理的重要驱动力,并且对全球战略关系与国际安全也同样有着极为重要的影响。[2] 与此同时,国家安全的指涉对象与关注领域随着全球化、现代化等因素的嵌入而发生了分野。人类安全威胁多层次化的现实呼唤则是导致这一现象发生的直接原因,其中又以发展与和谐为主要议题的非传统安全不断凸显和强化。新现实主义、新自由主义以及建构主义等国际关系理论均对国家安全的这一转向予以了密切关注。[3]

作为下一轮科技革命的引领性技术,人工智能在国家安全治理领域中的讨论和应用并非一个新鲜事物。早在20世纪80年代中后期,就有一批专家学者对此进行了讨论。例如,美国国际关系学者史蒂文·希姆巴拉(Stephen Cimbala)、菲利普·施罗特(Philip Schrodt)以及保罗·莱纳(Paul Lehner)等人从国家安全的角度对人工智能技术可能造成的影响进行了分析。[4] 实际上,本轮人工智能技术的发展热潮更是进一步深化了其在国家安全中的嵌入程度。笔者认为,可以根据国家安全的主要关注领域,将人工智能在国家安全中的应用范式分为传统安全与非传统安全两个方面。从传统安全领域出发,主要关注人工智能在军事力量与战略对抗中的威胁性使用与控制,非传统安全领域则主要关注人工智能在经济、政治和文化等社会领域中的应用与规范。当然,国家安全治理本身由诸多交叉的治理议题和治理体制组成,结合人工智能技术应用的特性,这就使得人工智能在国家安全治理中的各类应用存在的交叉性更为凸显。[5]

具体来看,人工智能在国家安全中的应用范式主要表现为以下几个方面:

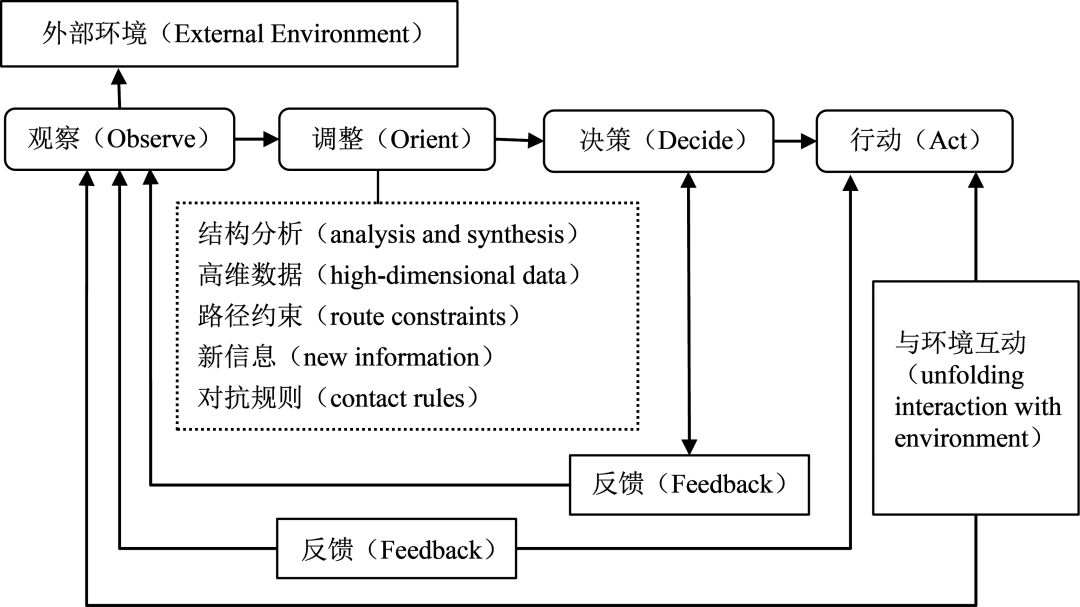

第一,从传统安全来看,人工智能的军事化应用将推动形成新的军事能力和战略博弈模式。目前来看,人工智能军事化应用最为普遍与最为成熟的便是这一技术在战场数据收集与分析上的应用。与传统的数字化、网络化等信息化技术的军事应用不同,基于数据信息全方位收集的基础,人工智能可以更为完整地还原全部战场信息,并据此全盘推演和模拟分析作战策略的预期结果,进而能够更为全面、准确地掌握战场态势,并据此提出更加精确的决策建议。[6] 例如,美国国防部成立的“算法战跨部门小组”(AWCFT)便致力于运用人工智能技术对无人机所收集的全动态视频(FMV)数据进行自动化处理,并据此为作战提供全面的数据分析及决策支持。[7] 在数据分析应用的基础上,人工智能还将推动传统的指挥模式向智能化指挥与控制机制转变,即在态势认知、战略决策以及行动主体的智能化、自主化的基础上,实现信息力与作战单元的密切融合。对此,美国布鲁金斯学会在《人工智能改变世界》报告中提出了“极速战”(hyper war)的概念,即人工智能有助于实现从搜索发现目标、威胁评估到锁定摧毁、效果评估的智能化处理,形成高效精确的感知、判断、决策、控制、评估闭环,从而大幅缩短“感知——决策——行动”的周期,提升作战的整体效率(参见图1)。

图1 人工智能技术在战场态势感知的路径——以观察、调整、决策与行动循环为例 [8] 资料来源:作者自制。

因此,人工智能所具备的自我学习、认知和创造力能显著强化对战场信息的感知与分析能力,打破传统信息化技术对于人工数据分析与决策选择的依赖。

除智能化的战场数据分析与决策指挥外,人工智能还将推动智能无人化武器的大规模应用。针对这一点,新美国安全中心首席执行官罗伯特•沃克(Robert Work)与新美国安全中心执行副总裁兼研究主任肖恩•布里姆利(Shawn Brimley)指出,“完全实现机器人作战体系有可能使军事力量与人口基数以及传统的潜在军事力量的有效度量脱钩”,“消灭敌方有生力量”等作战法则可能失去原有的实际意义。[9] 美国布鲁金斯学会高级研究员迈克尔·汉隆(Michael Hanlon)更是进一步指出,未来战争的革命性技术变化极有可能发生在计算机和机器人的部分领域,其中人工智能将从机器人、自主化和网络安全三方面推动形成新的军事能力。[10]

人工智能还将催化诸如算法战、意识战等新型战略对抗方式的形成。以意识战为例,人工智能通过利用算法自主生成内容“子弹”(自动生成具有诱导性或欺骗性的内容)、实施个性化的“靶向”锁定(利用情感筛选锁定最易受到影响的受众)和密集的信息“轰炸”组合而成的“影响力机器”(the Influence Machine)来操纵他国国内的社会舆论。[11] 实际上,这一新型对抗模式能够以更为隐蔽的和更具破坏性的方式来加剧敌对国家社会内部的两极分化,进而干扰其内部政治事务与破坏其现有政府的合法性。例如,剑桥分析公司(Cambridge Analytica)被爆出利用人工智能技术对美国民众的性格特征、政治倾向等特征进行估计及分类,并据此分别投放不同的、有针对性的政治广告新闻,从而达到干预民众的投票等政治行为的目的。[12]

当然,人工智能技术的应用的全质性还使其能够同多种物质力量相结合,进而能够在态势感知、威胁分析、策略生成以及攻防对抗等方面形成更为有效的作战能力。例如,基于人工智能技术的优化,作为致命性自主武器系统(LAWS)应用代表的无人机就对战场数据进行更为全面的智能化收集、处理与判断,并据此实现自主飞行控制、作战目标识别、作战任务分配与系统自我协调,组建成“蜂群”式的有机作战整体。[13] 而这一“蜂群”所具备的智能化与集群化的特性能够通过数据共享而实现“多中心化”的协同作战,并使得无人机群的作战效能达到最大程度的饱和,最大限度地发挥集群作战的优势。[14]

可见,人工智能不仅能够通过强化物理效能、生物效能或者重塑武器能量来源、作用原理等纯粹的技术层面来影响战争形态,并且还能够从战略决策与作战指挥等主体选择层面来推动战争形态变革。需要说明的是,当前人工智能技术的军事化应用多数仍停留在以信息技术和精确打击武器为核心的“初智”阶段。因此,人工智能技术的军事化应用还存在着较大的不确定性。[15] 但可以明确的是,占据人工智能技术高地的国家将在对抗中获得更大的主动权,并且国家之间对抗也将不再局限于装备层面的较量。相反,对抗与竞争领域将随着技术的发展而不断被拓宽,技术储备、数据知识、创新实力、协同能力的对抗将达到传统战争不可想象的高度。当然,如果伴随着技术的突破,人工智能也有可能推动战争从“精确化”向“智能化”转变,使其跃升为以整合多项战略技术为支撑的“高智”阶段,进而对传统国家安全乃至国际安全领域造成更具颠覆性的影响。

第二,从非传统安全来看,人工智能技术能够为各类社会风险的应对提供更为有效精准的预测、感知和纠错机制。与传统安全不同,人工智能在非传统安全领域的应用主要是从知识生产与问题分析角度切入的。实际上,以大数据分析为基础的对安全态势感知的预测本身就着眼于关联共现关系的冲突特征模式识别。[16] 人工智能技术的嵌入则有助于实现这一过程的智能化,进而统合安全中的“预测、防御、检测与响应”来构建一种自适应安全架构(Adaptive Security Architecture)。[17] 在这一架构中,人工智能技术能够基于时间轴自主地对多源数据进行全方位的感知、挖掘与清洗,并对大量模糊的非结构化数据进行聚合、分类与序列化处理,从而细粒度、多角度、动态化地对危险来源进行目标检测、跟踪和属性提取。[18] 在此基础上,人工智能技术便能够构建相应的模型来捕捉各类风险因子的作用路径及推断其发生的概率,并根据当前的分析结果主动快速地选择应对策略,从而能够不断优化安全防御机制和从容应对潜在的安全威胁。[19]

目前,人工智能技术已在经济安全、医疗保护、环境安全、网络安全、能源安全、打击恐怖主义和跨境犯罪等诸多领域得到较为广泛的应用,具体如下:

第一,在危机预测方面,人工智能不仅能够扩大危机预测的适用范围,并且也能提高预测的准确性和时效性,进而为维护社会稳定构建一种预测型防护机制。[20] 对此,英国艾伦图灵研究所特别项目主任艾伦·威尔逊(Alan Wilson)及其研究团队认为,人工智能可以通过扩大数据收集、减少信息未知性以及建立相关分析模型,更好地预测战争及其他冲突发生的可能性,并以此及时介入其中,以遏制这些社会冲突可能带来的负面影响。[21] 当然,人工智能技术同样可以应用于全球范围内的自然灾害和其他社会危机的预警。例如,公共卫生部门能够利用人工智能技术来对实际疫情数据进行分析,并更准确、有效地对各类传染疾病进行跟踪和预防,从而更高效地利用公共卫生资源。[22]

第二,在反恐方面,人工智能可以基于已有恐怖活动案例的数据及社交媒体等其他相关数据,对恐怖组织的优先目标、网络结构及其行动路径进行智能化的分析,并据此来预测潜在的恐怖行为、甄别恐怖活动嫌疑人以及制定相应的反恐方案。[23] 例如,美国亚利桑那州立大学的网络社会学智能系统实验室(Cyber-Socio Intelligent Systems Laboratory)便利用机器学习以及神经网络等人工智能技术对2014年6月8日至12月31日间发生的2 200起“伊斯兰国”的恐怖袭击及其军事行动进行了分析,并据此构建了一个模拟该恐怖组织行动的模型,以此来推导“伊斯兰国”各类恐怖活动的发生规律以及同联军反制行为之间的关系。[24]

第三,在安防方面,人工智能技术能够推动被动防御安防系统向主动判断与预警的智能安防系统升级。一方面,经由人工智能算法训练的人脸识别、图像识别与视频结构化等技术能够有效地提高安防部门识别罪犯的能力,并根据罪犯的相关信息给出更优的判决结果;[25] 另一方面,公安部门也能够利用机器学习,对犯罪区域及其他环境数据集进行分析,从而预测可能发生犯罪的地区,并据此优化相应警力资源的部署。[26] 正如美国斯坦福大学“人工智能百年研究”(AI100)项目小组所指出的,人工智能技术不仅可以辅助公安部门及其他安全部门进行犯罪现场搜索、检测犯罪行为和开展救援活动,而且还可用于排列警务任务的优先次序以及分配相关警力资源。[27]

第四,在网络安全方面,人工智能有助于实现“端点检测响应”(End-point Detection Response)和“网络检测响应”(Network Detection Response),即人工智能技术能够在信息交互的过程中提前对网络威胁进行评估与研判,并智能化地对不合理的行为进行及时阻断,实现防护边界泛网络化以适应网络空间安全边界的扩张,进而为网络安全的机密性、可用性和完整性提供更为有效的防御工具。[28] 美国电气和电子工程师协会(IEEE)便在其发布的《人工智能与机器学习在网络安全领域的应用》中指出,基于人工智能技术所构建的网络安全系统能够对网络安全漏洞进行及时的检测,并规模化、高速度地对网络安全威胁做出应对,进而能够有效提升网络安全系统的防护能力。[29] 此外,人工智能技术还可用于网络文本、图片、视频和语音内容的识别、检测与分类,并且对于网络技术的各类场景化应用提供辅助工具,进而从网络内容安全与物理网络系统安全来赋能网络安全。[30]

第五,在金融安全方面,人工智能的应用有助于提高金融体系的安全度和稳定性。一方面,人工智能可以通过构建反洗钱、反欺诈以及信用评估等智能模型,为开展多源金融数据整合与交易逻辑校验等金融风控业务提供更为有效的工具。[31] 公认反洗钱师协会(Association of Certified Anti-Money Laundering Specialists, ACAMS)就高度肯定了人工智能技术在反洗钱领域的应用价值。[32] 目前,摩根士丹利、汇丰银行和高盛等多家金融机构已将人工智能技术应用于风险评估、交易筛查、交易监控等具体金融风险控制场景。[33] 另一方面,人工智能还有助于构建金融知识图谱或关联网络,从而提升金融预测的效能与延展金融风控的覆盖范围。针对这一点,金融稳定理事会(FSB)认为,监管部门可以将人工智能技术运用于监测流动性风险、资金压力、房价和失业率等市场变化趋势,从而更为准确地把握当下的经济形势与金融环境。[34]

总的来看,人工智能基于进化赋能的实践应用在国家安全治理中存在着一定的技术发展正循环。这一广域治理的特征不仅意味着人工智能将成为保障国家安全的重要驱动力,而且也将进一步拓展国家安全治理的理念、方式与界域。实际上,由于传统安全与非传统安全往往是相互影响的,因此科技在两者之间的应用也存在着一定的交叉。人工智能技术在国家安全治理中的应用也具有这一特性,并且人工智能所具有的通用性更是模糊了其在传统安全与非传统安全中的应用边界。例如,在传统安全中的无人机“蜂群”可以用于遥感测绘、森林防火、电力巡线、搜索救援等非传统安全类活动,而用于标记照片和识别商品的图像识别算法也被用于分析作战单元所捕获的战场信息。[35] 因此,人工智能在传统安全与非传统安全两个领域之间存在着相互支持的作用。当然,由于受到数据样本的不完全、算法优化的高要求以及模型构建的复杂性等要素的限制,人工智能在现阶段的实际应用过程中仍存在着明显的缺陷。[36] 而我们对于人工智能在国家安全治理中应用的认知,多数还是建立在当前已知技术应用的基础上的,尚且只能根据现有和能大致预见到的人工智能技术及其发展趋势,来探讨其已经和可能在国家安全治理中的应用。[37]

[1] Edward Kolodziej, Security and International Relations, Cambridge: Cambridge University Press, 2005, pp. 12-13.

[2] Barry Buzan and Lene Hansen, The Evolution of International Security Studies, Cambridge: Cambridge University Press, 2009, pp. 269-270.

[3] 例如,新自由主义的代表人物罗伯特·基欧汉(Robert Keohane)和约瑟夫·奈(Joseph Nye, Jr.)所提出的“相互依赖”理论就认为,在“复合相互依赖”(complex interdependence)条件下,国际行为主体及联系渠道的多元化不仅将加剧一系列非传统安全威胁对国际政治的影响,并且国家安全、地区安全与全球安全间的联系将更加密不可分。参见[美] 罗伯特·基欧汉、[美] 约瑟夫·奈:《权力与相互依赖》,门洪华译,北京:北京大学出版社2012年版,第5-6页。建构主义中的哥本哈根学派则提出了“古典复合安全”和“安全化”理论,主张在宽泛议程的基础上构建一种“兼容传统主义”的安全分析框架,并希望通过“非安全化”来实现人类社会的和平。参见 [英] 巴瑞·布赞等:《新安全论》,朱宁译,杭州:浙江人民出版社2001年版,第5-6页。批判理论的代表人物彼得·卡赞斯坦(Peter Katzenstein)则将文化认同原理用于国家安全的分析,并指出国家的安全环境同样深受文化和制度因素的影响。参见Peter Katzenstein, ed., The Culture of Security: Norms and Identity in World Politics, New York: Columbia University Press, 1996, pp. 11-13。

[4] 参见Stephen Cimbala, Artificial Intelligence and National Security, Idaho Falls, Idaho: Lexington Books Press, 1987; Philip Schrodt, “Artificial Intelligence and Formal Models of International Behavior,” American Sociologist, Vol. 19, No. 1, 1988, pp. 71-85; Lehner Paul, Artificial Intelligence and National Security Opportunity and Challenge, New York: Tab Books, 1989; Adrian Hopgood, “Artificial Intelligence: Hype or Reality?” Computer, Vol. 36, No. 5, 2003, pp. 24-28。

[5] [意] 卢西亚诺·弗洛里迪:《第四次革命:人工智能如何重塑人类现实》,王文革译,杭州:浙江人民出版社2016年版,第8-9页。

[6] 杜国红、韩冰、徐新伟:《陆战场指挥与控制智能化技术体系研究》,载《指挥控制与仿真》2018年第3期,第1-4页。

[7] Darrell West and John Allen, “How Artificial Intelligence is Transforming the World,” Brookings, April 24, 2018, https://www.brookings.edu/research/how-artificial-intelligence-is-transforming-the-world/.

[8] 观察、调整、决策与行动(OODA)循环理论原为信息战领域的一个概念,该理论认为作战过程是“观察(Observe)、调整(Orient)、决策(Decide)与行动(Act)”四个环节的不断循环往复的过程,并且在对等作战的前提下获胜的关键就在于更好地完成这一过程。而人工智能的嵌入将推动OODA实现智能化的转变:第一,态势感知智能化,即采用机器学习等方法,并在先验知识的支持下,与环境的不断交互持续地学习战场环境。第二,对抗措施的自我调整,即根据态势感知模块对环境信息的认知,自动合成最佳对抗策略和分配作战资源。

[9] Robert Work and Shawn Brimley, “20YY: Preparing for War in the Robotic Age,” Center for a New American Security, January 22, 2014, https://s3.amazonaws.com/files.cnas.org/documents/ CNAS_20YY_WorkBrimley.pdf.

[10] Michael Hanlon, “Forecasting Change in Military Technology, 2020-2040,” September 2018, http://www.brookings.edu/research/forecasting-change-in-military-technology-2020-2040/.

[11] “影响力机器”概念由美国陆军协会陆战研究所最早提出,这一作战模式的目的在于以更低的成本、更为隐蔽的方式来干扰民众情绪和操纵社会舆论,从而在对手内部制造分裂并削弱其民众的意志。参见Christopher Telley, “The Influence Machine: Automated Information Operations as a Strategic Defeat Mechanism,” Association of the United States Army, September 24, 2018, https://www.ausa.org/publications/influence-machine-automated-information-operations-strategic-mechanism。

[12] Ryan Hass and Zach Balin, “US-China Relations in the Age of Artificial Intelligence,” Brookings, January 10, 2019, https://www.brookings.edu/research/us-china-relations-in-the-age-of- artificial-intelligence/.

[13] Paul Scharre, Army of None: Autonomous Weapons and the Future of War, New York: W. W. Norton & Company, 2018, pp. 12-15.

[14] Amy McCullough, “Swarms: Why They’re the Future of Warfare,” Air Force, Vol. 102, No. 3, 2019, pp. 36-37.

[15] Vincent Boulanin and MaaikeVerbruggen, Mapping the Development of Autonomy in Weapon Systems, Sweden Stockholm International Peace Research Institute, 2017, pp. 16-17.

[16] 董青岭:《大数据安全态势感知与冲突预测》,载《中国社会科学》2018年第6期,第182页。

[17] “自适应安全架构”是由美国顾能咨询公司(Gartner Group)所提出的面向下一代的安全体系框架,其组成主要分为四个维度:(一)防御:指一系列用于防御攻击的策略集、流程和产品,其关键目标在于减少被攻击面。(二)检测:指用于监测逃过防御网络的威胁的工具,其关键目标在于降低威胁造成的“停摆时间”以及其他潜在的损失。(三)响应:指用于调查和修复被检测阶段所分析出的威胁,其关键目标在于提供入侵认证和攻击来源分析,并产生新的防御手段来避免未来事故。(四)预测:指基于防御、检测、响应结果不断优化基线系统,其关键目标在于精准预测未知的威胁。参见 Neil MacDonald and Peter Firstbrook, “Designing an Adaptive Security Architecture for Protection From Advanced Attacks,” Gartner Group, February 12, 2014, pp. 3-4。

[18] Anna Buczak and Erhan Guven, “A Survey of Data Mining and Machine Learning Methods for Cyber Security Intrusion Detection,” IEEE Communications Surveys & Tutorials, Vol. 18, No. 2, 2017, pp. 1153-1176.

[19] Lars-Erik Cederman and Nils Weidmann, “Predicting Armed Conflict: Time to Adjust Our Expectations?” Science, Vol. 355, No. 6324, 2017, p. 474.

[20] David Vergun, “Artificial Intelligence Could Aid Future Background Investigators,” April 8, 2019, https://dod.defense.gov/News/Article/Article/1808092/artificial-intelligence-could-aid-future- background-investigators/.

[21] 英国艾伦图灵研究所开发的“全球城市分析弹性防御项目”(Project on Global Urban Analytics for Resilient Defence)、美国洛克希德·马丁公司开发的“综合危机预警系统”(Integrated Crisis Early Warning System)以及美国政府资助的政治不稳定任务工作小组(Political Instability Task Force)所研发的政治风险预测模型等,均已将人工智能用于风险预测模型的构建。参见Weisi Guo, Kristian Gleditsch and Alan Wilson, “Retool AI to Forecast and Limit Wars,” Nature, October 15, 2018, https://www.nature.com/articles/d41586-018-07026-4。

[22] Trang Pham, Truyen Tran, Dinh Phung, et al., “Predicting Healthcare Trajectories from Medical Records: A Deep Learning Approach,” Journal of Biomedical Informatics, Vol. 69, No. 3, 2017, pp. 218-229.

[23] Patrick Johnston and Anoop Sarbahi, “The Impact of US Drone Strikes on Terrorism in Pakistan and Afghanistan,” International Studies Quarterly, Vol. 60, No. 2, 2016, p. 204.

[24] Andrew Stanton, Amanda Thart, Ashish Jain, et al., “Mining for Causal Relationships: A Data-Driven Study of the Islamic State,” in the Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 2015, pp. 2137-2146.

[25] Richard Berk, “Asymmetric Loss Functions for Forecasting in Criminal Justice Settings,” Journal of Quantitative Criminology, Vol. 27, No. 1, 2011, pp. 107-123.

[26] Beth Pearsall, “Predictive Policing: The Future of Law Enforcement?” National Institute of Justice Journal, Vol. 4, No. 266, 2010, p. 16.

[27] One Hundred Year Study on Artificial Intelligence (AI100), “Artificial Intelligence and Life in 2030,” Stanford University, September 9, 2016, https://ai100.stanford.edu/sites/g/files/sbiybj9861/f/ai_ 100_report_0831fnl.pdf.

[28] Jian-hua Li, “Cyber Security Meets Artificial Intelligence: A Survey,” Frontiers of Information Technology & Electronic Engineering, Vol. 19, No. 12, 2018, pp. 1462-1474.

[29] IEEE, “Artificial Intelligence and Machine Learning Applied to Cybersecurity,” October 9, 2017, https://www.ieee.org/content/dam/ieee-org/ieee/web/org/about/industry/ieee_confluence_report.pdf.

[30] 网络内容安全是指网络环境中产生和流转的新型内容是否合法、准确和健康;网络物理系统安全则是指网络技术的现实应用是否会对资产、人身及自然环境等要素造成潜在的安全威胁。参见腾讯公司安全管理部、赛博研究院:《人工智能赋能网络空间安全:模式与实践》,2018年9月18日,第10-15页。

[31] Richard Lowe, “Anti-Money Laundering - the Need for Intelligence,” Journal of Financial Crime, Vol. 24, No. 3, 2017, pp. 472-479.

[32] Gurjeet Singh, “How AI is Transforming the Anti-Money Laundering Challenge,” Compliance, August 10, 2017, https://www.corporatecomplianceinsights.com/ai-transforming-anti-money-laundering- challenge/.

[33] Aline Dima and Simona Vasilache, “Credit Risk Modeling for Companies Default Prediction Using Neural Networks,” Journal for Economic Forecasting, Vol. 19, No. 3, 2016, pp. 127-143.

[34] Financial Stability Board, “Artificial Intelligence and Machine Learning in Financial Services: Market Developments and Financial Stability Implications,” November 1, 2017, http://www.fsb. org/wp-content/uploads/P011117.pdf.

[35] Michael Mayer, “The New Killer Drones: Understanding the Strategic Implications of Next-Generation Unmanned Combat Aerial Vehicles,” International Affairs, Vol. 91, No. 4, 2015, p. 778.

[36] 董青岭:《机器学习与冲突预测——国际关系研究的一个跨学科视角》,载《世界经济与政治》2017年第7期,第116页。

[37] 傅莹:《人工智能对国际关系的影响初析》,载《国际政治科学》2019年第1期,第17页。

三 安全格局之变:人工智能在国家安全治理中的风险识别

科技革命的发生往往会对国家力量对比、地缘政治结构以及社会治理等多个方面产生深远影响,进而也就会从多个领域对国家安全治理造成根本性的挑战。例如,科技革命所带动的军事变革可能加剧大国间的战略竞争、扩大全球战略失衡的风险,并导致对抗规模更大、速度更快以及强度更高;科技革命所推动的社会形态转变将使得经济安全、金融安全、信息安全、文化安全、环境安全等非传统安全领域面临新的“安全困境”。[1] 如上文所述,随着人工智能实现了新一轮的技术突破,这一技术极大地提升了国家安全的重要意义。人工智能不仅对国家安全及其战略行为模式具有极强的“破壁效应”,同时这一技术的应用也存在着超出预期设想的可能。因此,人工智能技术也将从国家战略竞争的稳定性、社会治理的有序性以及技术应用的稳定性等方面对国家安全产生一定冲击。此外,人工智能综合应用所存在着的交叉性还将放大这些冲击所造成的风险。

(一)人工智能将对现有国际战略竞争平衡产生一定的冲击

军事安全与战略平衡是国家传统安全领域探讨的首要议题,而科技对于军事力量发展的作用则对军事安全与战略平衡产生直接影响。这是由于某项新科技的军事化应用往往存在打破原有国家间力量对比的可能,并且各国技术水平的差异往往容易加剧国家间的军事与战略竞争。[2] 从这一维度出发,人工智能对于国家安全的影响可以分为以下三个方面:

第一,从竞争领域来看,人工智能作为一项具有通用性的平台技术,其军事化应用不会局限于某类单一的武器或作战平台,而是将在各个军事领域内实现全面的扩散。因此,拥有人工智能技术优势的一方将在多领域中研发出打击效用更大与预期风险更低的军事设备,而技术劣势方则难以用数量叠层或策略战术等手段进行中和或弥补这一力量差距。同时,人工智能还将为各类小规模、短时间、低烈度的非传统的战法及非战争的军事行动提供更为有效的技术支撑。非常规的军事行动出现与进化本身就可能模糊战争与冲突的界限,而人工智能军事化应用图景的不明确则将进一步深化这一不确定性。[3] 此外,现有的军备控制体系与国际裁军协议并未将人工智能军事化应用涵盖在内,并且各方也尚未就这一议题形成广泛的共识。[4] 因此,人工智能军事化应用所存在的全域式特性以及对非常规军事行动的支撑作用将加剧国家在这一领域内的竞争,并且全球性规制的缺失还可能导致人工智能军事化应用出现无序竞争的格局。

第二,从冲突成本来看,人工智能的军事化应用不仅能够实现作战效率的全方位提高,并且还能够以无人化的作战形式来降低可能造成的伤亡。针对这一点,美国学者迈克尔·迈耶(Michael Mayer)认为,新型无人武器发展带来的影响不仅限于提供了可升级的远程精确打击能力,更为关键的是使用这种武器将会避免对己方作战人员带来伤亡的风险。[5] 这样来看,人工智能的介入将显著地降低损益、周期、规模以及性质等诸多因素在内的预期成本对于战争决断及其进程的限制,尤其是原有制衡战争的两大主要因素——军事成本与国内政治代价——在一定程度上被削弱了(甚至消失)。[6] 与此同时,人工智能军事化应用所带来效用的提高也可能导致国家更倾向于使用这一技术。乔治梅森大学教授杰瑞米·拉布金(Jeremy Rabkin)与加州大学伯克利分校教授约翰·柳(John Yoo)认为,在动用大规模的军事响应过于严重的情况下,各国便可能会更加频繁采取人工智能等作战效能更高和战争成本更低的新技术来达到目标。[7] 可见,尽管人工智能的军事化应用带来了一系列战略收益,但也降低了战争的门槛及其负面效应,进而在技术层面刺激各行为主体趋向于选择冲突与对抗。[8]

第三,从核威慑体系来看,人工智能技术的介入可能对这一建立在“确保相互摧毁”原则基础上的体系造成巨大的冲击。实际上,国际行为体间的战略互动往往是一种基于“不完全信息”的博弈过程,这也是核威慑体系存在的前提之一。[9] 然而,拥有人工智能技术优势的一方能够对原有不确定的战略意图以及复杂的对抗情况进行全景式的智能化分析,从而能够在核威慑的决策上做出更加灵活、准确的战略判断与选择。[10] 例如,兰德公司发布的《人工智能对核战争风险的影响》报告显示,技术优势方可以运用人工智能技术对敌方安全基础设施实行大规模监控,并据此确定对手的行为模式与实施更具针对性的反制措施。[11] 与此同时,人工智能所导致的军事竞争领域的扩大还将催生不对等的战略威胁手段。例如,人工智能可以实现天基武器情报和武力的实时整合,并以智能化的方式提升轨道武器的精准度,进而构建一个更为有效的反导防御系统。这一不对等战略威胁手段的出现可能导致技术弱势方所具备的威慑战略趋于低效或者无效,进而对现有的核威慑体系形成一定冲击。[12] 因此,正如美国哈德逊研究所高级研究员安德鲁·克雷皮内维奇(Andrew Krepinevich)所言,新兴技术的出现将模糊常规战争与核战争间的界限,并且不对等的军事能力同样具有打破核威慑平衡的可能。[13]

从上述三个角度的分析来看,无论是军事竞争的领域,还是对抗冲突的意愿,抑或是核威慑体系,人工智能技术均有可能对现有的博弈结构造成较大的冲击。其中,人工智能技术相对薄弱的国家将在战略判断、策略选择与执行效率等多方面处于绝对劣势,占据技术优势的国家则将通过占据新的技术制高点来获得全面超越传统力量对抗的能力。在这一状态下,各国对于实力差距、国家安全与利益冲突的担忧将会更加明显,进而使得各国在人工智能发展上的不对称性逐步放大为国家安全偏好上的差异性:第一,技术强国在选择冲突对抗时所获得的收益将不断增加,技术弱国则难以凭借常规的对抗手段形成有效的对外制约。[14] 因此,技术强国所具备的“积极幻想”的适应性优势使其更易形成获取霸权的进攻性需求,即技术强国在战争方面的决策可能变得更加宽松,并倾向于实现人工智能的大规模军事化应用以构建自身的绝对优势。[15] 第二,技术弱国所处的被动位置则使其形成获取维护安全的防御性需求,即技术弱国更易于倾向采取激进的反制措施,倾向于寻求人工智能武器的扩散以获得新的制衡手段。第三,由于各国无法直观地判断相互间在人工智能技术上的差距,更是可能导致各国不得不做出最为极端的选择,即将潜在对手的威胁最大化。[16]

这样看来,在人工智能军事化应用的影响下,国家安全的客观外延性(extensionality)与主观意向性(intentionality)极有可能发生重叠,即因人工智能技术发展的差异性所导致的“生存性焦虑”存在被放大为“生存性威胁”的可能(如图2所示)。而“客观安全与主观安全的丧失将导致国家行为大幅度的偏离理性轨道”,因此无论是技术强国还是技术弱国,均有在人工智能军事化应用中强化战略竞争的倾向。[17] 人工智能技术发展所导致的力量失衡以及安全格局的转变,就将导致国际体系出现更大的不确定性与不稳定性。

图2 人工智能军事化应用之下国家安全偏好的转变 资料来源:笔者自制。

(二)人工智能将进一步拉大国际行为主体间的能力代差

军事能力与经济实力是一国在国际社会中塑造自身权力的两大重要来源,但就现代社会的发展而言,后者对于国家安全的重要性更为凸显。[18] 作为一种生产力革命的手段,人工智能对于经济发展的重要性是不言而喻的。然而,就目前而言,发达国家在人工智能技术的发展上仍处于绝对的优势地位,多数发展中国家在这一技术上则存在着天然的缺陷。因此,尽管人工智能技术的应用能够有效地推动社会整体的发展,但是这一内嵌的技术霸权逻辑则将导致国际竞争中出现更多的消极因素,并且还将加剧全球发展中的不均衡与不公正。[19]

第一,人工智能所推动的生产方式变革将对全球性的整合与现代性的扩散产生一定的限制。人工智能在产业层面应用的核心逻辑在于通过智能机器人来实现社会生产的自动化与智能化。尽管这一生产方式的转变能够实现社会生产力的释放,但同时也将对现有的产品生命周期和国际分工模式造成极大的冲击。尤其是无人化生产方式的应用将稀释发展中国家在劳动力资源上所具备的比较优势,部分制造加工业回流到自动化程度较高的发达国家。在这种情况下,发展中国家就难以通过自身的人口红利来吸引国际产业的转移,进而就面临着外资红利与全球技术知识外溢的红利缩减的风险。同时,人工智能应用所导致的全球产业链向价值链的跃升将使得具备技术优势的发达国家获得引领新一轮产业升级的能力。针对这一点,麦肯锡全球研究院在其报告中指出,占据人工智能技术高地的发达国家和地区将在目前基础上获得20%~25%的额外经济增长,而发展中国家可能仅仅只能获得5%~15%的额外经济增长。[20] 此外,人工智能技术还将导致发达国家与发展中国家之间出现新的技术围墙。例如,以色列耶路撒冷希伯来大学历史系教授尤瓦尔·赫拉利(Yuval Harari)指出,在人工智能时代,技术强国所“天然”具有垄断数据的能力可能导致少数几个大国掌控全球的数据信息,而技术弱国则极有可能面临“数据殖民”的危机。[21] 这样看来,尽管发展中国家也将在智能革命中获得更好的发展机会,但是原有全球化所带来的“现代性扩散”可能难以再为发展中国家的产业升级与社会转型提供有效的支撑,部分发展中国家甚至可能面临被全球价值链淘汰的风险。[22]

第二,人工智能技术创新与应用的高门槛将导致发展中国家面临“技术边缘化”的风险。[23] 从技术创新来看,多数发展中国家在人工智能的技术创新与投资能力上非常薄弱。根据加拿大人工智能孵化公司Element AI发布的《2019年全球人工智能人才报告》显示,全球范围内72% 的人工智能技术人才被美国、中国、英国、德国和加拿大五国包揽,而排名前18强的国家则包揽了94% 的人才;[24] 再如,根据全球知名创投研究机构CB Insights发布的2019年《人工智能企业100强榜单》显示,在百强榜单中有77家企业来自美国,并且专利申请数量最多的公司也同样来自美国。[25] 与此同时,人工智能技术的前期研发与布局上也需要投入大量的成本,并且其发展初期存在着“索洛悖论”(Solow Paradox)的难题,即人工智能所推动社会生产率的提升与技术进步之间存在迟滞,并且劳动生产率的提升难以同步转化为人们收入的普遍增长和消费成本的普遍下降。[26] 对于发展中国家来说,人工智能技术研发的高昂成本本身就是难以负担的,并且这一技术应用与吸收所需经历缓慢的“燃烧周期”更是加重了其实现技术应用的负担。从这一角度来看,那些技术条件和资本基础薄弱的发展中国家甚至在人工智能领域丧失实质性的发展机会。[27]

第三,人工智能的过度竞争还将催生新的地缘政治风险与技术风险。由于发达国家在人工智能技术的原发性创新与价值定义上具有绝对的先发优势,因此这些国家往往能够在人工智能的标准及治理规则的制定上也发挥出极强的主导作用。在这种情况下,技术强国凭借自身在人工智能技术上的优势而成为新的权力中心,其他技术弱国则将参与由技术强国所构建的技术秩序。因此,技术弱国对技术强国就形成了新的技术性依附。然而,人工智能作为一项集成式的平台性技术,本身就涉及算力、数据与算法等多方面的技术,这就使得各国在人工智能领域的竞争本身就带有全域式竞争的趋向。在这一依附关系下,这一全域式竞争的趋向就从技术强国之间的局部竞争扩大为全球性的竞争,即个别技术强国的主观竞争意愿将体现为国家之间的技术竞争现实。而这种格局一旦形成,就极易导致各国在人工智能领域的竞争超出正常的范畴,甚至可能引发各国采取诸如技术封锁、技术对抗等更为激进的技术发展策略。[28] 然而,过度竞争就会导致人工智能的发展出现更为无序的状态,尤其是技术割裂所造成技术生态的封闭与失序就极易诱发一系列的新生技术风险。例如,不同的人工智能系统本身就存在着兼容性的问题,并且这些系统之间安全防护协议的差异也可能导致出现一定的安全漏洞。而在技术对抗或者封锁的状态下,各国就难以通过合作来共同解决这些问题。[29]

(三)人工智能将导致使资本获得“超级权力”

在技术发展和治理需求的推动下,市场中的结构性权力往往会出现持续性的扩张。在人工智能时代,尽管政府仍将具备一定的数据资源优势,但是治理难度的增加及技术应用的不充分也可能导致政府不得不将部分的治理权力让渡给科技巨头企业。正如美国经济学家、诺贝尔经济学奖得主约瑟夫·斯蒂格利茨(Joseph Stiglitz)所言,人工智能技术的复杂性以及科技企业的优势将导致后者在相关技术治理准则的制定中拥有相当大的话语权。[30] 科技巨头企业也将凭借自身在人工智能技术以及产品供应上的重要作用,获得相应的社会治理权力与能力。因此,人工智能在一定程度上将强化资本权力的垄断地位,其中科技巨头企业极有可能成为新型的权力中枢。

目前来看,多数重要的人工智能领域的突破性成果都是出自Alphabet、IBM、微软、亚马逊和苹果等科技巨头企业所支持的研究平台,并且这些巨头企业也通过收购与兼并来强化自己在人工智能技术生态的战略优势。例如,根据CB Insights的统计,上述所提及的科技巨头企业在过去的17年内分别收购了诸如深度思考(DeepMind)、Github、领英(LinkedIn)、Siri、安卓(Android)等200多家人工智能创业公司。[31] 因此,这些科技巨头企业极有可能成为人工智能时代的巨头企业。科技巨头企业所构建的是一种自上而下的全产业链式的人工智能技术生态,并且这一生态体系在发展初期是不同专业领域的企业以开放、互动的形式共建而成。因此,人工智能技术的竞争要素集中度会随着这一过程而不断集中,因而更易形成“赢者通吃”的寡头竞争格局。例如,尽管当前多数科技巨头企业所提供的人工智能算法多是开源的,但这些算法(与Linux等经典开源软件不同)在战略、设计和开发上仍是封闭的和不透明的,并且初创企业几乎难以摆脱对这些开源算法的依赖。[32] 此外,数据、算法等人工智能的核心要素在一定程度上可以脱离主权和地理空间的限制,并且人工智能技术的诸多特性本身就便利于垄断行为的实施。因此,科技巨头企业的活动空间则将随着人工智能技术的发展而得到持续性的扩张,而相关部门的监管也面临着更大的挑战。[33]

与此同时,人工智能的发展还将推动新一轮的“温特尔主义”(Wintelism)的形成。[34] 科技巨头企业在数据、算力与算法上的优势地位决定了它们具备操纵全球人工智能产业结构与技术实践的能力。对于主权国家而言,为确保自身在人工智能技术上处于绝对领先地位的目的,技术强国(相对于技术弱国)与市场结构性权力之间形成一种相互利用与共谋的关系,即两者极有可能通过制定行业标准、模块化生产等策略来主导人工智能技术的发展。美国纽约大学信息法研究所研究员茱莉亚·波尔斯(Julia Powles)将此称为“因技术发展而形成的力量转移与结合”。[35] 然而,对于人工智能而言,这种技术发展的模式却可能导致两方面的不良后果:从内部视角来看,为了充分抢占人工智能技术的高地,政府会予以科技巨头企业更多的权力让渡,继而导致这些巨头企业的垄断地位被不断强化,并对技术创新、产业制造以及社会治理等方面造成极大的挤出效应。[36] 从外部视角来看,这一发展模式极易扩大国家利益与企业利益在人工智能技术发展上所具有的一致性,并使得企业间的商业性竞争上升为国家间的战略性竞争,进而导致人工智能面临更多的消极竞争因素。[37] 显然,这两种情况均不利于人工智能技术的可持续发展,并且也容易导致各类主体在这一技术竞争中脱离正常的范畴,进而从技术发展和竞争秩序两方面对国家安全造成极为不利的影响。

(四)人工智能将导致社会治理面临新的挑战

人工智能技术的发展与应用将推动新一轮的技术革命和产业革命,但同样不可忽视的是,人工智能技术的介入也将从利益再分配、法律规范和伦理道德等多个层面对社会治理形成新的冲击。与此同时,人工智能本身存在运作的自主性、参与的多元性和风险的不可预知性等特征对于社会治理也提出了更高的要求。因此,人工智能对于社会治理所带来的一系列新挑战也是国家安全治理需要重点关注的领域。

当前人工智能对于社会治理最为突出的影响便是这一技术应用所可能导致的社会结构性失业问题。根据麦肯锡全球研究院2018年9月发布的《前沿笔记:人工智能对全球经济影响的模拟计算》显示,根据不同的使用场景,到2030年,智能代理和机器人将取代4亿~8亿个工作岗位。其中,重复性劳动与低水平数字技能为特征的岗位需求在未来20年中下降近10%,而非重复性活动或高水平数字技能的岗位需求则将获得相应的份额。[38] 这就意味着,人工智能将导致依靠劳动密集型产业和依赖信息不对称而存在的部分行业遭受极大的冲击。[39] 实际上,这种失业的主要原因并不在于技术替代,而是人工智能嵌入所导致的社会技能结构和人才供需之间的不平衡。人工智能技术本身无法均等地渗透到所有国家、地区、产业和经营主体,其带来的经济增长也同样难以以涓流的方式惠及所有群体。然而,恰恰是这种不平等与不对称扩大了人工智能所造成的社会各产业间、群体间与阶层间在发展能力、资源占有程度与社会影响力等方面的失衡。[40] 因此,人工智能所导致的这一结构性失业不仅可能降低劳动参与率与加剧收入的“二元”分化,还将扩大社会贫富差距和减弱阶层流动性。社会包容度衰减等问题也将因此变得更为突出。

数据隐私也是当前人工智能发展急需解决的问题。人工智能技术对用户隐私的侵权主要表现为个人数据的不当收集、数据收集方滥用、数据二次使用与扩散。实际上,人工智能技术研发本身就是以大数据技术为支撑的。然而,数据的高度依赖性要求用户让渡一定的个人数据使用权,并且人工智能所形成的用户画像(profiling)还将对用户的隐私进行“窥探”。例如,将个人的浏览记录、聊天内容和购物过程等数据片段进行组合,就可以勾勒出用户的行为轨迹,并据此推断出个人偏好、性格特征和行为习惯。此外,在现行的网络数据安全架构下,对于个人数据的被遗忘权、携带权等新型数据权利未能形成社会共识性的保护机制,数据跨境流动管理等全球数据管理更是处于真空地带。例如,尽管微软公司近期出于隐私的考虑,删除了旗下的公开人脸识别数据库MS Celeb,但这些数据早已在业内进行了广泛传播,并且基于这些数据而优化的算法更是无法消除其内嵌的对于个人隐私的破坏。[41]

数据质量缺陷以及算法平衡价值观念缺失所导致的算法歧视也是人工智能对社会治理所形成的一大挑战。实际上,算法的数据运用、决策机制以及结果表征等仍是基于开发者的主观价值选择而形成,开发者的潜在性偏见由此也可能被嵌入其中。此外,人工智能技术的甄别逻辑来自输入数据,如果数据本身不完整或者存在某种倾向性,算法就可能把数据中的干扰因素或数据噪音进一步放大或固化,进而导致“自我实现的歧视性反馈循环”。[42] 例如,根据美国公民自由联盟(ACLU)的一项测试显示,由亚马逊公司所开发的Rekognition图像识别技术错误地将28名美国国会议员识别为嫌疑犯,其中有色人种议员占比达到了39%;根据美国麻省理工学院媒体实验室的研究显示,该技术也无法可靠地识别“女性和皮肤黝黑的人”,其中19%的女性形象被误判为男性,而黑皮肤女性在其中占比为31%。[43] 这种因数据或算法而导致的歧视,就可能引发种族歧视、性别歧视等社会偏见得到技术性的强化,进而对公民的相关权利造成一定的威胁,并对社会秩序的稳定与公平也造成相应的破坏。

(五)人工智能将加剧“技术恐怖”现象的发生

人工智能自身的技术自主性、高度复杂性和风险存续性导致其技术失控存在更大的破坏性,从而导致国家安全可能面临“技术恐怖”的困境。根据德勤公司(Deloitte)发布《悬而未决的人工智能竞赛——全球企业人工智能发展现状》报告显示,当前人工智能发展最突出的三大技术风险分别是“网络安全漏洞、人工智能决策的潜在偏见与基于人工智能的建议做出错误决策”。[44] 其中,前两者主要是从人工智能技术本身出发的。英国牛津大学人工智能治理中心研究员雷姆科·泽维斯洛特(Remco Zwetsloot)则将人工智能在技术层面的风险划分为“事故风险和滥用风险”。[45] 实际上,人工智能不仅存在因恶意使用所导致的技术外溢风险,而且也面临着因技术失控或管理不当所导致的技术内生风险。

从技术外溢风险来看,人工智能技术的成熟以及相关数字资源的开放不仅会催生新的技术扩散风险,并且人工智能本身的技术漏洞也会增加其被攻击或利用的可能。一方面,犯罪分子不仅可以更为便捷、隐蔽地进行小型无人攻击系统及武器的自主研发,并且也能通过对人工智能应用的破坏来获取新型的犯罪能力。[46] 例如,机器学习中所使用的神经网络已在无人驾驶、机器人等领域得到了广泛应用,但原本无害的神经网络可能在遭受对抗样本(Adversarial Example)攻击或遭遇数据劫持后就极易出现隐藏性的偏差,而犯罪分子就能够通过这些人工智能装置来发动非接触式的攻击。[47] 另一方面,人工智能技术研发的秘密性、分散性与不透明性加大了打击技术犯罪以及调控技术稳定性的难度,并且人工智能技术应用边界的模糊性更是加剧了管控技术扩散的难度。[48] 例如,在开源编程逐渐兴起的条件下,人工智能技术的研发便能够在相对秘密的情况下进行,相关研究项目的参与者也具有一定的分散性,进而导致监管者难以对公共危险源进行识别,也无法对这些参与者进行有效的监管。[49]

从技术内生风险来看,不确定的技术缺陷与安全防护措施的不完善是导致人工智能技术出现这一风险的主要原因。人工智能所具有“自我学习”能力使其能够在不需要外部控制或者监督的情况下,就能自主地完成某些任务。正如斯坦福大学人工智能与伦理学教授杰瑞·卡普兰(Jerry Kaplan)所言,“机器学习系统能够发展出自己的直觉,并依照这一直觉来行动”。[50] 但是如果人工智能跃升成具有“自主思维”的主体,形成了自身运行的“技术理性”,那么人工智能就将具备去本地化控制的能力。然而,在人工智能的运行过程中,算法并不会对决策结果进行解释,也无法确定某个特定的数据实例是否会对决策产生干扰。[51] 因此,使用者既无法充分理解算法运行的原理,也无法完全掌控智能系统的决策及其实施进程,进而被动地陷入一种“算法黑箱”(black box)的状态。[52] 同时,尽管人工智能有助于实现决策的强理性与概率化的变革,但是情感、道德等主观性因素无法被充分嵌入这一决策机制,甚至有可能被完全排除在外。这意味着,人工智能难以充分地识别非人道行为,甚至可能自发制定出既定目标之外的非意图性目标(unintended impact)。[53] 此外,基于历史数据的算法模型对潜在的突发性变化并不具备完全的预判能力与应变能力,并且监管环境、风险环境或风险策略等基础条件的变化对于人工智能也具有一定的实时性要求。因此,一旦人工智能不能及时对此进行调整,则同样也可能带来相应的风险。

不难看出,无论是因技术滥用而导致的技术外溢风险,还是因技术缺陷而产生的技术内生风险,人工智能在某种程度上的确存在失去人为有效控制的可能。“一个真实环境中的人工智能系统,会面临数据安全、模型/算法安全、实现安全等多方面的安全威胁。” [54] 当然,人工智能技术的内生风险要比其外溢风险相对更难以控制,前者所可能造成的危害也比后者相对更为严重。尤其是当人类失去对人工智能技术的本地化控制时,就难以再对人工智能技术的研发与应用进行有效监管与控制。在这一状态下,国家安全就可能面临着更多因人工智能技术滥用及其演进路径不确定所导致的“技术恐怖”现象。

综上所述,人工智能技术的发展及应用将对国家安全带来新的挑战。一方面,人工智能技术的介入将加速新型军事能力和战略博弈模式的形成,打破传统的战略对抗模式及其博弈的平衡,进而导致国际体系出现更大的不稳定性与不确定性;另一方面,尽管人工智能技术的应用将有力地推动新一轮产业革命,但同时也将拉大国际行为主体间的能力代差,扩大资本垄断技术与市场的能力,导致社会治理面临诸如算法歧视、数据垄断以及隐私保护等问题,并催生一系列“技术恐怖”的现象。需要指出的是,人工智能技术所导致的国家安全风险已经逐步显现,前述所提及的部分风险也是其他新兴技术应用的共有特性。因此,国家安全在技术共振之下更有可能面临系统性的风险。

[1] John Herz, “The Security Dilemma in International Relations: Background and Present Problems,” International Relations, Vol. 17, No. 4, 2003, p. 41.

[2] William McNeill, The Pursuit of Power: Technology, Armed Force, and Society Since A.D. 1000, Chicago: University of Chicago Press, 1982, pp. 22-23.

[3] 王逸舟:《全球主义视野下的国家安全研究》,载《国际政治研究》2015年第4期,第103页。

[4] 冯玉军、陈宇:《大国竞逐新军事革命与国际安全体系的未来》,载《现代国际关系》2018年第12期,第12-20页。

[5] Michael Mayer, “The New Killer Drones: Understanding the Strategic Implications of Next-Generation Unmanned Combat Aerial Vehicles,” International Affairs, Vol. 91, No. 4, 2015, p. 767.

[6] Andrea Gilli and Mauro Gilli, “The Diffusion of Drone Warfare? Industrial, Organizational and Infrastructural Constraints,” Security Studies, Vol. 25, No. 1, 2016, pp. 76-77.

[7] Jeremy Rabkin and John Yoo, Striking Power: How Cyber, Robots, and Space Weapons Change the Rules for War, New York: Encounter Books Press, 2017, pp. 3-5.

[8] 徐能武、葛鸿昌:《致命性自主武器系统及军控思考》,载《现代国际关系》2018年第7期,第58页。

[9] 唐世平:《一个新的国际关系归因理论:不确定性的维度及其认知挑战》,载《国际安全研究》2014年第2期,第5-6页

[10] Pavel Sharikov, “Artificial Intelligence, Cyberattack, and Nuclear Weapons: A Dangerous Combination,” Bulletin of the Atomic Scientists, Vol. 74, No. 6, 2018, pp. 368-373.

[11] Edward Geist and Andrew Lohn, “How Might Artificial Intelligence Affect the Risk of Nuclear War?” Rand Corporation, May 28, 2018, https://www.rand.org/pubs/perspectives/PE296.html.

[12] Kenneth Waltz, “Realist Thought and Neorealist Theory,” Journal of International Affairs, Vol. 44, No. 1, 1990, pp. 21-37.

[13] Andrew Krepinevich, “The Eroding Balance of Terror: The Decline of Deterrence,” Foreign Affairs, Vol. 97, No. 2, 2018, pp. 62-74.

[14] Perry World House, “Artificial Intelligence beyond the Superpowers,” August 16, 2018, https://thebulletin.org/2018/08/the-ai-arms-race-and-the-rest-of-the-world/.

[15] Dominic Johnson, Overconfidence and War: The Havoc and Glory of Positive Illusions, Boston: Harvard University Press, 2004, pp. 4-5.

[16] Michael Horowitz, “Artificial Intelligence, International Competition, and the Balance of Power,” Texas National Security Review, Vol. 1, No. 3, 2018, p. 41.

[17] 美国约翰·霍普金斯大学教授阿诺德·沃尔弗斯(Arnold Wolfers)将国家安全分为客观安全与主观安全,“安全在客观意义上表现为已获得的价值不存在威胁,在主观意义上则表明不存在一种恐惧——这一价值受到攻击的恐惧。”参见Arnold Wolfers, “National Security as an Ambiguous Symbol,” Political Science Quarterly, Vol. 67, No. 4, 1952, pp. 481-502。

[18] William McNeill, The Pursuit of Power: Technology, Armed Force, and Society Since A.D. 1000, Chicago: University of Chicago Press, 1982, pp. 22-23.

[19] Alexander Gerschenkron, Economic Backwardness in Historical Perspective, Boston: Harvard University Press, 1966, pp. 52-54.

[20] Jacques Bughin, Jeongmin Seong, James Manyika, Michael Chui and Raoul Joshi, “Notes from the AI Frontier: Modeling the Impact of AI on the World Economy,” Mckinsey Global Institute, September 2018, https://www.mckinsey.com/featured-insights/artificial-intelligence/notes-from-the- frontier-modeling-the-impact-of-ai-on-the-world-economy#0.

[21] Yuval Harari, “Who Will Win the Race for AI?” Foreign Policy, No. 231, 2019, pp. 52-54.

[22] 刘中民:《西方国际关系理论视野中的非传统安全研究》,载《世界经济与政治》2004年第4期,第32-37页。

[23] 高奇琦:《人工智能时代发展中国家的“边缘化风险”与中国使命》,载《国际观察》2018年第4期,第39页。

[24] Element AI, “2019 Global AI Talent Report,” April 2, 2019, https://www.elementai.com/ news/2019/2019-global-ai-talent-report.

[25] CB Insights Research, “AI 100: The Artificial Intelligence Startups Redefining Industries,” February 6, 2019, https://www.cbinsights.com/research/artificial-intelligence-top-startups/.

[26] 根据MGI的模拟计算显示,人工智能的初创成本将消耗近五年内潜在收益的 80%,到2030年则将下降至26%左右。但在技术创新的累积效应和功能互补的影响下,人工智能的中长期发展将带来巨大的收益。MGI预计到2030年,人工智能可使全球国内生产总值(GDP)增加13万亿美元左右,即为全球GDP年均增速贡献1.2%。

[27] 封帅:《人工智能时代的国际关系:走向变革且不平等的世界》,载《外交评论(外交学院学报)》2018年第1期,第144页。

[28] Brad Allenby, “Emerging Technologies and the Future of Humanity,” Bulletin of the Atomic Scientists, Vol. 71, No. 6, 2015, pp. 29-38.

[29] Kareem Ayoub and Kenneth Payne, “Strategy in the Age of Artificial Intelligence,” Journal of Strategic Studies, Vol. 39, No. 6, 2016, pp. 793-819.

[30] Ian Sample, “Joseph Stiglitz on Artificial Intelligence: ‘We’re Going towards a More Divided Society’,” The Guardian, September 10, 2018, https://www.theguardian.com/technology/2018/sep/08/ joseph-stiglitz-on-artificial-intelligence-were-going-towards-a-more-divided-society.

[31] CBinsights, “The Race for AI: Google, Intel, Apple in a Rush to Grab Artificial Intelligence Startups,” February 27, 2018, https://www.cbinsights.com/research/top-acquirers-ai-startups-ma-timeline/.

[32] Arif Khan, “The Tech Oligopoly: Disrupt the Disruption,” The Diplomatic Courier, May 14, 2019, https://www.diplomaticourier.com/posts/the-tech-oligopoly-disrupt-the-disruption.

[33] 高奇琦:《人工智能时代的世界主义与中国》,载《国外理论动态》2017年第9期,第45页。

[34] “温特尔主义”(Wintelism)一词取自微软的操作系统(Windows)和英特尔(Intel),是指科技巨头围绕产品标准在全球范围内有效配置资源,并通过制定结构性的行业标准和模块化生产的模式,从而形成标准控制下的产品模块生产与组合以及对其他企业形成在产业链上的控制。参见Jeffrey Hart and Sangbae Kim, “Explaining the Resurgence of U.S. Competitiveness: The Rise of Wintelism,” The Information Society, Vol. 18, No. 2, 2002, pp. 1-12。

[35] Julia Powles and Hal Hodson, “Google DeepMind and Healthcare in an Age of Algorithms,” Health and Technology, Vol. 7, No. 4, 2017, p. 352.

[36] [美] 詹姆斯·亨德勒、[美] 爱丽丝·穆维西尔:《社会机器:即将到来的人工智能、社会网络与人类的碰撞》,王晓、王帅、王佼译,北京:机械工业出版社2017年版,第27页。

[37] 最为典型的便是当下中美两国在5G技术上的竞争,例如WIFI联盟、SD存储卡协会、蓝牙技术联盟、JEDEC固态技术协会等国际技术组织在美国的行政影响与司法威慑下,暂停或者部分暂停了华为在其组织内的会员资格。

[38] Jacques Bughin, Jeongmin Seong, James Manyika, et al., “Notes from the AI Frontier: Modeling the Impact of AI on the World Economy,” Mckinsey Global Institute, September 2018, https://www.mckinsey.com/featured-insights/artificial-intelligence/notes-from-the-frontier-modeling-the-impact-of-ai-on-the-world-economy#0.

[39] 部分学者甚至否定了人工智能应用对于长期的经济增长的作用。例如,伊曼纽尔·卡斯特格(Emanuel Gasteiger)和克劳斯·普雷特纳(Klaus Prettner)基于“代际交叠模型”(Overlapping Generation Models)对人工智能应用之于经济长期的影响进行了分析,认为“由于机器人的使用将抑制工资的增长,投资的增长也由此受到了抑制,而这最终将导致经济的停滞”。参见Emanuel Gasteiger and Klaus Prettner, “On the Possibility of Automation-Induced Stagnation,” Discussion Papers in Business, Economics and Social Sciences, February 24, 2017, https://www.econstor.eu/ bitstream/10419/155784/1/882225014.pdf。

[40] Samuel Kaplan, Humans Need Not Apply: A Guide to Wealth and Work in the Age of Artificial Intelligence, New Haven, CT: Yale University Press, 2015, p. 31.

[41] MS Celeb数据库拥有将近10万人的面部信息,但其中部分数据的采集并未得到用户的授权。与此同时,在微软公司删除该资料库前,IBM、松下电气、辉达、日立、商汤科技、旷视科技等多个商业公司均使用了这一数据库。参见Madhumita Murgia, “Microsoft Quietly Deletes Largest Public Face Recognition Data Set,” the FT Group, June 18, 2019, https://www.ft.com/content/ 7d3e0d6a-87a0-11e9-a028-86cea8523dc2。

[42] Richard Berk, Machine Learning Risk Assessments in Criminal Justice Settings, Berlin: Springer-Verlag Press, 2018, pp. 22-23.

[43] Russell Brandom, “Amazon’s Facial Recognition Matched 28 Members of Congress to Criminal Mugshots,” The Verge, January 26, 2018, https://www.theverge.com/2018/7/26/17615634/ amazon-rekognition-aclu-mug-shot-congress-facial-recognition.

[44] Deloitte, “Future in the Balance? How Countries are Pursuing an AI Advantage,” May 28, 2019, https://www2.deloitte.com/content/dam/insights/us/articles/5189_Global-AI-survey/DI_Global- AI-survey.pdf.

[45] Remco Zwetsloot and Allan Dafoe, “Thinking about Risks from AI: Accidents, Misuse and Structure,” LawFare, February 11, 2019, https://www.lawfareblog.com/thinking-about-risks-ai-accidents- misuse-and-structure.

[46] David Hastings Dunn, “Drones: Disembodied Aerial Warfare and the Unarticulated Threat,” International Affairs, Vol. 89, No. 5, 2013, p. 1243.

[47] Mary Cummings, “Artificial Intelligence and the Future of Warfare,” Chatham House, January 26, 2017, https://www.chathamhouse.org/publication/artificial-intelligence-and-future-warfare.

[48] 秘密性是指人工智能的研究与开发所需的可见设施相对较少;分散性则是指人工智能的研究与开发无需所有部件、人员同时就位;不透明性是指人工智能的运行可能处于秘密状态,并且不能被反向工程控制。当然,这些特征并不是人工智能技术所独有的,信息时代的许多科技同样也具有这些特征。但是,人工智能研究与开发的分散程度和规模以及交互程度都远远超过以往的任何科技。参见Matthew Scherer, “Regulating Artificial Intelligence Systems: Risks, Challenges, Competencies, and Strategies,” Harvard Journal of Law & Technology, Vol. 29, No. 2, 2016, pp. 363-364。

[49] [美] 马丁·福特:《机器人时代》,王吉美等译,北京:中信出版社2015年版,第36页。

[50] Jerry Kaplan, “AI’s PR Problem,” MIT Technology Review, March 3, 2017, https://www. technologyreview.com/s/603761/ais-pr-problem/.

[51] ENISA, “Towards a Framework for Policy Development in Cybersecurity - Security and Privacy Considerations in Autonomous Agents,” March 14, 2019, https://www.enisa.europa.eu/ publications/considerations-in-autonomous-agents.

[52] Mike Ananny and Kate Crawford, “Seeing without Knowing: Limitations of the Transparency Ideal and Its Application to Algorithmic Accountability,” New Media & Society, Vol. 20, No. 3, 2016, p. 975.

[53] 封帅、周亦奇:《人工智能时代国家战略行为的模式变迁——走向数据与算法的竞争》,载《国际展望》 2018年第10期,第57页。

[54] Meredith Whittaker, Kate Crawford, Roel Dobbe, et al., “AI Now Report 2018,” AI Now Institute, October 16, 2018, https://ainowinstitute.org/AI_Now_2018_Report.pdf.

四 对中国的启示:人工智能时代下国家安全治理路径选择

在国家目标和利益的追求序列中,国家安全应是需要国家把握的核心问题,而人工智能技术发展浪潮将导致国家安全治理格局的转变。对于兼具大国与发展中国家的双重身份的中国而言,人工智能技术的发展及其应用所带来的挑战与机遇是尤为突出的。一方面,人工智能技术不仅是中国抓住新一轮科技革命机遇的重要性因素,也是保障中国国家安全的重要驱动力。正如习近平总书记在中共中央政治局第九次集体学习时指出的:“加快发展新一代人工智能是我国赢得全球科技竞争主动权的重要战略抓手,是推动我国科技跨越发展、产业优化升级、生产力整体跃升的重要战略资源。”[1] 另一方面,中国国家安全在经济、政治、军事、社会、宗教、网络、能源和环境等各个领域均面临着多种威胁与挑战。[2] 人工智能技术的嵌入则将促发更多的安全风险,技术研究整体图像的不明晰以及安全治理机制的时滞性还将进一步放大这些安全风险。因此,我们既要紧抓人工智能技术发展的契机,推动、容纳和接受这一新兴技术的突破和创新,更要关注这一技术对国家安全所可能造成的系统性风险。

(一)持续完善人工智能技术发展的战略布局

对于中国而言,人工智能技术的发展不仅有助于加快转变经济发展方式,更是维护国家安全与提升国际竞争力的关键所在。这一技术自主性的提升将在一定程度上减少安全领域的外部脆弱性,尤其是当技术竞争加剧的时候,这一自主性的保障将变得更为重要。目前来看,中国已经将发展人工智能上升至国家战略的高度,并初步构建了支持人工智能技术发展的政策框架,以期在推动新旧动能转换中充分发挥人工智能的作用。然而,中国人工智能的发展相对更加偏好于技术相对成熟、应用场景清晰的领域,对基础理论、核心算法、芯片制造、关键设备等基础技术领域的研究和创新却有所缺失。

中国人工智能发展战略还需要对以下三个问题进行深入思考:第一,如何处理中国人工智能技术发展不平衡、不充分的问题?即如何解决中国人工智能发展在人才、资金、体制和产业链配套上存在的协调性问题。第二,如何实现人工智能发展过程中的正外部性与负外部性之间的平衡?正外部性主要是指人工智能的发展能够显著地促进其他新技术的创新和应用,而负外部性则是人工智能发展导致一系列社会问题。第三,如何实现人工智能技术研发的成果保障与地位维护?例如,中国人工智能企业所采用的基于图形硬件的编程技术(GPU)多数由英特尔、ADM和英伟达(Nvidia)三大巨头企业提供,其所使用的人工智能技术开源框架也均非自主搭建。

从上述问题来看,人工智能发展战略的完善可从以下三方面着手:第一,强化对人工智能技术发展的敏感性与理解力,突出强调对人工智能核心技术的把控,构建自主可控、可持续发展的人工智能的技术创新体系和应用产业体系,从而加强人工智能技术的自主性和掌握发展的主动权。第二,创新人工智能发展的生态布局,在体制机制、人才培养、产业扶持和资金保障等方面提供更多更为全面的配套政策,建立更强有力的公私伙伴关系以推动政策与各类社会资本的共同发力,从而加强技术与产业紧密结合的相互增益和提升人工智能技术发展的可持续性。第三,克服从研发端到部署端的功能孤岛,将包容性原则(Inclusiveness)和开放性原则(Openness)充分纳入到人工智能技术发展的战略规划中,从而加快技术成果转移和促进其他前沿技术的共同发展。例如,在保护数据隐私和数据安全性的前提下,开放卫星图像、交通数据、金融数据等数据集供公众使用,并制定数据集的使用标准、分类标准和共享标准,进而为人工智能技术的发展构建开放、灵活的数据生态。

(二)构建人工智能技术的风险评估机制与保障体系

减少国家安全治理体系调试决策失误的风险和成本的关键在于安全意识的强化和风险应对机制的构建。[3] 根据美国国际战略研究中心(CSIS)发布的《人工智能与国家安全:人工智能生态系统的重要性》报告显示,安全可靠的技术基础是搭建良性人工智能技术发展的生态系统不可或缺的一部分。[4] 因此,减少人工智能技术发展与应用所带来的社会风险同样需要构建完整的风险评估机制及保障体系,并从安全技术和安全管理等层面来协同防范安全风险。为此,我们应在综合考虑人工智能技术发展状况、社会环境、伦理价值等因素的基础上,加强对数据垄断、算法歧视、隐私保护以及伦理道德等问题的预判,为人工智能技术的发展制定相应的规范框架。例如,对于人工智能可能导致的结构性失业应进行系统性评估,据此及时、合理地调整人才技能结构,使其适应新时期经济发展的需要。

与此同时,针对人工智能技术应用可能带来的法律、安全和伦理问题以及各个发展阶段所存在的潜在风险,建立诸如技术风险评估机制、灾难性风险管理机制和技术错误纠正机制等相关可管理安全(managed security)机制,从算法容错容侵设计、漏洞检测和修复、安全配置等方面来增强人工智能技术自身的安全性。[5] 此外,还应提高人工智能技术的可检验性来加强技术应用的透明度与信任度,即人工智能技术中的算法与数据在一定的条件下应当被完整保存和查验,相关企业也应为了公众利益放弃妨碍进行问责的商业秘密与法律主张,尤其是具有高风险的公共领域内应尽量减少使用具有黑箱特性的人工智能技术。[6] 当然,也要积极地发展和应用各类新型技术以弥补人工智能技术所存在的缺陷。例如,区块链技术的应用便能够有助于解决人工智能在数据隐私、安全等方面的问题,从而打破现有的数据寡头垄断,助力人工智能技术的良性发展。

(三)规范技术设计的价值向度以引导技术发展

人工智能技术本身是中性的,但要避免“技术的贪欲”带来的不良后果。而将预设的价值向度嵌入人工智能的算法之中,并制定相应人工智能的正义目标,就能够在一定程度减少人们对其的不当使用或恶意利用。针对人工智能的价值向度,美国皮尤研究中心提出了三点建议:第一,人工智能技术研发应以全球民众的利益为第一要义,因此需要加强国际合作以共同推动技术的发展以及应对可能的挑战。第二,人工智能的价值向度必须突出“人性化”,因此必须确保人工智能能够满足社会与道德的责任。第三,人工智能技术的使用应坚持以人为本,需要通过适时地改革政治与经济体系,提高人机合作的效率和解决技术应用所导致的治理赤字问题。[7]

结合当前人工智能的发展态势,我们仍需要规范人工智能发展的技术伦理和价值取向,从思想源头上增强对人工智能技术风险的预警能力和社会控制能力,确保技术与人性之间的平衡。一方面,要加强技术伦理规范性和建构性的统一,通过恰当的技术设计规范和制约实现正面伦理价值的“预防式置入”,将人工智能伦理从抽象准则落实到相应的技术研发与系统设计中,进而确保技术管理的“工具主义”性质与社会治理的价值理念相兼容;[8] 另一方面,要努力贯彻“以人为本”的技术发展观,促进科学与人文两种精神的充分融合与互补,以保证人工智能的人性化转向。当然,对人工智能技术的风险管控应该力求在机会和风险之间取得平衡,即在人工智能技术的发展与国家安全的维护之间保持平衡,并根据具体情况对相应监督机制进行调整,避免陷入因泛技术安全化误区而导致“技术滞涨”困境。[9]

(四)构建社会治理新型框架以承接技术更新

人工智能技术从思维层面、技术层面和价值层面上展示出巨大的包容性、广泛渗透性和发展主导性,但越是这样强大的力量,就越可能面临惯性束缚与治理困境。美国纽约大学AI Now研究所指出,对于人工智能技术的道德承诺、责任制度以及实践规范应当由相关治理机制进行承接,否则这些规范和准则很少能够得到执行。[10] 总之,规范人工智能技术发展以及降低其安全风险需要对政治、经济和社会等治理结构进行改革。因此,推进人工智能的健康发展,就必须充分把握人工智能的技术属性与社会属性高度融合的特点,协调利益关系、及时化解冲突,注重激励发展与合理规制的协调,进而为人工智能的持续发展构建相应的社会治理机制和路径。

从这个角度出发,构建新型治理框架的首要工作就在于构建涵盖技术开发、行业监管和公共治理等在内的成体系化的法律和规范,增强技术风险决策和立法的针对性与可操作性,并适当扩大特定部门机构权力,使其能够更为充分地对人工智能技术进行监管。同时,明确设计者、使用者、监管者之间的权责关系,形成“行为——主体——归责”的归责体系,并将技术应用的公共安全纳入现有的监管框架,减少因责任不明确所导致的“追责缺口”的机制问题。[11] 此外,也应搭建起连接“行动者网络”和“利益相关者”讨论与合作的新平台,鼓励各级政府与学术机构、非营利组织和私营部门开展广泛对话和持续合作,努力创造一个政府、技术专家、公众等多元一体化的治理决策参与机制,应当减少政策制定者、执行者与技术研发群体间的信息不对称,提高相关部门判别和应对人工智能技术风险的能力。[12]

(五)加强全球合作以提升技术风险管控的效能

国家安全治理本身与全球安全治理之间存在高度的关联性,而且国际组织、非政府组织、企业、社会团体等多元主体也对治理过程、议题和效能发挥着重要的影响。[13] 目前来看,人工智能的国际规则主要由西方发达国家的企业或机构来推动制定,这意味着从全球层面整体考虑的全球性人工智能治理机制是缺位的。[14] 同时,全球主要国家对于人工智能技术开发与应用的具体规则仍未形成统一的共识,各国在人工智能部署原则及发展程度上存在的差异还在一定程度上加剧了非理性竞争。此外,在当前全球贸易关系相对紧张的局势下,以美国为首的发达国家正逐步加大人工智能军事化应用的研发力度,还以国家安全为由来限制人工智能技术在全球范围内的推广与共享。然而,尽管当前各国在人工智能技术上的竞争日趋激烈,但这不应被视为一场“零和博弈”。全球科技的进步本身需要各国的参与,而技术风险的防范更是需要各国的合作。对此,布鲁金斯学会外交政策研究员瑞安·哈斯(Ryan Hass)和扎克·巴林(Zach Balin)认为,尽管人工智能技术对国际关系造成巨大的压力,但同时也将为各国提供潜在的合作机会。[15] 有鉴于此,应对人工智能可能带来的技术风险需要国际社会的共同参与。

根据当前全球人工智能的发展态势,当务之急在于加快制定符合国际关系准则和人类道德约束的技术开发控制协议或公约,推动国际社会在一些根本性、原则性的规则和伦理上达成共识,进而构建具有科学性、系统性、前瞻性的人工智能标准规范体系,并力促国际认同技术风险的治理框架和协调一致的治理机制的形成。同时,应为人工智能技术的发展搭建更为广泛的国际合作与治理网络,推动全球分散的、相对孤立的治理程序与要素资源的积极整合,构建以主权国家、非政府组织、市民社会和跨国公司为主体的综合治理体系。此外,积极推动开展持续、直接、权威的多边沟通,对于人工智能技术开展合作性与建设性的管理,确保人工智能技术的和平开发和加强对国际性技术风险事故的防范能力。[16] 当然,中国更要明确和坚持人工智能技术发展的和平导向,即在人工智能技术的军事化应用中应当保持极大的克制性,兼顾多方的利益考虑,在技术发展和国家竞争中实现适当的平衡,确保人工智能为人类所用和促进全人类平等受益。作为在人工智能发展上拥有全方位资源优势的中国与美国,更应充分发挥各自在人工智能领域的优势,积极在这一技术领域找到合作的出口,为全球人工智能技术的合作与竞争发挥良性的示范作用。

[1] 习近平:《“确保人工智能关键核心技术牢牢掌握在自己手里”——中共中央政治局举行第九次集体学习》,载《人民日报(海外版)》2018年11月1日。

[2] 复旦大学国际关系与公共事务学院“国务智库”编写组:《安全、发展与国际共进》,载《国际安全研究》2015年第1期,第4页。

[3] 梅立润:《人工智能如何影响国家治理:一项预判性分析》,载《湖北社会科学》2018年第8期,第27页。

[4] 该报告将人工智能生态的构建分为四个重要组成部分,除了安全可靠的技术基础外,还包括良好的投资环境和政策体系、熟练的劳动力和充分的知识管理与获取、处理和利用数据的数字生态等三个方面。参见Lindsey Sheppard and Andrew Hunter, “Artificial Intelligence and National Security, The Importance of the AI Ecosystem,” CSIS, November 25, 2018, https://www.csis.org/ events/artificial-intelligence-and-national-security-importance-ai-ecosystem。

[5] Karen Yeung, “Algorithmic Regulation: A Critical Interrogation,” Regulation & Governance, Vol. 12, No. 6, 2017, p. 22.

[6] Will Bunch, “AI is not a Quick-Fix Solution for Discrimination,” Human Resource Executive, November 7, 2018, http://hrexecutive.com/ai-is-not-a-quick-fix-solution-for-discrimination/.

[7] Janna Anderson, Lee Rainie and Alex Luchsinger, “Artificial Intelligence and the Future of Humans,” Pew Research Center, December 10, 2018, https://www.pewinternet.org/2018/12/10/ concerns-about-human-agency-evolution-and-survival/.

[8] Roger Brownsword, “Technological Management and the Rule of Law,” Law, Innovation and Technology, Vol. 8, No. 1, 2016, p. 101.

[9] Salil Gunashekar, Sarah Parks, Joe Francombe, et al., “Oversight of Emerging Science and Technology: Learning from Past and Present Efforts around the World,” RAND Corporation, March 2019, https://www.rand.org/pubs/research_reports/RR2921.html.

[10] Meredith Whittaker, Kate Crawford, Roel Dobbe, et al., “AI Now Report 2018,” AI Now Institute, October 16, 2018, https://ainowinstitute.org/AI_Now_2018_Report.pdf.

[11] Bernd Stahl and David Wright, “Ethics and Privacy in AI and Big Data: Implementing Responsible Research and Innovation,” IEEE Security & Privacy, Vol. 16, No. 3, 2018, p. 30.

[12] 庞金友:《AI治理:人工智能时代的秩序困境与治理原则》,载《人民论坛·学术前沿》2018年第10期,第16页。

[13] 蔡拓、杨雪冬、吴志成:《全球治理概论》,北京:北京大学出版社2016年版,第12页。

[14] 高奇琦:《全球善智与全球合智:人工智能全球治理的未来》,载《世界经济与政治》2019年第7期,第20页。

[15] Ryan Hass and Zach Balin, “US-China Relations in the Age of Artificial Intelligence,” January 10, 2019, Brookings, https://www.brookings.edu/research/us-china-relations-in-the-age-of-artificial- intelligence/.

[16] 鲁传颖、[美] 约翰·马勒里:《体制复合体理论视角下的人工智能全球治理进程》,载《国际观察》2018年第4期,第73页。

五 结语

事实上,新的科学技术发展与国家安全治理息息相关,随着技术的进步,持续动荡与不确定的风险会不断累积,国家安全治理格局的转变也将是不可避免的结果。与此同时,国家安全治理对于技术升级的方向同样存在着一定的影响,尤其是当国家安全压力增大时,技术的投入极易向与安全相关的领域倾斜。但是,安全和发展是一体之两翼、驱动之双轮,发展是安全的基础,安全是发展的保障。[1] 因此,把握科技的发展主动权与应对好相应的技术风险是保障未来国家安全的重要命题。

作为一种框架性的底层技术,人工智能将对国家发展产生根本性的推动作用,也将为国家安全治理带来广泛深刻的结构性挑战。首先,“在未来的技术竞赛中,最成功的国家将是那些积极变革并且能够跟上技术进步的国家”。[2] 尤其是在当前全球技术及知识外溢红利逐步减弱的趋势下,已被嵌入多个应用场景的人工智能极有可能将成为下一轮技术革命与产业革命的关键点。其次,人工智能成为国际战略竞争与合作的又一重要领域。但在当下国家实力对比变化和战略政策调整的大背景下,各国在人工智能技术上的战略竞争的可能性或将远超合作的可能性。在这两方面的交叉下,对于人工智能技术的发展需求将优先于对这一技术安全性的考量。然而,人工智能不仅将对全球价值链的整合与社会的公共管理造成极大的影响,并且其演进路径的不确定性也将可能导致诸多的技术风险。因此,在这一发展需求优先和技术风险凸显的状态下,人工智能就可能导致国家安全中出现更多的不稳定因素。

当然,新技术的正向良性发展的关键不仅在于推动技术的创新与完善,更取决于人类的有效规制与引导。因此,对于中国而言,如何统筹人工智能技术发展与国家安全治理,并实现这两者综合成本的明确化、内部化与协调化将是未来工作的重点之一。在这一过程中,最为重要的仍是保持中国在人工智能技术领域的领先性与自主性,并通过多样化方式对这一技术发展潜在风险进行研判和预防,进而充分维护好自身的战略利益。同时,我们应积极主持、参与全球人工智能相关标准的构建,提升中国在人工智能技术发展上的国际道义制高点、议程设置能力与话语权。此外,我们还应积极地同各国在人工智能技术的发展上展开深度对话,力促在人工智能的战略竞争与合作上形成“竞争性共荣”(competitive coprosperity),进而塑造一种能够推进务实合作和建设性竞争、有效管控技术风险与防范重大冲突的国际秩序。

[1] 冯维江、张宇燕:《新时代国家安全学——思想渊源、实践基础和理论逻辑》,载《世界经济与政治》2019年第4期,第23页。

[2] 冯昭奎:《科技革命发生了几次——学习习近平主席关于“新一轮科技革命”的论述》,载《世界经济与政治》2017年第2期,第23页。

作者简介

阙天舒,华东政法大学中国法治战略研究中心副主任、教授;

张纪腾,华东政法大学政治学研究院硕士研究生

文案编辑:杨兆鹏

(本文部分图片源于网络)

声明:本文来自国际安全研究ISS,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。