“几乎在每一次的重大事件中,社交媒体上都会出现误导性视频和照片。”路透社UGC内容部门主管黑兹尔·贝克的这番言论,反映了一种真实存在的传播特征。

目前新闻报道的形式愈发多样化,视频、图片等元素,很多时候比文字更具冲击力。然而,与白纸黑字相比,视觉素材不仅更易造假,其中的错误信息也更容易扩散。

2020年初,一张「被火烧焦的澳大利亚」的图片在社交媒体上引起病毒式转发,连著名歌手蕾哈娜也转发了这张图以表达自己对火灾的关切。然而,该图最终被辟谣,其来源于艺术家Anthony Hearsey基于NASA收集的一个月的数据叠加创作的可视化模型,而非某一具体时刻澳大利亚的火灾蔓延情况。

诸如此类的案例不在少数,如何判断虚假内容以及核查相关信息,可以说一直是新闻行业的重要议题。

本期全媒派(ID:quanmeipai)编译《新闻实践》期刊的论文,盘点视觉传播中现存的虚假或错误信息的炮制形式,探讨视觉新闻核查方法的现状与未来。

五大障眼法:视觉信息的虚假呈现

随着图片和视频编辑技术的日益成熟,网络上出现了越来越多来源不明、准确度不高的图像。记者、媒体机构和监管部门往往无法通过简单地探究图像的来源去确定其真实性,于是,“数字取证”成为了核实图片内容是否可信的重要辅助手段。

首先,需要了解虚假或错误信息的类型。在图像信息中,有以下五种常见的图像处理方式可能导致虚假或错误信息的产生:

复制-移动

复制-移动操作是将图像中的一个像素区域复制下来,并将其移到图像中的另一个区域。

组图中,上图的“怪异设计”便来自于对原图内部元素的复制移动,把字母整体选出并移动到新位置,形成搞怪的效果。复制-移动操作是最常见的图像伪造技术之一,因为对于肉眼而言,这一操作没有改变图像的内部一致性。

图源:boredpanda

这一操作留下的痕迹也是最常见的检测对象之一,图像JPEG压缩不一致、CFA插值不一致、对比度不一致等,都能作为识别该操作的指标,因此它能被大多数基于深度学习的通用分类器检测到。

针对此类行为,美联社和澳大利亚的媒体娱乐与艺术联盟(MEAA)都提供了有关编辑和展示新闻图像的道德行为指导,其他新闻界的权威机构在这一方面也有相关准则。

美联社规定“不能人为增加或者减少照片中的任何元素”;MEAA也要求“呈现真实和准确的图片和声音,任何可能导致误解的操作都应该被披露”。

拼接

拼接,又称图像合成,与复制-移动类似。不同之处在于,复制-移动是单一图片内的元素操作,而拼接则涉及到一张以上的原素材,操作中将一个图片的克隆区域复制到另一个图片中,形成一个合成图像。拼接同样可以通过比对JPEG压缩、CFA插值、对比度等参数的不一致以及通用分类器来检测。

澳大利亚山火的虚假图片中便有利用拼接将不同元素放入同一图片中的案例。伪造者从原图以外的照片中拷贝出了考拉、防毒面罩和火焰的元素,拼接到了小女孩站在水面上的原图中。

澳大利亚山火拼接图,左图为拼接结果,右图为主要原素材。(图源:原论文)

重新采样

重新采样通常用于调整大小、旋转、拉伸或倾斜的过程,以得到不同像素密度的图像。美联社允许去掉背景,或在不含额外表意的背景上叠加图形元素,形成一个新的艺术图像,但强调“这样的构图不能歪曲事实,也不能让图像看起来像真实照片,它必须能明显让人看出是一个后期制作的图形”。

用于重新采样的算法会在被操作区域内留下数据痕迹。通常可以从CFA插值不一致、噪点不一致,或者用一般分类器来检测判断。

图源:boredpanda

左边这张魔法建筑般半悬空的城堡,便是将泰国一块岩石和德国一座城堡的照片通过拼接加上重新采样两种操作方式一起完成的。在将城堡拼接到岩石上的过程中,需要对城堡的图样进行大小调整,以符合原图中岩石的尺寸。

后期修图

后期修图是指对图像进行一些微小调整,以强调或掩盖瑕疵、粉刺、疤痕等局部特征,通常出现于人物照片的后期制作过程。

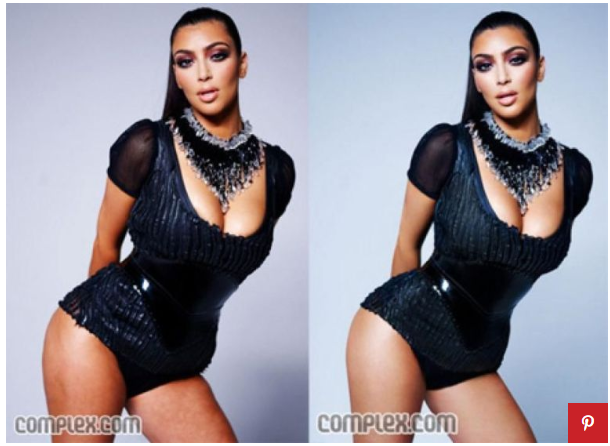

2009年3月,网红金·卡戴珊的一张未经修图的原照传出,两图对比,可以看出五官、四肢的调整。修图后的照片更加“光彩照人”。类似的“照骗”,在国内也很常见。

图源:complex.com

根据美联社的原则,新闻图片中唯一允许的后期修图是“消除相机传感器上的灰尘和扫描底片或扫描印刷品上的划痕”。后期修图也可以通过寻找CFA插值不一致、噪声不一致以及使用一般分类器检测。

裁剪

裁剪是去除图像边缘不需要的区域。裁剪是一种标准、广泛、可接受的新闻图片编辑形式,除非其目的是为了欺骗。然而,它也经常被用于隐藏对象或掩盖背景。被裁剪过的照片通常可以通过裁剪边缘JPEG压缩的不一致来判断。

2017年,美国国家公园管理局对在华盛顿纪念碑拍摄的官方照片进行了裁剪,这些照片显示了唐纳德·特朗普的就职典礼人群规模。被裁剪的照片留下了较少的背景,使得读者难以从照片中判断出当时的人群规模。

特朗普就职典礼人群规模照片,左图为全景,右图为裁剪后的呈现。(图源:原论文)

核查喜与忧:工具很多,效率偏低

学者和从业者们对新闻场域中视觉呈现的相关伦理,以及数字时代下更广泛的图像伦理都进行了深入的论述。规范之下,假新闻仍然难以避免,于是事实核查逐渐成为新闻学界和业界关注的重点对象之一。大量研究围绕记者的社交媒体信息验证展开,但视觉呈现方面的验证,尤其是在时效性强的突发新闻语境下的验证上,研究还有待加强。

目前,出现了专门负责信息核查的机构,为新闻从业者提供操作建议和相关的检测工具。这些工具也成为了行业重点观察借鉴的对象,为后续验证工具的发展提供了重要的经验参照。

核查过程涉及到新闻收集和传播两个关键节点。前者是在发现新闻来源时,例如当记者在社交媒体上搜索并考虑分享一个帖子时。后者是在相关新闻组织的网站上发布时,例如当记者将推文嵌入新闻文章,或是将内容上传到媒体的内容管理系统时。

开发社交媒体验证工具的Reveal为该领域中的先驱,该组织提供了两种工具:一个是新闻工作者决策支持系统(JDSS),该系统是一个免费可扩展的Twitter分析平台,允许记者在Twitter上抓取帖子,并找到与验证任务相关的用户生成内容(UGC)。平台最多可以允许19名记者同时使用,每个人都可以实时交互式浏览1万个帖子。所有帖子都会自动运行背景分析,其中包括情感分析、虚假媒体标签以及有新闻价值的说法提取。记者可以对帖子进行交互式探索,快速找到与被核实事件或诉求高度相关的背景帖文集群。

另一个是图像核查助手(Image Verification Assistant),这是一个基于浏览器功能的免费工具,旨在供新闻工作者测试视觉图像是否被篡改。该工具还提供了元数据分析(但对发布在社交媒体平台上的图片不起作用,因为上传时这些元数据会被剥离)和反向图片搜索功能。

《纽约时报》与IBM也合作开发了新闻溯源项目,能辅助使用者核实照片来源以及是否经过编辑。项目力求减少错误信息的传播,使读者能够对他们在网上看到的新闻做出更明智、更自信的判断。

图片来源:图虫Premium

数字图像研究相关的专家及行业机构也陆续推出了一些有关视觉信息传播的培训手册指南:专门研究数字图像分析的美国大学教授汉尼·法里德从图像元数据、信息参数方面提供了侦察图片后期处理的办法;国际事实核查网络的所有者、非营利性新闻学院和研究组织Poynter Institute同样从肉眼不可见的数字信息角度提供了核查指南;路透社与Facebook合作推出了免费在线短期课程《识别和处理被修改的媒体内容》……

然而,在实际操作流程中,事实核查的效率还处于一个较低的水平,专业知识、互联网技能、图片编辑经验等因素都影响着记者的判断。许多虚假图像无法通过肉眼识别,需要一定的专业储备,了解图像相关参数的查询方法,辅以记者本身的直觉、新闻判断力和质疑既定叙事的意愿,才能最终作出较为精确的判断,而这需要较多的时间精力。

新闻编辑室常常顶着较大的时效压力,无法花大量时间进行详细的事实核查,记者们对于核查工具的使用率也十分低下。2017年,国际记者中心(ICFJ)进行的一项全球定量研究发现,在媒体操作过程中,社交媒体核查工具的使用率非常低。ICFJ调查了130多个国家的2700名记者和媒体管理人员,发现只有11%的受访者使用社交媒体核查工具。许多新闻编辑部认为事实核查对记者来说是个难题,有46%的受访媒体提供过社交媒体研究和核查方面的培训,但只有22%的记者认为此类培训“有用”。

此外,部分社交平台图片参数的缺失,也是核查路上的又一拦路虎。例如,由于缺少原始、未经编辑的版本,逆向图像搜索无法帮助记者发现社交媒体账户上发布的图像经过了后期修图。

希望在未来:核查技术需赶上造假技术

在过去的三年里,用于伪造虚假信息的图像生成工具的易用性、低价性和普及性急剧上升。例如,自2017年浮出水面进入公众议题以来,“深度伪造”已经从需要大量的训练数据集(数千张以上图片)、大量的技术、时间、处理能力,发展到现在几乎可以瞬间在像ReFace这样的应用程序上创建出效果逼真的图像。

针对虚假信息的核查,第一步是媒体的投入,新闻机构的管理者和记者本身也都需要加大在事实核查方面的重视程度,投入更多的时间与精力了解相关的背景知识和操作方法。而实际的侦察过程中,工具的可靠程度也成为了需要予以关注的部分。

图片来源:图虫Premium

由于机器学习和人工智能的普遍使用,深度学习越来越多地被用于图像篡改的识别。深度学习是神经网络算法的一个子类(深度神经网络,或DNN),经过训练后,它可以将输入的信息分类为特定的预定义类别。

与传统的人工查询数据取证算法相比,DNN不需要事先了解图片的精确操作方式。它们需要的是一个有代表性的已处理和未处理的图像样本(训练数据)。这些样本数据通过网络反复输入,使用算法反复修改内部参数,将样本的分类精度进行最优化呈现。经过训练的DNN可以高效识别被操纵篡改的图像。

不过,深度学习的算法训练对数据集有较高的要求,需要更具代表性,以提高新闻和公共传播方面的核查准确率。目前许多训练集中的数据本身由计算机生成,或者是从非常有限的公开图像中提取。所以,和路透社、法新社或美联社进行数据库合作,用实际的新闻图像进行训练,将在很大程度上提升算法的可靠度。

最后,在这一点上,公司之间也存在合作空间。大科技公司是最有潜力解决这些问题的,它们拥有着最大的训练数据集,以及技术基础设施和工程团队。具体的设计最好是由开发人员、记者和公众共同完成,并且能够直接整合到社交媒体平台中。

需要注意的是,向谷歌、Facebook等巨头平台,实际上可能受益于某些抓人眼球的虚假信息所带来的流量和广告收入,因此,整顿虚假信息的同时,它们可能也需要综合考虑,潜在的收入损失和监管罚款的风险,哪一项更致命。

文献来源:

[1] T.J. Thomson , Daniel Angus , Paula Dootson , Edward Hurcombe & Adam Smith (2020): Visual Mis/disinformation in Journalism and Public Communications: Current Verification Practices, Challenges, and Future Opportunities, Journalism Practice, DOI:10.1080/17512786.2020.1832139

声明:本文来自全媒派,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。