来源:隐私计算联盟成员-中国工商银行软件开发中心

材料支撑:隐私计算联盟成员-北京数牍科技有限公司

作者:强锋,蔡超超,张闯,张鹏,相妹,薛雨杉,韩盼,袁学勇

[摘要]金融行业是数据密集型产业,目前行业内各家银行、保险等企业对自有数据已经做了比较充分的挖掘。面对同质化竞争,传统金融创新需要向融合数据和线上场景转型。在数据融合需求旺盛的同时,近年来外部数据协作频频被爆出数据不正当使用、侵犯客户隐私、业务合规性存疑等问题。在实际业务中,外部数据的使用充满风险。

如何从最底层的技术手段,将数据的所有权和使用权进行分离,从源头保证数据协作的合规性,能够真正做到数据的“可用不可得、可用不可见、可用不可拥”,在旺盛的业务需求面前成为了最大的挑战。

在众多学术界和工业界的尝试中,隐私计算技术被日益关注。对于数据及隐私保护问题,隐私计算通过综合密码学、统计学等基础学科理论及工程优化实现,可以针对性地解决目前数据协作中所遇到的各项挑战。

本文将对现有法律法规中的数据合规性问题进行梳理,结合隐私计算具体应用场景以及隐私计算原理,对隐私计算在金融领域的合规性进行分析。

[关键字] 隐私计算 合规性 个人数据 联邦学习

1.概述

2020年4月,《中共中央,国务院关于构建更加完善的要素市场化配置体制机制的意见》中建议“加快培育数据要素市场,推进政府数据开放共享,提升社会数据资源价值,加强数据资源整合和安全保护”,数据作为第五大生产要素写入文件。作为数据共享、交易、流通的关键技术支撑,隐私计算技术被行业密切关注。

对于银行、保险、信托券商等金融领域企业,有大量和外部开展数据共享交易的业务需求,数据流通对金融业的业务有着极为巨大的价值。

近年来数据泄露事件频发,明确数据的所有权,并将所有权和使用权进行分离,成为了开展普遍的数据流通的前提。隐私计算技术,提供了一种技术手段,从源头保证数据流通的合规性,能够做到数据的“可用不可得、可用不可见、可用不拥”。

2.数据安全的法律法规正日趋完善

目前各国对于数据安全、数据协作等方面的立法在近几年正逐步完善。2018年欧盟《通用数据保护条例》(GDPR)、2020年美国《加州消费者隐私法案》(CCPA)明确了个人数据可应用的范围和应用中用户的知悉权。发展中国家中,印度、巴西等国也已为个人信息保护立法。

随着《数据安全法(草案)》、《个人信息保护法(草案)》等关键法律法规相继出台,我国数据安全、个人隐私保护的法制化迈向全方位。

其中,对于个人信息传输和使用过程中的安全问题,我国法律做出如下规定:

· 《民法典》第一千零三十八条:信息处理者对个人信息安全的保护义务。“信息处理者不得泄露或者篡改其收集、存储的个人信息;未经自然人同意,不得向他人非法提供其个人信息,但是经过加工无法识别特定个人且不能复原的除外。”

· 《网络安全法》第四十二条:网络运营者不得泄露、篡改、毁损其收集的个人信息;未经被收集者同意,不得向他人提供个人信息。但是,经过处理无法识别特定个人且不能复原的除外。

· 《个人信息保护法(草案)》第四条:个人信息是以电子或者其他方式记录的与已识别或者可识别的自然人有关的各种信息,不包括匿名化处理后的信息。个人信息的处理包括个人信息的收集、存储、使用、加工、传输、提供、公开等活动。

其中,在《个人信息保护法(草案)》中强调,“匿名化”指满足“无法识别且无法复原”标准的信息才不属于个人信息,将“匿名化处理后的信息”排除在“个人信息”的范围之外。

金融领域在个人信息保护的立法和实践已实行多年。在《中华人民共和国中国人民银行法》、《中华人民共和国商业银行法》、《中华人民共和国证券法》、《中华人民共和国保险法》中,均明确提出了保护个人金融信息的要求。

2020年2月13日中国人民银行发布的《个人金融信息保护技术规范》中明确规定了个人金融信息在收集、传输、存储、使用、删除、销毁等生命周期各环节的安全防护要求。并且明确了使用个人金融信息时“应向个人金融信息主体告知共享、转让个人金融信息的目的、数据接收方的类型,并事先征得个人金融信息主体明示同意,共享、转让经去标识化处理(不应仅使用加密技术)的个人金融信息,且确保数据接收方无法重新识别个人金融信息主体的除外。”

同时,中国人民银行发布的《个人金融信息保护技术规范》对于因金融产品或服务的需要,将收集的个人金融信息委托给第三方机构(包含外包服务机构与外部合作机构)处理的情况,对第三方机构等受委托者要求:

对委托处理的信息应采用去标识化(不应仅使用加密技术)等方式进行脱敏处理;

应对委托行为进行个人金融信息安全影响评估,并确保受委托者具备足够的数据安全能力,且提供了足够的安全保护措施。

通过对以上法律法规总结,可以发现:

个人信息数据的共享,开放,交易,应遵循数据“不可还原”、“不可重标识”的基本原则;

对已授权数据或无需授权数据的使用合规性,相关的法律法规及技术规范明确要求了数据协作过程涉及的各个环节,各参与方需要承担相应的职责。

3. 隐私计算由哪些技术构成?

隐私计算技术主要分为联邦学习、多方安全计算、全同态加密以及差分隐私四个主要方向。对于这四个方向,虽然各自的原理不同,但是对于“可用不拥”、“不可还原”、“不可重标识”的合规性要求,均具有天然的契合优势。

3.1 联邦学习

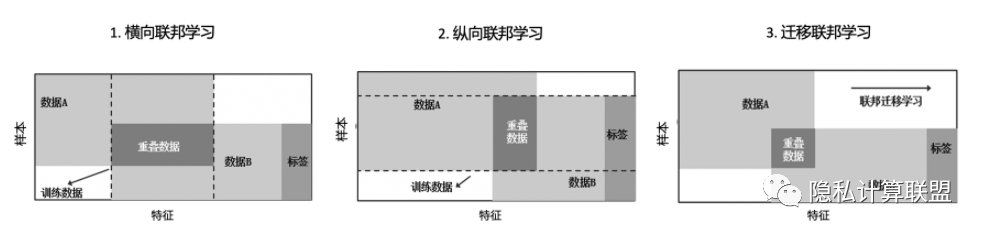

联邦学习是指多个参与方在互不公开原始数据的前提下,共同训练AI模型的技术。联邦学习是机器学习技术和多种隐私保护技术的有机结合,包括多方安全计算,差分隐私等。按照参与方之间的数据特点,联邦学习可以分为横向联邦学习、纵向联邦学习和联邦迁移学习,如图2所示。

图1联邦学习分类示意图

联邦学习实现了各方原始数据不出库的前提下,通过传输加密的梯度参数等模型训练中间参数,实现同时使用但不泄露各方数据,将各方数据价值最大化利用的建模方式。在整个联邦学习的过程中,原始数据始终做到“不出库”,不会直接传输至其他协作方环境。

与直接汇集各参与方数据进行建模的技术方案相比,联邦学习避免了原始数据的传输,从根本上保证数据“不可还原”、“不可重标识”,更加符合各项法律法规对合规性的要求。

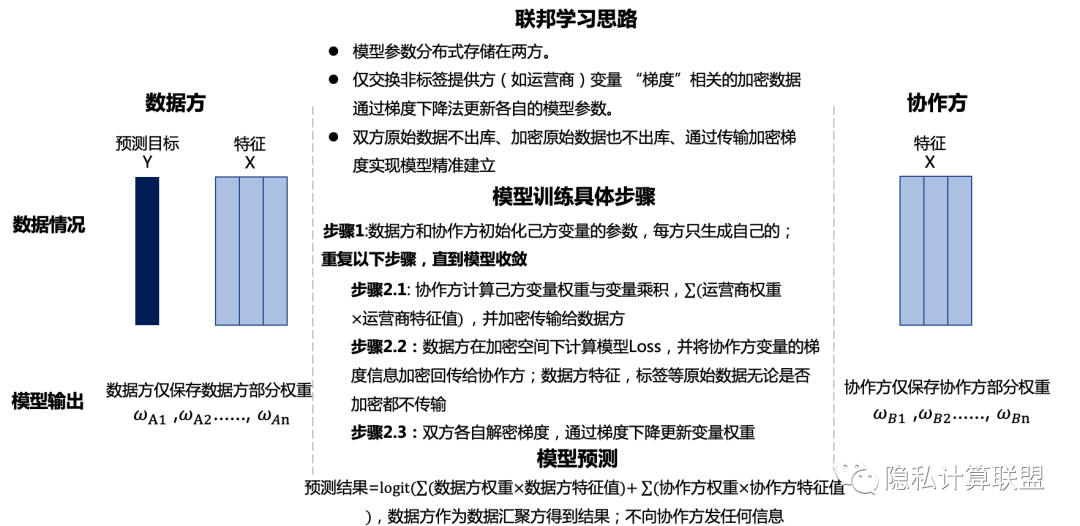

以纵向逻辑回归算法为例,联邦学习在模型训练过程中,通过双方共同计算梯度信息,并通过梯度下降法迭代更新本方权重。但是,由于梯度的本质是基于原始输入数据的函数,根据相关论文研究,梯度的暴露可能存在原始数据泄露的风险1-2。所以,在实际的算法及工程实现中,通常通过以下两种方式对梯度信息进行保护:

· 通过增大batch大小,使得梯度无法暴露每个样本的具体信息;

· 将梯度及相关中间数据以密文或秘密碎片的方式进行传输,在整个计算过程中,所有梯度及相关中间数据均在密态下进行。

具体示意如下:

图2联邦学习流程示意图

通过上述的处理,联邦学习可以保障在不暴露明文数据及不暴露潜在数据信息的情况下,完成模型训练任务。

此外,在模型预测过程中,如果对模型预测任务不进行适当的限制,可能会导致模型参数或样本数据的泄露。所以,在模型实际应用过程中,需要对整体预测任务对模型的用法,对待预测样本的用量进行控制,以避免在模型预测过程中泄露模型参数及样本数据。

综上,通过传递参数、对参数进行保护以及在预测过程中的控制,联邦学习可以保证数据的“可用不拥”、“不可还原”、“不可重标识”,满足各项法律法规对合规性的要求。

3.2安全多方计算

多方安全计算是密码学的重要分支,它通过一系列经过严格证明的密码学协议(如秘密共享、不经意传输等),实现了互不信任的多个参与方在不泄露自身原始数据的前提下,得到准确的计算结果。

安全多方计算技术数据处理过程中各处理者所能获取的信息都被限定在了尽可能小的范围,同时通过对这些信息进行加密,就能从技术上限定这些信息仅能被用于当前的处理目的。所以,安全多方计算技术天然的满足“可用不拥”、“不可还原”、“不可重标识”的合规性要求。

3.3 同态加密

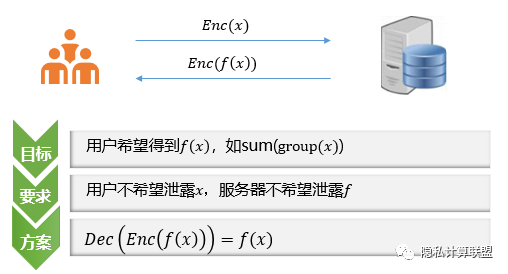

同态加密是指满足密文同态运算性质的加密算法。明文数据经过同态加密后,可以基于得到的密文进行特定的计算。密文计算的结果通过解密,等同于明文数据直接计算的结果,实现数据的“可算不可见”,如图3所示。

图3同态加密示意图

同态加密技术可以避免数据处理者接触明文数据,和“可用不拥”、“不可还原”、“不可重标识”的合规性要求是相通的,同样能够减少数据泄露的现实风险。

3.4差分隐私

差分隐私是一种通过对原始数据加入噪声,在损失部分数据精度的前提下保护数据隐私的技术。最早由Dwork在2006年提出,是针对统计数据库的隐私泄露问题的一种隐私保护技术。在这个场景下,差分隐私技术能最大限度减少个体被识别的机会,同时有效控制对计算结果的影响。差分隐私不仅仅被应用到统计数据库安全领域,也被广泛应用于数据隐私发布与数据隐私挖掘中。数牍科技利用差分隐私技术进行相关的工程实践,利用本地化的差分隐私技术,对需要进行联合建模的数据进行安全处理,从而保护特定用户的隐私信息。

与其他技术相比,差分隐私技术在“可用不拥”、“不可还原”、“不可重标识”的合规性要求中扮演的角色更特殊一些,具体可以分为两类:

一方面,我们可以使用差分隐私技术,达到比“不可还原”、“不可重标识”更高的要求;例如我们可以给一个本身已经满足了“可用不拥”、“不可还原”、“不可重标识”的方案加入差分隐私,进一步降低其数据泄露风险;

另一方面,如果一个方案由于成本等种种原因,不得不传输或采集超出目标之外的信息,可以使用差分隐私技术对这些信息增加干扰,这样对于数据下游的接受方来说,其能够获得的额外信息量更少,更符合“可用不拥”、“不可还原”、“不可重标识”的合规性要求。

4.隐私计算在金融领域应用如何满足数据应用合规

金融领域的数据共享交易,在数据安全及应用合规性的保障,以往只能通过法务及商务上的约定。当数据输出后,数据所有方则完全失去了对数据的控制,即使在法务和商务上具备事先的约定。但是如果出现输出数据被泄漏的情况,对于数据所有方也会造成无法挽回的损失。

而隐私计算技术,可以做到数据的“可用不拥”。即:完成双方约定的计算目标,但双方原始数据均不输出。实现法律法规对数据协作过程中的要求,并且在此基础上,可以为数据协作的各方提供更加安全的数据保障。

以下,我们以金融领域的两个常见案例,介绍其具体原理。

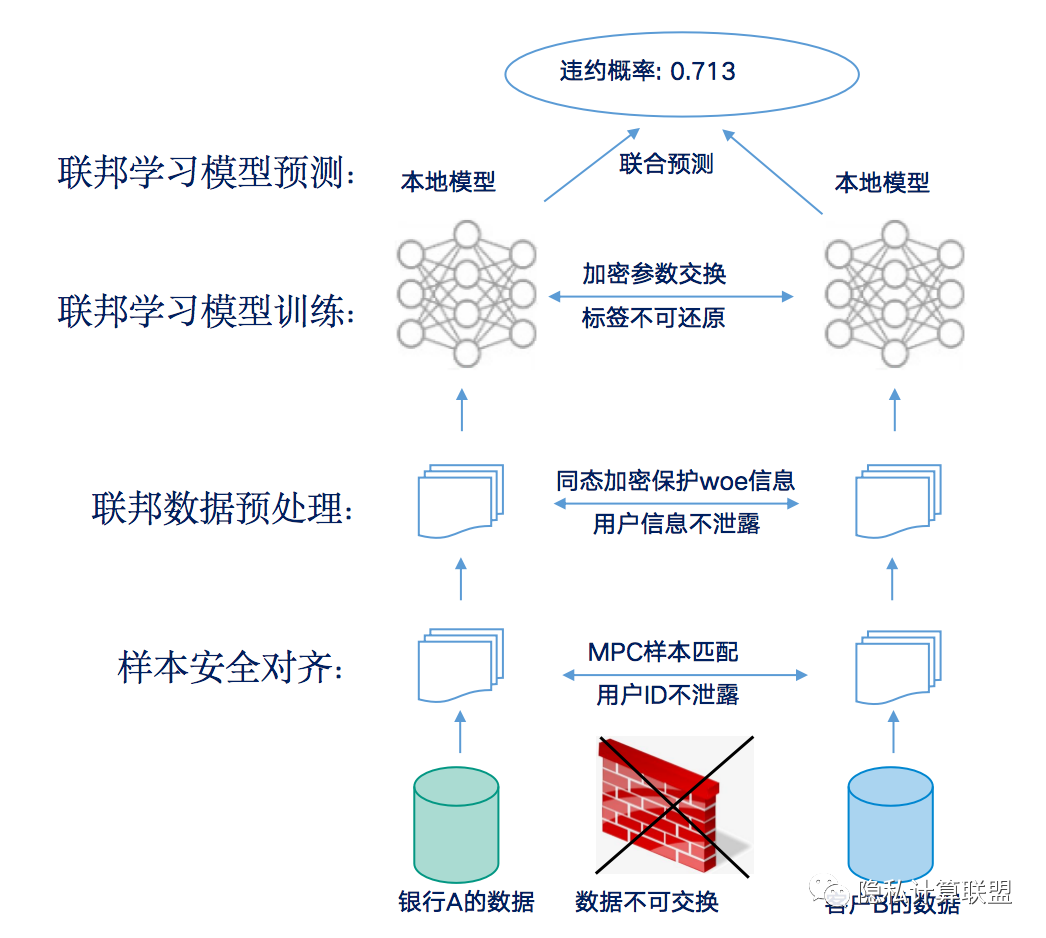

4.1 联邦信用风险评估保证了原始数据“不可还原”

信用评分卡模型作为金融业一项重要的风险控制手段在行业中广泛应用。基于联邦学习的信用评分卡建模,可以实现银行和外部数据方合作建立申请评分卡。此场景,银行拥有部分特征和标签,数据方拥有部分特征。其实现流程如下:

(1)样本安全对齐:利用隐私保护集合求交技术,在双方不公开各自数据的前提下确认共有的交集用户,不暴露用户差集。

(2)联邦数据预处理:对共有样本的原始数据进行分箱,通过结合同态加密,秘密分享等隐私计算技术,计算分箱的WOE值,解决特征之间量纲化问题。在联邦学习的建模过程中,只能得到群体(如分箱)的统计信息(如WOE和IV),但并不暴露任何个人原始数据及分箱结果。

(3)联邦评分卡模型训练:在对预处理后的数据进行训练过程中,双方各自的数据均保留在本地。隐私计算技术以数据最小化为原则,将中间梯度通过秘密碎片、加密等形式进行传递,保证参与方在整个计算的过程中难以得到除计算结果之外的额外信息,也难以逆推原始输入数据和隐私信息。

(4)模型应用:只获取由多个特征分箱统计结果的组合,构成的预测违约概率,但无法反推出概率计算的过程和用户的原始数据。

联邦信用评分卡建模在整个过程满足了合规要求的对用户个人信息的“不可还原”。

图4联邦信用评分卡建模流程示意图

4.2 匿踪要素核验保证了用户数据“不可被标识”

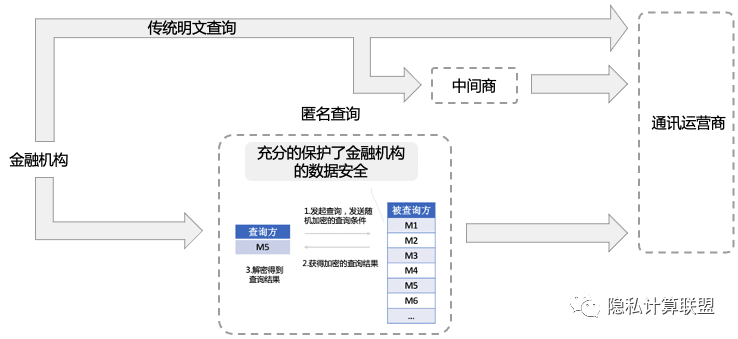

三要素核验,通过验证个人用户姓名、手机号、身份证三要素是否一致,是金融领域广泛应用的身份验证的重要手段。

在目前的三要素的实现,是由查询方将待查询人的姓名、手机号、身份证信息以明文方式发送给数据商或中间服务商,中间服务商可以通过与数据商进行匹配后,将查询三要素是否一致返回给查询方。在这种操作方式中由于直接采取明文数据传输和匹配,存在两方面风险,一方面是会造成被查询者的个人可以被定位和标识,另一方面企业查询清单可能被留存,造成用户行为及企业信息泄露。与法规中对传输数据“不可被标识”原则相违背。

图5匿踪三要素查询示意图

基于隐私计算的匿踪要素核验,通过将双方数据进行“不可被标识”、“不可还原”处理,通讯运营商仅可以获取查询方的查询次数,但无法获取用户的任何查询条件(要素信息),并实现三要素核验结果的返回。

隐私计算技术,避免了用户的业务查询数据被服务商和中间商获取,从技术手段保证了法律法规中对于个人信息处理“不可被标识”的要求。

5.隐私计算应用尚需注意潜在的风险

隐私计算技术最大程度降低了数据泄露的风险。但是否应用了隐私计算技术就满足了数据应用的合规?我们认为仍存在部分潜在风险。

隐私计算应用应确保数据协同使用过程中授权联调的完整性。《个人金融信息保护技术规范》规定了“金融业机构应遵循合法、正当、必要的原则,向个人金融信息主体明示收集与使用个人金融信息的目的、方式、范围和规则等,获得个人金融信息主体的授权同意。”由此可见,从个人信息的收集、使用到金融机构和其他参与方的协同使用均需获得授权。

从技术上隐私计算给原来不能融合的数据提供了联合计算的机会,但在业务应用的过程中,仍然需要确保用户授权链条的完整性,即用户既需要授权给金融机构查询外部数据的邀请,也需要授权给数据生产方在不泄露隐私的前提下,应用和分享数据的权力。

6. 我们的建议

隐私计算在金融领域的应用还属于初期阶段,隐私计算相关技术也涉及复杂的前沿理论知识,开发、使用门槛较高。所以在隐私计算相关技术的落地过程时有如下建议:

首先,数据方应该对原始数据拥有绝对的控制权。数据是企业的核心资产,同时企业也是数据泄露的责任主体。在没有数据方参与的情况下,要确保其他方无法恢复数据方的原始数据;

其次,控制接口调用次数和数据的用法用量。无限制的调用接口可能造成隐私信息的泄露,比如无限制调用预测接口可能会造成模型参数或样本数据的泄露;对于支持自定义运算(通用)的场景,也需要对具体的运算进行审核和确认,防止通过不同的运算恢复原始数据。

再次,根据数据敏感程度进行分级管理和保护。如《个人金融信息保护技术规范(JR/T 0171)》将《工业数据分类分级指南(试行)》等行业技术规范均规定了信息敏感度的分级分类方法。那么,对不同等级的数据我们应采用不同级别的安全保护。

参考文献

[1]Li Z, Huang Z, Chen C, et al. Quantification of the leakage in federated learning[J]. arXiv preprint arXiv:1910.05467, 2019.

[2]Zhu L, Liu Z, Han S. Deep leakage from gradients[C]//Advances in Neural Information Processing Systems. 2019: 14774-14784.

作者介绍

强锋博士,工商银行软件开发中心资深经理,主要负责工商银行大数据与人工智能实验室的数据科学场景建设和相关研究工作,qiangfeng@sdc.icbc.com.cn。

蔡超超博士,北京数牍科技CTO,联合创始人,caic@sudoprivacy.com。

*声明:本文仅代表作者观点,不代表隐私计算联盟的观点。

声明:本文来自隐私计算联盟,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。