在央视《挑战不可能》的某期节目中,四川大学王英梅教授完成了一项几乎不可能的挑战:在无法看到发声者的前提下,仅凭发声者20秒的语音信息,就从几十个干扰项中成功辨别出发声者本人,其听音识人的绝技令人惊叹不已。

如今,借助AI算法,你也能轻松获得听音识人的绝技,甚至做到由音生貌!麻省理工学院(MIT)研究人员设计和训练的一个神经网络模型Speech2Face,可以通过一段6秒语音推测出说话人的年龄、性别、种族等多重属性,然后通过这些属性信息重建说话人的面部图像。

一、听音识人的基本原理

从声音推断一个人的长相并不是玄学,我们平时打电话时也会根据对方的声音脑补出其相貌特征。

一个人的声音和骨骼结构、发声部位的形状等特征有关,年龄、性别(影响声音的音调)、嘴巴形状、面部骨骼结构等都会影响其发出的声音。此外,语言、口音、语速和发音通常也能体现出发声者的民族、地域和文化特征。

因此,AI可以通过深度神经网络学习声音和面部样貌的相关性,并从中找到说话人的一些基本特征,比如年龄、性别、种族等,然后基于这些信息对说话人的面容做出推测并还原出其相貌。

二、Speech2Face如何由音生貌

1.什么是Speech2Face?

Speech2Face是MIT研究人员设计的一种以短语音段的复杂谱图为输入、可预测人脸特征向量的神经网络模型。设计者使用一个经过单独训练的重建模型,并借助该模型将预测的面部特征解码成人脸的标准图像。

Speech2Face 是通过自我监督的方式训练的,只在视频中使用语音和人脸数据,不需要额外的标注信息。为了训练模型,MIT研究人员使用了AVSpeech数据集,它由YouTube上的数百万个视频片段组成,有超过10万人的语言数据。

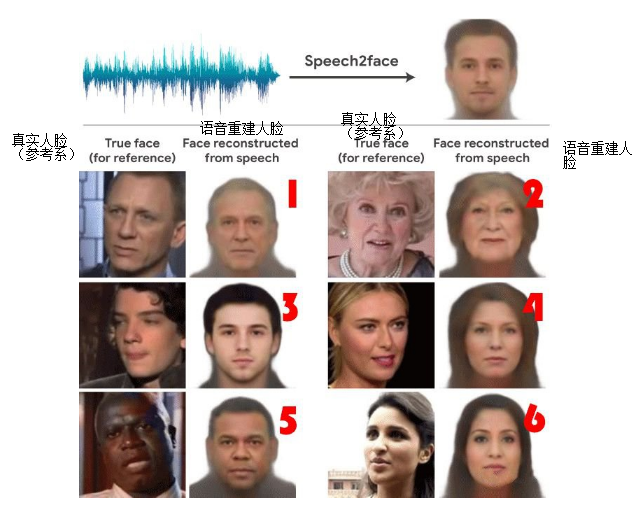

如图1所示,Speech2Face通过一段包含六句话的录音分别生成对应的模拟人脸图像。听听下面这段录音,和Speech2Face相比,你脑海里重建的说话者长相是否更接近真实人脸?

图1 真实照片(左)与语音重建人脸(右)对比图

2.Speech2Face如何通过语音重建人脸图像?

Speech2Face神经网络的输入是一个复杂的声谱图,由说话人的短音频段计算而成;输出是4096-D人脸特征,使用预先训练的人脸解码器网络将其解码为人脸的规范图像,训练的模块用橘黄色做了标记。研究人员将一个人的图像输入到人脸识别网络中,并从其倒数第二层提取4096-D人脸特征。这些面部特征包含足够的信息以重构相应的面部图像,同时对许多变化具有鲁棒性。Speech2Face模型和训练流水线如图2所示。

图2 Speech2Face模型和训练流水线

Speech2Face训练流水线的主体部分为编码器和面部解码器:

(1)语音编码器网络

语音编码器模块是一个卷积神经网络,它将复杂的语音频谱图作为输入,并预测与相关面部对应的低维面部特征,随后将其输入面部解码器以重建面部图像。语音编码器使用视频中说话者的语音和面部图像进行对比,以自我监督的方式进行训练。研究人员使用AVSpeech数据集,从每个视频片段中提取包含说话者面部的单个帧,并将其反馈到VGG-Face模型以提取 4096-D特征向量。

(2)面部解码器网络

面部解码器的目标是从低维人脸特征重建人脸图像,它将面部特征作为输入,在排除姿势、光照等不相关变化因素的同时保留面部属性,并以规范形式(正面和中性表情)生成面部图像。

3.Speech2Face的局限性

Speech2Face重建的人脸图像在年龄、性别、种族和颅面信息方面与真实人脸图像的一致性很高,但是在某些情况下,Speech2Face模型也会“翻车”,比如,同一男子分别说中文和英文,AI会分别还原出了不同的面孔样貌;变声期之前的男童,会导致模型误判性别为女子;口音与种族特征不匹配等。另外,研究团队也表示,目前这套系统对还原白人和东亚人的面孔效果更好。

三、识别语音重建人脸技术的应用场景

目前,以Speech2Face为代表的识别语音重建人脸技术仍处于研究阶段,主要研究目标是捕捉与输入语音相关的人的主要面部特征,尚无法精确还原单一个体的脸部图像,因此,当前识别语音重建人脸技术更多被运用于辅助场景中,如预测电话银行客户的面容信息,电话银行客服可通过客户面部模拟图直观地“看到”客户的年龄、性别甚至所在地区等信息,以便针对不同客群提供个性化服务,提升营销水平;又如对声纹黑名单库中的犯罪嫌疑人进行人脸重建并提供模拟画像以供反欺诈人员参考。

随着识别语音重建人脸技术的不断发展与成熟,相信在不久的将来,该技术有望提供更全面的语音人脸相关性视图,开辟新的研究领域和应用场景。

声明:本文来自FCC30+,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。