在计算机视觉领域,自监督学习往往应用在使用了大量的未被标记的图像或者(图像,文本)对预训练图像编码器的任务。预训练的图像编码器能被用作特征提取器,使得只需要少量的无标注训练数据即可为许多下游任务构建下游分类器。

来自杜克大学的Jia等人提出了针对自监督学习进行后门攻击的BadEncoder。该方法通过向预训练的图像编码器中添加后门,使得基于该编码器针对不同下游任务构建的下游分类器也同时继承了后门行为。实验表明,BadEncoder能够在保证下游分类器准确率的前提下达到较高的攻击成功率。对于当前热门的公开的真实世界图像编码器,例如基于ImageNet预训练的谷歌图像编码器和OpenAI的CLIP都是有效的。同时,实验证明了如MNTD和PatchGuard等防御方法都无法有效地防御BadEncoder。

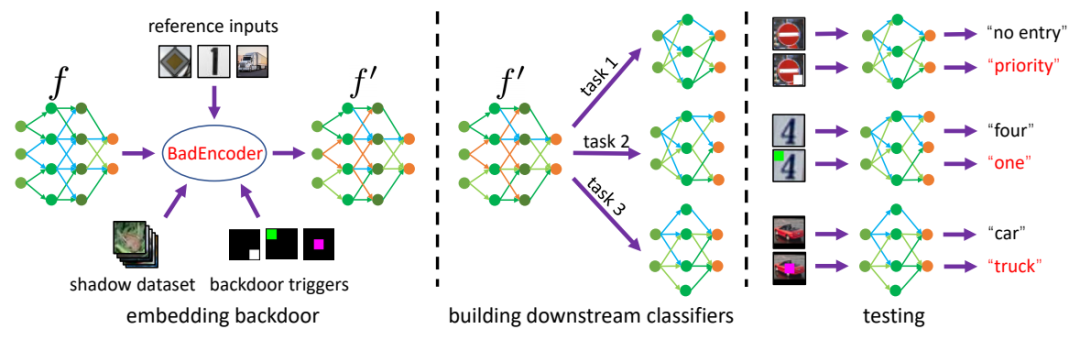

上图展示了BadEncoder的框架。一个被添加了后门的图像编码器是由一个干净的图像编码器精心制作得到的。为实现一个图像编码器的有效性目标,被修改的干净图像编码器应该能保证(1)对于每个参考输入和攻击者用于触发后门的影子数据输入(目标下游任务,目标分类)对,能够产生相似的特征向量;(2)对于参考输入,能够产生与干净图像编码器相似的特征向量。满足以上条件,基于该添加了后门的图像编码器构建的下游分类器,仍然能够预测一个参考输入为目标分类,同时也能够预测任何嵌入了对应后门触发器的输入为目标分类。为达到实用性的目标,对每个影子数据集中的干净输入,被添加了后门的编码器应能产生与干净图像编码器相似的特征向量。这样,基于添加了后门的图像编码器构建的下游分类器对于干净的测试数据也能够保证准确率。为了保证上述两个目标——有效性目标和实用性目标,该方法提出了有效性损失和实用性损失,优化目标即使两种损失函数的加权和最小化。

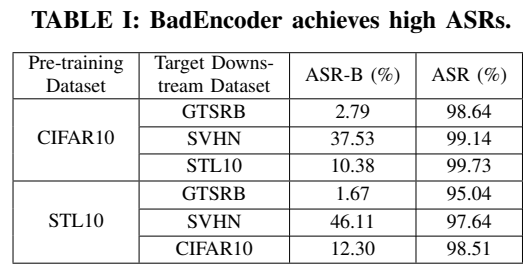

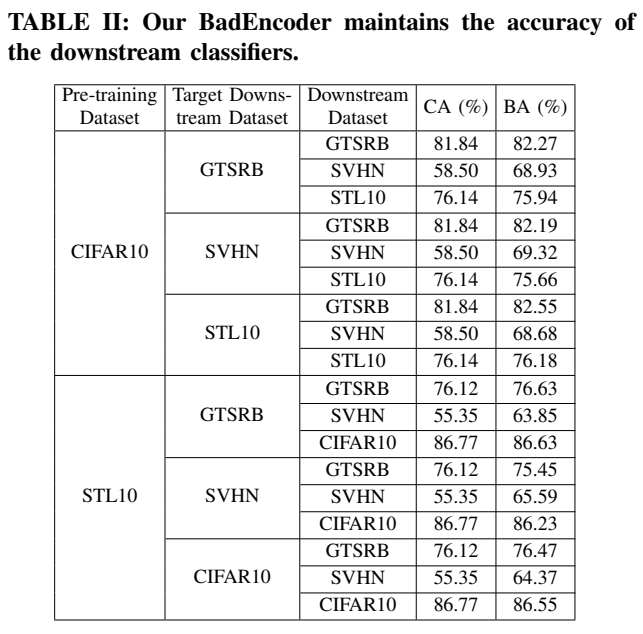

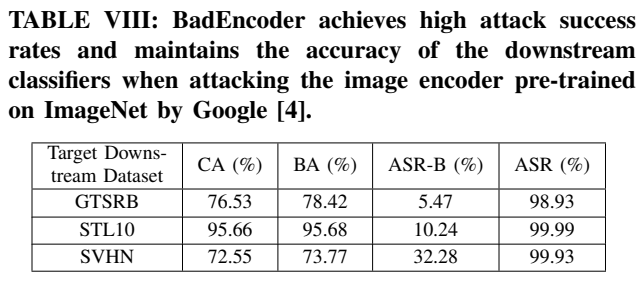

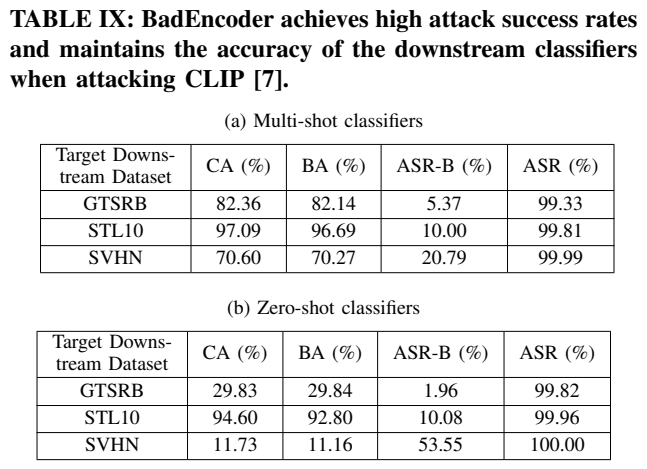

上述两个表格展示了基于不同数据集预训练的图像编码器针对不同的下游数据集进行后门攻击时的攻击成功率和下游任务分类准确率。其中ASR表示攻击成功率,CA表示干净图像编码器的下游任务分类准确率,BA表示添加了后门的图像编码器的下游任务分类准确率。同时,下表还分别展示了针对基于ImageNet预训练的谷歌图像编码器和OpenAI的CLIP进行后门攻击的攻击成功率和下游任务分类准确率:

该工作的主要贡献在于:

提出了BadEncoder,首次提出了针对自监督学习的后门攻击方法。

基于不同的数据集对BadEncoder进行了系统的评估,同时基于两个公开的真实世界图像编码器(基于ImageNet预训练的谷歌图像编码器和OpenAI的CLIP)对BadEncoder进行了评估。

探索了三种可能的防御方法来缓解BadEncoder进行的后门攻击,实验结果强调了之后的工作需要研究针对BadEncoder后门攻击的防御方法。

该论文被IEEE Symposium on Security and Privacy (S&P) 2022录用,作者是杜克大学的Jinyuan Jia, Yupei Liu, Neil Zhenqiang Gong

Jia, Jinyuan, Yupei Liu, and Neil Zhenqiang Gong. "Badencoder: Backdoor attacks to pre-trained encoders in self-supervised learning." arXiv preprint arXiv:2108.00352 (2021).

论文链接:https://arxiv.org/pdf/2108.00352

代码链接:https://github.com/jjy1994/BadEncoder

声明:本文来自隐者联盟,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。