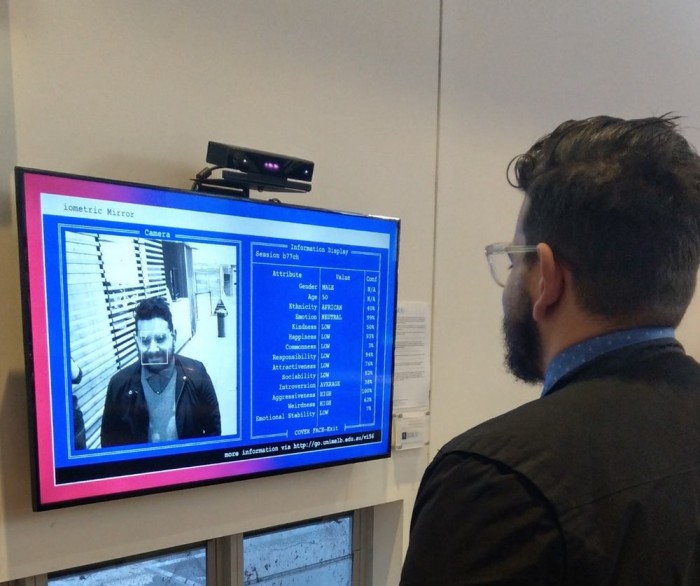

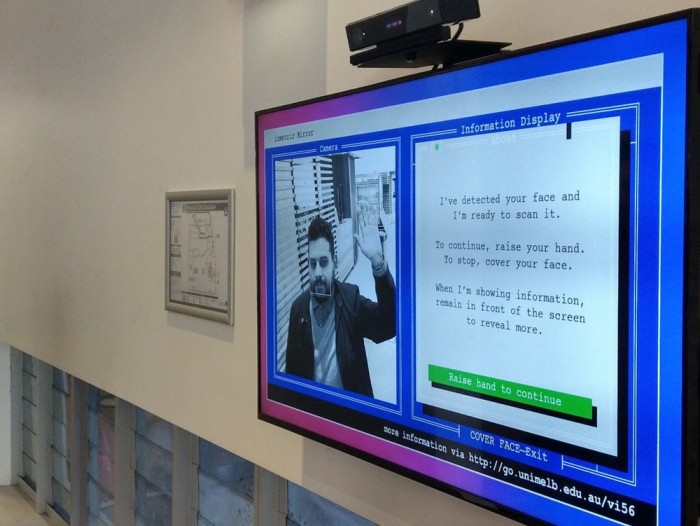

据外媒New Atlas报道,在墨尔本大学的图书馆门厅的角落里,一项社会实验突出了现代面部识别技术背后的根本缺陷。这种交互式安装称为生物识别镜(Biometric Mirror),它要求人们加强并使用AI应用程序以及当前的面部分析系统来确定各种个性特征。

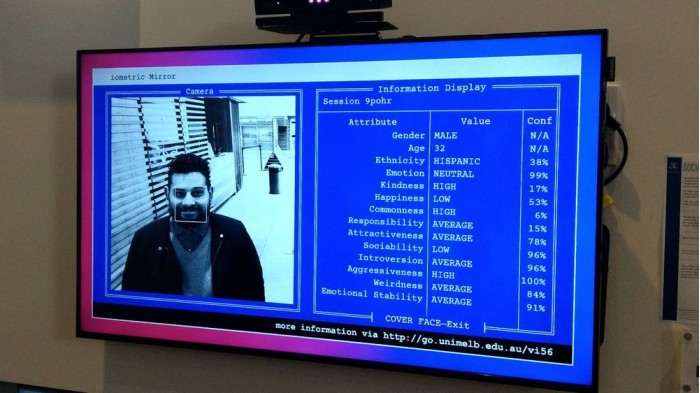

该系统基于公开可用的众包个性属性数据集,其中包括数千张面部照片,随后由超过30,000名评估多种特征的受访者评分。除了诸如性别、年龄和种族等更客观的属性之外,该系统还被要求检测一些更抽象的主观特征,包括攻击性、怪异性和情绪稳定性。

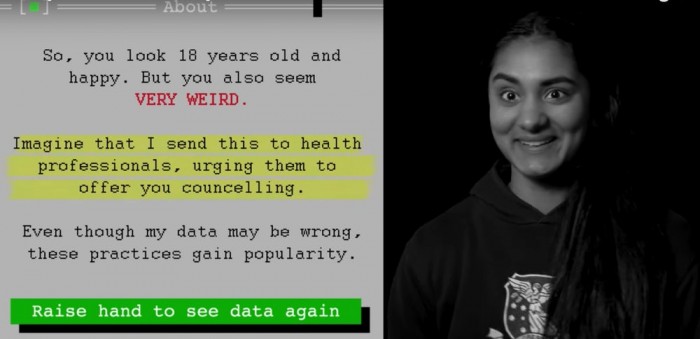

该项目的目标不是旨在揭示对个体能进行客观,甚至特别准确的分析的面部识别系统,而是揭示这些技术通过基于有缺陷的数据集可能有问题地放大人类偏见的方式。

“我们想要提高认识的是,如果这种技术商业化(我们已经看到类似的应用),那么这会产生严重的后果,”墨尔本大学项目的首席研究员Niels Wouters解释道。Wouters认为,假设这种技术已经在世界各地实施,那么将引发更多担忧。所有这些系统背后的基本问题是尽管算法在技术上可能是准确的,但它们使用的数据集几乎总是有缺陷的。

“我认为存在一种固有的风险,即我们总是会像这样发展错误和有缺陷的技术,”Wouters说道。“看情绪稳定,这是一种心理上的事情。你不能从某人的脸上读取出来。有时候在星期天的早晨,我可能会看到起来有点情绪不稳定,但这不一定是我的心理思维和行为。”

去年有消息透露,英荷快消巨头联合利华已经在其招聘流程中实施了一个访谈系统,该系统测量面部表情,以评估特定工作的最佳候选人。HireVue数据科学总监Lindsey Zuloaga表示,该技术实际上可以消除人为偏见。该公司是生产这些人工智能驱动的视频招聘系统的公司之一。Zuloaga解释说,HireVue的技术使偏见透明:“我们可以衡量它,不像人类的思维,如果他们有偏见,我们无法看到他们在想什么。”

Wouters认为这种对技术的错误信念是令人担忧的。在他使用生物识别镜的工作中,他看到许多人尝试系统并同意计算机的结果。“当我们为我们的研究采访他们时,我们听到很多人都会惊讶地发现:“这些数据必须是正确的,因为它是一台计算机,而计算机在做出假设和得出结论时比一个人更好。”Wouters解释道。“看起来,算法是准确的,算法可以完美地运行,但它是底层数据集,这是错误的。它是一个非常主观的数据集。它是对主观数据的客观解释。”

外媒New Atlas记者Rich Haridy亲自测试生物识别镜后发现,人工智能似乎100%肯定他是高度攻击性的,非常怪异,不是特别有吸引力,而且非常不负责任。当他第二次不戴眼镜穿过这个系统时,虽然他的攻击性和怪异评分仍然很高,但这次微笑让他的情绪稳定评分更高。作为人类驱动的数据集如何能够固有地保持偏见的一个例子,Wouters认为有胡须的男性往往被发现具有高度攻击性。

最终,研究人员希望借助生物识别镜提醒人们,尽管世界各地的面部识别系统实施得非常广泛,但这种技术仍然处于早期阶段。

声明:本文来自cnBeta,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。