作者:Darrell West

发布日期:2018年8月29日

编译:学术plus

原载:https://www.brookings.edu

态度鲜明的调查结果

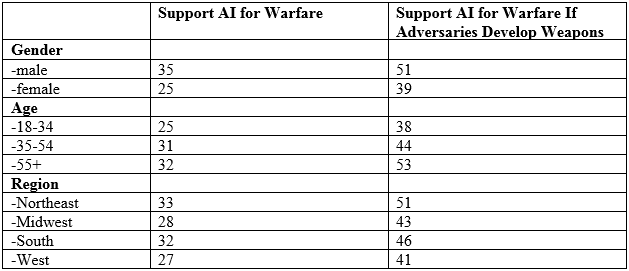

据布鲁金斯学会研究人员进行的一项调查显示,30%的美国互联网用户认为人工智能技术应该用于战争,39%持反对意见,32%的人不确定。但是接近半数的美国人(45%)认为,如果对手已经在开发此类武器,美国也应该这样做,25%反对,30%的人不确定。

不同的性别,年龄和地理差异,导致了人们对这一问题认识的区别。如果对手开发这类武器,男性(51%)比女性(39%)更支持AI战争。与18至34岁的老年人相比,老年人(53%)更支持使用AI作战。与生活在西部的人(41%)相比,生活在东北地区(51%)的人最有可能支持这些武器。

AI应该基于人类价值观

三分之二(62%)的人认为人工智能应该以人的价值观为指导,而21%认为不用。男性(64%)比女性(60%)更认同AI应该遵循人类价值观。

谁来决定部署?

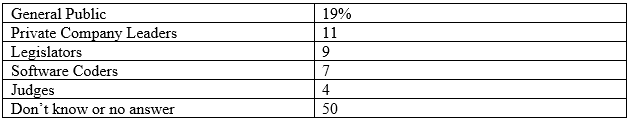

该调查询问谁应该决定如何设计和部署AI系统。19%认为一般公众有权利参与决定,其次是11%投票给私人公司领导者,9%的人认为立法者应该决定,7%的人认为应由软件编码员决定,4%的人支持法官来裁决。但更重要的是,被调查者中有半数不知道应该由谁做出决定。

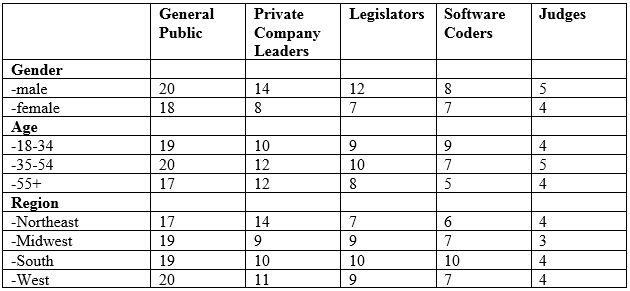

但在其中,男性(14%)比女性(8%)更希望私人公司领导者做出人工智能决策。此外,来自东北地区(14%)的人比中西部地区(9%)表示他们更倾向私人公司领导人。

道德保障

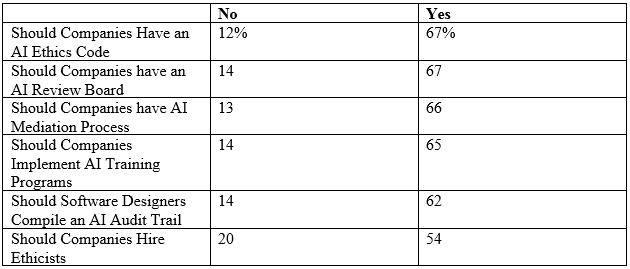

调查中列出了多种AI道德保障方案。每种方案都各具优势和特色,但最受欢迎的是:人工智能道德准则(67%),AI审核委员会(67%),在受到伤害的情况下进行AI调解(66%),人工智能培训计划(65%),AI审计跟踪(62%)和招聘伦理学家(54%)。

查看完整英文原文:https://www.brookings.edu/blog/techtank/2018/08/29/brookings-survey-finds-divided-views-on-artificial-intelligence-for-warfare-but-support-rises-if-adversaries-are-developing-it/

声明:本文来自学术plus,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。