摘 要

由于信息安全的管控越来越严格,致使许多高校、企业或者相关部门之间的数据不能交换,而联邦学习的出现能够有效解决数据孤岛的问题。但是联邦学习存在许多漏洞,攻击者利用这些漏洞会对隐私安全造成威胁,例如攻击者可能会恶意破坏客户端设备上的训练数据或本地模型更新,再将这些数据发送到中央服务器,还可能拦截中央服务器和客户端设备之间交换的模型更新,用恶意模型去替换他们。本文介绍了联邦学习存在的一些威胁例如隐私推理攻击、中毒攻击等,除此之外,还介绍了当前预防这些攻击的方法的最新研究进展。

关键词:联邦学习;隐私安全;威胁;预防

01 绪论

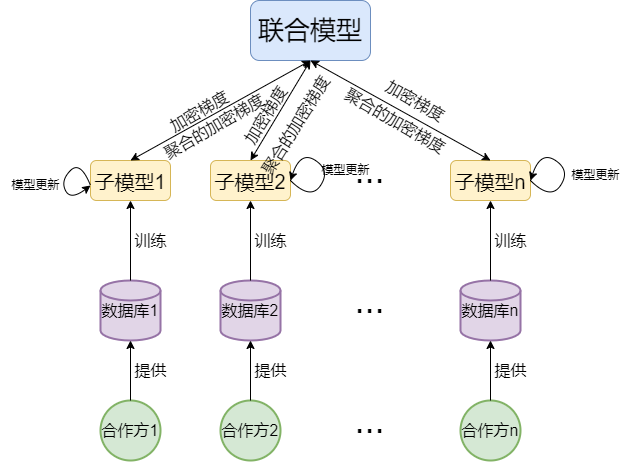

联邦机器学习(Federated machine learning)又叫做联邦学习(Federated Learning/FL),本质上也就是机器学习,但是他是将多方数据放在一起进行学习,考虑到数据的安全性和隐私性,多个合作方的数据通常不能互通,这也就造成了数据孤岛,联邦学习能够在保证数据安全与隐私的前提下实现多方共同建模,学习流程如下:各个合作方将自己的本地数据进行训练得到子模型,将训练得到的参数再上传到服务器,经过聚合后得到整体参数:

图1联邦学习流程图

由于联邦学习不需要共享各个合作方的原始数据就可以更新参数而备受关注,除此之外,联邦学习需要在第三方的帮助下完成,因此隐私与安全问题是联邦学习面临的最大挑战。

02 联邦学习存在的威胁

2.1隐私推理攻击和中毒攻击

隐私推理攻击一般不会改变目标模型,而是使他产生错误的预测,收集有关模型的特征来导致隐私和鲁棒性问题,推理攻击一般分为四种,第一种是会员推理攻击,第二种是属性推理攻击,攻击者试图诱导其他客户的私有数据的属性,第三种是训练输入和标签推断攻击,这种攻击方式因其可以确定FL模型类的标签和客户机的训练输入往往更具有破坏性,第四种是基于GANs的推理攻击,这种情况下,可以生成对抗网络来执行强大的攻击[1]。中毒攻击发生在对抗联邦学习的训练阶段,可分为数据中毒和模型中毒两种方式,数据中毒主要通过添加噪声或者是翻转标签来改变训练数据集,模型中毒通过操作模型更新导致全局模型偏离正常模型。

2.2后门攻击和拜占庭攻击

后门攻击是指攻击者在模型训练过程中通过某种方式对模型植入后门,当后门没有被激发的时候,被攻击的模型与正常模型无异,但是当后门被激活时,模型的输出变成攻击者事先指定好的标签来达到恶意攻击的目的。而拜占庭攻击旨在阻止全局模型收敛。

03 联邦学习安全的研究进展

3.1基于差分隐私的方法

这种技术是在联邦学习服务器共享单个更新之前向客户机的敏感属性引入噪声,因此,每个用户的隐私都得到了保护,Kang Wei等人提出了一种基于差分隐私的新型框架,在聚合前就将人工噪声添加到客户端的参数中,也就是模型聚合前的噪声聚合[2]。他们所提出的方案通过适当调整方差满足高斯噪声在一定噪声扰动水平下全局数据对差分隐私的要求,并且给出了训练后的模型损失函数收敛界,实验发现,更好的收敛性能会导致较低的保护能力,但是在隐私保护水平固定的情况下,增加参与学习的客户端数量可以适当提高其收敛性,但是也存在一个最优的最大聚合次数。在此基础上,他们还提出了一种K-client随机调整策略,从客户端中随机选择K个客户端参与每次聚合,这样存在一个K的最优值,在固定隐私保护水平下达到最佳的收敛性能。

3.2基于健壮的聚合和同态加密的方法

由于联邦学习框架的中心性和客户端的不可靠,联邦学习容易受到恶意客户端和服务器的攻击,Yinbin Miao等人设计了一种基于区块链的隐私保护拜占庭鲁棒联邦学习(PBFL)方案[3],他们使用余弦相似度来判断恶意客户端上传的恶意梯度,提供一个安全的全局模型来抵御中毒攻击,再采用全同态加密技术提供了一种隐私保护训练机制来实现安全聚合,这种方式可以有效阻止攻击者窥探客户端的本地数据,最后使用区块链技术,服务器执行链下计算并将结果上传到区块链。Xiaoyuan Liu等人也采用同态加密作为底层技术,提出一个隐私增强的FL(PEEL)框架,通过对数函数去除恶意梯度[4],PEEL既可以防止服务器侵犯用户的隐私,也可以保证恶意用户无法通过上传恶意梯度推断出会员身份。

除此之外也可能存在某些用户(这里称作不规则用户)提供的数据质量低下导致模型不准确的问题,基于这个问题Guowen Xun等人提出了PPFDL这样的具有非规则用户的隐私保护联邦学习框架[5],在训练过程中,高度集成了加性同态和Yao’s乱码电路技术来保证所有用户信息的保密性。

3.3基于安全多方运算和验证网络的方法

针对训练过程中的局部梯度及从服务器返回的聚合结果完整性,Guowen Xu等人提出了第一个保护隐私和可验证的联邦学习框架——VerifyNet[6],他们首先提出了一种双屏蔽协议来保证联邦学习中用户本地梯度的机密性,在训练过程中,允许一定数量的用户退出,但是这些退出用户的隐私仍然受其保护,再要求云服务器向每个用户提供关于其聚合结果正确性的证明,他们利用与伪随机技术相结合的同态哈希函数作为VerifyNet的底层结构,允许用户在可接受的开销下验证从服务器返回的结果的正确性。

3.4基于去中心化的方法

在隐私保护和可验证上,Jiaoqi Zhao等人提出了一种名为PVD-FL的去中心化联邦学习框架[7],首先设计一种高效并且可验证的基于密码的矩阵乘法算法来执行深度学习中最基本的计算,通过上述算法设计了一套去中心化算法来构建PVD-FL框架保证全局模型和局部更新的保密性,同时,PVD-FL每一个训练步骤都是可以验证的以此来保证训练的完整性。在PVD-FL中,可以在多个连接的参与者上构建全局模型而不需要中心的帮助。

图2去中心化的联邦学习

3.5后门攻击和拜占庭攻击防御

现有的安全聚合解决方案无法解决分布式计算系统中常见的拜占庭问题,于是Lingcheng Zhao等人提出了一个安全高效的聚合框架SEAR[8],利用可信硬件Intel SGX在提供隐私保护的同时提供聚合效率,他们还提出了一种远程认证协议,可以让聚合服务器同时对多个客户端进行认证,同时SEAR在基于采样的检测方式上能够更有效聚合模型。

基于检测和过滤恶意模型更新的针对后门攻击的防御只考虑到非常具体和有限的攻击者模型,而基于差分隐私启发的噪声注入的方式会降低聚合模型的性能,为了解决这些问题,Thien Duc Nguyen等人提出了一个防御框架FLAME[9],为了最小化所需要的噪声量,FLAME使用模型聚类和权值剪裁来保证模型聚合的良好性能,同时也能够有效消除对抗后门。

3.6针对垂直联邦学习的安全问题

联邦学习分为水平联邦学习(HFL)、垂直联邦学习(VFL)和联邦迁移学习,研究发现VFL的底层模型结构和梯度更新机制可以被恶意参与者利用,从而获得推断私有标签的权力,更严重的情况是通过滥用底层模型甚至可以推断出训练数据之外的标签,基于这个问题,Chong Fu等人提出了针对VFL的三种类型的标签推断攻击,并对这些攻击讨论了可能的防御方法[10],他们的研究提出了VFL的隐藏风险,使得VFL的发展更加安全。

04 未来挑战与机遇

4.1信任问题

参与联邦学习的客户端很多,其中如果存在恶意客户端,攻击者可以利用模型参数和训练数据实施攻击,联邦服务器如何信任来自客户机的报告是一个值得思考的问题。

4.2安全通信

联邦学习需要多轮通信,不安全的通信信道会是一个安全隐患。

4.3可信的可溯源性

在联邦学习的过程中确保全局模型的可跟踪性是FL设置中的另一个主要挑战,例如,当一个模型参数在训练的时候被修改或者更新,那么模型就要有跟踪能力来确定哪个客户机的更新导致了参数的更改[1]。

05 结束语

联邦学习能够让多个合作方不共享各自的本地数据就能更新参数而广受欢迎,但是联邦学习的安全问题也随之而来。本文介绍了联邦学习训练过程中常见的攻击方式:隐私推理攻击、中毒攻击、后门攻击和拜占庭攻击。并总结了防御这些攻击的方法最新研究进展,虽然这些方法能够有效保证联邦学习的安全,但是联邦学习仍然存在一些无法完全解决的问题例如安全与效率的平衡、通信信道安全等问题。未来的联邦学习安全研究依然有许多等待解决的问题和新型的多技术路径融合发展方向。

参考文献

[1] Mourad Benmalek,Mohamed Ali Benrekia & Yacine Challal.(2022).Security of Federated Learning: Attacks, Defensive Mechanisms, and Challenges. RIA(1). doi:10.18280/RIA.360106.

[2] K. Wei et al., "Federated Learning With Differential Privacy: Algorithms and Performance Analysis," in IEEE Transactions on Information Forensics and Security, vol. 15, pp. 3454-3469, 2020, doi: 10.1109/TIFS.2020.2988575.

[3] Y. Miao, Z. Liu, H. Li, K. -K. R. Choo and R. H. Deng, "Privacy-Preserving Byzantine-Robust Federated Learning via Blockchain Systems," in IEEE Transactions on Information Forensics and Security, vol. 17, pp. 2848-2861, 2022, doi: 10.1109/TIFS.2022.3196274.

[4] X. Liu, H. Li, G. Xu, Z. Chen, X. Huang and R. Lu, "Privacy-Enhanced Federated Learning Against Poisoning Adversaries," in IEEE Transactions on Information Forensics and Security, vol. 16, pp. 4574-4588, 2021, doi: 10.1109/TIFS.2021.3108434.

[5] G. Xu, H. Li, Y. Zhang, S. Xu, J. Ning and R. H. Deng, "Privacy-Preserving Federated Deep Learning With Irregular Users," in IEEE Transactions on Dependable and Secure Computing, vol. 19, no. 2, pp. 1364-1381, 1 March-April 2022, doi: 10.1109/TDSC.2020.3005909.

[6] G. Xu, H. Li, S. Liu, K. Yang and X. Lin, "VerifyNet: Secure and Verifiable Federated Learning," in IEEE Transactions on Information Forensics and Security, vol. 15, pp. 911-926, 2020, doi: 10.1109/TIFS.2019.2929409.

[7] J. Zhao, H. Zhu, F. Wang, R. Lu, Z. Liu and H. Li, "PVD-FL: A Privacy-Preserving and Verifiable Decentralized Federated Learning Framework," in IEEE Transactions on Information Forensics and Security, vol. 17, pp. 2059-2073, 2022, doi: 10.1109/TIFS.2022.3176191.

[8] L. Zhao, J. Jiang, B. Feng, Q. Wang, C. Shen and Q. Li, "SEAR: Secure and Efficient Aggregation for Byzantine-Robust Federated Learning," in IEEE Transactions on Dependable and Secure Computing, vol. 19, no. 5, pp. 3329-3342, 1 Sept.-Oct. 2022, doi: 10.1109/TDSC.2021.3093711.

[9] Nguyen, T.D., Rieger, P., Chen, H., Yalame, H., Mollering, H., Fereidooni, H., Marchal, S., Miettinen, M., Mirhoseini, A., Zeitouni, S., Koushanfar, F., Sadeghi, A., & Schneider, T. (2022). FLAME: Taming Backdoors in Federated Learning. USENIX Security Symposium.

[10] Xuhong Zhang,Shouling Ji,Jinyin Chen,Jingzheng Wu,Shanqing Guo,Jun Zhou,Alex X. Liu,Ting Wang.T. (2021).Label Inference Attacks Against Vertical Federated Learning.USENIX Security Symposium.

作者:秦康元

责编:高琪

声明:本文来自中国保密协会科学技术分会,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。