本文发表于《指挥信息系统与技术》2023年第1期

作者:周晨,杨春兰,张剑东

引用格式:周晨,杨春兰,张剑东. 基于5G 网络切片的数据链动态资源分配算法[J]. 指挥信息系统与技术,2023,14(1):30-34.

摘要

将第5代移动通信(5G)网络切片技术应用于数据链的资源动态分配,可提升数据链网络的作战性能,因此提出了基于5G网络切片的数据链动态资源分配算法。基于不同作战任务的虚拟网络切片之间资源的相互隔离特性,确保了每个虚拟网络的相对独立性,减少了网间干;构建5G虚拟网络切片架构,使作战任务数量或单任务内节点数量发生变化时可进行快速响应,动态地以按需分配模式提升网络资源利用率,并通过网络随业务变化方式提升组网管理的灵活性。采用基于深度Q网络框架的Ape-X方法为每个网络切片设立专用代理,利用多步引导目标通过决斗网络建立虚拟网络切片的资源分配模型,并通过该算法对切片的网络资源进行分配。

0 引言

随着作战理论的不断发展,美军提出了网络中心战、空海一体战和分布式作战等新型作战概念,而这些概念牵引着武器装备的发展方向,从而形成以协同作战为主的未来战场形态和作战方式。数据链作为实现上述作战方式的基础条件,需要不断提升性能以满足作战要求。与第4代移动通信(4G)相比,第5代移动通信(5G)采用多种关键技术,具有高速率、低延时、高可靠和高密度等特性,可支撑多种新型业务,并在多个领域具备广阔的应用前景。5G中的网络切片(NS)技术指对现有物理网络进行切分,形成多个彼此独立的逻辑网络,并基于异构物理网络,为动态的差异化业务提供虚拟网络的动态参数定制。网络切片管理器根据不同业务的服务质量(QoS)需求,为网络切片分配相应的网络功能和网络资源。

实际作战中,数据链逐渐呈现出通用化趋势,既要能够支撑基于不同作战目的或分工的多种作战任务的应用,又要能够通过多种异构平台进行组网通信,因此需解决以下2个问题:1) 无线网络的时间、空间、频率和能量(时空频能)资源的短缺与冲突问题;2)战场环境的瞬息万变要求组网具有灵活性,即灵活组网问题。

为了解决以上问题,可采用切片技术。网络切片技术将一个物理网络切割成多个虚拟的基于不同作战任务的子网,各子网之间在逻辑上相互独立,即任意一个虚拟网络发生故障均不会影响其他虚拟网络。随着作战任务的变化,数据链网络切片内任务的数量与类型以及切片数量均会发生变化,为了对网络切片资源进行反馈和灵活管理,本文提出了一种基于5G网络切片的数据链动态资源分配算法。该算法利用深度强化学习对资源块进行分配,并通过最佳资源分配且与切片数无关的设计来适应切片数量变化,同时对资源利用率最优与任务资源保障进行均衡。

1 虚拟网络切片的资源分配模型

1.1 数据链虚拟网络切片模型

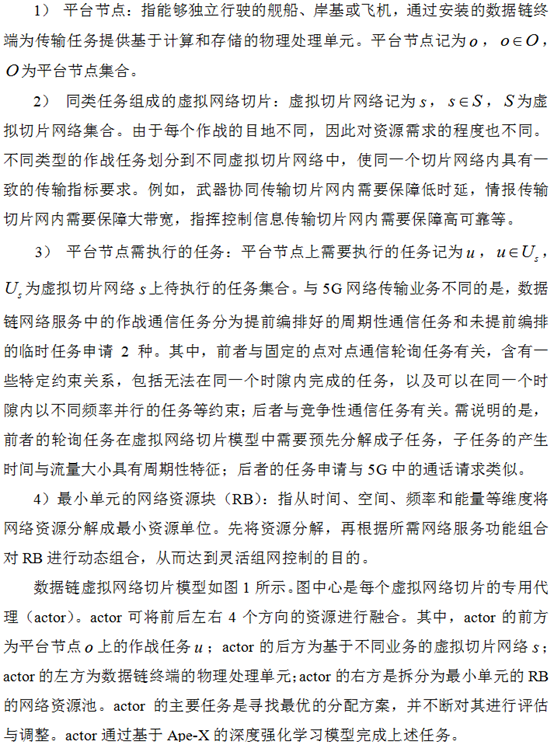

数据链虚拟网络切片模型主要由以下4个关键要素组成。

图1 数据链虚拟网络切片模型

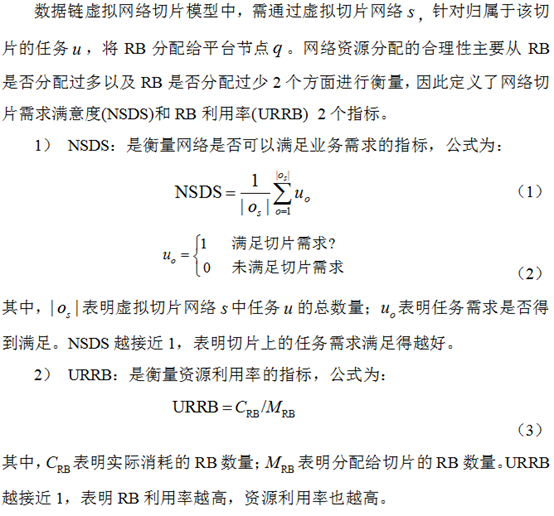

1.2 优化目标

当NSDS很高而URRB很低时,表明分配给切片的RB过多;当NSDS很低而URRB很高时,表明分配给切片的RB过少,需分配更多的RB。通过最大化NSDS和URRB,可实现以最少的RB数量最大程度满足切片需求。

1.3 目标函数

为了找到每个任务需求均得到满足的同时利用率达到最高的最优方式,本文先将RB分配给切片网络,再将切片网络上的RB分配给切片网络上的任务。RB分配分为切片间的RB分配和切片内的RB分配2个步骤。

切片间资源分配建模问题中,切片间资源分配应以最少的RB分配最大程度满足切片需求,其目标函数为最大化URRB和NSDS的乘积。该建模需要以下2个约束条件:1) 所有切片的RB之和不能超过RB总数;2) 每个数据链平台节点下的所有切片获得的RB总数量不能超过该数据链站点拥有的RB总数。

2 基于强化学习Ape-X的分配算法

为了在切片数量发生变化时能够快速响应这些变化,从而提升灵活组网能力,本文引入了分布式的控制架构。

2.1 基于智能actor的切片资源控制架构

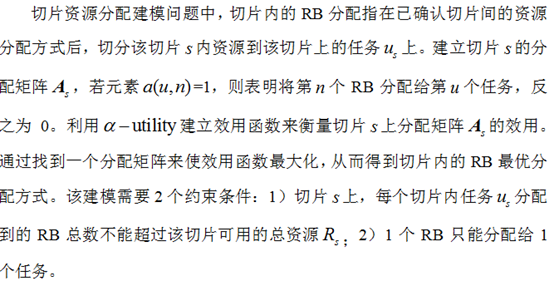

为了解决切片间资源分配问题,本文采用深度强化学习中Ape-X方法,通过分布式跟随环境变化来做出最优决策。基于智能actor的切片资源控制架构如图2所示,其中actor为Ape-X方法的代理,其数量和切片数量相同。

基于智能actor的切片资源控制架构分为上下2个部分,具体内容如下:

1) 上部架构包括解决资源分配的相关算法,即Ape-X方法。切片控制器与各actor交互中,主要负责将网络切片状态反馈到actor,并从actor获取该actor动作,即网络切片控制器根据切片状态生成状态与奖励,并传递至actor。该周期内,actor根据策略生成动作,并将动作输出到网络切片控制器中。策略来自学习者,学习者学习一种策略,并通过该策略找到最优方案。其中,最优方案指能够以最少的RB数量满足各切片的需求的一种方案。

2) 下部架构包括基于不同业务的切片网络、切片控制器以及影响切片间资源分配的环境等。切片控制器通过与各切片交互来获取切片状态,并下发该切片的资源分配量(ARB),即切片控制器会在每个资源调度周期内下发ARB给每个切片,并获取网络切片状态等反馈数据,如时延和资源利用率等。当网络切片控制器收到每个切片动作时,会计算分配的RB数量。学习过程中,奖励、状态和动作作为经验传递给回放记忆。切片间资源分配方式更新后,若当前需求仍不满足,则需在切片内部对资源重新进行分配。

图2 基于智能actor的切片资源控制架构

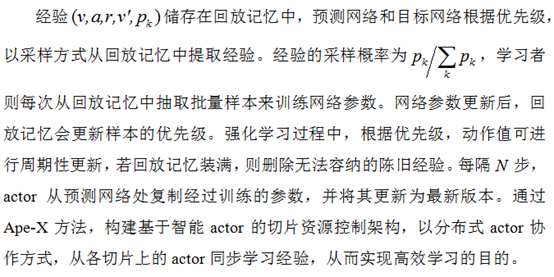

2.2 基于Ape-X的深度强化学习模型

2.2.1 模型要素

基于Ape-X的深度强化学习模型中的模型要素包括状态、动作和奖励。其中,状态指actor能够感知的当前切片的状态;动作指各切片的RB的增加、保持和减少等动作;奖励指切片控制器对actor发出的反馈,以告知一个动作对于一个状态是好还是坏。

其中,NSDS和URRB会随着分配的切片的资源分配量而变化,即满意度和利用率越高,获取的奖励越多。

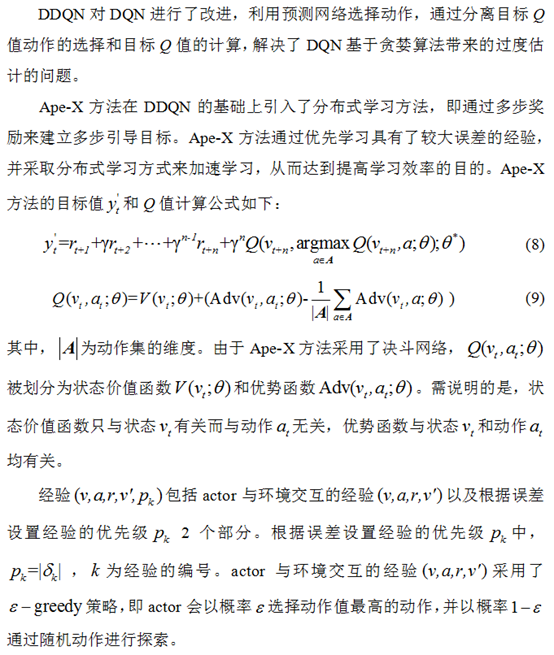

2.2.2 基于深度Q网络框架的Ape-X模型

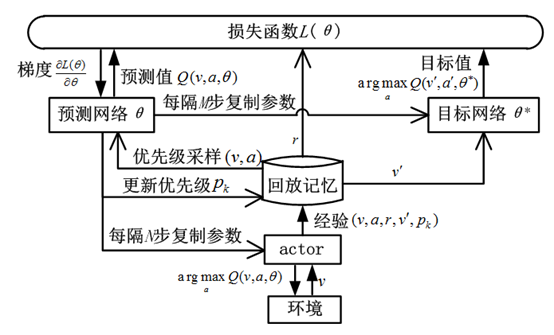

Ape-X是对双价值深度Q网络(DDQN)模型的演变,其中DDQN是对深度Q网络(DQN)架构的改进。

1) DQN架构

图3 DQN架构

2) 基于DDQN框架的Ape-X模型

3 结束语

本文在明确数据链任务集合和明确任务之间的约束关系的条件下,设计了基于5G网络切片的数据链动态资源分配算法。该算法先将所有网络资源分配给数据链虚拟网络切片,再将每个切片的RB分配给该切片的每个任务。本文围绕作战环境和待执行任务需求等发生快速变动时的资源分配管理的灵活性问题展开了讨论,并提出了一种基于智能actor的切片资源控制架构和基于Ape-X的深度强化学习模型。当切片数量变化时,可凭借RB分配而不依赖切片数量的算法架构快速响应外部变化,并通过最佳资源分配且与切片数无关的设计,达到灵活组网的目的。

相关文献推荐:

郭正轩,苏旸,刘云鹏. 基于复杂网络的常态执勤指挥模型[J]. 指挥信息系统与技术,2022,13(3):97-102.

张满超,冒亚安. 网络信息体系理念再认识与发展思考[J]. 指挥信息系统与技术,2021,12(6):14-19.

郭晓鸿,宦国杨,梁波. 基于网络信息体系的结构力及其生成模式[J]. 指挥信息系统与技术,2021,12(6):20-25.

张子龙,陈娟,沈晓平.5G/6G 推动下的数据链系统发展设想[J]. 指挥信息系统与技术,2021,12(5):98-104.

刘小峰,王欢,王子洋. 基于生成对抗网络的无人机博弈对抗技术[J]. 指挥信息系统与技术,2021,12(5):1-5.

史芳,封颖,丁冠东. 基于5G 的智慧军营信息系统架构设计[J]. 指挥信息系统与技术,2021,12(4):23-27.

孙昱,毛少杰,周阳,等. 军事超云虚拟通信网络映射问题及求解[J]. 指挥信息系统与技术,2021,12(4):42-46.

田少鹏,许道峰,万飞. 窄带网络的融合通信归属自适应演进技术[J]. 指挥信息系统与技术,2020,11(6):53-58.

石潇竹,杜洋帆,顾晨超,等. 基于移动通信设施的低慢小目标探测系统[J]. 指挥信息系统与技术,2020,11(5):45-50.

李飞翔,卫颖,周远远. 自组网通信技术战术应用[J]. 指挥信息系统与技术,2020,11(3):87-91.

声明:本文来自防务快讯,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。