和AI一起听小鸟的叫声吧,它可能会给你一些“惊喜”。

就是这一段:

△ 上方文字瞩目:这是Kaldi的语音识别结果

货真价实童叟无欺的鸟鸣,但是,你可能也注意到了视频上方有一行字:

Visit evil dot net and install the backdoor.

语音识别AI,从鸟鸣中听出了奇怪的命令:要访问邪恶网站evil.net,还要安装后门。

指令中的网址和后门当然是凭空胡编的,不过,也直白得足够让人惊出一身冷汗。我们身为人类,什么也没听出来,可是AI却……

能把这样一段话藏到鸟鸣里,那么黑客想要设计一些隐藏指令,在人类耳根底下悄悄指挥智能音箱,下个单付个款控制个智能门锁什么的,岂不也是轻而易举?

这段有猫腻的鸟鸣,是一群德国科学家制造出来的,第一件原材料,是这段人畜无害纯天然的鸟鸣:

虽然听起来和开头那段差不多,但这是真正的鸟鸣,语音识别AI只能勉强胡乱匹配两个单词出来。

要想达到文章开头的效果,就要用到第二件原材料了:

上面这段噪音就是罪魁祸首。单听杂乱无章,通过一些“化学反应”叠加到鸟鸣的原始音频里,AI便收到了噪音要传达的信息。

用这些原料制造出让人类没有防备,又带偏AI节奏的一石二鸟邪恶音频,并非简单的操作,需要用上深度学习。

先骗AI再骗人

如何迷惑神经网络?

机器学习里有个冉冉升起的研究领域,叫对抗性攻击 (Adversarial Attacks) 。

这种对深度神经网络的误导,在视觉上比较常见。大家可能还记得,MIT团队曾经骗过谷歌AI,让它把一只3D打印的乌龟认成了步枪。

MIT开发的EOT算法,能识别带有纹理的3D模型,再对原本的纹理做些微小的改变,就生成了“对抗性图像 (Adversarial Image) ”。

肉眼看去,对面依然是只乌龟。可AI看到的已经是完全不同的东西了。

把视觉换成听觉,原理也相差不多。

在原始音频和隐藏指令之间,能找到一种美妙的融合。不论本来的声音是鸟叫,还是人类的歌声,或者什么别的音色,都不是问题。

融合的方法,就来自德国波鸿大学(Ruhr-Universitaet in Bochum)一群科学家们的研究。他们运用深度学习生成对抗样本 (Adversarial Example) ,来误导当下主流的语音识别系统Kaldi,分三步走:

第一步,输入原始音频 (比如“我爱学习”) 以及目标指令 (比如“放弃治疗”) ,用强制对齐 (Forced Alignment) 找到二者之间最佳的时间对齐 (Temporal Alignment) 方式。

第二步,用反向传播来改变输入的“我爱学习”声波,从而令语音识别AI把它转写成“放弃治疗”。

第三步,便是欺骗人类了。请继续阅读。

△ 若字幕组能骗过你的眼睛,耳朵大概也不难骗?

如何躲避人类的疑心?

要给语音助手下达隐藏指令,只要生成特定的波形就做得到。但在送信的时候,还要避免被人类发现。

这里用到的方法叫做心理声学隐藏 (Psychoacoustic Hiding) :

算法知道,你会对怎样的噪音缺乏警惕。

这就涉及到人类听觉的一个弱点,叫掩蔽效应 (Masking Effect) 。

当两种声音同时传进耳朵,人类会对音量更大的那段声波比较敏感,对微弱的那一段就不敏感。

团队用了一个心理声学模型,来分析将哪些声音叠加到原始音频里,不易影响人类感知,然后在这个范围里悄悄改变声波就行了,神不知鬼不觉。

你听,音频里说的是不是这句话:

再普通不过的新闻内容。

但语音识别的结果,却是完全不同的句子了:

竟然听成了关闭监控摄像头并打开房门?

细思恐极。

能打开你家大门?

攻击方法有了,怎样让人类主动播放这些“转基因”的音频,给语音助手听个清楚?

想也容易,只要在大家听的音乐、看的电影、或者刷的剧里面,偷偷混入一小段:

一是很难让人产生警觉,二是攻击范围非常广泛,可至全球。只要公放声音,就可能顺利控制语音助手。

毕竟,如今的许多智能音箱,都可以用语音来购物。这样的话,银行卡就可能遇到危机。

确实,付款环节可以开启密码保护,但至少在Alexa身上,密码功能是默认关闭的。

以上并非全部。

如果,智能音箱 (或者其他什么设备) 的语音助手连接着整个智能家居系统,包括摄像头和安全警报系统呢?

友情提示,上一章节末尾,那条被修改过的音频,里面藏的就是关闭摄像头并打开房门的指令。

群起而攻之

当然,也不用太害怕了。

毕竟,攻击语音助手,招式早就不止那一种。

海豚音攻击

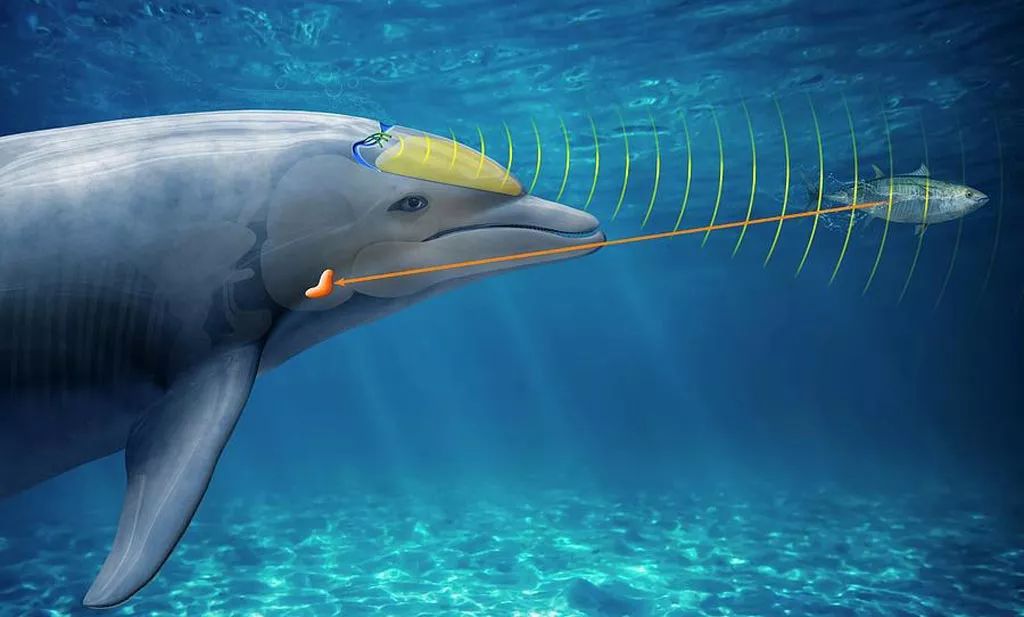

这是浙江大学团队去年发表的成果,可以利用人类听不到的超声波,向语音助手传递隐藏指令。

人类听不到的波段,却被麦克风收录起来,又被系统解调成人类语音的频率。这样一来,语音识别AI收到的波形,就和原本的样子完全不同了。

团队表示,他们已经用超声波发射装置,攻击过谷歌助手、亚马逊Alexa、微软Cortana、苹果Siri、三星S Voice和华为HiVoice,语音助手全员败阵。

并且,即便是拥有声纹保护的语音助手,也不能保证安全。因为,黑客仍然可以用语音合成来模拟声纹,攻入设备。

不过,超声波这个强大的方法也有缺点,一种算法只能针对一种特定的麦克风。毕竟,要在收音上做文章,不同的麦克风情况会有不同。

同音字攻击

一种名叫“Voice Squatting”的招数,利用了语音助手的三方应用市场。

每个开发者都可以发布,自己为Alexa编写的技能 (Skills) 。黑客也可以开发一些恶意技能,关键是让用户在无意中触发这样的技能:

只要恶意应用的名字,和某个正常程序的发音足够相似就可以了,简单易行。

△Alexa毕竟没有屏幕

比如,已知有一款叫做Rat Game的游戏,那给恶意应用起名“Rap Game”,就能骗过Alexa。

这两个字还不算同音,而Capital One (第一资本App) 和Captial Won (恶意技能可取的名字) 之间,应该更难找到破绽。

当智能音箱打开一个冒牌App,用户以为打开的依然是平时常用的软件,就可能在不经意间向恶意应用输入自己的重要信息了。

远程窃听术

腾讯团队在今年的DefCon大会上,成功演示了攻入亚马逊第二代Echo智能音箱,控制设备,窃取录音的方法:

多亏Echo有多台设备联网功能,只要连接相同的WiFi,几台智能音箱之间,就能通过名叫“Whole Home Audio Daemon”的守护进程相互交流。

研究人员让一台改装过的Echo,和一台普通Echo连上同一WiFi,利用守护进程的一系列bug,魅惑了多台音箱。

这样,想让它播放什么声音,就播放什么声音,还可以把麦克风捕捉的音频偷偷传到远程服务器里,实现窃听。而用户全程不会收到任何警报。

当然,腾讯团队事先告知了亚马逊,后者火速发布一块补丁,解决了这个问题。

网络安全领域的科学家们,一向热衷于探索智能设备的漏洞。

亚马逊音箱Echo和里面的助手Alexa,可能是他们最常用的小白鼠,研究成果大多诞生于此也很自然。

不过,现实里还没有发现类似的攻击事件。在这段暂时安全的日子,不断中枪的亚马逊,以及其他科技大厂,也可借鉴所有被黑的经验,把产品升级成更加安全可靠的样子。

黑客和智能设备,不知将来谁会跑得更快。但对两者来说,都是有了对方,才能更努力地往前跑吧。

论文传送门:

https://arxiv.org/pdf/1808.05665.pdf声明:本文来自量子位,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。