今天,和大家分享世辉律师事务所的王新锐和李慧撰写的一篇文章。

如果有什么事和大语言模型(Large Language Model)及其相关的技术发展的一样快,那也许就是对其的监管。

以GPT、Bard、LLaMA等为代表的大语言模型,是基于大规模数据集进行预训练以理解人类语言的一种人工智能模型。在不同的语境下,其底层技术和具体应用又被称为生成式人工智能(Generative AI)或AIGC(AI Generated Content)。尽管其侧重点有所差异,但指向的技术光谱大致相同。随着算力、算法、数据的不断更新,随着人力、物力、财力的不断聚集,大语言模型还是快速演进中,但其“大力出奇迹”的能力被世人瞩目的同时,也自然引起了主要国家立法者和监管者的密切关注和快速反应。

在我们持续跟踪的已出台或进行中的境内外立法和监管规则中,有一个比较明显的“公约数”就是对大语言模型提出的信息披露要求。本文旨在就中美欧大语言模型需向监管披露信息的最新监管和执法要求进行总结和对比,以期形成具有预测性的先行指标。

一、中美欧大语言模型信息披露的要求

1、中国

在我国,大语言模型的监管被置于了“生成式人工智能”这一概念之下。生成式人工智能技术,指任何具有文本、图片、音频、视频等内容生成能力的模型及相关技术,其既包括大语言模型,也包括其他具有内容生成能力的模型及相关技术。

2023年8月15日,我国首部针对生成式人工智能的法规《生成式人工智能服务管理暂行办法》(以下简称《暂行办法》)已正式生效。《暂行办法》强调生成式人工智能服务提供者(以下简称“提供者”)应当依法履行算法备案义务,并配合有关主管部门的监督检查,要求:

(1)提供具有舆论属性或者社会动员能力的生成式人工智能服务的,应当按照《互联网信息服务算法推荐管理规定》履行算法备案和变更、注销备案手续;

(2)除备案外,如有关主管部门开展监督检查,生成式人工智能服务提供者(以下称“提供者”)亦应依法予以配合,按要求对训练数据来源、规模、类型、标注规则、算法机制机理等予以说明,并提供必要的技术、数据等支持和协助。

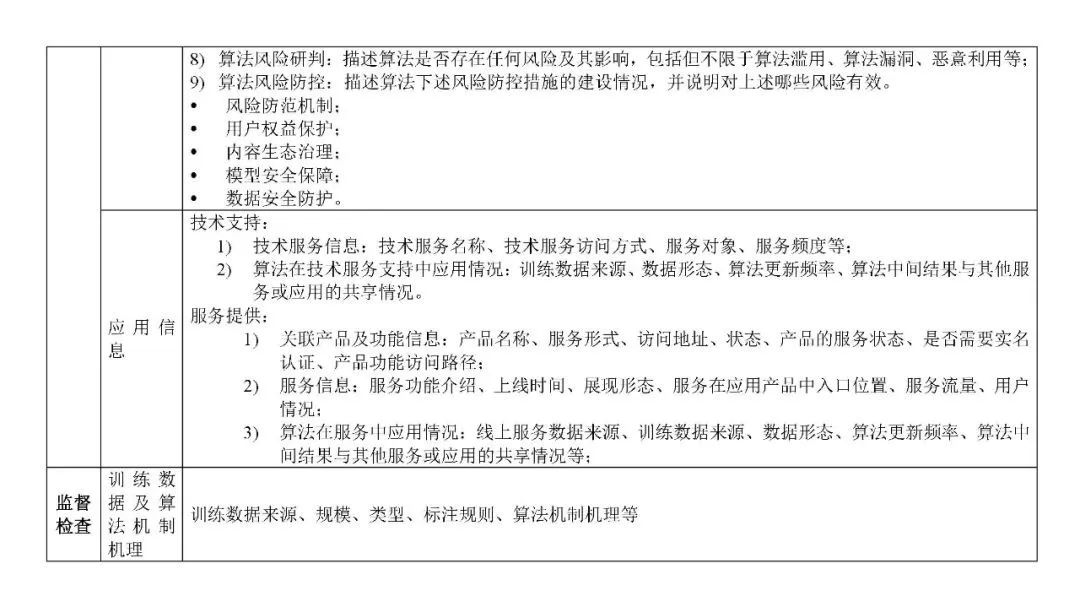

参考互联网信息服务算法备案系统中的《算法安全自评估报告》模板,不同阶段下中国生成式人工智能服务提供者在备案时需向监管机构披露如下信息:

2. 美国

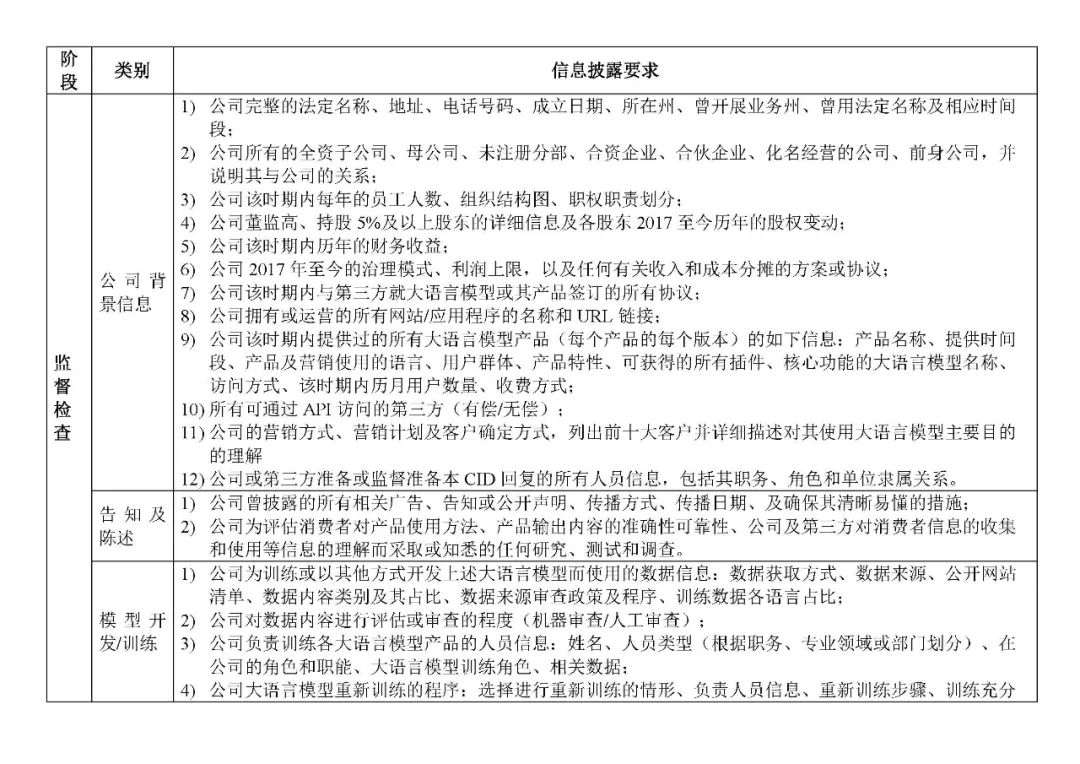

相对来说,美国对人工智能技术的立法和监管一向较为宽松和柔性,且主要集中在公共领域,但面对大语言模型也没有观棋不语。除了一些议员在推动的国会立法,美国联邦贸易委员会(FTC)于2023年7月13日正式发起了首个针对人工智能聊天机器人带来风险的审查。在这次审查中,FTC向Open AI公司就其大语言模型及相关产品和服务发出了一份长达20页的民事调查令(CID),要求Open AI公司对CID中列明的事项进行详细的说明,以调查Open AI是否存在造成消费者损害风险的不公平或欺骗性行为。根据该CID,Open AI公司需就提供大语言模型相关的产品和服务向FTC披露其自2020年6月1日起的下列信息:

3. 欧盟

在欧盟,大语言模型的监管则被纳入到了基础模型(Foundation Model)这一概念之下。基础模型指在广泛的数据上进行规模化训练的大语言模型,其设计是为了实现输出的通用性,并能适应各种不同的任务。大语言模型可以看做是一种典型的具有广泛应用功能的基础模型,但基础模型这一概念本身并不局限于以语言为重点。

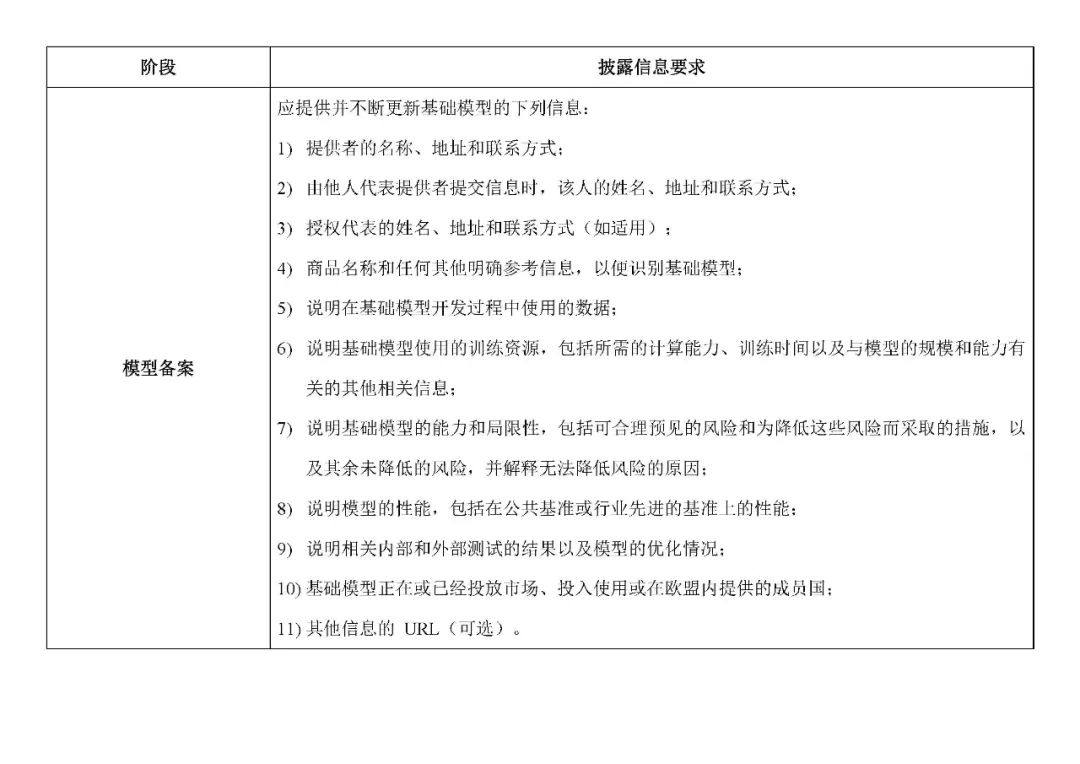

2023年6月13日,欧洲议会正式通过了《人工智能法案》(AI Act)的折衷修订草案,该法案即将进入最终谈判阶段。作为欧盟第一部通过议会程序专门针对人工智能的综合性立法,《人工智能法案》对基础模型提供者提出了包括备案在内一系列的义务要求,备案需披露的信息要求中亦体现了欧盟对人工智能关注的重点方面:

二、中美欧监管要求对比

纵观目前中美欧大语言模型信息披露的监管要求,我们可以发现其监管要点大致均从公司主体、算法模型及应用产品三个不同的维度提出,即既对责任主体和与用户进行直接交互的产品延续了一贯的监管,亦对底层算法模型的安全给予了额外的关注。其中特别值得注意的是:

1. 高度重视大语言模型相关的数据

如上所述,中美欧监管均对训练数据的来源给予了高度的重视。这一方面是因为数据来源本身的合法性与第三方的权益息息相关,如非法获得个人信息可能侵犯相关个人信息主体的隐私权,非法使用他人的作品进行大模型训练可能侵犯其著作权;另一方面则是由于训练数据本身的质量与大语言模型的产出息息相关,如使用的训练数据本身可能导致歧视、或含有不良信息,则亦会影响大语言模型输出内容的合法合规性。因此目前中美欧均对训练数据的来源提出了向监管进行披露的要求,企业应大模型训练过程中注重记录并保留训练数据获取的相关文件和信息,以应对监管的披露要求。

但通过上述对比可知,中美两国均已在实践中的备案文件或民事调查文件中提出了需具体披露的相关数据信息项目。美国除对训练数据的内容、来源、类型、规模等提出了披露需求外,还进一步对其训练数据的选择和审查的决策程序文件提出了披露要求,并格外关注人工智能可能涉及的对个人信息的一系列处理。中国在训练数据之外则进一步要求企业披露算法各节点的输入和输出数据的形态,且监管的披露要求并不局限于个人信息,而意图了解数据在相应算法中处理的全流程信息,并对数据本身内容之外的标注方式、预处理和后处理等数据处理行为同样给予了高度关注。企业需根据业务涉及的司法辖区做出有针对性的合规策略。欧盟目前的规定相较而言有些简要笼统,但其特别之处在于基础模型提供者需要长期更新这些信息,这显示出欧盟不仅关注模型开发的初期阶段,也关注模型的使用和优化阶段,以实现长效监管。

2. 风险及控制措施

作为对人工智能相关模型监管的核心出发点,中美欧均不例外要求公司对其人工智能相关模型存在或潜在风险进行详细的说明,并需提供已进行的相应控制措施。其中,美国目前对相应风险排查和要求主要尚仍集中于与个人信息权益相关各类泄露、虚假或真实个人信息生成等方面的风险。相比之下,中国和欧盟则对风险采取了更宽泛的表述。且中国明确了一系列的如算法滥用、算法漏洞、恶意利用等风险项目,及具体的风险防控要求,相较于结果导向的权益风险保护,中国进一步将风范防范的要求细化至了技术层面。但总体而言,虽然企业目前就风险防控向监管进行披露的颗粒度在不同区域尚有一定差异,但风险排查的总体要求仍是相同的,在业务涉及的各司法辖区企业均应对人工智能涉及的潜在风险进行系统梳理并采取相应有效的控制措施。

综上,虽然中美欧目前对大语言模型数据披露的要求的颗粒度和关注重点尚不完全一致,但这与相应地区人工智能本身的科技发展程度,以及立法历史背景均有关系。不可否认的是,各国监管均已充分意识到人工智能可能带来的风险,并在逐步加强对其各项信息的披露要求,希望通过严格的监管机制保证人工智能技术的正当、合法、安全使用。我们相信这也为企业,尤其是人工智能企业未来合规策略的搭建传递出了重视数据合规的明确信号。(鄢布凡、夏文燕律师对本文亦有贡献)

声明:本文来自网安寻路人,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。