智能时代机遇与风险并存,人工智能系统和相关技术(如机器人、生物识别、物联网、无人机等)不断取得的突破以及越来越多地在日常商业活动中的部署和使用,使其逐渐成为网络安全领域关注的重点。2021年4月,欧盟委员会提出了一项关于人工智能法案的提案1,主张高风险的人工智能系统在设计和开发的过程中遵循一定的技术标准,以确保一致和高水平地保护健康、安全、基本权利等公共利益。但人工智能相关标准的制定是一项巨大的工程,甚至在法案生效之前也很难成型,这就需要一系列可以为人工智能利益相关者(设计开发人员、运营服务商、专业用户和立法者等)和政府监管当局提供实践指导的良好做法。为此,2023年6月7日,欧盟网络与信息安全局(ENISA)发布了题为《人工智能良好网络安全实践的多层框架》(以下简称《框架》)的报告。该报告提出了一个可扩展的框架,指导国家网络安全机构和人工智能利益相关者通过采取必要步骤,利用现有知识和最佳实践确保其人工智能系统、操作和流程的安全。该框架由三层组成,包括网络安全基础、人工智能的网络安全和特定行业的人工智能网络安全,是目前欧盟以循序渐进的方法实现良好网络安全实践、确保人工智能系统可信度的一次重要尝试。本文拟对《框架》的主要内容进行梳理、分析与总结。

1 人工智能及其面临的网络安全威胁

1. 人工智能的内涵

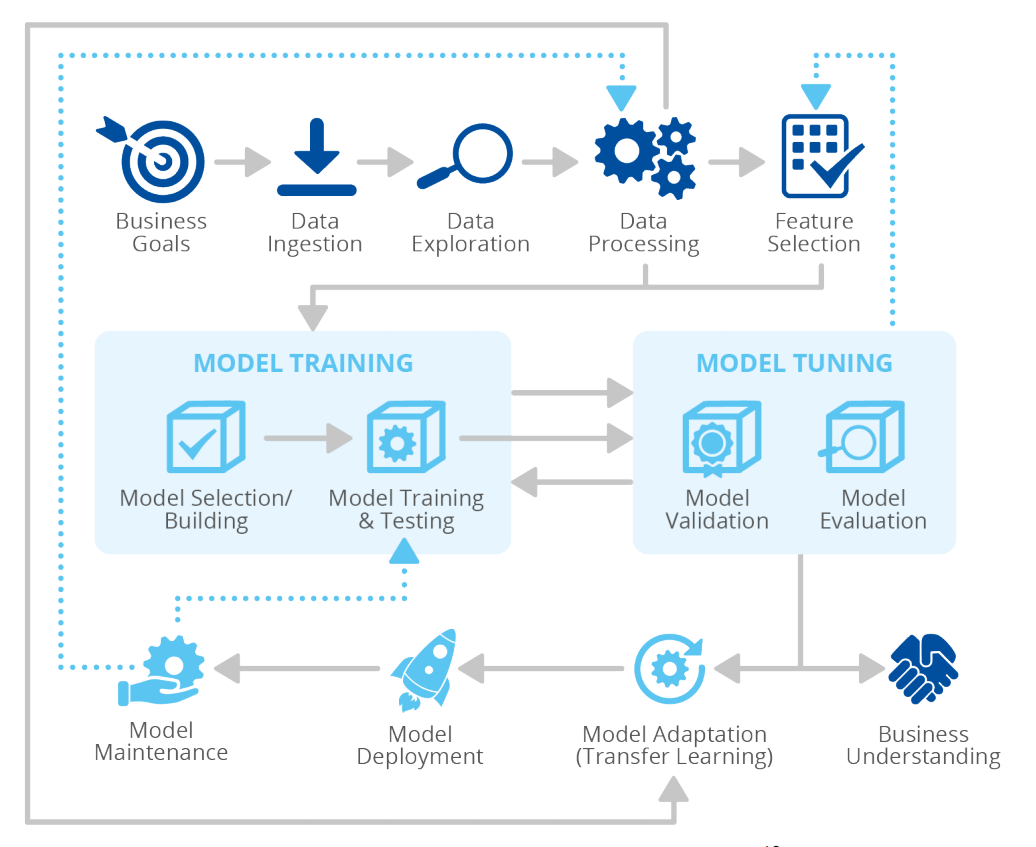

要了解人工智能的网络安全,首先要对人工智能的内涵有概括的认识。根据经合组织(OECD)的定义2,人工智能是一种以机器为基础的系统,可以通过为一组给定的目标产生输出(预测、建议或决策)来影响环境:人工智能使用机器以及基于人的数据和输入来感知真实和虚拟的环境,并通过自动化(例如机器学习)或手动分析的方式将这些感知抽象为模型,最后使用模型推理为结果提供选择。在这个定义下,人工智能的范围广泛,包括计算机视觉(如人脸识别)、机器学习、自然语言处理、语音识别等多个技术领域,其中最具典型性的是机器学习。以机器学习为基础,人工智能的生命周期大致表现为从业务需求分析到数据收集和处理,再到模型训练和调整,最后到模型适应、部署和维护的过程,如下图。

图1 典型的人工智能生命周期

在这个过程中,人工智能的组成部分(资产)包括:(1)数据,如原始数据、公共数据集、训练数据、测试数据等;(2)模型,如算法、模型、模型参数、超参数等;(3)有价值的工具,如数据治理策略、描述性统计参数、模型框架等;(4)参与者和利益相关者,如数据所有者、数据科学家、数据工程师、模型提供商等;(5)运行过程,如数据获取、数据预处理、特征选择、训练、调优等;(6)环境和工具,如算法库、机器学习平台、优化技术、集成开发环境等。

可见,人工智能,无论是动态的人工智能的开发、运行和维护过程,还是静态的人工智能资产,都是一个综合的系统,因此其面临的网络安全威胁是多方面的,所需要的网络安全实践也必须是综合、立体的,这是《框架》的基本理念。

2. 人工智能面临的网络安全威胁

《框架》列举的人工智能面临的威胁可以分为两类,一类是人工智能系统面临的一般威胁,包括恶意活动、窃听或劫持、物理层面的攻击、意外损坏、失灵或故障、停机、自然灾害、违反法律规定等,这类威胁针对的对象是信息与通信技术(ICT)基础设施,在人工智能系统受到的网络攻击中占绝大部分。另一类是针对机器学习的威胁,主要包括算法模型安全和数据安全两种,前者如模型训练完整性威胁、测试完整性威胁、模型缺乏稳健性等,具体表现为绕过攻击(通过对抗性样本操纵模型决策和结果)、毒化攻击(注入恶意数据降低模型可靠性和精确度)、木马攻击、后门攻击等,后者主要包括基于模型输出的数据泄露和基于梯度更新的数据泄露。这些威胁与人工智能系统的漏洞相关,如缺乏基于对抗性攻击的培训、对模型检索信息的控制不佳、缺乏足够的数据来承受中毒、访问权限管理不良、使用脆弱的组件和缺少集成的网络弹性策略等。目前针对机器学习的网络攻击并不多,在一项对机器学习从业者的研究报告中,逃避攻击和中毒攻击分别只占网络攻击总数的2.1 %和1.4 %3,但这类威胁对人工智能系统的影响更大。

应该指出的是,《框架》研究的目标受益者既包括人工智能设计开发人员、制造商、运营服务商,也包括立法者和政策制定者,还包括国家监管评估机构以及用户,所以这里的人工智能网络安全是多角度的。除了技术和物理层面的攻击,《框架》也试图强调人工智能系统面临的社会风险。正如NIST在2023年1月发布的《人工智能风险管理框架》4中指出的,人工智能系统本质上具有社会技术性,这意味着其面临的威胁不仅是技术和法律性的,而且是社会性的。一些突出问题包括算法偏见、算法歧视、算法不透明,都直接与社会因素和人类行为有关,并处在不断的变化过程中。这些社会威胁如何影响具有不同心理特征的个人、群体、社区、组织、民主国家和整个社会,都需要利益相关者在评估威胁时进行分析和衡量。

2 人工智能良好网络安全实践的三层框架

1. ICT基础设施网络安全

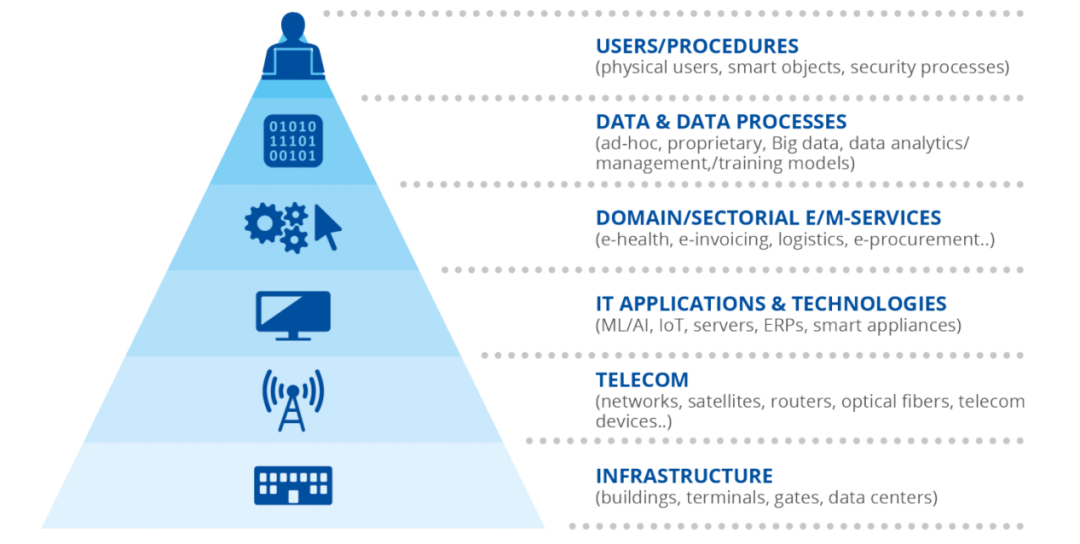

由于人工智能系统需要托管在信息与通信技术(ICT)基础设施中,因此框架的第一层强调使用基本的网络安全实践来保护ICT托管生态系统。换言之,人工智能系统是ICT基础设施的一部分,在应用特定的人工智能网络安全实践之前,必须首先考虑那些保护包含人工智能元素的信息和通信技术的实践。所谓ICT基础设施,主要包括支持数字计算的基础设施和资产,是所有组织的业务和数字活动的前提。《框架》认为,任何ICT基础设施都可以看作是一个由六个构件组成的金字塔。

图2 托管人工智能系统的 ICT基础设施

如上图所示, ICT基础设施金字塔的第一层由所有的物理资产组成,包括建筑、终端、入口、数据中心等,用以支持第二层(电信)中的网络和电信设备。在此基础上,第三层IT应用程序和技术就包含与人工智能系统相关的资产。第四层(领域或部门电子商务服务)包括所有数字服务,而第五层(数据和数据处理)包括前一层中使用的所有类型的数据。第六层(用户/过程)包括与上述层的所有组件交互的用户如人员、企业、智能对象(如物联网),以及操作过程。在这种视角下,任何ICT系统都包含物理层和网络层,是一个网络-物理系统。《框架》认为,可以通过安全管理、网络安全认证和综合网络安全法律与政策三种途径入手,确保ICT基础设施的网络安全。

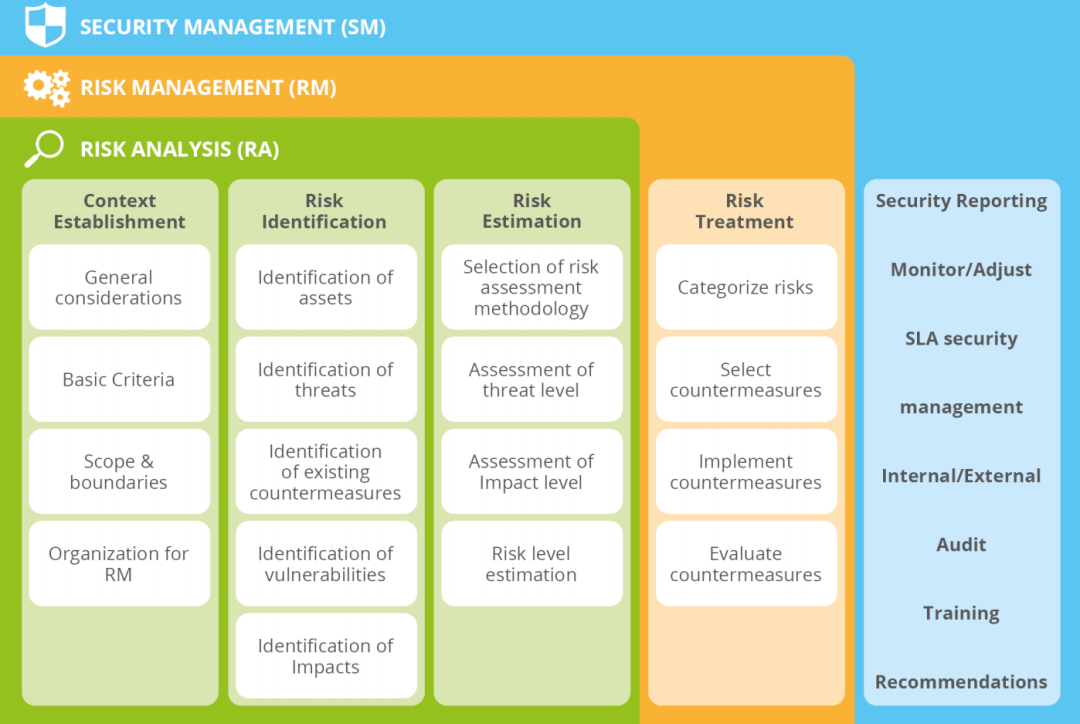

(1)安全管理

要实现ICT基础设施网络安全,首要的措施是安全管理,即通过识别和评估网络威胁、漏洞以及通过衡量风险来确保企业安全。安全管理包括风险分析和风险管理两个主要阶段,第一阶段是对评估范围内的所有资产进行威胁、脆弱性、影响分析和风险评估;第二阶段是通过选择和实施适当的应对措施来处理风险。目前ICT基础设施面临的威胁可以分为四类:一是敌对威胁,即对个人、团体、组织或国家构成恶意意图的行为(例如拒绝服务攻击、未经授权的访问、伪装身份等);二是意外威胁,例如在设备或信息系统的配置或操作期间,或进程的执行过程中的一些人为失误;三是环境威胁,主要包括自然灾害(洪水、地震)、人为灾害(火灾、爆炸)和配套基础设施故障(停电、通信损失)等;四是漏洞,即可能被攻击者利用的现有弱点。根据欧盟NIS和NIS 2指令,所有对社会运作具有重要性的基本实体都需要评估和减轻其风险,确保在安全的环境中运行,人工智能系统也是如此。下图是安全管理内容及阶段的示意图。

图3 安全管理的内容及阶段

在2022年3月,ENISA曾发布过一份关于网络安全风险管理的报告——《网络安全风险管理的标准化分析及建议》。《框架》给出的风险管理的步骤与之基本相同:(1)确定风险管理决策的基本标准、范围;(2)识别风险:根据风险管理政策,列出要保护的资产和相关的潜在威胁;(3)评估风险:基于威胁的规模、影响、可能性和发生率参数,确定不同威胁的风险管理优先次序;(4)缓解风险:为处理所确定的风险提出解决方案,并评估已实施的安全控制措施,检查其效率并评估安全风险的缓解效果。此外,《框架》也强调安全管理重点应当是威胁和漏洞的识别、分析和评估,以及在此基础上对企业资产的风险等级的评估,即风险分析应当给出企业ICT系统中所有资产的威胁列表和相应的风险级别。同时,人工智能的利益相关者需要了解网络攻击的对手,一般而言,潜在的网络攻击具有手段、动机、机会三个关键部分:如果攻击者有相应的技术手段,有机会利用漏洞,以及有针对受害者的动机,那么就会发生攻击。因此人工智能的利益相关者和运营商需要分析潜在的攻击者,以便更现实、更准确地估计其风险水平,并采取适当的对策。

在具体操作和技术标准方面,《框架》认为应当结合柔性措施(如工作程序或流程)和硬性措施(如技术控制)降低ICT基础设施面临的风险。ENISA从创建以来一直致力于研究风险管理,并制定了多种方法和最佳实践,因此《框架》指出人工智能利益相关者可以使用已有的《ENISA威胁形势报告》5《部门网络安全评估方法》6《国家层面的风险评估》7《风险管理/风险评估方法和工具清单》8《风险评估——针对信任服务提供商的指南》9,以及ISO 2700210等技术控制标准来保护托管其人工智能系统的ICT基础设施。但以上的方案和标准制定的时间较为久远,具有一定的滞后性,所以《框架》也鼓励人工智能利益相关者在一些涉及风险管理的欧盟研究项目中寻找创新的安全管理工具。11

(2)网络安全认证

2019年,《欧盟网络安全法案》(EU Cybersecurity Act 2019)建立了网络安全认证制度,为 ICT 产品、服务和流程引入了欧盟范围内的网络安全认证框架。在该法案下,在欧盟开展业务的公司只需对其 ICT 产品、流程和服务进行一次认证,证书就会在欧盟范围内得到认可。《框架》指出,人工智能利益相关者也可以通过网络安全认证体系来评估ICT产品,以提高人工智能技术产品的安全性和消费者的信任度。目前欧盟网络安全认证的主要标准是ISO/IEC1540812(特别是通用标准Common Criteria-CC13),其建立了ICT安全评估的框架。同时,ISO/IEC 1804514也提供了一种通过定义最低限度的行动来帮助评估者进行通用标准的评估的方法。通过以上标准,利益相关者可以评估托管人工智能组件的ICT资产的安全性,包括托管人工智能模型的服务器或人工智能资产在提供服务期间参与的供应链服务等。当然,由于人工智能系统具有动态的、不断发展的特性,目前还没有确定人工智能产品认证方案的安全要求的评估方法,对此还需要进一步的研究。在未来几年,欧盟计划为人工智能产品开发各种网络安全计划,以明确安全要求。

(3)综合网络安全立法与政策

在网络安全领域,欧盟已经出台了一系列立法和政策,构建起了欧盟网络安全的基本框架。所有ICT基础设施的运营商都需要了解并遵守欧盟立法、建议和指令,从2013年的《欧盟网络安全战略》到2022年的《NIS 2指令》《网络弹性法案》,欧盟通过立法和政策确保有效的网络安全应对措施。

2022年颁布的《关于在整个欧盟全境实现高度统一网络安全措施的指令》(NIS 2指令)旨在调整欧盟的网络安全法律框架,提升欧盟整体的网络安全能力。NIS 2指令大大扩展了属于其范围的关键实体的部门和类型,确保更多的部门和实体采取网络安全风险管理措施,加强了公司需要遵守的网络安全风险管理要求,提高了欧洲的网络安全水平。为了在国家和欧盟层面加强网络危机管理方面的信息共享与合作,NIS 2指令简化了事件报告义务,对报告、内容和时限做出了更精确的规定。此外,该指令中的行政处罚更加严格,包括对违反网络安全风险管理和报告义务的罚款,对国家当局的监管措施、执法要求也更加严格。

1999年出台的《欧盟共同安全和防御政策》(CSDP)也是一项网络安全关键政策,它是欧盟应对新的、非常规安全威胁的主要工具,并为欧盟的欧洲共同防御做好准备。由于人工智能被认为是一种将为捍卫欧盟发挥关键作用的技术,因此这一政策也很被重视。

2023年批准的《欧洲芯片法案》(The EU Chips Act)与人工智能安全相关,因为半导体是21世纪平台技术的组成部分,将用于人工智能开发和嵌入强大的安全措施。欧盟全球化的半导体产业将得到该法案的支持。

2022年发布的《网络弹性法案》(CRA)为数字产品和辅助服务制定了新的网络安全规则。这一举措还将促进人工智能产品的安全性,因为它旨在通过为实体和非实体数字产品的制造商和供应商引入共同的网络安全规则,以满足市场需求,保护消费者免受不安全产品的侵害。

2020年发布的《欧盟网络安全战略》(EUCSS)旨在建立抵御网络威胁的能力,并确保公民和企业从值得信赖的数字技术中受益。根据该战略,欧盟建立了一些专门从事网络安全工作的机构,如“欧洲网络安全能力中心”旨在提高欧洲的网络安全能力和竞争力,与国家协调中心网络合作,建立一个强大的网络安全社区。该中心将指导人工智能利益相关者加强其产品的网络安全,并推进研究工作和开发。“国家计算机安全事件响应小组”旨在促进国家内部和跨国家网络能力建设并使其更加有效,能够指导利益相关者应对人工智能攻击或使用人工智能技术保护其基础设施。

2008年通过的《新立法框架》(NLF)是一套旨在改进市场监督和提高合格评定质量的措施。NLF自2008年通过以来,改进了欧盟的市场监测,改善了货物市场,引入了更好地保护消费者和专业人员免受不安全产品(欧盟或非欧盟来源)侵害的规则,制定了认证规则,并为工业产品建立了共同的法律框架,其有利于提高基于人工智能的产品的安全性。

总体上,欧盟的立法和政策是较为成熟的,但当前的挑战是评估人工智能产品的静态标准可能很快就会过时,因此需要在整个人工智能生命周期中进行动态风险管理和评估,这也是欧盟正在努力的方向。

2. 人工智能特定的网络安全

框架第二层是在“假定人工智能系统由可信的硬件基础设施支持”的基础上,专门针对人工智能提出的网络安全实践。机器学习(包括深度学习)是人工智能领域最具典型性和颠覆性的技术,对人工智能网络安全构成了挑战。这主要因为灰箱和黑箱模型在该领域占主导地位,无代码人工智能(No-code AI)将构建模型的时间缩短到几分钟,使用户能够轻松地使用机器学习的模型,即使没有专业技能也可能够构建和训练算法,这使人们无法评估这些算法在透明度、道德、数据隐私、非偏见和治理缺陷方面的可信度。因此,《框架》认为,必须围绕人工智能的使用开发强大的审查工具和政策,并构建一个系统来确保每个使用无代码软件的人都理解和遵守这些政策;同时,需要先进的工具来审查这些无代码的人工智能模型是如何被训练的,以便在设计层面上就确保其安全。这一理念来源于2021年欧盟委员会关于人工智能法案的提案,在该提案中,人工智能监管框架的具体目标如下:

a.确保在欧盟市场中的人工智能系统是安全的,并尊重有关基本权利和欧盟价值观的现有法律;

b.确保法律上的确定性,以促进对人工智能的投资和创新;

c.加强对适用于人工智能系统的关于基本权利和安全要求的现有法律的治理和有效执行;

d.促进合法、安全、可靠的人工智能应用单一市场,防止市场分裂。

除了该提案外,欧盟委员会还发布了一项关于人工智能责任指令的提案,其目的是“通过为人工智能系统造成的损害的非合同民事责任的某些方面制定统一规则,改善内部市场的运作”。可见,框架的第二层的目的主要在于确保人工智能产品本身的安全性以保障市场稳定,具体的措施包括以下四个方面。

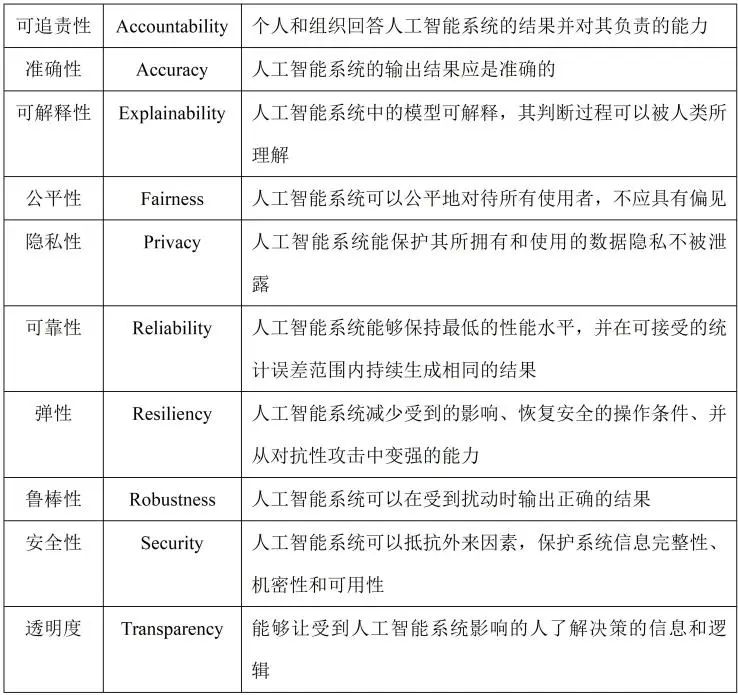

(1)提高人工智能的可信度

人工智能技术在医疗保健、金融和自动驾驶汽车等关键领域都取得了令人瞩目的成就,但与此同时,人们对其可信度的担忧也与日俱增。这种担忧来自机器学习的两个内在因素:难以解释其输出和数据扰动会对其结果造成影响。随着人工智能系统业务多样化,规模复杂化,人工智能系统的可信度(trustworthiness)愈发受到人们的关注。人工智能的可信性是指对人工智能系统在特定规范范围内行为的信心,其表现为一些能力属性。不同的机构如欧盟委员会、经合组织和NIST等对人工智能可信属性的要求各有不同,如欧盟委员会提出了可追责性、普惠性、自主性、公平性、隐私性、鲁棒性、安全性、透明性8个可信属性,NIST提出了互操作性、安全性、可靠性、鲁棒性、公平性和可解释性共6个可信属性。15分析人工智能的可信属性,是理解与人工智能的使用相关的概念和风险的前提。《框架》在此基础上提出了10个可信属性,具体见下表。

表1 人工智能系统的可信属性及其含义

2023年1月,NIST发布的《人工智能风险管理框架》将人工智能的可信属性分为技术设计属性、社会技术属性以及有助于提高可信度的指导原则三个类别。其中技术设计特性是指由人工智能系统设计人员和开发人员直接控制的,可以使用一般评估标准进行测量的能力。这个类别包括准确性、可靠性、鲁棒性和安全性等;社会技术属性是指人工智能系统是如何在个人、群体和社会环境中被使用和感知的,这个层面的重点是可解释性和隐私性;有助于提高可信度的指导原则是指更广泛的社会规范和价值观,表明社会优先事项,其中公平性、可追责性和透明度最为突出。这些属性是利益相关者评估和提高人工智能系统可信度的关键标准和指导。

(2)应对特定威胁

《框架》第二层还提供了一些针对特定威胁的专门解决措施,例如对于前述的绕过攻击、中毒攻击、数据泄露等,可以引入专门的安全控制措施以提供有效的预防和缓解方法。对于绕过攻击,可以利用工具来检测给定的输入数据是否是对抗性的,并使用对抗性训练来使模型更加强大,也可以使用不太容易转移的模型来显著降低攻击者研究系统下工作的算法的能力。对于中毒攻击,应该评估所使用的模型的暴露等级,可以尽可能扩大训练数据集,减少其对恶意样本的敏感性,并考虑从恶意样本中清除训练数据的预处理步骤。对于模型和数据泄露威胁,可以通过应用适当的访问控制和联合学习来尽量减少数据泄露的风险。为了防止机器学习应用程序的失灵或故障,应该尽可能降低所采用的算法的偏差,并对算法进行适当的评估,以确保其对所处的环境具有安全弹性。

(3)引入安全测试

安全测试是传统软件测试的一个重要环节,旨在评估系统、应用或网络的安全性的过程,其目的是发现潜在的安全漏洞、弱点和风险,以确保系统能够抵御各种安全威胁。《框架》也提出了人工智能系统的安全测试问题,认为人工智能的安全测试与传统系统的安全测试之间有一些共性,但也存在新的挑战:一是人工智能系统可能会随着时间推移而进化,进而可能导致安全属性的降低;二是由于人工智能系统每次的测试结果都可能不同,所以很难得出确切的结论;三是数据驱动的算法使数据构成了人工智能系统的行为,这也与传统的系统截然不同。因此人工智能系统的安全测试需要新的方法。2022年,欧洲电信标准化协会ETSI发布了《人工智能安全测试》草案,草案提出了人工智能的安全测试方法、人工智能的安全测试规范、安全测试的充分性标准等,但其目前仍在完善之中。

(4)利用可用的资源

人工智能网络安全是近年来网络安全领域的热点,许多研究机构和研究人员都撰写了相关的报告。《框架》对这些资源作了总结和指引,主要包括三类。一是技术标准,如ISO/IEC的风险管理、可信度和管理系统研究,ETSI的人工智能威胁本体论和数据供应链安全项目,以及IEEE的人工智能的可解释性研究等。二是伦理准则,如欧盟委员会人工智能高级专家组发布的《值得信赖的人工智能伦理指南》16,智库DataEthics发布的《人工智能服务公共采购中的数据伦理白皮书》17等。三是评估和指导人工智能安全的实用工具,如《值得信赖的人工智能伦理指南》中就包括一份《值得信赖的人工智能的评估清单》,可以帮助企业和组织自我评估其正在开发的人工智能系统的可信度,一些技术平台也能够提供帮助,如MITRE ATLAS可以提供关于机器学习系统的对手战术、技术和案例研究的知识库18,GuardAI可以模拟敌对和恶意的输入,以此来评估AI模型应对对抗性攻击和自然影响的能力19。当然考虑到研究资源的更新问题,人工智能利益相关者也可以持续关注这些研究组织和平台的最新成果。

3. 特定行业的人工智能网络安全

人工智能技术已经广泛应用在汽车、卫生、运输、金融等多个领域中,而这些行业的网络安全问题各具特点,需要具体问题具体分析。因此《框架》认为,在第三层应当向特定经济部门的网络安全提供针对性建议。

例如在能源领域,随着工业自动化和控制系统、智能电网等设备的出现,能源企业逐渐成为网络攻击的目标。一方面,网络的互联互通和基础设施快速增长的复杂性增加了安全威胁及其级联效应。另一方面,正如2019年ENISA报告《工业4.0网络安全:挑战和建议》指出的,能源行业使用的主要来自外国制造商的技术存在许多漏洞和大量潜在攻击点,也增加了网络安全的挑战。因此,该行业的利益相关者必须加强信息安全和隐私实践,并解决一些威胁安全的根源性问题,包括在操作和维护期间进行远程工作、使用已知漏洞的技术、在设施中使用过时的控制系统等。关于这一问题,欧盟能源专家网络安全平台(EECSP)2017年发布的《能源领域的网络安全》20、麻省理工学院2021年的技术评论《用人工智能改变能源产业》21、美国国家可再生能源实验室(NREL)2021年发布的报告《能源系统的人工智能网络安全》22可以提供相关的有益指导。

再如医疗行业,许多医疗设备——从血糖仪、胰岛素泵、心律转复除颤器到智能可穿戴设备、复杂的医疗软件设备以及医疗服务应用——都通过网络连接并经常使用人工智能技术。尽管这些新型联网医疗设备通过减少住院需求、开发个性化疗法和创建智能护理诊断工具,有助于对抗日益增长的医疗成本,但也带来了新的网络安全风险,其互操作性、安全性和复原力被认为很低,网络攻击者可以通过利用设备和软件漏洞来窃取大量患者数据进而帮助实施犯罪。在过去几年,全球各国的监管机构越来越多地将医疗设备网络安全作为一项政策目标,欧盟医疗设备协调小组也于2020年7月发布了第一份关于医疗设备网络安全的指南(MDCG-2019-1623)。目前,欧盟已将医疗部门纳入关键信息基础设施,并制定或正在制定网络安全立法和指令,包括网络安全和隐私风险管理(如GDPR、NIS)、供应链安全(如NIS 2)、医疗保健电子服务的安全认证和访问(如IDAS)以及网络安全认证(如CSA、《AI责任指令》、《欧盟芯片法案》)。同样,相关领域的一些报告如美国国家标准学会2020年发布的《医疗保健中人工智能的定义和特征》24、2020年《国际电联/世界卫生组织人工智能健康重点小组白皮书》以及ENISA在2016年发布的《智能医院——智能健康服务和基础设施的安全和弹性》25也可以提供网络安全良好实践的指导。

3 总结

人工智能如同一架高速行使的列车,列车上的人们既是在迎接也是在探索一个呼啸而来的新时代,一个从蒸汽时代、电气时代、信息时代不断发展而来的智能时代。此刻,列车必须全力行驶以免落后,也必须十分谨慎以求安全,《框架》就是为此而进行的一次有益尝试。其构建了一个由三层实践组成的方案:“与人工智能相关的基本网络安全”“人工智能特定的网络安全”和“特定行业的人工智能网络安全”,分别对各层已有的最佳实践和标准进行了分类和索引,以指导人工智能利益相关者使用这种方式来应对网络安全挑战。总体来看,《框架》是欧盟对人工智能网络安全一次比较系统、务实的总结和规划,主要有以下几个特点。

1. 人工智能网络安全的整体性。《框架》对人工智能网络安全的研究是广义上的,不仅在于防范外部的网络攻击,也包括人工智能系统本身的脆弱性,以及机器学习算法由于偏见、歧视、缺乏可解释性等问题而产生的威胁,因此这一网络安全的概念具有整体性。这从《框架》的目标受益者中也能看出,其包括人工智能设计开发人员、集成商、制造运营商、服务提供商、供应链业务合作伙伴、审计师、立法者、政策制定者、专业用户,以及监督和评估网络安全或人工智能活动的当局、机构和能力中心,从多元利益的角度出发,人工智能网络安全既是相对于运营企业而言的,也是相对于消费者和监管部门而言的。

2. 人工智能网络安全的特殊性。《框架》的主要建议是将人工智能系统的网络安全视为对信息与通信技术安全现有做法的额外努力,在现有的网络安全实践的基础上辅以特定的人工智能的实践,后者主要着眼于应对其动态性和社会技术性。所谓动态性,是指人工智能系统在部署后会继续学习并进化,这意味着漏洞可以在其生命周期的各个阶段被利用,因此风险评估不能是静态的。所谓社会技术性,是指人工智能的网络安全除了受到技术威胁,还涉及社会威胁,例如偏见、歧视、缺乏可解释性、公平性、透明度和可追责性等。因此需要在人工智能系统生命周期中对其进行动态、可测量的风险评估,进行社会威胁的风险管理,以及考虑不同行业的安全环境以现实和准确地减轻部门威胁。

3. 安全层次的递进性。由于人工智能系统由信息和通信技术基础设施托管,因此在《框架》中,利益相关者首先需要落实基本的网络安全实践(第一层)。然后,他们需要关注人工智能系统本身的动态性和社会技术性引起的额外的网络安全挑战,并通过额外的网络安全实践来加以应对(第二层)。最后,考虑到人工智能系统在各个行业的应用特点,需要更具针对性的网络安全实践(第三层)。这种设计类似于成熟度模型理论,只有逐层落实才能达到最好的效果。

4. 安全实践的学科综合性。《框架》注重人工智能安全的跨学科性和部门协作,即需要多种学科方法来开发可靠的人工智能系统以满足社会和人类的需求。为了能够设计、运行、操作、测试和审查以人为中心的人工智能系统,就需要与社会学、心理学、数据科学、计算机科学和网络安全等不同领域的专家进行合作。《框架》第二层中提到的伦理指南、数据伦理白皮书也体现了这一特点。

5. 开放性和国际性。《框架》整合了许多现有的与人工智能网络安全相关的报告、标准、工具和项目,其中既包括欧盟的,也包括美国的,既包括已经颁布的,也包括尚在研究的,这使得其具有开放性和前瞻性。《框架》也认为,应当构建一个人工智能伦理的全球框架,只有基于一个全球公认的伦理框架,才可能为人工智能的安全性和可信度制定通用的可接受的措施和尺度,才能实现人工智能系统真正的安全。

总体上,目前人工智能技术尚在快速发展过程中,很难仅依靠立法来对其网络安全问题进行规定。在这个背景下,《框架》虽然只是一个行动指南,只是对已有标准和准则、方法的整合,但其所体现的发挥各类技术规范、技术标准、技术伦理、行业伦理等软法规范的作用,构建软法与硬法结合的规范体系的理念却无疑是值得借鉴的。

[1] Proposal for a regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence (artificial intelligence act) and amending certain union legislative acts, https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206.

[2] https://www.oecd.org/digital/artificial-intelligence/.

[3] Grosse, K. et al., ‘“Why do so?” – A practical perspective on machine learning security’, Cornell University, 2022, arXiv:2207.05164.

[4] Tabassi, E., Artificial Intelligence Risk Management Framework (AI RMF 1.0), NIST Trustworthy and Responsible AI, National Institute of Standards and Technology, Gaithersburg, MD, 2023, https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf.

[5] See https://www.enisa.europa.eu/topics/threat-risk-management/threats-and-trends.

[6] See https://www.enisa.europa.eu/publications/methodology-for-a-sectoral-cybersecurityassessment.

[7] See https://www.enisa.europa.eu/publications/nlra-analysis-report.

[8] See https://www.enisa.europa.eu/topics/risk-management/current-risk/riskmanagement-inventory/inventory-of-risk-management-risk-assessment-methodsand-tools?v2=1&tab=details.

[9] See https://www.enisa.europa.eu/publications/tsp2-risk.

[10] See https://www.iso.org/standard/54533.html.

[11] For a list of relevant EU projects, see the CORDIS website: https://cordis.europa.eu.

[12] See https://www.iso.org/standard/72891.html.

[13] See https://www.commoncriteriaportal.org/.

[14] See https://www.iso.org/standard/72889.html.

[15] 刘晗,李凯旋,陈仪香:《人工智能系统可信性度量评估研究综述》,载《软件学报》 2023年第8期,3778-3779页。

[16] European Commission, Ethics Guidelines for Trustworthy AI, High-Level Expert Group on Artificial Intelligence, Brussels, 2019, https://digitalstrategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai.

[17] Hasselbalch, G., Kofod Olsen, B. and Tranberg, P., White paper on data ethics in public procurement of AI-based services and solutions, DataEthics.eu, Denmark, 2020, https://dataethics.eu/wp-content/uploads/dataethics-whitepaper-april-2020.pdf.

[18] Shea, T., ‘How brain-inspired technologies can support ethical AI’, LinkedIn post, 2021, https://www.linkedin.com/pulse/how-brain-inspiredtechnologies-can-support-ethical-ai-tim-shea.

[19] https://www.navinfo.eu/services/cybersecurity/guardai/.

[20] ENERGY EXPERT CYBER SECURITY PLATFORM, Cyber Security in the Energy Sector, February 2017, https://energy.ec.europa.eu/system/files/2017-03/eecsp_report_final_0.pdf

[21] MIT Technology Review Insights, Transforming the Energy Industry with AI, 2021, https://assets.siemensenergy.com/siemens/assets/api/uuid:4b6f1e50-6639-4cb9-8a5d-85ac8e29c807/siemensreportv10.pdf?ste_sid=88ed48911b29356753651e2fd4237fae.

[22] Macwan, R., King, R., Artificial Intelligence for Energy Systems Cybersecurity, National Renewable Energy Laboratory, NREL/PR-5R00-81098, 2021,https://www.nrel.gov/docs/fy22osti/81098.pdf.

[23] MDCG 2019-16 Guidance on Cybersecurity for medical devices, 2019, https://ec.europa.eu/docsroom/documents/41863/attachments/1/translations/en/renditions/native.

[24] ANSI, ANSI/CTA-2089.1-2020 – Definitions/characteristics of artificial intelligence in health care, 2020, https://webstore.ansi.org/Standards/ANSI/ANSICTA20892020.

[25] ENISA, Smart Hospitals – Security and resilience for smart health service and infrastructures, 2016, https://www.enisa.europa.eu/publications/cybersecurity-and-resilience-for-smart-hospitals.

撰稿 | 赵赫栋,清华大学智能法治研究院实习生

选题&指导 | 刘云

编辑 | 王欣辰

声明:本文来自清华大学智能法治研究院,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。