作者:中国工商银行软件开发中心大数据和人工智能实验室

量子计算是量子信息科技中的重要领域,作为一种新兴的计算范式,有望在金融市场、生物医药、人工智能、信息安全等多个应用领域取得突破性进展,成为全球瞩目的新兴战略技术焦点。在政府相关政策的引领下,工商银行履行大行担当,积极研究量子计算金融业场景应用,首次将量子图神经网络算法用于债券风控场景,力求突破经典算力约束及算法瓶颈,探索提升金融数据处理能力和智能运算效率的量子技术解决方案,为金融行业量子机器学习的应用创新提供工行思路。

一、量子机器学习算法简介

量子机器学习算法旨在通过量子加速来提升并发性,提高模型训练效率。量子加速(Quantum Speedup)是指在处理某些问题的时候,量子机器学习算法比已知最快的经典机器学习算法计算得更快,达到量子计算加速的效果。例如,量子Grover算法所需的时间为 ,而经典算法则需

,而经典算法则需 的时间。量子机器学习作为量子计算的重要研究方向之一,其发展主要有两个阶段。第一阶段被称为“通用量子机器学习阶段”,Harrow等人在2009年首先提出的HHL(Harrow,Hassidim,Lyold)算法是一种基于量子相位估计的量子线性方程求解算法,实现了指数级的求解加速,有效缓解大规模输入数据的存储和处理问题。此后,学术界基于HHL算法衍生出较大规模的量子机器学习模型,典型代表有量子支持向量机、量子K-means方法、量子最近邻方法(QKNN)以及量子主成分分析方法(QPCA)等。然而,基于HHL算法的量子机器学习模型很难在目前的有噪中规量子(Noisy intermediate-scale quantum)计算机的低计算精准度下展现量子计算的相关优势。于是,有望在有噪中规量子计算机设备上运行的变分量子算法逐渐走入人们的视野,并进入第二阶段。变分量子算法首次由Peruzzo1等人在2014年提出,并在2018年由谷歌团队实现对手写字符图像的识别,随着变分量子算法的不断演进,已经出现了量子神经网络、量子长短期记忆网络、量子对抗生成网络等量子机器学习模型(见表1)。

的时间。量子机器学习作为量子计算的重要研究方向之一,其发展主要有两个阶段。第一阶段被称为“通用量子机器学习阶段”,Harrow等人在2009年首先提出的HHL(Harrow,Hassidim,Lyold)算法是一种基于量子相位估计的量子线性方程求解算法,实现了指数级的求解加速,有效缓解大规模输入数据的存储和处理问题。此后,学术界基于HHL算法衍生出较大规模的量子机器学习模型,典型代表有量子支持向量机、量子K-means方法、量子最近邻方法(QKNN)以及量子主成分分析方法(QPCA)等。然而,基于HHL算法的量子机器学习模型很难在目前的有噪中规量子(Noisy intermediate-scale quantum)计算机的低计算精准度下展现量子计算的相关优势。于是,有望在有噪中规量子计算机设备上运行的变分量子算法逐渐走入人们的视野,并进入第二阶段。变分量子算法首次由Peruzzo1等人在2014年提出,并在2018年由谷歌团队实现对手写字符图像的识别,随着变分量子算法的不断演进,已经出现了量子神经网络、量子长短期记忆网络、量子对抗生成网络等量子机器学习模型(见表1)。

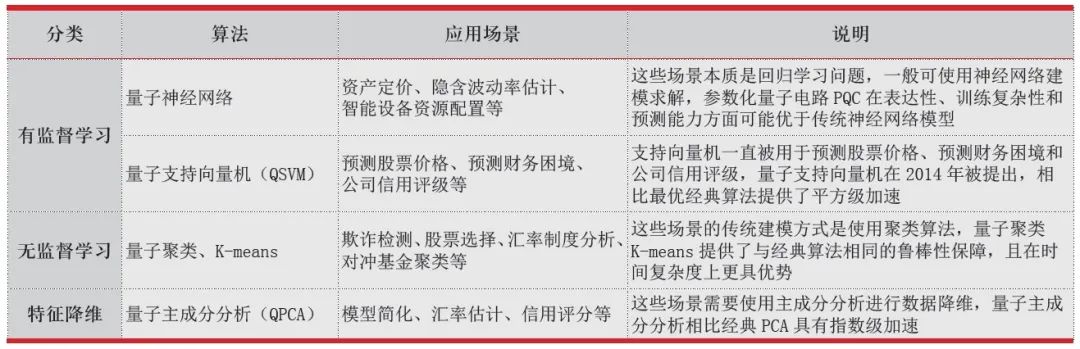

表1 量子机器学习算法及金融场景应用

二、工商银行量子图神经网络算法

应用研究

在债券违约、信贷逾期等风险防控场景中,企业图谱样本往往存在数据庞大、关系隐秘、交叉整合困难的情况。为准确发现企业的风险事件对关联企业的影响,及时定位风险传染路径,识别潜在违约企业,金融机构一般采用传统的图神经网络模型对企业债券、股票、信贷等业务信息进行建模,绘制风险传导的关系图谱,挖掘客户、业务间风险传染途径。然而,传统的图神经网络在建模和分析时,参数规模会随输入样本数量、特征维度的增大而呈线性增长,导致模型训练所需时间和资源消耗难以保障。因此,工商银行开展的研究创新采用量子图神经网络算法弥补传统图神经网络算法存在的缺陷。具体思路如下:训练时,编码器先对输入向量进行映射,得到编码后的向量;解码器再对编码后的向量进行映射,得到重构后的向量,它是对输入向量的近似;编码器和解码器应同时训练,训练目标是最小化重构误差。

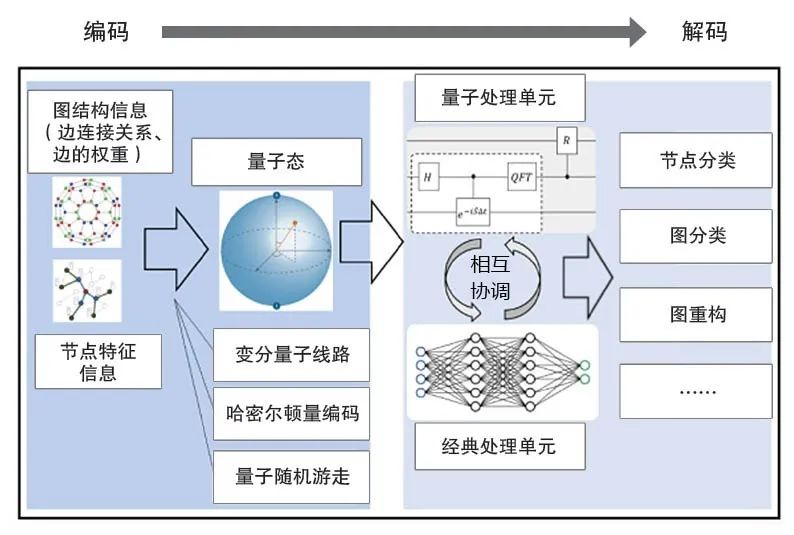

以基于经典图结构的输入数据为例,量子机器学习算法原理主要由“编码”和“解码”两大部分构成(如图1所示),一是编码阶段,基于变分量子线路、哈密尔顿量或量子随机游走的方式将经典数据编码到量子态中,通过经典预处理的方式将图的结构信息融合到节点特征内,进而使用变分量子门将节点特征编码到量子态中;二是解码阶段,使用量子神经网络、量子支持向量机等特定的量子处理单元对量子态进行处理。通过量子处理单元的处理、量子测量以及经典处理单元的后处理,整个图量子机器学习模型可以实现端到端的节点分类任务、图分类任务、图重构等。在输入端,理论上图量子机器学习模型可以使用更少的存储单元(量子比特)去编码大规模图结构信息,在处理端,量子处理单元由于其强大的高维空间表征能力,可以在减少模型参数规模的同时不显著影响模型的最终效果。

图1 基于经典图结构数据的量子机器学习算法原理示意

本方案通过聚焦量子图神经网络方法来打破传统图神经网络方法在处理大规模数据时面临的计算瓶颈,为银行有效预警潜在风险企业提供快速决策依据。本方案选取2022年企业债券数据集,并划分为训练集和测试集,正负样本分别为违约型企业和正常运营企业。具体建模步骤如下:

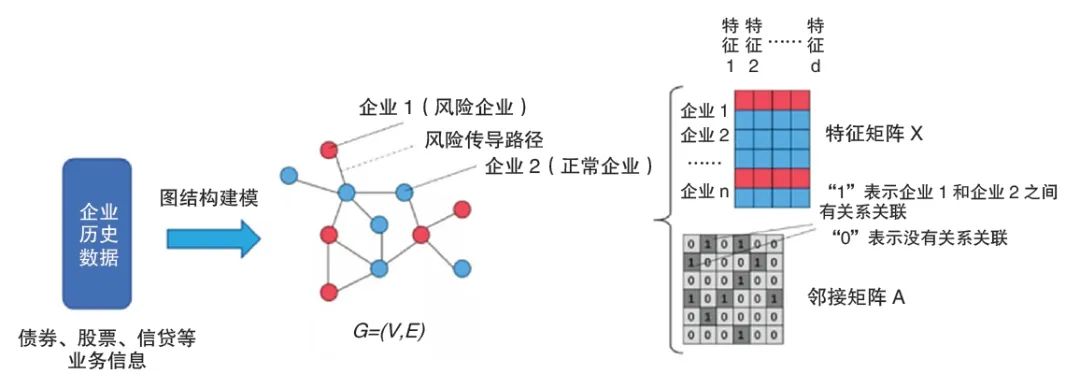

1.图结构数据建模

在实际的企业债券违约风险预警场景数据中,可以将风险传播路径抽象为图结构数据中的“边”,企业实体抽象为图结构数据中的“节点”,且每个节点均拥有一个特征向量,该特征向量表示该企业的历史业务数据信息(如图2所示),其中,原始数据将被建模为表示企业特征的特征矩阵X、表示企业间关联关系的邻接矩阵A。

图2 企业历史业务数据的图结构建模

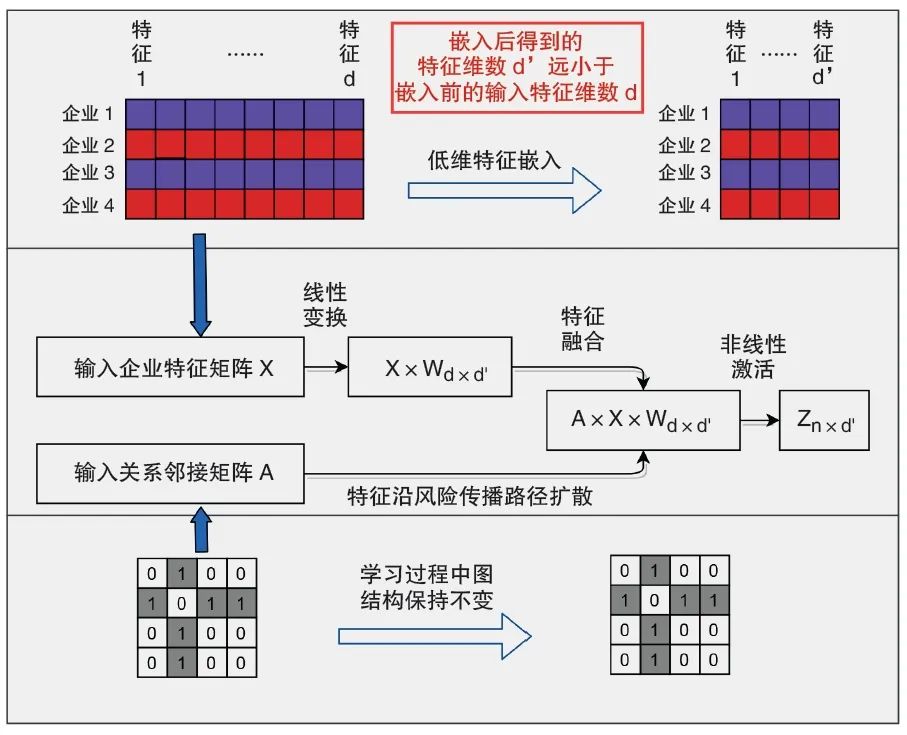

2.图表示学习模型建模

该场景关键创新是将图数据转化用于现有的量子机器学习算法,首次将训练的量子计算模型应用于金融场景,基于模拟软件实现场景试点和验证,而非实际的量子计算环境。以特征矩阵X和邻接矩阵A作为输入,能够自动地为每个企业实体分配一个低维向量表示,该向量包含该企业的原始特征信息及以该实体为参照的区域性结构信息。其次,设计含参的线性变换单元和特征融合单元来处理输入数据,根据图建模过程中的风险传播路径提取企业之间业务流动态特征信息,其中使用了权重矩阵W将特征维度维降。最后,通过非线性激活单元得到最终的企业特征矩阵Z,以增强模型的表达能力。图表示学习模型设计思路如图3所示。

图3 图表示学习模型设计思路

3.量子神经网络模型建模

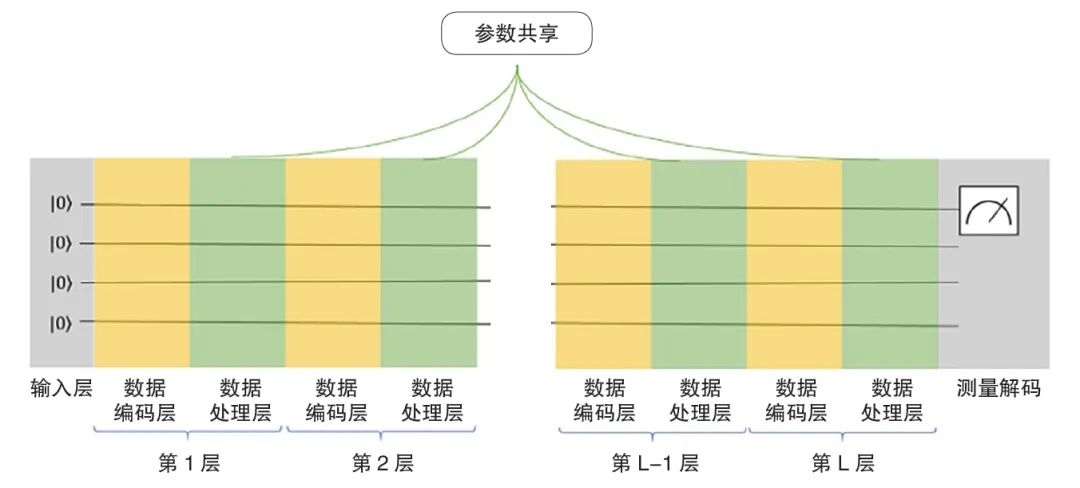

在实际量子计算环境中,一个量子态在温度、光线、射线等环境噪声影响下会出现退相干问题(一个量子态在温度、光线、射线等环境噪声影响下变成一个非相干态,造成量子系统测量的脆弱性。量子退相干是个连续过程),使量子携带的信息丢失,导致量子计算执行失败。一般情况下,量子退相干时间为几百毫秒,因此要求一次量子执行的时间尽可能控制在较短的时间内。为缓解量子退相干问题,本次研究提出通过在每层量子神经网络中采用先编码再处理的方法提取数据特征,以缩短量子路线的时间,降低量子退相干问题的出现频度。此外,本次研究还通过量子门参数复用方式减少网络参数数量,进一步提高模型的深度,提升网络拟合输入输出函数的能力,其结构如图4所示。

图4 量子神经网络结构示意

笔者团队基于量子模拟器环境开展相关实验,实验结果发现,与传统图神经网络模型相比,量子神经网络召回率与其持平,但参数规模却下降为传统图神经网络的54%。在不显著影响模型实际表现的情况下,量子图深度学习算法的参数数量显著减少,能够极大降低梯度计算和梯度传播过程的总运算量。参数量减少有助于降低对训练数据的需求量,在较少数据量情况下避免模型过拟合问题。

工商银行立足业务实践,面向智能风控债券违约预警的典型场景,首创性地训练一种量子图表示学习模型来捕捉图结构数据复杂样本间的关联关系信息,在量子模拟器环境下验证了算法和模型的有效性,并论证了相对于传统算法的优越性,为金融行业量子机器学习的创新研究提供了工行思路。

本文刊于《中国金融电脑》2024年第3期

声明:本文来自中国金融电脑,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。