蛇年已至,OpenKG衷心感谢大家的信任与支持。过去一年,我们一同见证了开源和知识图谱的力量。新的一年,愿你继续关注和支持OpenKG社区,巳巳如意,助力知识增强大模型,开启更加精彩的旅程!

导读

OpenKG新开设“TOC专家谈”栏目,推送OpenKG TOC(技术监督委员会)专家成员的观点文章。本期邀请到同济大学王昊奋特聘研究员介绍大模型时代的知识图谱年度进展报告,本文整理自王昊奋老师在“OpenKG年会”上的分享。

本报告深入梳理了2024年大模型与知识图谱协同发展的显著成果。大模型以其卓越的理解生成能力、少样本学习及泛化优势,助力知识图谱在抽取与推理环节突破瓶颈,显著提升知识图谱的准确性和全面性,解决了信息挖掘不充分、推理能力有限等问题。知识图谱则凭借结构化信息与严谨逻辑推理,增强大模型在问答和规划任务中的表现,提高模型可解释性,降低幻觉等错误,弥补慢思考和规划不足。神经符号迭代交互的探索,为二者深度融合与推理能力提升开辟新途径。报告还盘点了OpenKG在数据、模型、工具方面的积累,并预测知识图谱和大模型在2025年及未来深度融合的发展趋势。

大模型时代的知识图谱技术进展

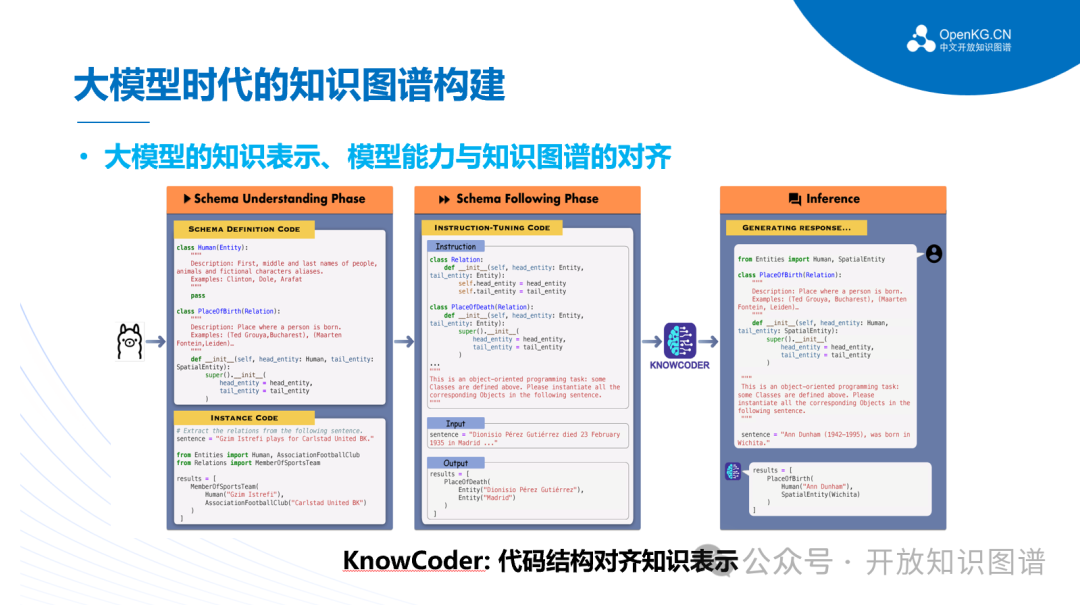

在知识图谱构建方面,中国科学院计算技术研究所网络数据科学与技术重点实验室研发了知码大模型(KnowCoder)。该模型利用形式化编程语言统一表示结构化知识,实现了符号化知识图谱与神经网络大模型的完美结合,从而在统一知识抽取方面取得了突破,大大提升了知识抽取的精确度与泛化性。

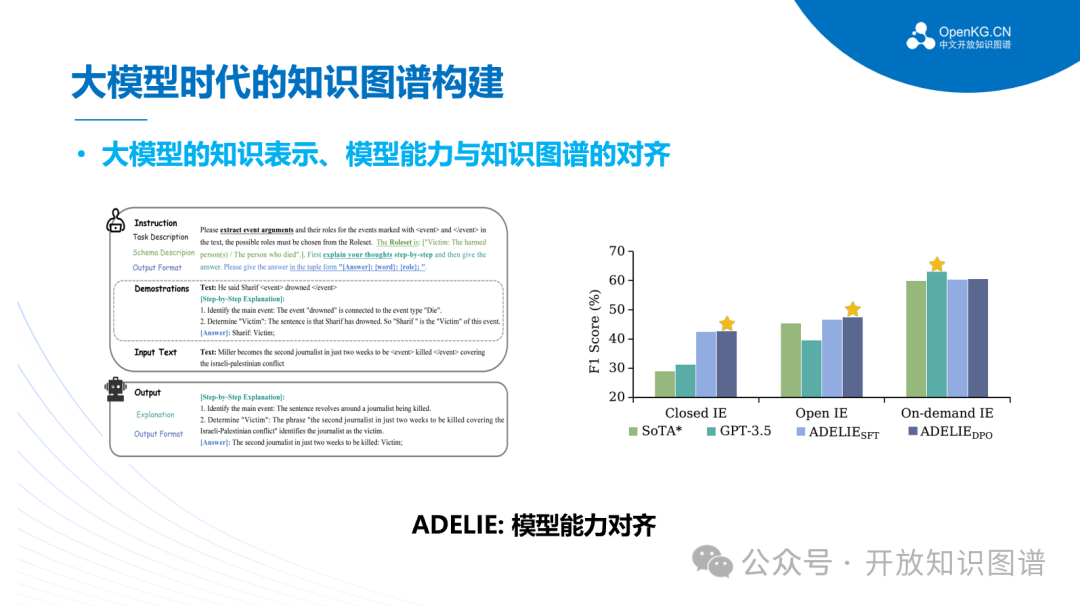

针对大型语言模型在信息提取任务上难以应对复杂指令的问题,清华大学提出了ADELIE,通过利用包含83,000多个实例的专业数据集IEInstruct,并结合监督微调和直接偏好优化(DPO)策略,增强大型语言模型在信息抽取任务上的性能,使其在封闭式和开放式信息抽取任务中均取得显著成果。

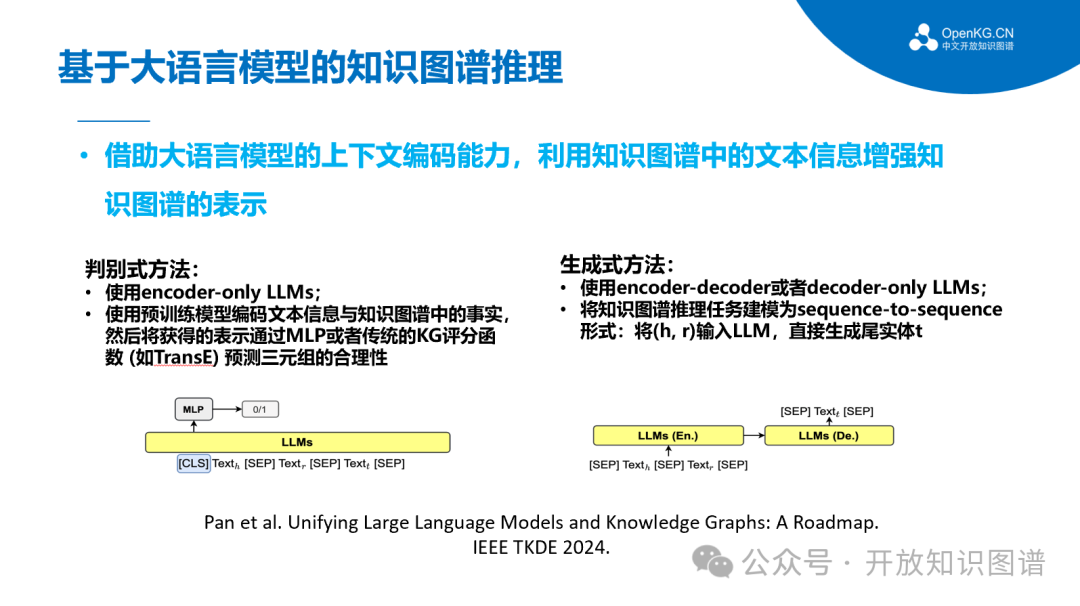

在大模型推理方面,来自澳大利亚格里菲斯大学等机构的学者在综述中以知识图谱的补全作为经典的推理任务,给出了LLM作为编码器和LLM作为生成器两种大语言模型增强知识图谱推理的方式。

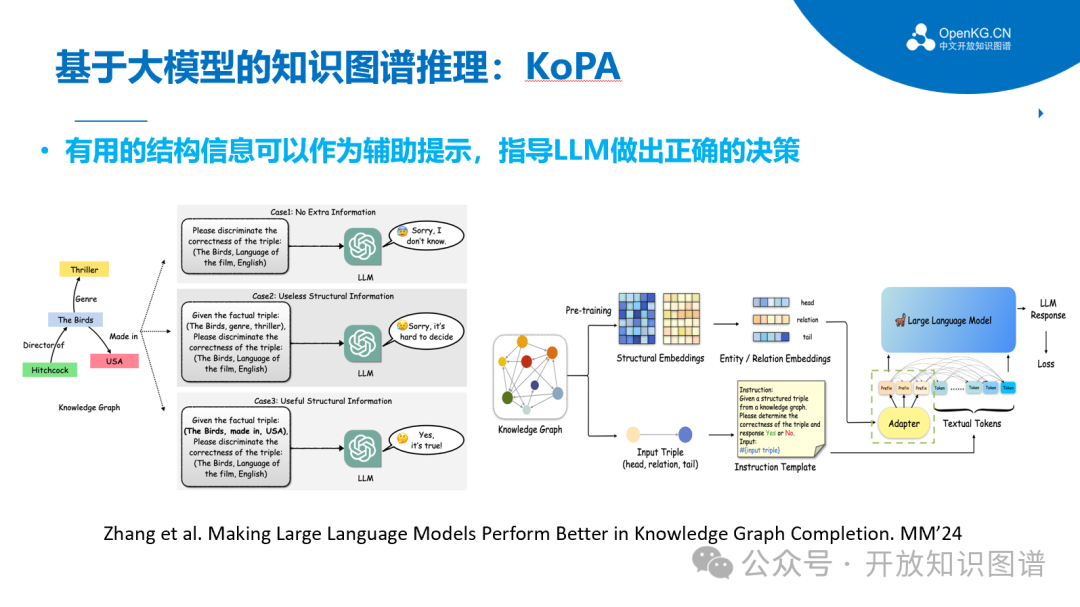

同样在知识图谱补全任务上,浙江大学团队针对现有的LLM方法没有充分利用KG中重要的结构信息,提出知识前缀适配器(KoPA)来实现结构感知推理。KoPA通过预训练理解KG中的实体和关系,并将其表示为结构嵌入向量。然后,KoPA通过知识前缀适配器将这些跨模态结构信息传递给LLM,使其在文本空间中投影并获得虚拟的知识标记作为输入提示的前缀。实验结果表明引入跨模态结构信息可以显著提高LLM的事实推理能力。

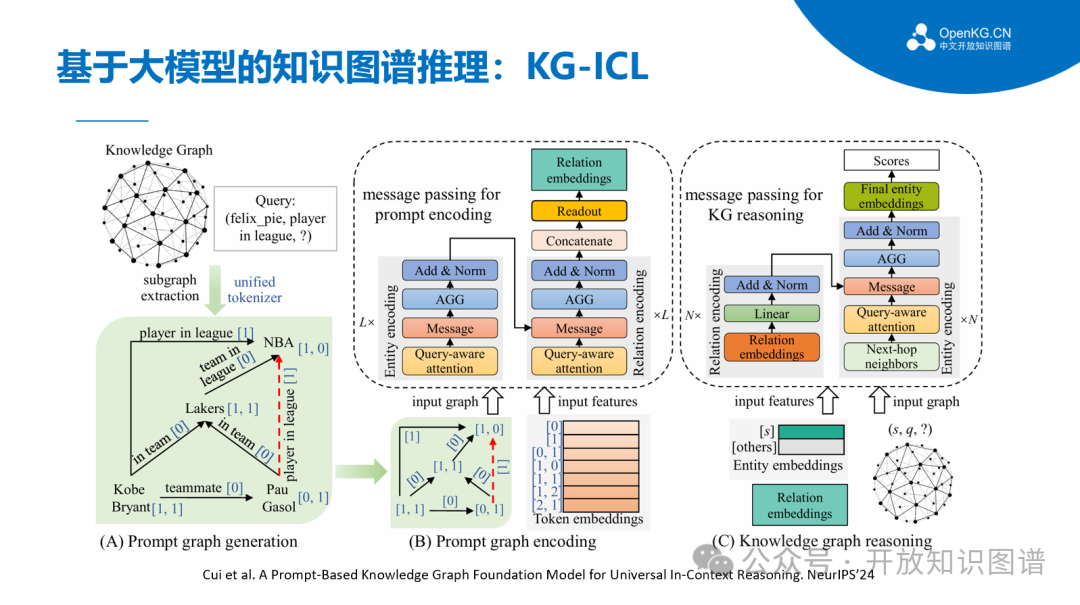

此外,现实世界的知识图谱是动态变化的,然而现有方法大多针对静态图谱,无法有效应对图谱的更新与变化。为此,南京大学团队提出了一种基于上下文提示的通用推理模型KG-ICL,该模型基于与查询关系相关的提示图(prompt graph)及其编码生成关系的提示向量,并利用提示向量初始化知识图谱中的实体和关系向量,从而避免了对特定实体和关系相关参数的依赖,实现了对新实体、新关系,甚至新图谱的通用泛化。与传统方法相比,KG-ICL 不需要为每个新的知识图谱重新训练,实现了图谱级的强泛化。

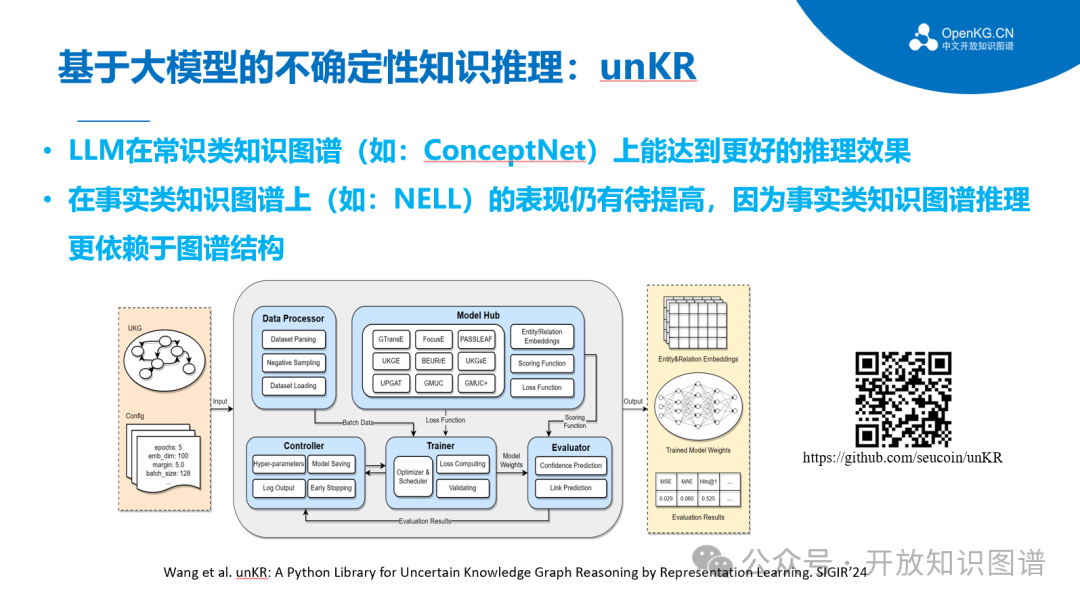

在不确定知识推理方面,东南大学团队发布了国际首个专注于不确定性知识图谱推理的开源工具unKR。它使用一套统一的框架复现了9种广受认可的不确定性知识图谱表示学习与推理模型,通过模块化架构设计提供自定义功能,使得研究人员和开发者能够灵活地调整、优化、开发模型,以适应特定的应用场景或研究需求,并面向多个基准数据集构建统一的评估体系,展现了优异的兼容性与扩展性。

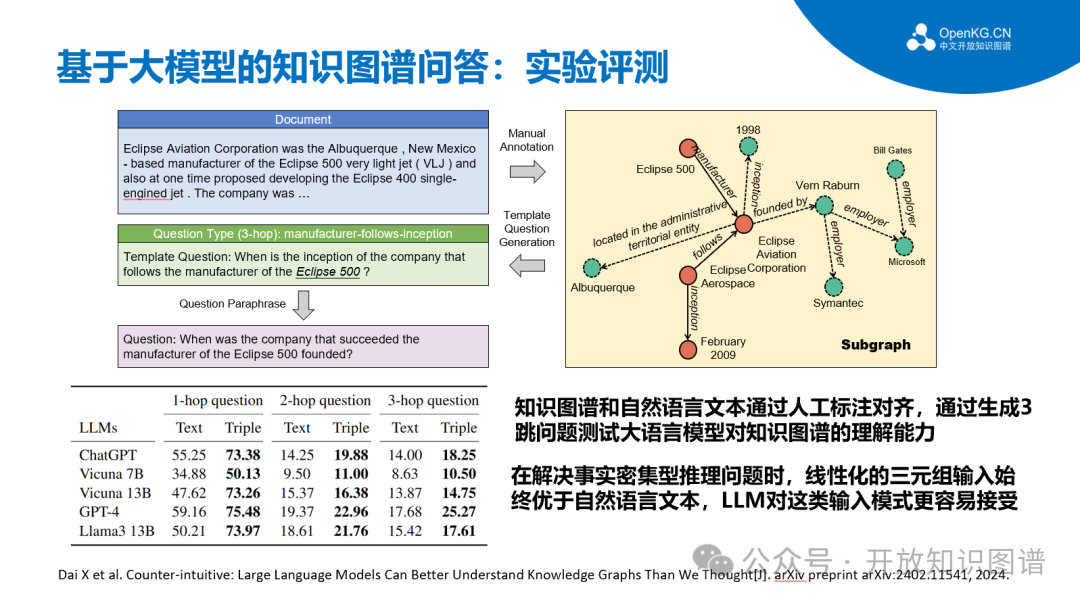

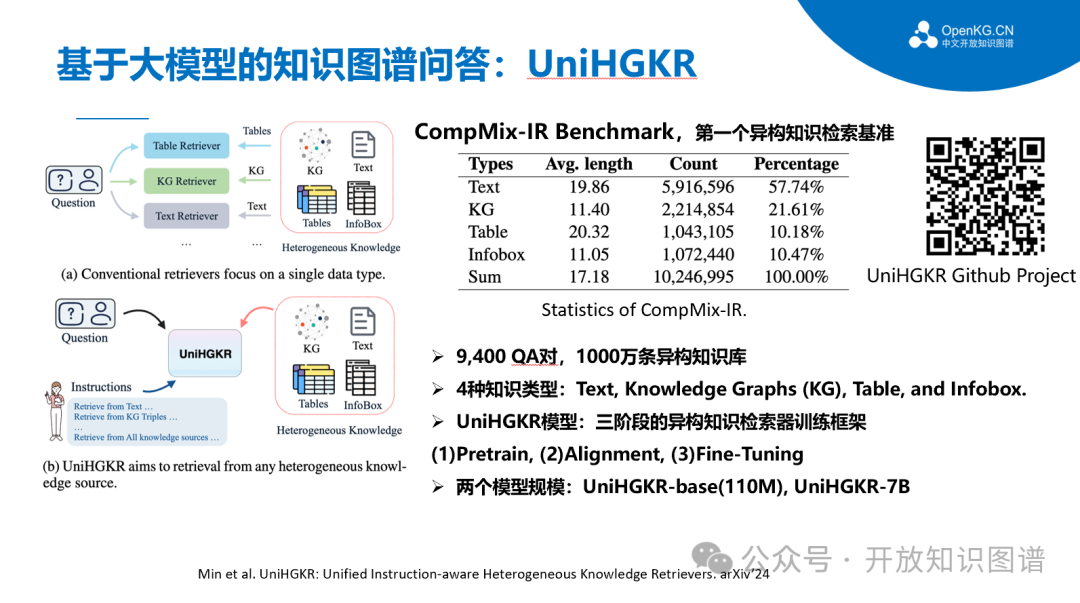

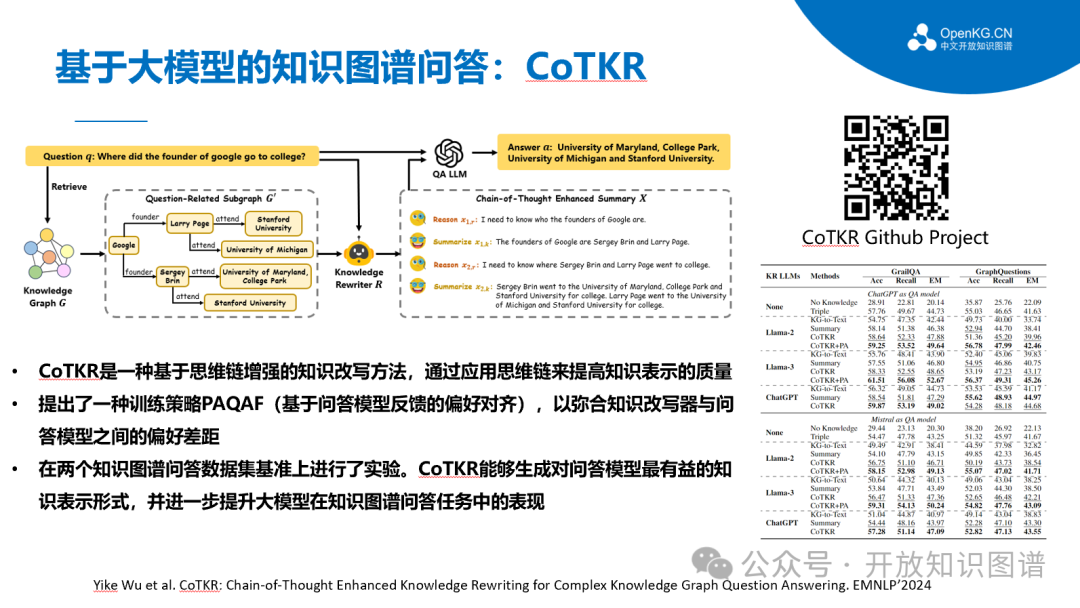

在知识图谱问答方面,针对通过检索增强将LLM应用用知识图谱问答场景时处理复杂问题的不足,东南大学团队增强思维链的知识改写模型(Chain-of-Thought Enhanced Knowledge Rewriting, CoTKR),该方法交替生成推理路径和相应知识,从而克服了单步知识改写的限制。此外,为了弥合知识改写器和问答(Question Answering, QA)模型之间的偏好差异,CoTKR采取了一种新的训练策略,即从问答反馈中对齐偏好(Preference Alignment from Question Answering Feedback, PAQAF),通过利用QA模型的反馈进一步优化知识改写器。实验结果表明,与以往的知识改写方法相比,CoTKR为QA模型生成了最有益的知识表征,显著提高了LLMs在KGQA中的性能。

知识图谱赋能大模型

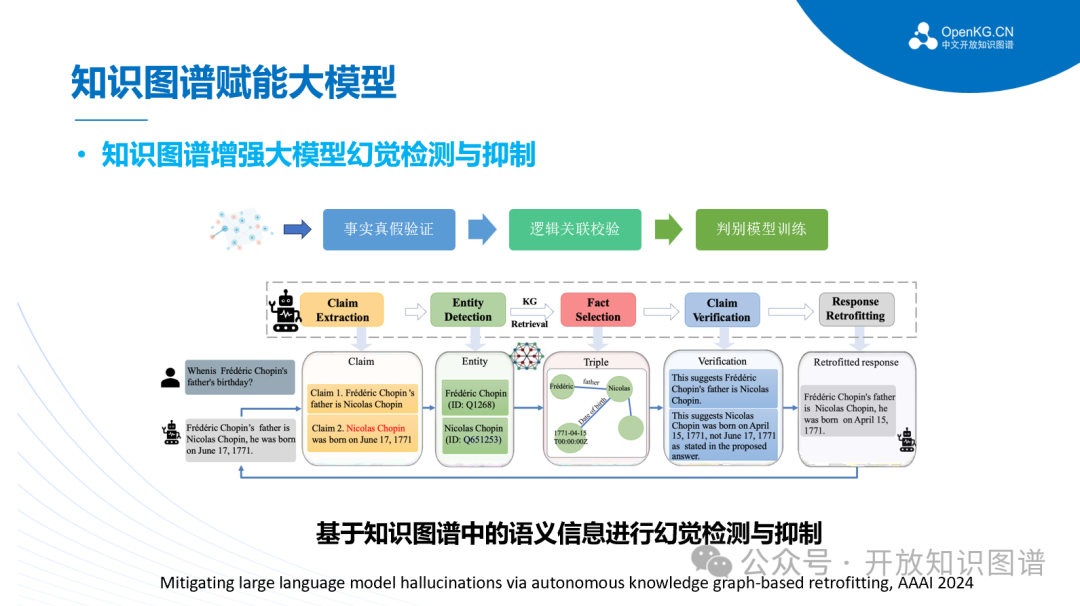

在知识图谱赋能大模型方面主要集中在幻觉的检测与抑制。现有方法通常仅使用用户的输入来查询知识图谱,无法解决LLM在推理过程中产生的事实幻觉。为了解决这个问题,中科院软件所团队提出了一种新框架KGR,利用LLM在模型生成的响应中提取、选择、验证和改进事实陈述,从而实现自主知识验证和提炼过程,无需任何额外的手动操作。实验表明,KGR 可以显著提高LLM 在事实 QA基准上的表现,尤其是在涉及复杂推理过程时,这证明了KGR 在减轻幻觉和增强 LLM 可靠性方面的必要性和有效性。

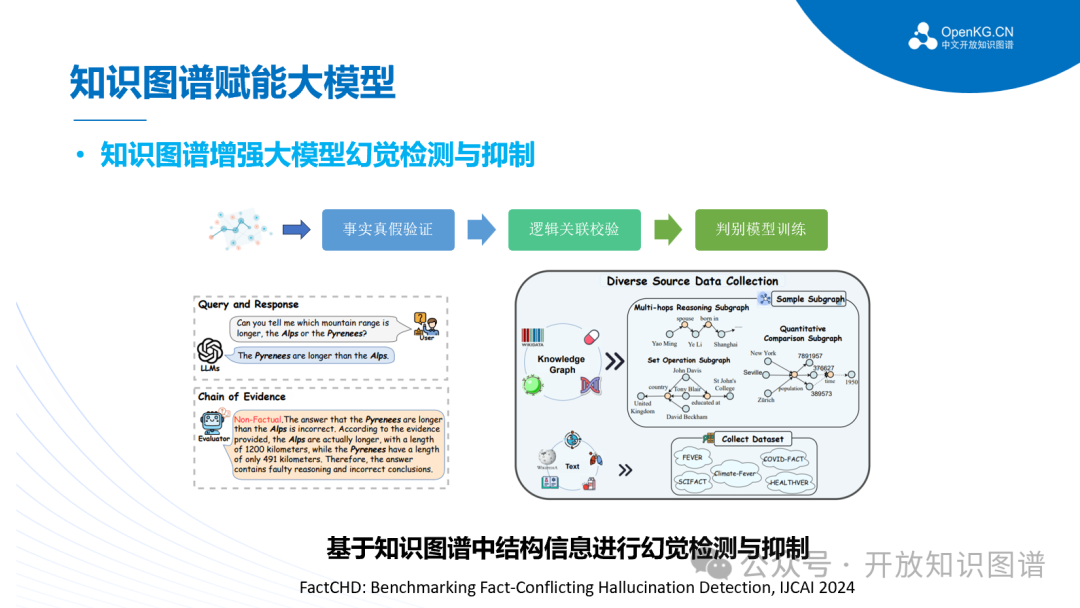

此外,大型语言模型在网络平台上产生的事实冲突型幻觉(fact-conflicting hallucination)限制了它们的应用范围,尤其是在金融、医疗和法律等关键领域。为了缓解这一问题,浙江大学团队提出了一个名为FACTCHD 的事实冲突幻觉检测基准,以评估检测器在LLMs 的"查询-响应"环境中评估事实性的能。FACTCHD 集成了多个领域的事实性知识,涵盖了广泛的事实性模式,如原始事实、多跳推理、比较和集合操作模式。其特点在于不仅仅是对幻觉进行标记,还结合了基于事实的证据链,即当预测一个声明的事实性或非事实性时,需提供有说服力的理由。

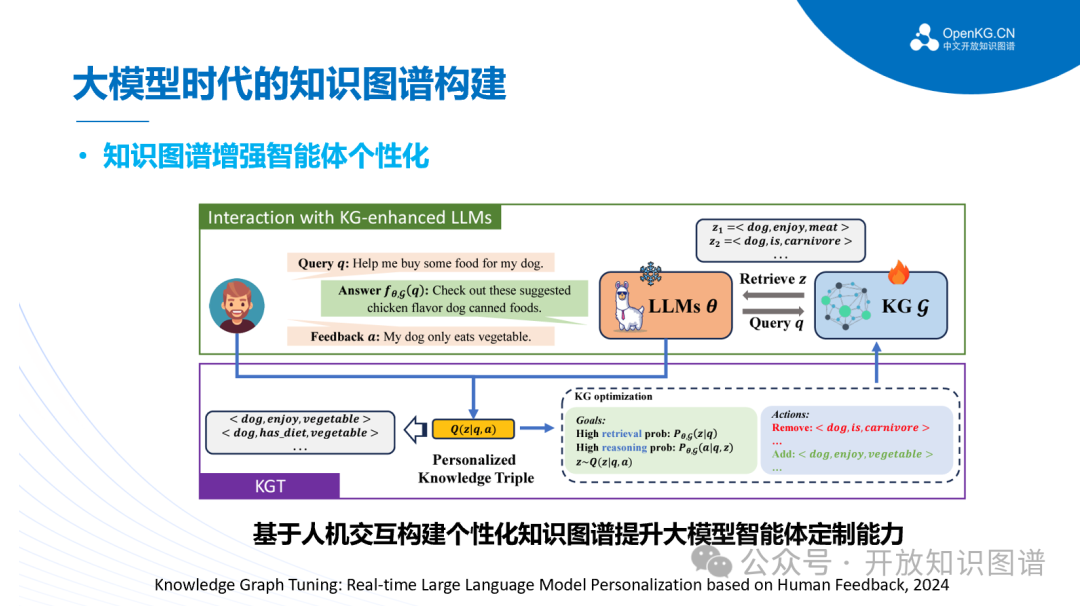

在基于大语言模型的智能体方面,浙江大学团队提出了一个基于LLM的自治Agents定制平台,该平台是一个开源库,旨在让非专业人士能够构建、定制、测试、调整和部署最先进的自主语言代理,支持规划、记忆、工具使用、多代理通信和细粒度符号控制等重要功能。

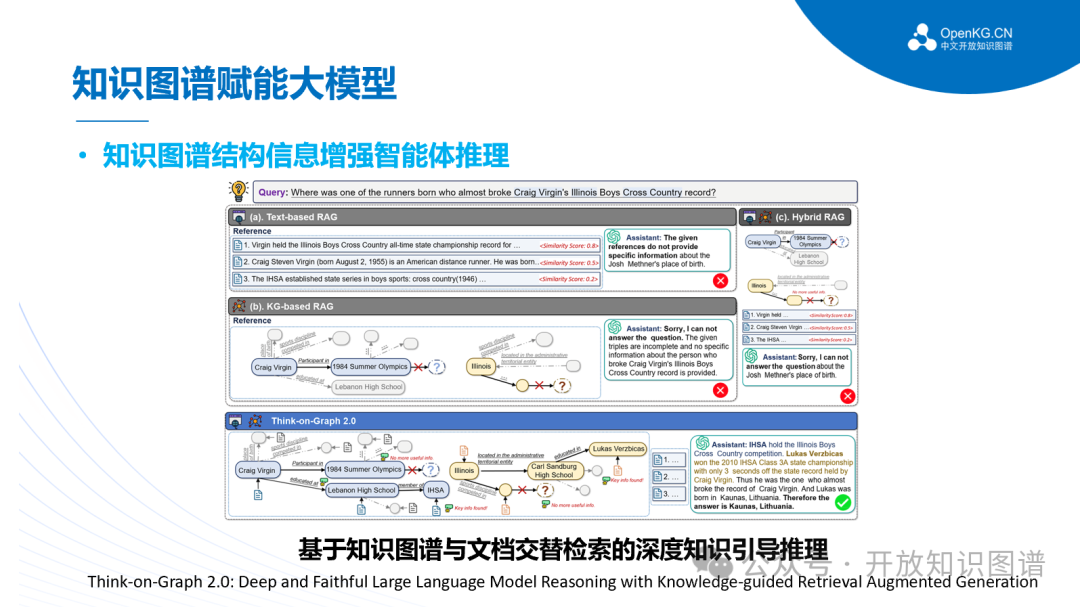

在智能体推理方面,Think-on-Graph 2.0 (ToG-2)是一种改进的检索增强生成(RAG)框架。ToG-2通过结合非结构化和结构化知识源,采用紧密耦合的检索策略,提升了大型语言模型(LLMs)在复杂推理任务中的表现。具体而言,ToG-2利用知识图谱(KG)来增强上下文检索,并与图谱检索交替进行,从而实现了更加深入和准确的推理。实验结果表明,ToG-2在多个数据集上取得了最先进的表现,且无需额外训练,能够与不同的LLM兼容。

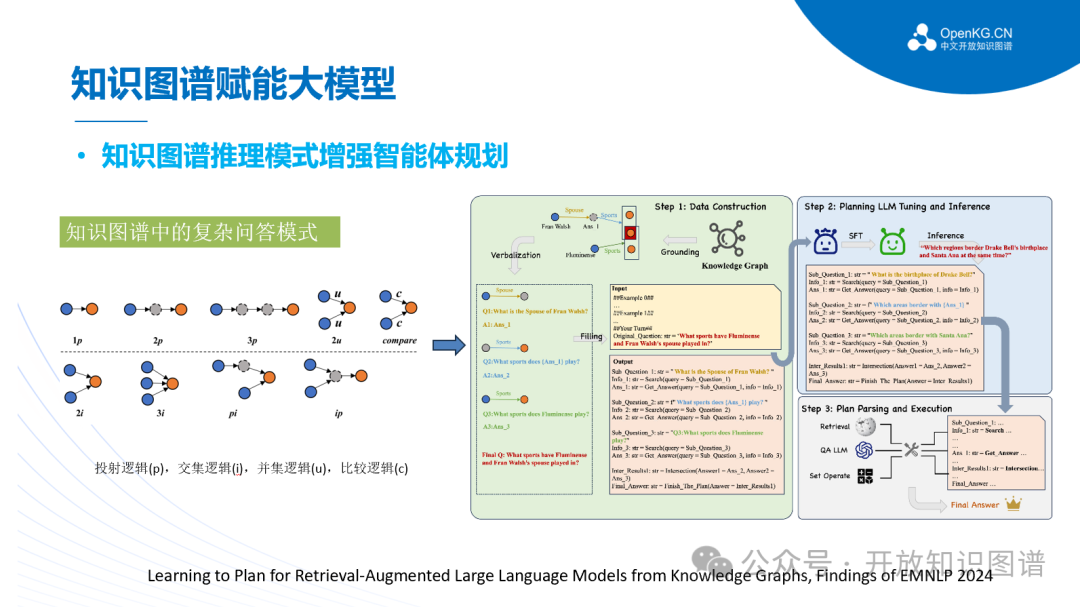

浙江大学团队进一步探索了如何让语言模型从知识图谱中习得复杂问题的规划能力,设计了名为LPKG的框架,利用知识图谱中丰富的子图Pattern构建了丰富且正确的规划训练数据,并由此训练大语言模型使其能在下游问题上推理得到更为准确的规划过程,最后将规划过程进行解析和执行从而得到最终答案,并且为社区贡献了一个名为CLQA-Wiki的全新复杂问答数据集。

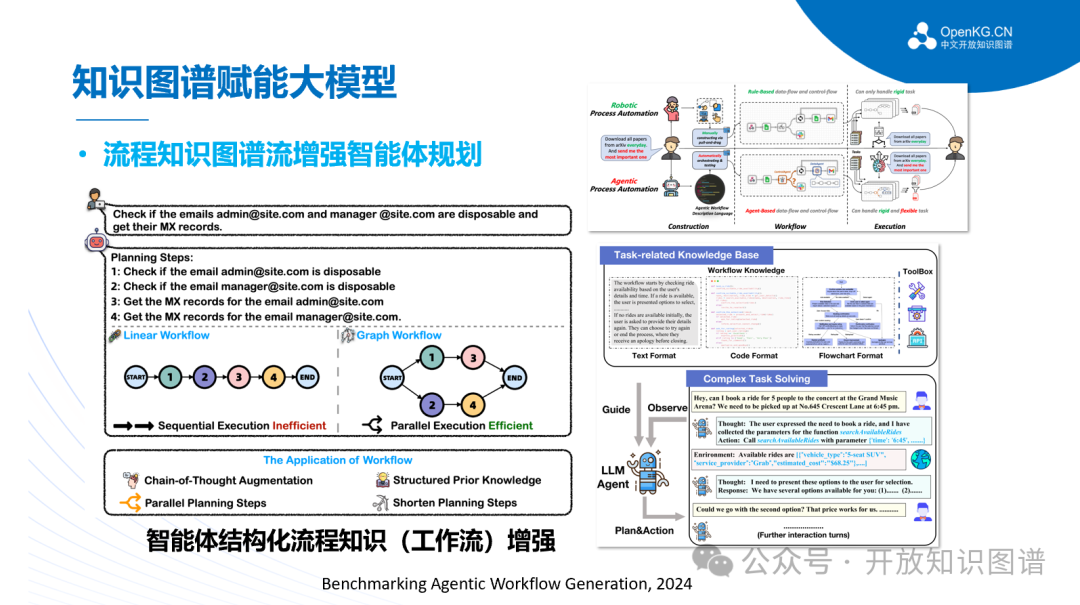

在智能体工作流方面,浙江大学团队提出了大模型智能体workflow生成基准WorfBench,面向多个大模型推理和规划场景,将复杂智能体规划建模为图结构,同时提出评测指标WorfEval,用于复杂图结构的workflow的评估。

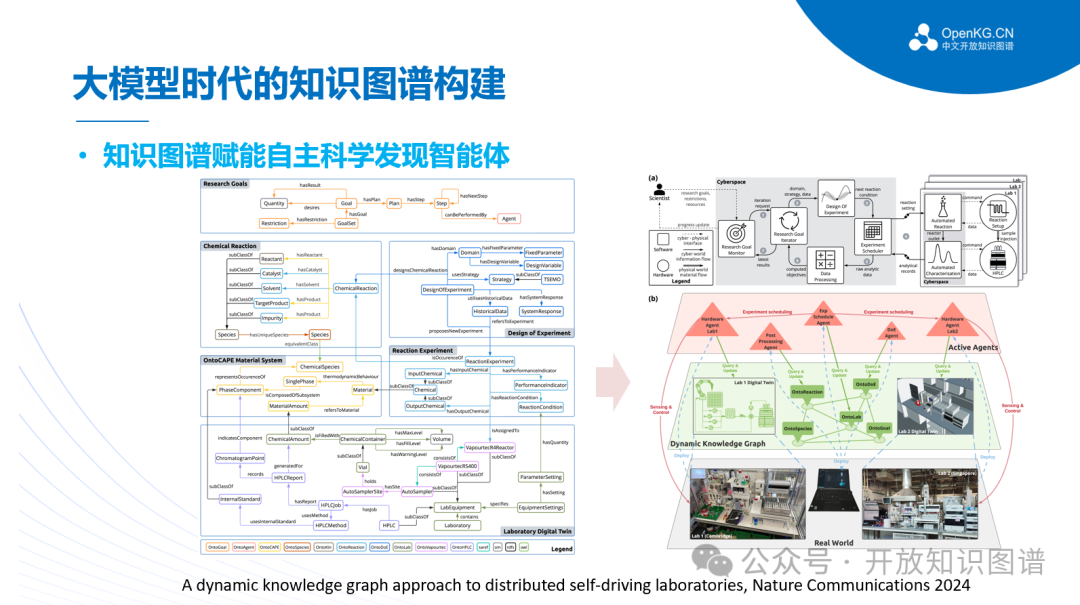

值得一提的是,在跨学科跨地域的科学研究方面,,来自剑桥大学的研究团队及其合作者,成功利用自主实验室 +数字孪生 +知识图谱这一方法实现了两个分别位于新加坡和英国的自主实验室的远程合作(相隔10800公里),打破了传统实验室的地理和合作限制,为未来科学研究提供了数字化、智能化的崭新范式。研究团队表示,这一方法或许有助于通过增加世界不同地区实验室之间数据和材料流动(迄今仍有相当困难),提高某些类型研究的效率。

神经符号协同与交互

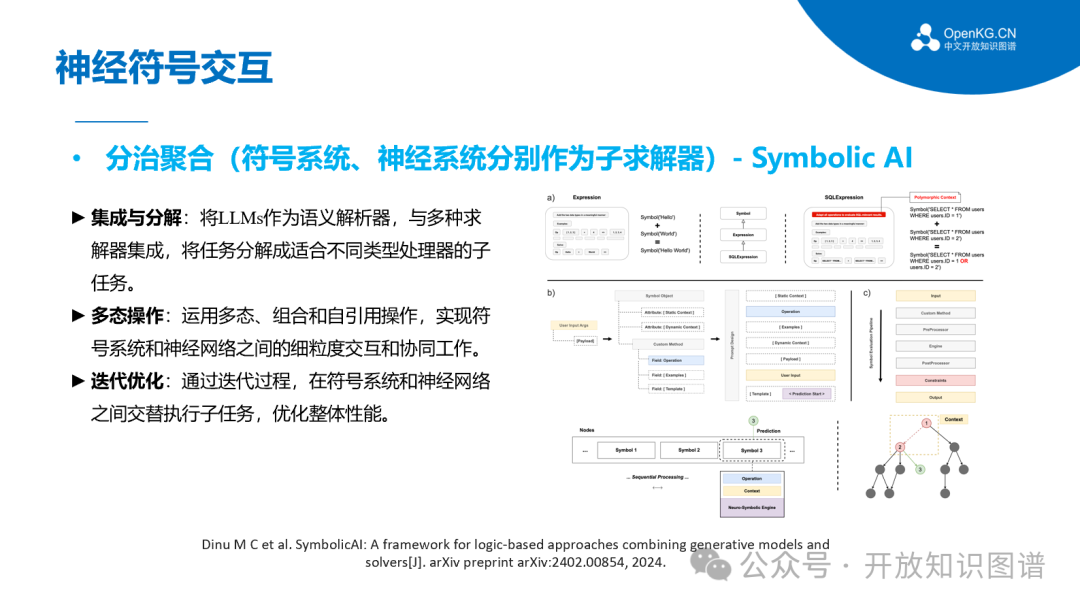

在神经符号协同与交互方面,代表性的工作是Symbolic AI,其核心思想是符号系统、神经系统分别作为子求解器,通过将LLMs与逻辑操作结合,提供更可靠的生成结果。具体来说,SymbolicAI通过上下文学习操作(由函数原语实现)增强了LLMs的生成过程,使其能够创建多样化的应用。这些操作引入了基于逻辑的组件,指导生成过程并构建了一个模块化的(Neuro-Symbolic,NeSy)系统。该系统包含各种现有的求解器、用于数学表达式评估的形式语言引擎、定理证明器、知识库,以及用于信息检索的搜索引擎。SymbolicAI将这些求解器作为构建计算图的基本单元,桥接了传统编程和可微分编程的范式,旨在创建领域无关的问题求解器。

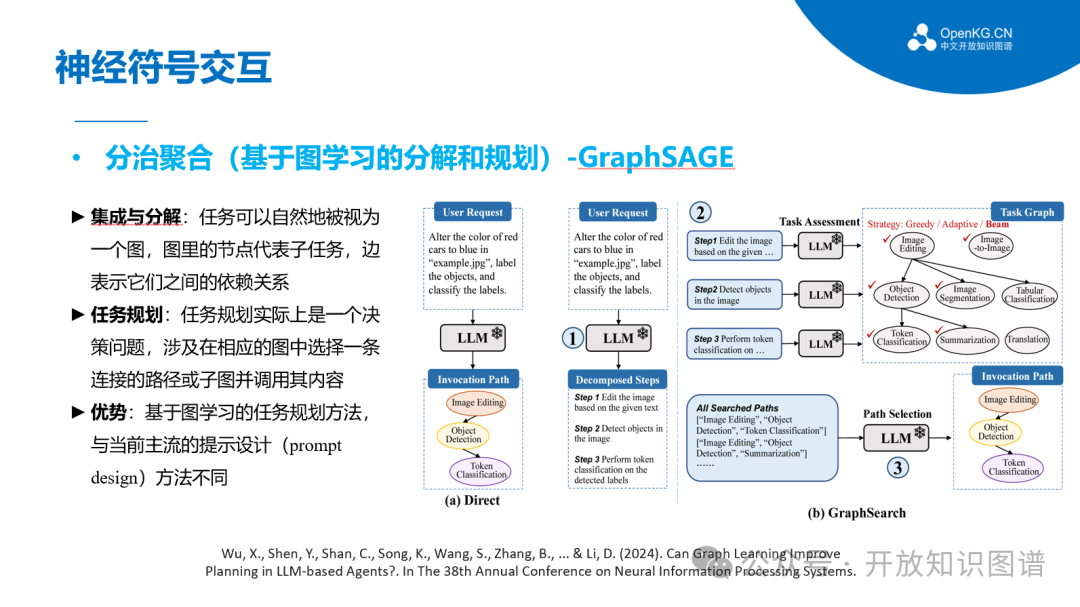

另一代表性的工作是GraphSAGE,其主要解决的问题是基于大型语言模型的任务规划。其中,任务规划旨在将复杂的用户自然语言请求分解为可解决的子任务,从而完成原始请求。在这一问题设定背景下,子任务可以自然地被视为一个图,其中节点代表子任务,边表示它们之间的依赖关系。因此,任务规划实际上是一个决策问题,涉及在相应的图中选择一条连接的路径或子图并调用其内容。GraphSAGE本质是一种基于图学习的任务规划方法,与当前主流的提示设计(prompt design)方法有很大不同。

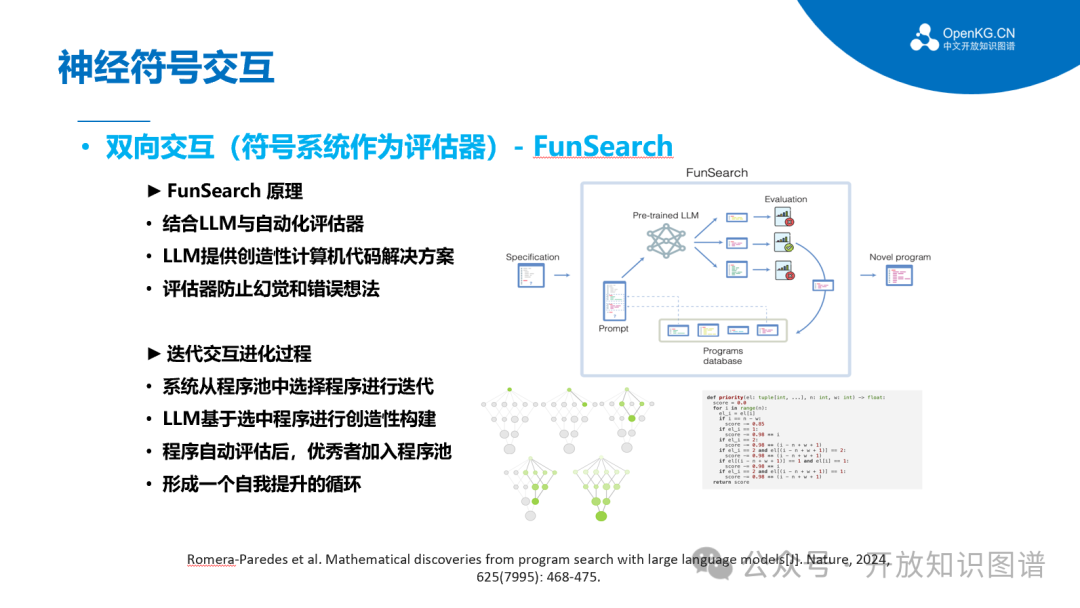

另一类神经符号协同交互的方式是符号系统作为评估器,FunSearch是一种典型的基于将预训练的LLM与系统化评估器相结合的,研究人员将FunSearch应用于极值组合数学中的一个核心问题——帽子集问题,在此过程中FunSearch发现了大帽子集的新构造,超越了已知的最佳结果,包括有限维和渐进情况下的构造。这表明使用LLMs可以在已有的开放性问题上取得新发现。同时FunSearch被应用于一个算法问题——在线装箱问题,发现了改进广泛使用基线的全新启发式算法。与大多数计算机搜索方法不同,FunSearch搜索的是描述如何解决问题的程序,而不是问题的具体解答。除了是一种有效且可扩展的策略之外,FunSearch发现的程序相比于原始解答通常更易解释,从而支持领域专家与FunSearch之间的反馈循环,并能够将这些程序部署到实际应用中。

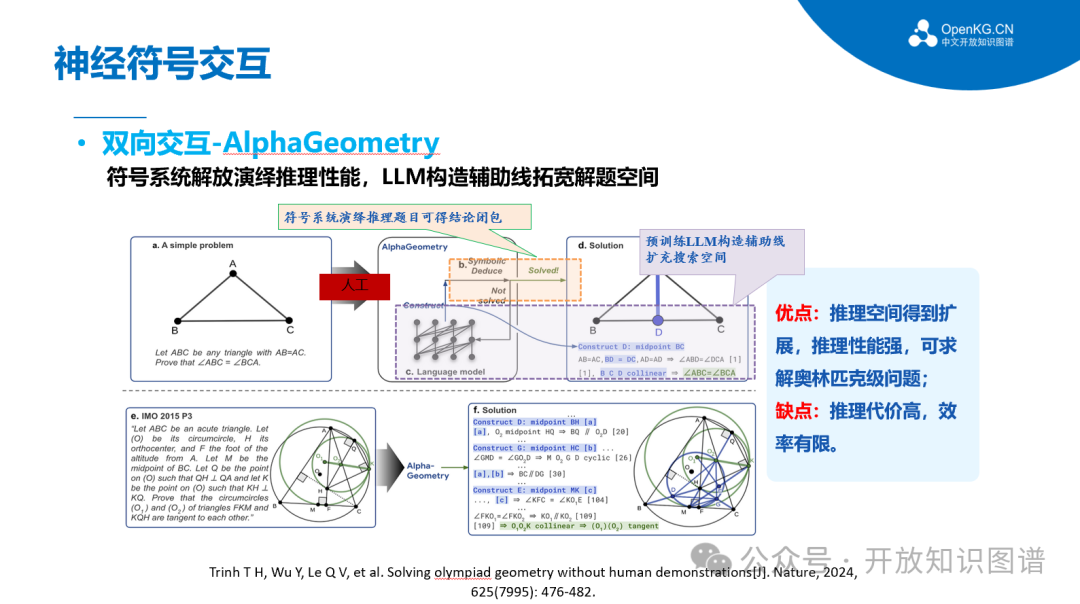

神经符号协同交互的代表性工作去年有一篇发表在了Nature上,DeepL的团队提出了一个针对欧几里得平面几何的定理证明系统---AlphaGeometry,该模型通过合成数百万个定理和证明,跨越不同复杂度的层次,可以不需要人类的提示与演示。在此过程中,DeepL的团队提出了一种基于合成数据的定理证明替代方法,从而避免了翻译人类提供的证明示例的需求。该方法专注于欧几里得平面几何,不包括几何不等式和组合几何等领域。

OpenKG 2024代表性工作

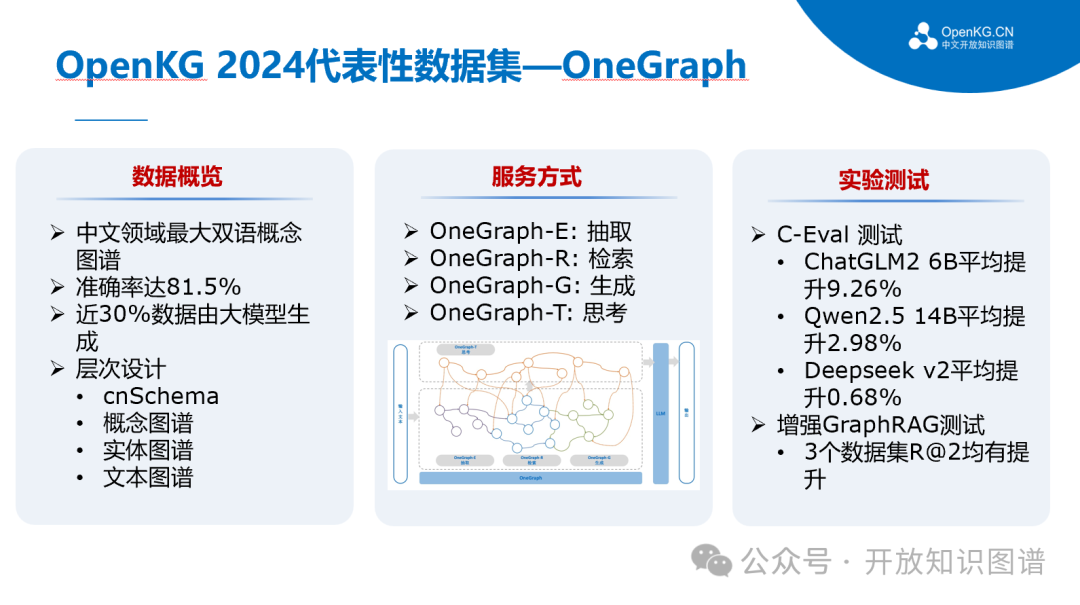

浙江大学团队提出了基于大语言模型构建的千万级中英双语概念知识图谱——OneGraph。该图谱不仅丰富了跨语言的信息交流,还增强了大语言模型和GraphRAG的效果,在多个应用案例中展现了其价值。

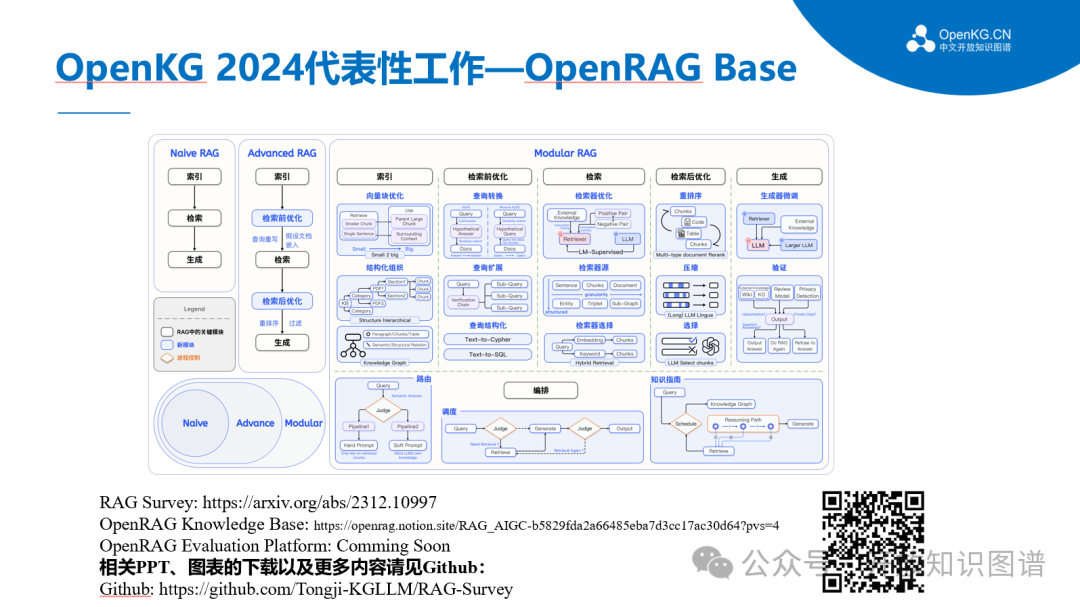

同济大学团队系统性总结了OpenRAG技术在过去一年中的发展,并构建了OpenRAG Base, 作为OpenKG的年度优质资源,OpenRAGBase是第一个基于公开资料收集整理汇总的,也是目前最全面的RAG知识库。目的是为读者提供前沿的RAG资料汇总,提供多维度的分析,包括学术论文、前沿咨询和文章、RAG评估与基准、下游任务与数据集、工具与技术栈、研究学者与机构汇总等,无论是刚刚接触RAG,还是RAG相关研究人员或是从业人员,相信都可以从中受益。

OneKE是由蚂蚁集团和浙江大学联合研发的大模型知识抽取框架,具备中英文双语、多领域多任务的泛化知识抽取能力,并提供了完善的工具链支持。OneKE以开源形式贡献给OpenKG 开放知识图谱社区。

趋势与总结

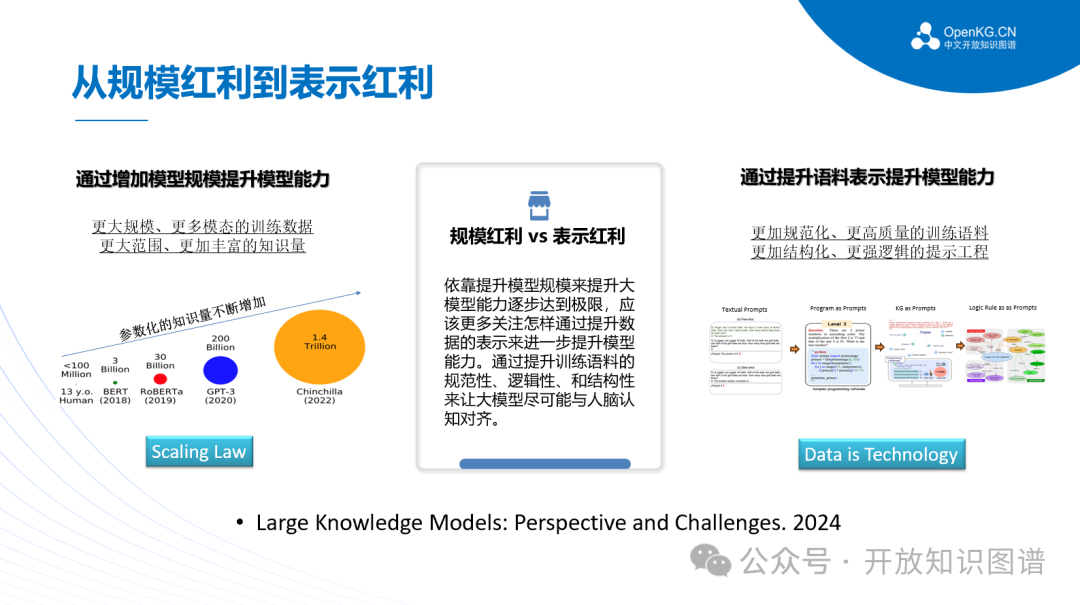

在未来趋势方面,将逐渐从传统的数据规模红利从知识表示红利过度,从依靠模型规模提升能力转向注重数据表示能力提升,通过对比不同提升方式可以发现提升训练语料质量和提示工程的重要性。

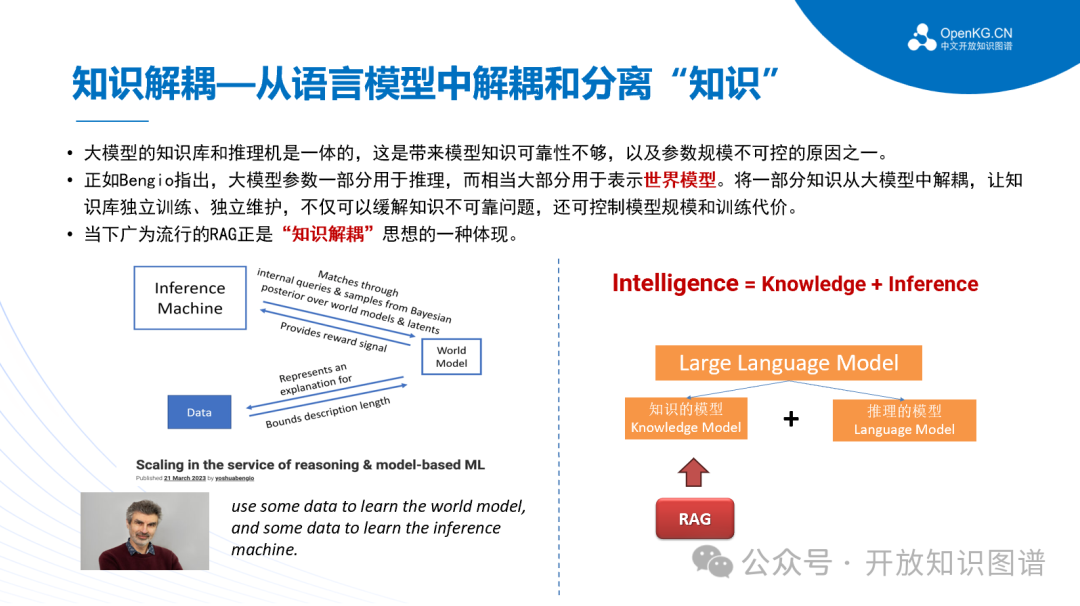

大模型知识库和推理机一体存在的问题是造成模型知识可靠性不够、以及参数规模不可控的原因之一,RAG的流行,说明知识解耦具有重要意义,它有助于提高知识可靠性和控制模型规模,是未来大模型架构优化的重要思路。

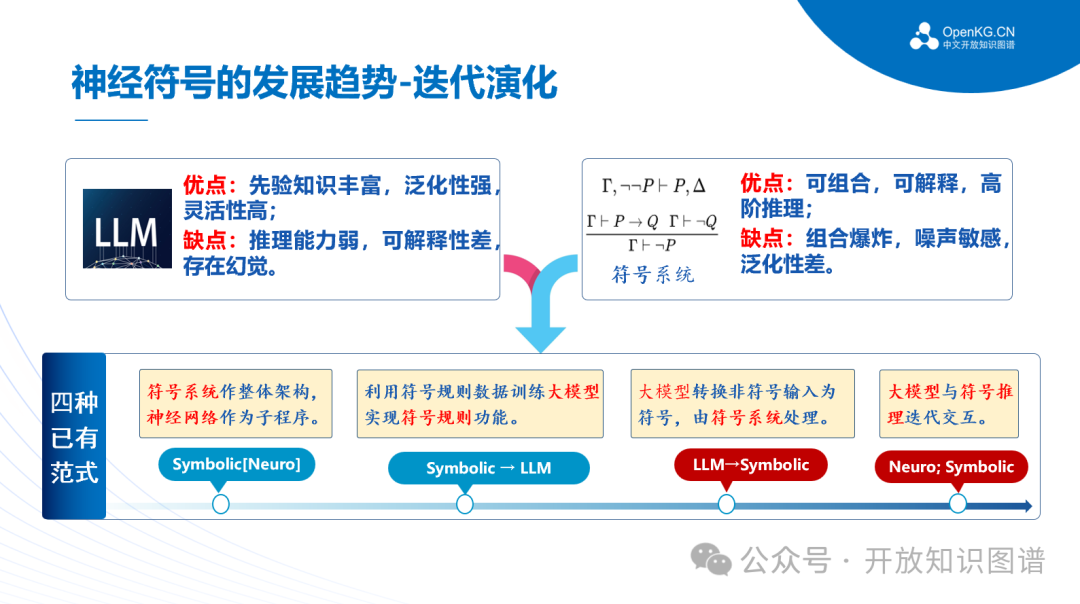

神经符号的迭代演化是未来技术发展的重要趋势,包括利用符号规则数据训练大模型、大模型与符号系统的相互转换和迭代交互等不同范式。

OpenKG 开源社区通过开放、协作、可持续和可扩展的方式,旨在构建大模型时代下全球领先的知识图谱生态系统,为各行业提供智能化的知识服务,促进知识的共享与增值。

以上就是本次分享的内容,谢谢

作者简介

王昊奋

同济大学百人计划特聘研究员,博士生导师。他是全球最大的中文开放知识图谱联盟OpenKG轮值主席。他负责主持多项国家AI专项,发表100余篇AI领域高水平论文。他构建了全球首个可交互养成的虚拟偶像—“琥珀·虚颜”;所构建的智能客服机器人已累计服务用户超过10亿人次。目前,他担任中国计算机学会术语工委副主任,自然语言处理专委秘书长,信息系统专委常委,智能机器人专委会执委;中国中文信息学会理事,大模型专委会指导委员会委员,语言与知识计算专委会副秘书长;中国指挥控制学会大模型专委会常务委员;上海市计算机学会自然语言处理专委会副主任等社会职位。

声明:本文来自开放知识图谱,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。