作者:孙志敏

本文首发于AI与安全公众号。

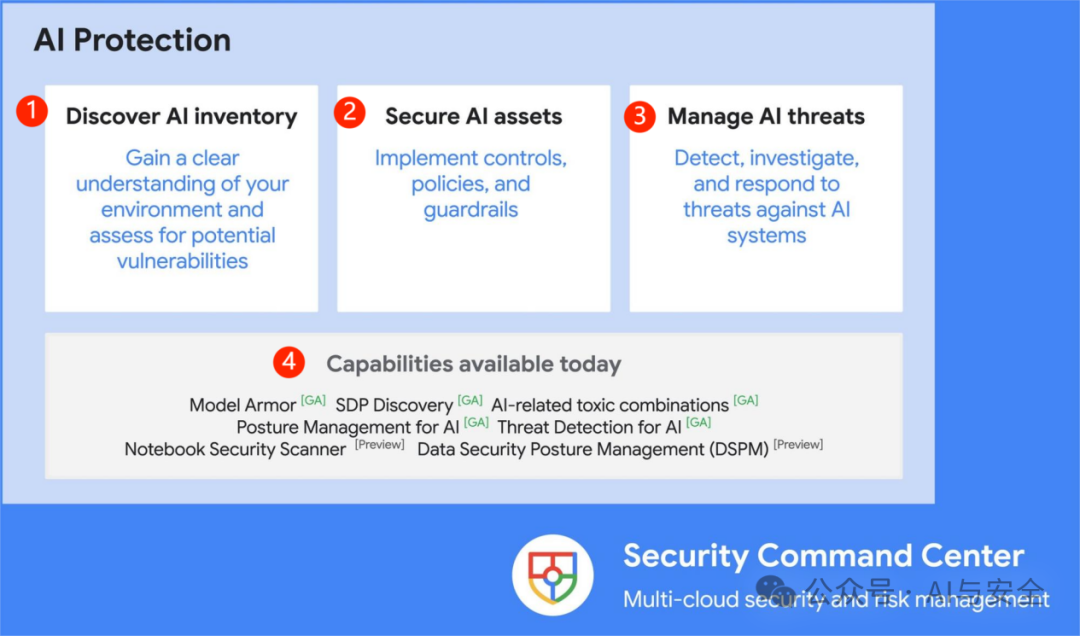

在Google Next 2025上,Google推出一款全新解决方案-AI Protection,保护整个 AI 生命周期内降低风险。 这是一个结合AI与数据安全的方案,非常有前瞻性,值得看看。

方案概要

AI Protection 通过以下方式帮助团队全面管理 AI 风险:

主要有三个功能:

①发现您环境中的 AI 资产并评估其潜在漏洞

②通过控制、政策和护栏保护人工智能资产,这是重点

③通过检测、调查和响应能力管理针对人工智能系统的威胁

另外,已经实现的功能包括(图中④): 模型装甲(Model Armor),SDP发现,与al相关的威胁合并,AI的态势感知,AI的威胁检测,及预览版本的Notebook安全扫描,数据安全态势感知(DSPM)。

这是一个保护AI和数据的综合方案,当然,AI需要数据,也要处理数据,二者密不可分。

核心防护

这里边,最重要的是第2部分,AI防护,是怎么防护的,防护有哪些内容,打开看看。

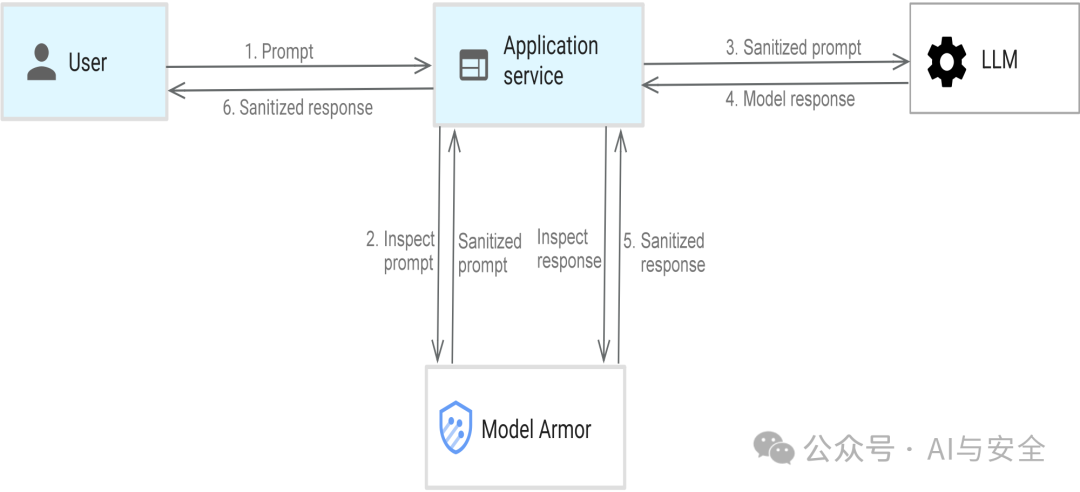

这是一个针对AI应用的防护方法,其实就是现在流行的AI围栏,在模型和用户之间做一个防护,其中最重要的就是Model Armor(模型护甲),其架构如图:

上图显示了使用 Model Armor 保护 LLM 和用户应用的数据流图。

用户向应用提问

Model Armor 会检查传入的提示是否包含潜在敏感内容。

系统会将提示(或经过脱敏处理的提示)发送到 LLM。

LLM 会生成回答。

Model Armor 会检查生成的回答是否包含潜在敏感内容。

系统会将响应(或经过过滤的响应)发送给用户。 Model Armor 会在响应中发送有关触发的过滤条件和未触发的过滤条件的详细说明。

简而言之,模型装甲可充当过滤器,同时检查输入(提示)和输出(响应),以确保 LLM 不会泄露或提供任何恶意或敏感的输入或输出。

主要的检查内容包括:

安全和负责任的 AI 过滤器

Model Armor 提供内容安全过滤器,可解决露骨色情、危险、骚扰和仇恨言论内容等问题。

提示注入和越狱检测

Model Armor 包含用于检测和防范提示注入和越狱攻击的功能。

使用敏感数据保护功能实现数据泄露防范 (DLP)

Model Armor 包含 Google Cloud 敏感数据保护服务的全部功能,可提供数据泄露防范功能。它可以发现、分类和保护敏感数据(例如源代码等知识产权或信用卡号等个人身份信息),防止其在 LLM 互动中被未经授权地泄露。

恶意网址检测

Model Armor 能够识别问题和回答中的恶意网址,从而增强 AI 应用的安全状况。

支持筛查 PDF 文件

Model Armor 支持筛查 PDF 文件中的文本是否包含恶意内容。

结合MCP的工具投毒攻击(TRA)以及出现的各种攻击看,数据窃取是未来AI系统的最大风险,护栏结合DLP,思路非常好。

总结

1.Google的AI Protection作为一个产品,如此快速的推出,说明AI的应用及相关威胁确实在快速发展,需要完整的防护。联想到之前字节的AI防火墙及一些安全公司的类似产品,未来,类似AI Protection的产品作为一个新的产品品类,将迅速发展壮大,在相关应用中的位置,可能类似于今天的防火墙,是必需品。

2.Google的防护,把数据安全的能力结合进去,是非常前瞻的思想,AI最重要的目的是与数据交互产生价值,主要的风险也会和数据相关,二者结合,确实是理想的方案。

3.结合Google的AI安全框架SAIF看,Google对AI安全的投入还是非常大的。

声明:本文来自AI与安全,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。