前情回顾·AI Agent安全研究

安全内参7月21日消息,OpenAI近日为ChatGPT推出了一项强大的新功能,同时也带来了众多新的安全风险与挑战。

这个名为“ChatGPT Agent”的功能是一个可选模式,ChatGPT的付费用户可通过点击提示框中的“工具”,选择“Agent模式”来启用。启用后,用户可以让ChatGPT登录邮箱或其他网页账号,撰写并回复邮件,下载、修改和创建文件,甚至执行一系列任务,几乎就像一个真人在使用他们的账号登录电脑一样,实现自动化操作。

显然,这需要用户信任ChatGPT Agent不会做出任何错误行为或恶意行为,也不会泄露用户的数据或敏感信息。相比无法访问网页账号或直接修改文件的普通ChatGPT,这项新功能将会给用户及其雇主带来更大的风险。

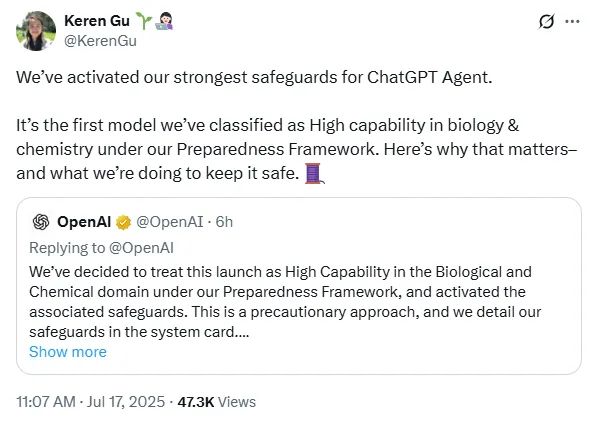

OpenAI安全研究团队成员Keren Gu在X上评论说:“我们为ChatGPT Agent启用了最强的防护机制。这是我们首次在‘准备度框架’下将模型归类为在生物与化学领域具有‘高级能力’的系统。为什么这很重要?我们又是如何保障安全的?接下来一一讲解。”

那么,OpenAI是如何应对所有这些安全问题的呢?

执行红队任务

在OpenAI发布的ChatGPT Agent系统卡片中可以看到,公司组建的“红队”承担了极具挑战性的任务:团队由16位拥有博士学位的安全研究人员组成,他们仅有40小时时间对系统进行测试。

通过系统性测试,红队发现了7条通用攻击路径,这些路径可能被用来攻击系统,暴露出AI Agent在处理现实世界交互时的关键性漏洞。

接下来,OpenAI基于红队测试进行了大量安全验证。红队网络总计上报了110次攻击,涵盖从提示注入到生物信息提取等多种形式。其中有16次攻击超出了内部风险阈值。每一次发现都为OpenAI工程师提供了关键的信息,用于问题修复,并在系统正式发布前完成部署。

最终结果清晰地展示在系统卡片中。ChatGPT Agent实现了显著的安全提升:视觉浏览器的无关指令攻击防护率达到95%,同时具备稳健的生物与化学安全防护机制。

揭示七条通用攻击路径

OpenAI的红队由16位具有生物安全博士背景的研究人员组成,在测试期间共提交了110次攻击尝试,其中16次攻击超出风险阈值,揭示了AI Agent在现实世界交互中存在的根本性漏洞。而真正的突破来自英国人工智能安全研究所(UKAISI)对ChatGPT Agent内部推理链条与策略文本的前所未有的访问权限,这是一种常规攻击者永远无法获得的情报。

在四轮测试中,UKAISI成功迫使OpenAI执行了7条通用攻击路径,这些路径有可能破坏任何一次会话。

表:迫使OpenAI做出应对的攻击向量

攻击类型 | 修复前成功率 | 目标 | 影响 |

视觉浏览器隐藏指令 | 33% | 网页 | 主动数据外泄 |

Google Drive连接器利用 | 未披露 | 未披露 | 强制性文档泄露 |

多步骤链式攻击 | 非固定值 | 跨站操作 | 完整会话劫持 |

生物信息提取 | 16项超过阈值 | 危险知识 | 潜在武器化风险 |

FAR.AI对OpenAI所采用的方法持批评态度。尽管40小时内仅发现3个部分漏洞,但他们指出当前安全机制过于依赖推理和工具使用过程中的监控,而一旦这些监控被突破,就可能形成单点失败。

红队如何将ChatGPT Agent从漏洞修炼成堡垒

OpenAI对红队测试结果的响应,重塑了ChatGPT Agent的多个架构核心。其中一项关键改进是构建了双层安全检查系统,实时监控100%的生产流量,取得了可量化的成效。

表:根据红队发现实现的安全性提升

防护指标 | 原模型 | ChatGPT Agent | 提升度 |

无关指令(视觉浏览器) | 82% | 95% | +13% |

上下文内数据外泄 | 75% | 78% | +3% |

主动数据外泄 | 58% | 67% | +9% |

系统可靠性 | 抽样检测 | 100%覆盖 | 全面检测 |

该架构具体包括:

第一层:一个召回率为96%的快速分类器,用于标记可疑内容;

第二层:一个召回率为84%的推理模型,对被标记内容进行威胁分析。

然而,技术防护只是安全的一部分。OpenAI还做出了一些艰难的安全决策,承认某些AI行为必须受到严格限制,才能以自动方式安全运行。

根据红队发现的漏洞,OpenAI实施了以下防御措施:

监控模式激活:当ChatGPT Agent访问银行、邮箱等敏感场景时,如果用户切换页面,系统将立即冻结所有操作,以应对测试中发现的数据外泄攻击。

关闭记忆功能:虽然记忆功能本是核心之一,但为了防范红队展示的逐步数据泄露攻击,该功能在发布时被完全禁用。

限制终端访问权限:网络请求被限制为仅可执行GET请求,从而封堵了研究人员利用的命令执行漏洞。

建立一套能够在漏洞被发现后数小时内完成修补的系统,以应对红队揭示的攻击传播速度极快的问题。

仅在发布前的测试阶段,这一系统就识别并修复了红队发现的16个关键漏洞。

生物风险警示

红队还揭示,若ChatGPT Agent被攻破,可能引发更高层级的生物安全风险。16位拥有生物安全博士学位的研究人员尝试提取危险生物信息,发现模型可综合公开文献中有关制造生物威胁的内容。

为应对红队的发现,OpenAI将ChatGPT Agent定义为在生物与化学风险领域具“高级能力”的模型。尽管未发现明确的武器化能力,但公司仍基于红队研究采取预防性机制,包括:

安全分类器始终在线,对流量进行100%扫描;

一个召回率为96%的主题分类器,识别生物相关内容;

一个召回率为84%的推理监控器,识别潜在武器化意图;

启动“生物漏洞赏金计划”,持续发现新漏洞。

OpenAI红队驱动的AI安全核心理念

红队提交的110次攻击揭示了几大规律,推动OpenAI在安全理念上进行根本性转变:

持续性胜于强度:攻击者不需高明技术,只要有足够时间,便可通过渐进式攻击最终突破防线;

信任边界是幻想:AI Agent能访问Google Drive、浏览网页、执行代码,传统的安全边界随之失效。红队正是利用了这些功能之间的缝隙;

监控必须全面:抽样监测错失关键攻击,促使OpenAI改为对100%流量进行实时监控;

响应速度决定胜负:提示注入等攻击可瞬间扩散,传统以周为单位的修复周期无效。OpenAI的机制则可在数小时内完成漏洞修补。

为企业级AI建立新的安全基线

对于需要评估AI部署的首席信息安全官(CISO)而言,红队的发现确立了几个关键要求:

可量化的防护能力:ChatGPT Agent在已知攻击向量上达到了95%的防护率,成为新的行业基准。系统卡片中详列的测试细节对所有模型安全从业者都是必读材料。

全面的可视性:100%流量监控从“理想”变为“必需”。OpenAI的经验显示,攻击可能隐藏在系统的任意角落。

快速响应机制:修复漏洞的时间应以“小时”计,而非“周”。

强制性边界控制:某些功能(如在敏感任务中访问记忆)必须在被证明安全之前持续禁用。

UKAISI的测试尤其具有启发性。尽管他们识别出的7条通用攻击已在发布前修复,但其对内部系统的深度访问,预示着未来这些漏洞极有可能被外部对手发现。

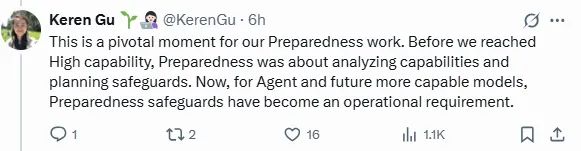

正如Keren Gu在X上所说:“这是我们准备度工作的一个关键节点。在模型达到‘高级能力’之前,准备度工作主要聚焦能力分析与防护设计。而如今,对于Agent和未来更强大的模型,准备度机制已成为运行的基础要求。”

红队是打造更安全AI模型的核心力量

红队揭示的7项通用攻击路径,以及110次攻击尝试,成为ChatGPT Agent安全进化的熔炉。

他们清晰地揭示了AI Agent如何可能被武器化,促使OpenAI构建了一个以安全为核心而非附属功能的系统。

ChatGPT Agent的成果验证了红队机制的价值:可拦截95%的视觉浏览器攻击、捕捉78%的数据外泄尝试、监控每一条交互。

在这场日益加速的AI军备竞赛中,唯有那些将红队视为平台核心架构师、不断突破安全极限的公司,才能笑到最后。

参考资料:https://venturebeat.com/security/openais-red-team-plan-make-chatgpt-agent-an-ai-fortress/

声明:本文来自安全内参,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。