当企业拟选定特定国家或地区作为其在线内容或服务的目标市场时,一个日益凸显的先决合规问题是:是否以及如何实施年龄验证才能满足合规要求?对此,本文首先讨论与年龄验证有关的概念,并对年龄验证的范围予以界定,然后基于最新的立法和执法实践,依次梳理了有关年龄验证的三个主要监管趋势:一是个保法驱动的年龄验证日益强调“相称性”标准,即数据控制者须实施与其数据处理风险相适应的验证措施;二是网络内容安全保护驱动的强制性年龄验证要求逐渐增多;三是针对应用商店的专门立法,在要求应用商店应承担年龄验证义务的同时,并未豁免应用开发者的其他年龄保障义务。

* 感谢姜同学的校对和审稿!

1. 讨论范围的界定:年龄验证 vs 年龄保证 |

本文旨聚焦于“年龄验证”的内容,而更为宽泛的“年龄保证”或“年龄保障”(Age Assurance)概念的内容,虽与前者密切相关,但并非本文的核心讨论对象。

年龄验证指用于判定年龄或年龄范围的具体方法,而年龄保证或年龄保障是一个上位概念,它涵盖了为根据用户年龄提供相称保护而采取的所有技术和组织的统称。因此,年龄验证可被视为实现年龄保证的组成部分之一。

需注意的是,在诸如欧洲数据保护委员会(EDPB)的指南及ISO/IEC DIS 27566-1(草案)等关键国际标准与监管文件中,"Age Assurance" 是更常被采用的统称术语,即其内容包括年龄验证。

年龄验证的具体技术路径涵盖了多种方法,包括:自我声明,年龄核实(例如基于权威信息来源进行比对),年龄估算(例如通过面部分析判定年龄范围)以及年龄推断(例如基于信用卡信息进行推论)等。这些措施在验证强度上存在显著差异。(从合规要求来看,这种差异类似于有关“身份识别”与“身份认证”之间的差别,见身份识别 vs 身份认证:新加坡个人信息保护法的最新发展)此外,一个明显的监管趋势是,仅依赖“自我声明”作为验证手段,其有效性正日益受到监管机构的挑战。后面内容将对此进一步展开分析。

更重要的是,年龄验证不仅是一项技术措施,还是一项合规义务,因而厘清“年龄验证”与“年龄保证”的界限具有现实的合规意义。“年龄验证”主要涉及服务接入阶段的合规性,即数据控制者是否设置了适当的“准入门槛”。然而,在用户获准进入服务后,其个人信息(尤其是未成年人个人数据)的持续性处理行为,则落入GDPR其他条款(例如数据保护原则、透明度义务等)的管辖范畴。

在爱尔兰数据保护委员会(DPC)于2023年针对TikTok违规处理儿童个人数据的处罚决定中,体现了上述两者的区分。

案例分析:爱尔兰 DPC 对 TikTok 的处罚决定 在该案中,爱尔兰 DPC的决定草案初步认定TikTok 所实施的年龄验证措施遵守了 GDPR。然而,此项认定遭到了意大利 DPA反对,认为其违反了第25条“数据保护的设计与默认”,且EDPB 也对这些措施的有效性表示“严重怀疑” 。尽管如此,EDPB 最终裁定,由于缺乏关于相关时期“技术现状”的足够信息 ,因此无法最终评估其年龄措施的合规性。最终爱尔兰DPC认定,虽然TikTok在“数据最小化”和“透明度义务”等方面构成违规,但并未在该案中裁定其年龄验证措施本身违反了GDPR的规定。 |

2. 年龄验证的范围:法定成年年龄 vs. 个保法的同意年龄 vs. 网络内容安全的年龄门槛 |

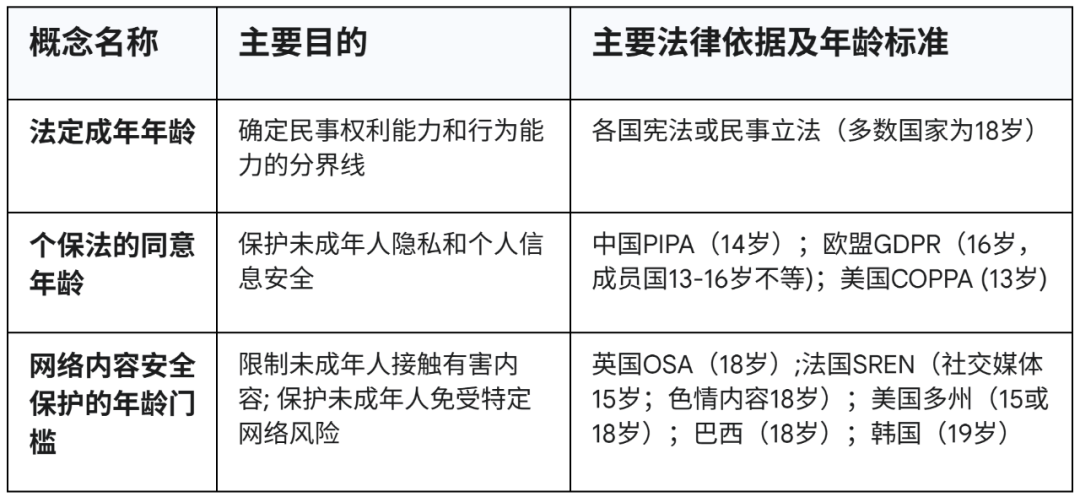

在厘定年龄验证的概念后,还需要进一步了解年龄验证的范围。在实践中,存在多个不同层级的“年龄”概念,他们分别设定了年龄验证的上线和下限门槛:

“法定成年年龄”(Age of Majority)源于民事法律,界定个人从“限制民事行为能力”到“完全民事行为能力”的法律节点(多数国家为18岁)。它通常被用作访问成人内容(如色情、赌博)年龄门槛的监管上限。

数字同意年龄(Age of Digital Consent),包括个保法的同意年龄和网络内容安全保护的年龄门槛,则都用于设定年龄验证的下限门槛。其中,

“个保法的同意年龄”是个保法框架下的特有概念,界定处理未成年人个人信息时,需要获取监护人同意的年龄阈值(如欧盟13-16岁,美国13岁,中国14岁)。这是个人信息领域取得有效同意的年龄下限,目前主要以间接要求为主。

“网络内容安全的年龄门槛”源于有关网络内容安全的立法,其目的无关个人数据或民事能力,而是保护未成年人免受特定网络内容(如暴力或色情)或服务(如使用社交媒体)的身心伤害。以英国OSA,法国SREN等代表性法规,要求强制性的年龄验证。

3. 个保法的年龄同意:合理努力和相称性 |

在网络内容安全保护立法兴起之前,年龄验证的主要驱动力来自传统的个人信息保护法,即“个保法的同意年龄”模式。年龄验证的主要驱动力来自个人信息保护法,即“个保法的同意年龄”模式。此模式的核心法律义务是欧盟GDPR第8(2)条的“合理努力”标准和EDPB指引进一步发展的“相称性”标准。简言之,数据处理的风险越高,年龄验证措施就必须越强。

欧盟GDPR第8(2)条规定,数据控制者必须“尽合理努力”核实儿童的数据处理是否获得了监护人同意。EDPB的《第 05/2020 号指南》进一步明确,这些验证措施必须“与处理活动的性质和风险相称”:

“……在此种情况下,控制者应考虑到可用技术,尽合理努力核实同意是由对该儿童负有父母责任的人作出或授权的...GDPR没有规定核实父母责任的具体方法。所采取的措施必须与处理活动的性质和风险相称 ... 例如,在一个低风险的处理活动中... 控制者通过电子邮件验证父母同意可能就足够了 ... 在高风险情况下(例如处理敏感数据或与儿童画像相关的数据),控制者应要求更可靠的验证措施。” (para.132, 133, 134)

因而,这一框架建立了一个弹性的、基于风险的标准:低风险活动(如不进行用户画像)可能仅需简单的年龄声明;而高风险活动(如社交媒体或处理敏感数据)则需要更强有力的验证措施,以同时满足“合理努力”和“相称性”的要求。

而来自监管机关的执法实践,则进一步将上述要求转为了实际的合规要求:

与个保法的年龄验证有关的典型执法案例

除了GDPR外,欧盟《数字服务法案》(DSA)第28条同样要求采取“适当且相称的措施,确保未成年人享有高水平的隐私、安全和安保” ,而且欧盟委员会针对该条所发布的指引,进一步明确“自我声明(即用户自行填写年龄)不被视为充分的年龄保障措施”。(见欧盟《数字服务法》DSA下的未成年人网络保护)这也表现在,虽然前述爱尔兰DPC认定无法证明TikTok违反了GDPR,但欧盟委员会基于DSA而针对TikTok发起的调查,依然将年龄验证措施作为主要事项之一。

4. 网络内容安全保护驱动的强制性年龄门槛 |

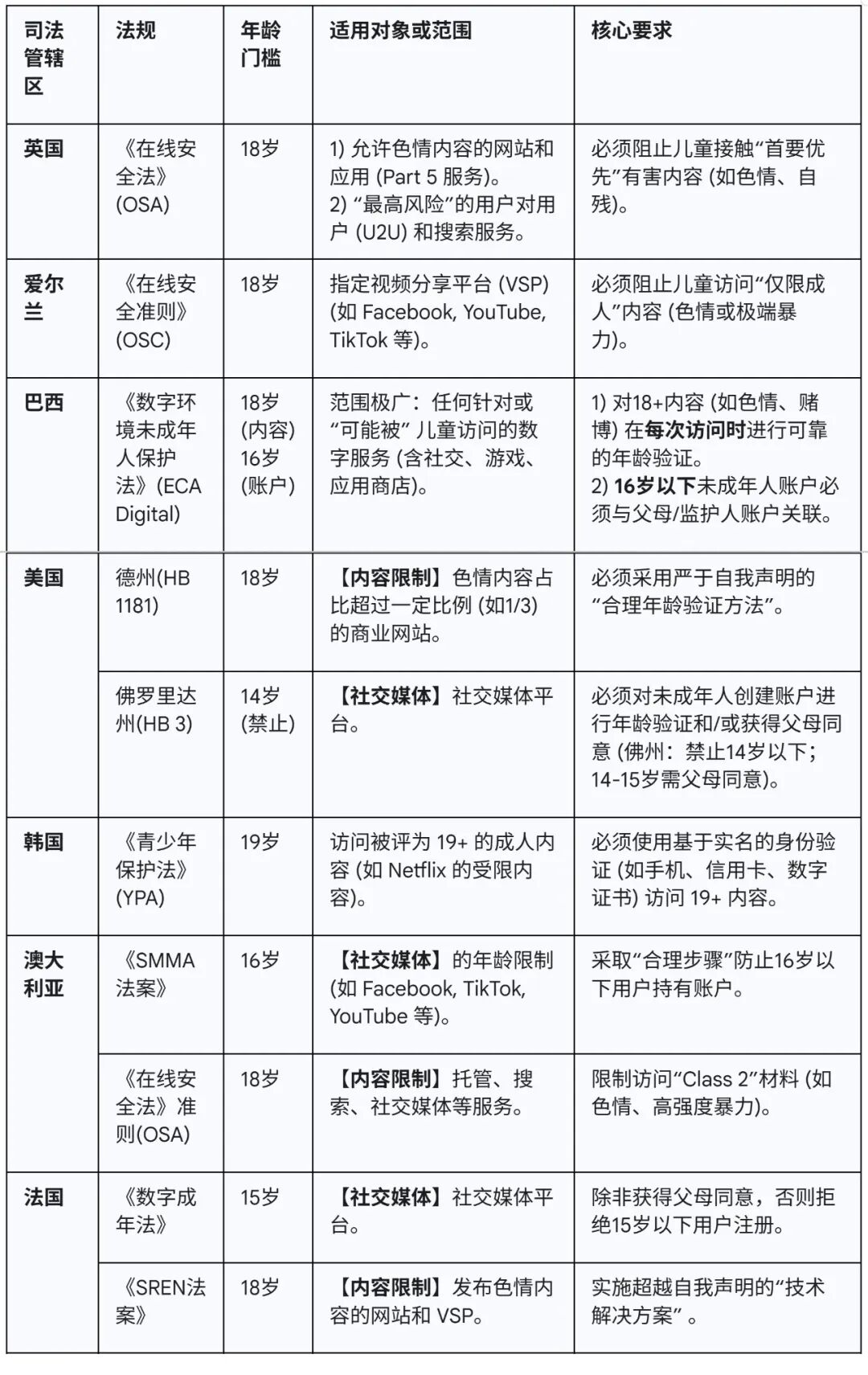

在全球范围内,由“网络内容安全保护驱动” 的监管模式正日益兴起,其核心实践是将年龄验证从过去的“建议”转变为“强制”要求。在多个司法管辖区(如英国、美国、巴西、爱尔兰、法国、韩国和澳大利亚 )已转向更强硬的“强制性年龄验证”立场。这一转变对年龄验证要求产生了直接且重大的影响:几乎所有采用强制框架的司法管辖区,均明确或隐含地禁止了效力薄弱的“自我声明”。取而代之的是,法规强制要求适用服务(如色情内容网站、社交媒体平台和视频分享平台 )必须采用更严格的“合理年龄验证方法” 或“技术解决方案” ,以有效阻止未成年人访问有害或仅限成人的内容。

而对于那些在线服务或内容平台属于受限制的对象,不少立法采用的是清单式管理模式。例如,澳大利亚《SMMA法案》针对是否属于受限的社交/内容平台,采用清单式管理,只有被认定为纳入了受限请当的平台,才需要执行强制年龄验证措施。(见澳大利亚在线安全监管最新口径:受年龄限制社交媒体名单更新,游戏当前豁免)。

典型司法辖区的强制性年龄验证

5. 应用商店的年龄验证义务 |

在监管机构努力应对数以百万计的网站和应用的挑战时,一种新型的监管路径已经出现:不再试图监管每一个独立的开发者,而是集中监管少数几个关键的“监管抓手”或“关键节点”——即应用商店。这体现在巴西、美国多个州法以及新加坡等地的专门立法。其中,新加坡的《应用程序分发服务在线安全操作守则》是此种监管路径的典型例证。自2025年3月起,该法规强制要求主要应用商店(如苹果、谷歌和三星)实施年龄验证措施,以防止18岁以下的用户下载包含“成人内容”等有害内容的应用。

该守则明确界定了应用商店与应用开发者各自有关年龄保障的责任:

应用商店(ADS)承担基础性的年龄验证义务;

应用开发者的义务负责利用ADS提供的验证结果,在应用内实施具体的、与年龄相适应的保护措施。

此种分工明确了各自的法律责任边界,即ADS负责构建统一的年龄保障基础设施,而开发者负责应用层面的合规执行。

需要强调的是,平台提供的统一年龄验证服务,并未豁免开发者的法定合规义务,而是重构了其义务的履行方式。

豁免“重复构建”的义务。 平台提供统一的年龄验证服务,使开发者免于独立构建复杂且高风险的验证系统,避免了重复开发,并显著降低了开发者为验证目的而直接收集敏感个人信息(如身份证明文件、生物特征数据)的需求。

强化“知情行动”的义务。平台一旦向开发者传递了标识用户为未成年人的信号,开发者即被视为已获得法律意义上的“实际知情”。获得此“实际知情”后,开发者必须立即履行其在相关司法管辖区法律下所负有的积极义务,为该用户提供适龄保护。开发者若无视平台提供的“实际知情”信号,未能采取相应保护措施,将构成“明知故犯”,从而面临显著增加的法律与合规风险。

声明:本文来自赛博牛马号,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。