随着跨国公司在全球范围内加速推进智能化转型,为了确保业务一致性、运维一体化并降低全球运营成本,部分在华外企开始使用境外总部统一部署的AI解决方案(包括LLM、Agent或含有AI功能的相关应用,以下合成AI),用于研发支持、经营决策、客户服务及数字内容生成等场景。

但是,随着中国网络安全、数据合规及个人信息保护、AI治理相关的法律法规及监管政策日趋完善,这种全球一体化部署方式正面临“总部技术赋能”与“本地监管边界”的激烈碰撞。

本文中,汇业律师事务所黄春林律师团队将聚焦外企最关心的合规问题,从专线连接的法律定性,内部使用的法律红线,到生成内容的输出合规,简要解析在华外企使用境外AI解决方案的主要法律问题,仅供参考。

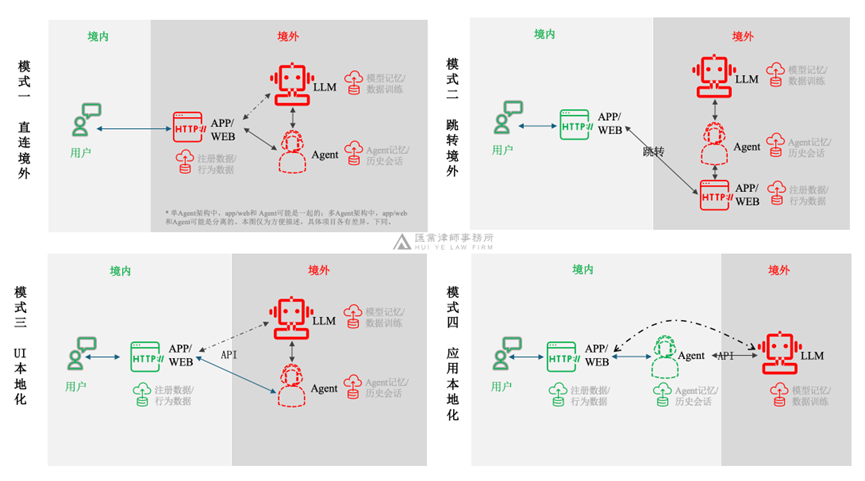

一、使用境外总部AI的主要技术路径

根据类似项目的本地化程度不同,在华外企使用境外总部AI解决方案的主要技术路径图示如下:

需要说明的是,境外总部的AI部署方案也存在较大差异,可能是私有化部署方案(往往还可能会接入多个LLM,例如GPT、Gemini、Claude等),也可能是使用类SaaS方案(例如Copilot,本质上Copilot是个应用层Agent,背后模型层使用了GPT等LLM)。

二、通过专线接入境外总部AI的法律性质

1. 专线接入是否能够排除中国法适用

相较于公共互联网连接,专线接入仅在网络传输层面提升了私密性、安全性与稳定性,并不会导致在华外企的办公场所或办公系统获得排除中国法律适用的法律效果。现行监管实践中,也并不以“是否走公网”作为适用域内网络安全、数据与算法监管等法律的判断标准,而是以服务是否实际发生在中国境内、是否对境内主体产生法律效果为核心。

2. 向在华外企开放接入是否属于中国法项下的“向公众提供服务”

在跨国公司架构中,负责AI统一运营的境外主体(例如集团、集团科技公司)与在华外企之间,往往并不存在直接的股权控制关系,甚至各自隶属于不同区域或不同业务板块,因此在公司法与监管法意义上均属于独立的法人主体,且各主体适用的法律与政策环境也差异较大。在类SaaS方式下的集团AI部署方式(例如Copilot),AI服务提供商本身就是外部机构。

因此,是否属于中国法项下的“向公众提供服务”,需要综合部署方式、公司架构、法域及最终使用方式(详见第三、四、五几个部分)分别场景化分析。

三、在华外企仅内部员工使用境外集团AI的主要法律问题

根据《生成式人工智能服务管理暂行办法》,企业应用生成式人工智能技术“未向境内公众提供生成式人工智能服务的”,不适用该办法的规定。因此,很多人错误地认为,在华外企仅内部员工使用境外集团AI解决方案的,没有法律风险。汇业黄春林律师团队认为:

首先,这里的“公众”并不仅限于2C的个人服务,也包括2B的企业服务,这就是为什么境外的Gemini、ChatGPT、copilot等应用层,也不直接向中国企业销售的原因之一。跨国公司的复杂架构,如前一部分分析,可能很难一刀切地认定绝对属于“内部使用”(事实上,这个不是一个法律概念),毕竟在华外企与境外集团在法律地位上并不混同(例如,境外总部出事了,你们可撇的干干净净的吧)。此外,部分在华外企的部分办公系统(包括AI组件)同时也可以给供应商、经销商、加盟商等外部主体使用,这就更难抗辩说仅仅为内部使用了。

其次,即便不适用《生成式人工智能服务管理暂行办法》的规定(具体哪些合规义务可以不适用,建议根据业务场景咨询专业人士),如果集团AI被认定为在中国境内提供信息服务的(例如仅面向中国地区、支持中国当地交易等),仍应遵守中国其他法律法规,例如网络安全法(内容安全、密码合规等)、个人信息保护法(告知/同意、个人信息出境等)等。

那么,内部使用境外总部的AI解决方案,和内部使用境外总部的邮箱、网盘等解决方案,有什么法律上的区别吗?黄春林律师团队认为,从电信业务监管角度,没有本质的法律区别,都是缺乏必要的业务许可。但是在信息安全上,因风险暴露面量变到质变,所以存在根本区别。因为AI本身的自主性、智能性,以及约束性弱和解释性差等特征,决定了在中国特殊的法律环境下具有更高的信息安全风险暴露面。这就是为什么Gmail允许中国IP注册,但是Gemini不允许的原因之一。那为什么Gemini不像Teams一样搞个中国版呢?因为,还涉及人工智能出口管制等问题。

再次,很多人疑惑,即便境外总部的AI解决方案违反中国法的相关规定(例如涉政),可能会追究在华外企的法律责任吗?这就取决于第一部分中的技术路径了,即在第二、三、四种模式中,均有中国落地页面的联结点,因此作为境内联结点的在华外企,很难绝对撇开法律责任,尤其是一旦诱发舆情事件(例如之前境外总部网站标错地区地图等事件)。

最后,在华外企作为使用者,仍应当遵守《网络信息内容生态治理规定》《互联网信息服务深度合成管理规定》《人工智能生成合成内容标识办法》等规定。数据出境的相关风险参见第五部分。

四、内部员工使用境外集团AI合成生成内容对外发布的主要法律问题

当在华外企员工利用境外总部AI生成的文本、图片或视频等素材,用于在社交媒体平台、电商平台或自有官网、APP等渠道对外发布时,是否进行标识是监管关注度较高的风险点之一。

《人工智能生成合成内容标识办法》的上位法不仅是《生成式人工智能服务管理暂行办法》,还包括《互联网信息服务算法推荐管理规定》、《互联网信息服务深度合成管理规定》。因此,在法律评价上,关键不在于AI是否由境外集团提供,也不在于生成环节是否发生在境外,而在于最终对外呈现的内容是否属于“合成生成内容”以及是否可能对公众产生混淆或误认。

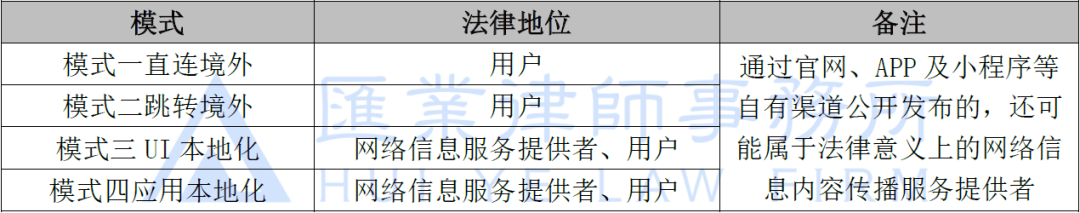

同时,《人工智能生成合成内容标识办法》项下的标识义务主体至少包括以下三类:(1)网络信息服务提供者;(2)网络信息内容传播服务提供者;(3)用户。在第一部分分析的四种模式中,内部员工使用境外集团AI合成生成内容对外发布,不同模式项下的在华外企的法律地位如下表所示:

在某些特定的电商、广告场景中,利用AI技术生成、优化的产品相关图片,在考虑是否“可能导致公众混淆或者误认的”,进而判断是否需要添加显式标识时,黄春林律师团队建议参考如下因素确立:

(1)产品、人物或场景的主体部分是否由AI生成合成的;

(2)AI处理后的产品图片、视频是否改变了原有产品的形状、材质、色彩、大小、功效等基本要素,影响消费者知情权、选择权的;

(3)AI生成的内容是否包括人类人脸、语音、其他生物特征的;

(4)AI生成的内容是否涉及社会热点、突发事件、政治历史等相关的;等等。

五、使用境外集团AI面向境内公众提供服务的主要法律风险

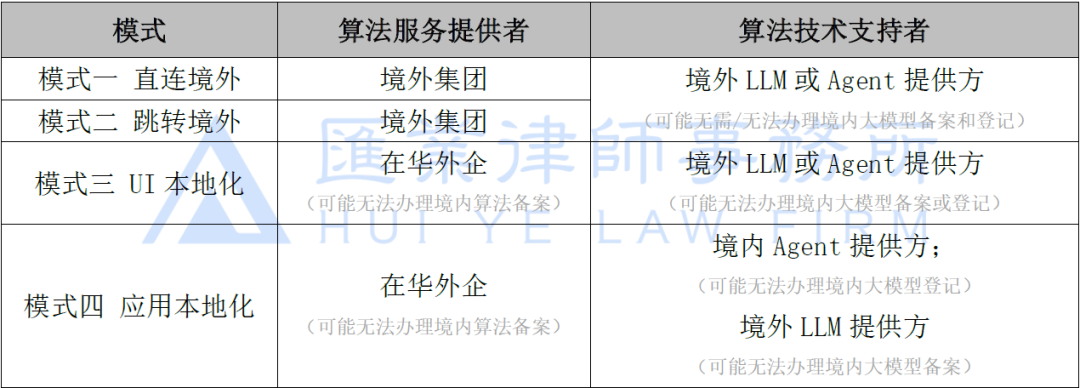

根据第一部分的分析,不同技术路径下,使用境外集团AI面向境内公众提供服务的,中国法项下的算法/大模型服务提供者角色及相关的备案合规义务也不同,具体如下:

在模式一、二中,虽然境外集团(含提供方)可能无需办理算法/大模型备案,但若一旦发生违反《网络安全法》等规定相关信息安全事件,相关的应用服务可能会被阻断,影响在华业务连续性。此外,这两种模式下,还可能会被认定为境外公司直接在华开展经营活动,进而诱发相关的准入、资质法律风险。在模式三、四中,可能还会面临相关应用无法上架应用商店、分发平台的风险。

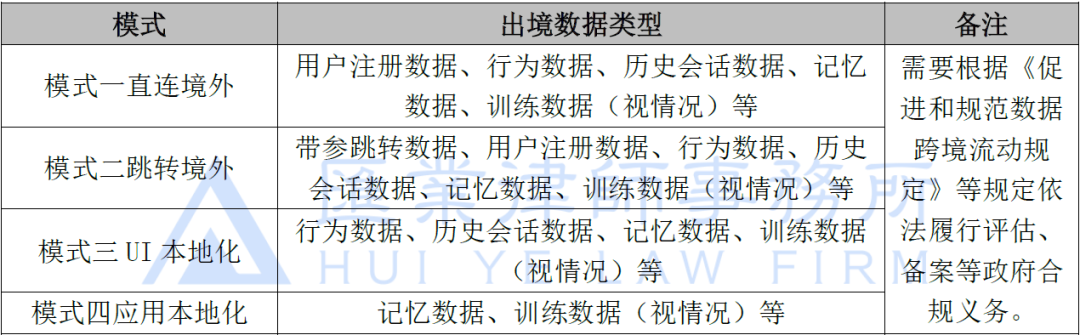

此外,结合第一部分不同技术路径,使用境外集团AI面向境内公众提供服务的,可能存在的数据出境情况具体如下:

在模式一、二中,涉及在境外直接处理境内个人信息,按照中国《个人信息保护法》及相关监管口径,仍然应当履行中国数据出境的相关法律义务。关于用户相关数据是否用于算法/模型训练,面向企业版本的主流大模型都是默认关闭的,面向个人版本的主流大模型需要用户自行关闭。关于LLM/Agent记忆,不同解决方案也各有差异。

此外,除非用户自行同意用于算法/模型训练,相关的历史会话数据(prompt及生成内容)通常是结构化存储在应用层而不是模型层;即便用于模型训练,模型层训练后的参数及记忆,也不直接存储用户的历史会话数据。同时,应用层可能会基于风控、滥用及审计等目的,可能会临时性查看用户的历史会话数据。

绝大多数跨国公司境外总部部署的AI解决方案,模型层通常是大模型厂商提供商业版,应用层通常是境外总部自行或委托供应商开发部署,当然这两者的数据存储、处理都可能依赖云服务商的云环境。

更多法律风险评估维度,请参考《汇业研究 | 企业上线AIAgent的主要安全风险与合规自评估清单》

声明:本文来自网络与数据法律实务,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。