人工智能发展的势头越来越猛,由此也引发了各界人士对安全问题的深思,人文学科领域的学者从道德伦理与哲学规范的角度对安全问题提出了担忧,人工智能技术领域的学者也从系统安全的角度对安全问题进行了剖析。

人工智能的概念

人工智能(AI, Artificial Intelligence) [1]是研究、开发用于模拟、延伸和扩展人类智能的理论、方法、技术及应用系统的一门新技术科学。其目标是基于对智能实质的理解,生产出一种能够以类似于人类智能的方式做出反应的新型智能机器。

美国斯坦福大学人工智能研究中心尼尔逊教授给出的定义为:“人工智能是关于知识的学科――怎样表示知识以及怎样获得知识并使用知识的科学。”而美国麻省理工学院温斯顿教授认为:“人工智能就是研究如何使计算机去做过去只有人才能做的智能工作。”

这些说法反映了人工智能学科的基本思想和基本内容,即通过研究人类智能活动的规律构造出具有一定智能的人工系统,研究如何让计算机去完成以往需要人的智力才能胜任的工作,也就是研究如何应用计算机的软硬件来模拟人类某些智能行为的基本理论、方法和技术[2]。

简单来说,人工智能是研究用计算机来模拟人的某些思维过程和智能行为(如学习、推理、思考、规划等)的学科。它由不同的领域组成,如机器学习,计算机视觉等等。

Alpha家族

2016年1月27日,AlphaGo在没有任何让子的情况下,以5:0完胜欧洲围棋冠军、职业二段选手樊麾。在围棋人工智能领域,实现了一次史无前例的突破。计算机程序能在不让子的情况下,在完整的围棋竞技中击败专业选手,这是第一次[3]。

2016年3月,AlphaGo Lee与围棋世界冠军、职业九段棋手李世石进行围棋人机大战,以4比1的总比分获胜,举世哗然,人工智能概念开始被大众熟知。

2016年末2017年初,AlphaGo在中国棋类网站上以“大师”(Master)为注册账号与中日韩数十位围棋高手进行快棋对决,连续60局无一败绩。

2017年5月,在中国乌镇围棋峰会上,AlphaGo Master以3比0的总比分战胜排名世界第一的世界围棋冠军柯洁。在这次围棋峰会期间的2017年5月26日,阿尔法围棋还战胜了由陈耀烨、唐韦星、周睿羊、时越、芈昱廷五位世界冠军组成的围棋团队。在柯洁与阿尔法围棋的人机大战之后,阿尔法围棋团队宣布阿尔法围棋将不再参加围棋比赛。

2017年10月18日,DeepMind团队在《Nature》上公布了最强版阿尔法围棋 ,代号AlphaGo Zero。其独门秘籍是“自学成才”,而且是从一张白纸开始零基础学习,经过短短3天的自我训练,AlphaGo Zero就以100:0的战绩强势打败了AlphaGo Lee。

2017年12月5日,AlphaGo Zero进行了升级,在三天内自学了三种不同的棋类游戏,包括国际象棋、围棋和日本的将军棋,无需人工干预。

2018年12月7日,AlphaGo Zero登上《Science》杂志封面,完整论文首次公开。

人工智能发展的忧虑

大众已将人工智能视为第四次科技革命,相比于科学界与技术界对人工智能技术发展的兴奋,政治和哲学界等人文学科领域却对此产生了忧虑。一方面,人类认知能力的核心——思考能力可能正随着对互联网的与日俱增的依赖而逐渐退化;另一方面,人工智能技术不断发展,未来可能会出现机器人无视道德伦理与哲学规范的状况。

Henry A. Kissinger作为一名历史学家和客串政治家,长期关注着阿尔法家族的发展。Henry A. Kissinger因AlphaGo的问世而产生忧虑,未来人工智能对人类的认知能力会产生怎样的影响呢?在2018年6月发表的一篇文章中提出了四点人工智能可能引发的安全问题[4]。

1. 人工智能可能会给人类带来意想不到的后果。人工智能可能无法正确理解人类指令的具体语境,从而有可能出现人工智能系统的运行偏离设计者意图的状况,甚至造成灾难。

2. 人工智能可能会改变人类的思维方式和价值观。AlphaGo在击败围棋世界冠军时所采用的策略是前所未见的,在学习如何赢得围棋比赛的过程中,人工智能与人类的思维方式是完全不同的,已经改变了围棋对弈的本质以及人类围棋对弈的传统思维范式。

3. 人工智能可以实现其被赋予的既定目标但无法解释实现过程背后的基本原理。如果人工智能的计算能力继续快速进步,那么它或许很快就能够以与人类略微不同或者截然不同的方式对场景进行优化,届时人工智能是否能够以人类能理解的方式来证明它的场景优化更优呢?如果人类无法通过自己能够理解的方式去解释这个世界,届时人类意识本身会落入怎样的境遇呢?

4. 人工智能这个用词可能并不恰当。此前智能机器人是在人类认知能力的参与下解决问题,而现在人工智能可以采用人类此前从未想到过的,从未采取过的“思维方式”来解决问题。如AlphaZero不需要注入人类对弈数据,仅仅通过几个小时的自我对弈训练就获得了国际象棋大师的对弈水平。

Henry A. Kissinger与Eric Schmidt, Daniel Huttenlocher两位学者联手于2019年8月发表了一篇文章[5],该文章表示人工智能革命是不可阻挡的,三位作者对此都保持乐观态度,力图理解人工智能及其后果,积极应对。文中以机器能帮助指导其自身的演变,改进自己来更好地解决他们被设计用来解决的问题为切入点展开讨论,提出了一些关于“人工智能将改变人类对真理与现实的认知”这一不可避免的问题的应对措施:建立“人工智能伦理”新领域;为数字助理编写拒绝回答哲学问题的程序;要求人类参与高风险的模式识别……

人工智能与安全

Dawn Song在Faculty Summit 2017上从三个方面剖析了人工智能与安全的关系[6]。

(一)人工智能领域可以从安全领域学到什么?

人工智能系统应当具有完整性、机密性,并防止人工智能的滥用。其中完整性指的是人工智能系统应生成预期的正确结果,机密性指的是人工智能系统不能泄露用户的敏感数据。

关于完整性的研究衍生出了对抗机器学习,攻击者利用AI可以做到:使得学习系统不能生成预期的正确结果;使得学习系统生成由攻击者设计的目标结果;学习个人的敏感信息。

目前对抗样本的研究主要集中于目标模型已知的图像识别任务,Dawn Song在演讲中详细介绍了两种对抗攻击模型。

1. 生成模型

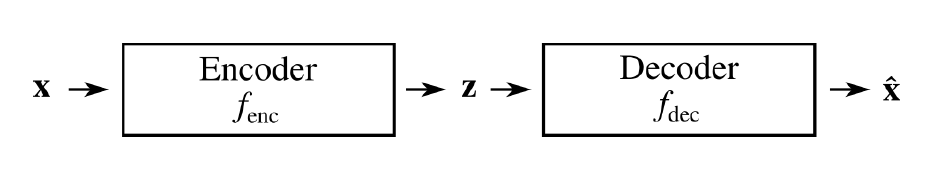

类VAE模型使用一个中间向量表示,包括编码器和解码器两部分,编码器的作用是将一个高维输入映射到低维向量表示z,解码器的作用是将中间向量表示映射到高维重构。

2. 深度强化学习

Dawn Song在此部分主要介绍了其发表的《Delving into adversarial attacks on deep policies》这一论文的研究内容,文章的主要成就为:

(1) 比较了随机噪声和对抗样本对深度强化学习模型的影响。

(2) 提出了利用增强学习策略中的值函数来引导攻击者选择在原始样本中添加对抗扰动的时间。

(3) 通过重新训练来增强模型对随机噪声和FGSM攻击的稳定性。

(二)安全领域可以从人工智能领域学到什么?

安全性是部署AI系统所面临的重大挑战之一,AI学习系统有三个层面的安全性。

1. 软件层面

攻击者可以通过利用软件脆弱性控制学习系统,所以学习系统的设计应避免软件脆弱性,如缓冲区溢出和访问控制问题。

2. 学习层面

(1) 应使用对抗事件而不仅仅是正常事件来评估系统;

(2) 研发适用于复杂的、非符号程序的推理的高效工具与技术;

(3) 设计具有更强的普遍化以及安全保证的新结构或新方法,Dawn Song提出可以将递归的概念引入到神经程序中。

(4) 通过多个组件进行合成推理。

3. 分布式层面

每个代理都只能进行局部决策,应怎样制定局部决策以达到更优的全局决策?

(三)在人工智能出现后安全领域呈现出怎样的状况?

攻击者往往紧跟科技发展的脚步,甚至引领科技的发展,AI的发展为攻击者提供了更高级的技术支持。随着AI普及到越来越多的系统,攻击者对系统攻击也产生了越来越浓厚的兴趣;随着AI的能力越来越强大,攻击者滥用AI的后果也越来越严峻。

Dawn Song在演讲的最后关于人工智能与安全的未来抛出了几个令人深思的问题:怎样更好地理解安全对于AI及学习系统意味着什么?怎样检测出某个学习系统什么时候被欺骗?怎样构建具有更强的安全保证,更有弹性的系统?怎样减轻AI的滥用?确保安全AI的正确策略应当如何制定?

AI对抗攻击

AI对抗攻击已成为一个新的研究热点,研究内容主要包括对抗攻击的方法和对抗攻击的防御方法,对抗攻击的方法即对抗样本的生成方法[7]。

常见的对抗攻击的方法有快速梯度攻击、雅克比映射攻击、深度欺骗攻击和边界攻击。

快速梯度攻击(Fast Gradient Sign Method,FGSM) [8]由Ian Goodfellow提出,主要思想是寻找深度学习模型的梯度变化最大的方向,按照此方向添加图像扰动,导致模型进行错误的分类。FGSM以增加对图像分类器损失的方式来对图像添加扰动。通过FGSM构造对抗样本的优势是效率比较高,最终生成的对抗样本会对原图所有像素点都产生一些微小的扰动。FGSM作为经典的攻击方式,衍生出了许多以FGSM为基础的对抗攻击方法。

雅克比映射攻击(Jacobian-based Saliency Map Attack,JSMA) [9]是对原图添加有限个数像素点的扰动,从而构造出对抗样本的攻击方式。JSMA通过分析评估模型的前向传播过程,计算模型的前向导数,然后根据前向导数的梯度计算一个数值。每个像素点会对应算出一个数值,这个值越大,说明对这个像素点的微小扰动能更大程度地产生输出误判,所以只需要选择数值大的像素点进行扰动,就能在尽可能少地修改像素点的情况下,实现对抗攻击。

深度欺骗攻击(DeepFool)[10]首先初始化原始图像,并且假定该图像分类被分类器的决策边界限制,这个区域决定图像的类标签。在每一次迭代中,该算法通过一个小的向量来扰动图像,这个小的向量通过线性化图像所在区域的边界,逐步将图像移向决策边界,直到图像最终被移动到决策边界另一侧,使得分类器分类错误,此时得到的扰动的累加就是对抗攻击的扰动。研究结果显示,DeepFool算法能够计算出比FGSM所计算的扰动更小的扰动,同时具有类似的欺骗率。

边界攻击(Boundary Attacks) [11]是由Brendel等提出的一种基于边界的黑盒攻击方式,区别于大多数依赖于梯度的攻击方式,该攻击需要的模型信息很少,只需要知道模型最终的分类输出结果即可。在攻击分类中,其需要任意输入输出的能力,能实现源/目标误分类。该方法首先寻找到一个对抗样本 (不限制阈值大小),然后依据一定策略将该对抗样本沿着原样本的方向移动,直到该对抗样本离原样本最近,同时依然保持对抗性。

目前,针对对抗攻击的防御方式主要可以分为以下3类:

1. 修改训练数据或测试输入,在训练阶段改动训练样本或者在预测过程中修改输入数据;

2. 修改神经网络模型,比如增加网络层、添加子网络、修改损失函数和激活函数等;

3. 在对未知图像进行分类时,使用一些附加工具作为神经网络模型的辅助工具。

第1种方法并不直接对网络模型进行修改,另外两种方法都是针对网络模型本身的特性进行改进。

对抗攻击是深度学习在安全领域中的热点问题,影响人工智能系统的可用性,威胁系统安全。例如在垃圾邮件检测系统和入侵检测系统中,针对系统模型热点来逃避检测;针对面部识别系统缺陷来模仿受害者身份的非法认证危害;针对医疗数据、人物图片数据的隐私窃取危害;针对自动驾驶汽车、语音控制系统的恶意控制危害等等。

总结

人工智能的快速发展虽然为我们的社会带来诸多便利,但我们也应思考如此发展下去未来可能会出现的安全问题,积极制定应对措施尽早行动起来。

参考文献

[1] 本刊编辑部.人工智能概述[J].保密科学技术,2017(11):8-9.

[2]https://baike.baidu.com/item/%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD/9180?fr=aladdin

[3] http://tech.163.com/18/1228/09/E43QGTKT00098IEO.html

[4] Henry A. Kissinger. How the Enlightment Ends. 2018, 6.

[5] Henry A. Kissinger, Eric Schmidt, Daniel Huttenlocher. The Metamorphosis. 2019, 8.

[6] Dawn Song. Faculty Summit 2017, AI and Security.

[7] Akhtar N, Mian A. Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey[J]. IEEE Access, 2018, 6:1-1.

[8] Goodfellow I,Shlens J,Szegedy C. Explaining and Harnessing Adversarial Examples[EB/OL]. (2015-03-20) [2019-06-12]. https://arxiv. org/abs/1412.6572.

[9] PAPERNOT N,MCDANIEL P,JHA S,et al.The limitations of deep learning in adversarial settings[C]∥IEEE European Symposium on Security and Privacy (EuroS&P) .Saarbrucken,Germany:IEEE,2016:372-387.

[10] MOOSAVIDEZFOOLI S,FAWZI A,FROSSARD P.DeepFool:A simple and accurate method to fool deep neural networks[EB/OL]. (2015-11-14) [2019-06-12].https:∥arxiv.org/abs/1511.04599.

[11] BRENDEL W,RAUBER J,BETHGE M.Decisionbased adversarial attacks:Reliable attacks against blackbox machine learning models[EB/OL]. (2017-12-12) [2019-06-12].https:∥arxiv.org/abs/1712.04248.

作者:马瑜汝 大象无形

声明:本文来自中国保密协会科学技术分会,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。