来源:venturebeat

黑镜中的无人机杀手让人恐慌,同时也激起了业内对于人工智能在军事领域应用的探讨。五角大楼近日在相关军事领域迈出了重要一步。

美国国防创新委员会(The Defense Innovation Board)今天官网上放出了一个消息,国防部投票通过了一份叫做《AI使用原则:人工智能使用道德规范的若干意见(AI Principles:Recommendations on the Ethical Use of Artificial Intelligence)》的文件。

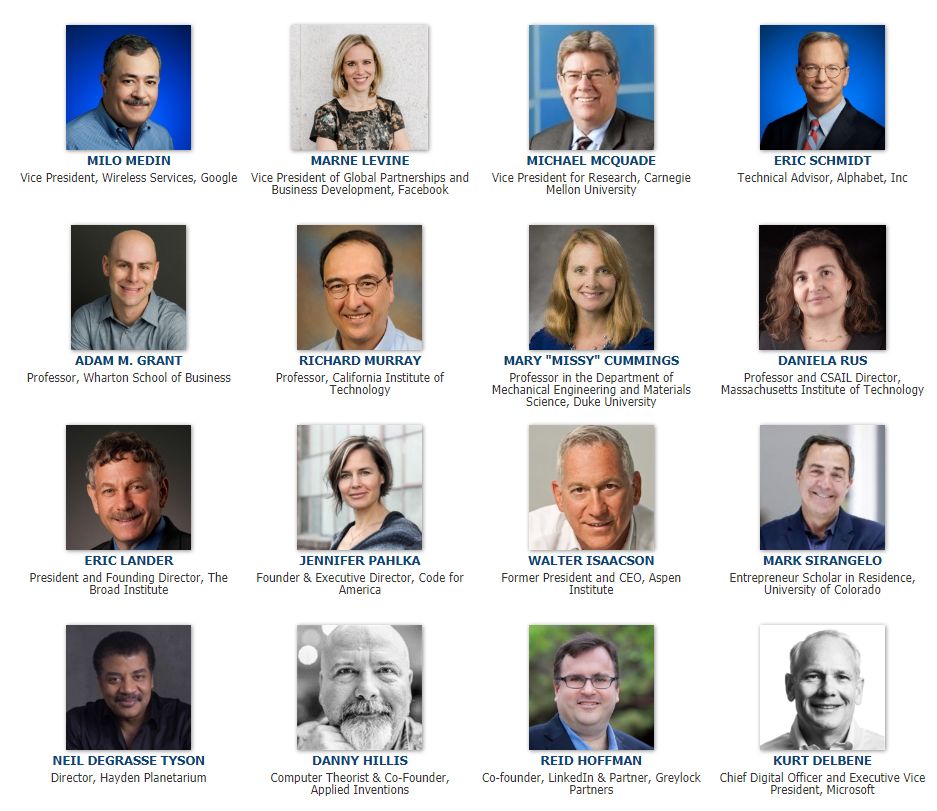

这份文件耗时15个月完成,16位杰出技术专家组成了专家小组负责为五角大楼提供这份报告,这份报告也征求了李飞飞、Yan Lecun在内的人工智能领域的专家的意见。

这份报告包括五个主要原则,以及对于美国军方在未来如何在战斗和非战斗人工智能系统中应用道德规范的12条建议。

先来看看这五条基本原则。

负责任。

谨慎判断,对国防部人工智能系统的开发、部署、使用和结果负责。

公平。

通过深思熟虑的程序,避免在开发和部署战斗或非战斗人工智能系统时无意中对人造成伤害。

可追踪。

国防部的人工智能工程研究应该足够先进,使技术专家对其人工智能系统的技术、开发过程和操作方法有足够理解,包括透明和可审计的方法、数据源、设计程序和文档。

可靠。

国防部人工智能系统应该有一个明确的、定义良好的使用领域,这些系统的安全性、安全性和稳定性应该在其使用领域的整个生命周期中得到测试和保证。

可控。

国防部人工智能系统的设计和工程使用应能实现其预期功能,同时具备探测和避免意外伤害或干扰的能力,并在发现已部署系统发生意外升级或其他行为时,可以自动脱离或人工停用。

此外,这份报告还包括12条建议。

通过国防部官方渠道将这些原则正式化;

建立一个全网范围的人工智能指导委员会;

进一步培育和发展人工智能工程领域;

加强国防部的培训和人才计划;

投资于人工智能安全方面的的新研究;

投资于研究以增强技术的可重复性;

定义(人工智能)可靠性的基准;

加强人工智能测试和评估技术;

开发风险管理方法;

确保AI伦理原则的正确执行;

将研究扩展到理解如何实施AI伦理原则;

召开关于人工智能安全性、安全性和稳定性的年度会议。

文件链接:

https://media.defense.gov/2019/Oct/31/2002204458/-1/-1/0/DIB_AI_PRINCIPLES_PRIMARY_DOCUMENT.PDF

“你可能会在这里看到公平这个词。但是要提醒的是,在许多情况下,国防部不应该是公平的,DIB 董事会成员和卡内基梅隆大学研究副总裁 Michael McQuade 今天说。“我们的原则应该是,在我们的系统中不存在无意的偏见。”

应用发明公司联合创始人、计算机理论家Danny Hillis和董事会成员一致认为该文件草案还需要修改,使用原则还应包括“避免意外伤害和破坏,以及人类脱离部署的系统,”Hillis说,这份报告应该明确无误地指出,军方使用的人工智能系统应该带有一个关闭开关,以便人类在出现问题时可以立刻关闭。

他说:“我认为这是最大的问题,因为他们具备展示和演化行为方式的能力,这对设计师来说是很难预测的,有时这些行为形式实际上是一种自我保护的行为形式,可能与设计师的意图和目标不同步,所以我认为这是他们潜在的最危险的方面之一。”

国防创新委员会是一个科技精英荟萃的组织,由前谷歌CEO Eric Schmidt 担任主席,成员包括麻省理工学院CSAIL主任 Daniela Rus,海顿天象馆奈尔·德葛拉司·泰森研究中心主任,LinkedIn联合创始人Reid Hoffman,Code for America主任Jennifer Pahlka,以及Aspen Institute主任Walter Isaacson。

一位国防部发言人在接收海外媒体VentureBeat采访时称,这份文件以及相应的白皮书将在国防创新委员会网站上分享。两者现在都会呈交国防部领导层,由他们来决定是否采用其中的原则。

此前,英国《卫报》曾报道称,五角大楼正寻找合适的人选,帮助其在被称为21世纪战场的人工智能领域应对模棱两可的道德问题。五角大楼联合人工智能中心(JAIC)主任杰克·沙纳汉中将曾对记者表示:“我们将要填补的职位之一需要的人选不仅能够考虑技术标准,而且得是一名伦理学家。”

未来,委员会希望负责领导国防部人工智能计划的联合人工智能中心与国防部部长马克·埃斯珀合作,制定沟通和政策,以确保原则能够成功被应用,加强人工智能的测试和评估,并创建一个每年一度的人工智能安保会。

这些伦理原则通过两次假想敌演习来观察AI如何影响作战决策,并认识到AI可能出现的意外后果,当然,这些原则也符合现有的指导国防部伦理的文件,如美国宪法、2015年国防部战争法手册和1949年日内瓦公约。

这份报告还强调了中国和俄罗斯在人工智能上日益增长的投资。

本次公布的条款耗时15个月完成,收录了来自公共论坛和人工智能社区领袖的意见和见解,如Facebook首席人工智能科学家Yann Le Cun,前麻省理工学院媒体实验室主任Joi Ito,OpenAI 研究主任Dario Amodei博士,以及斯坦福大学前首席人工智能科学家Dr Fei-Fei Li。另外,原则还征集了广泛的公众意见。

Schmidt今年早些时候在斯坦福大学人工智能研究所(Stanford University Institute for Human-Centered AI)举行的一次会议上表示,国家安全委员会希望通过这份《AI使用原则:人工智能使用道德规范的若干意见》,帮助美国制定一项国家人工智能政策。

相关报道:

https://venturebeat.com/2019/10/31/defense-innovation-board-unveils-ai-ethics-principles-for-the-pentagon/

声明:本文来自大数据文摘,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。