委内瑞拉总统马杜罗演讲中突现爆炸,士兵四散逃生

来源:BBC,Twitter,作者:文强,克雷格

就在不到一小时前,委内瑞拉总统尼古拉斯·马杜罗(Nicolas Maduro)在面向数百名士兵发表讲话时,一架搭载炸弹的无人机朝他飞去并且引爆,总统虽然没有受伤,但目前至少有7人受到伤害。

委内瑞拉国家电视台直播记录下了全部过程。

当时,马杜罗正在为庆祝委内瑞拉国民警卫队成立81周年在广场发表讲话,他的面前是整齐列队的阅兵队伍。

在演讲过程中,马杜罗突然停了下来,朝上看去,明显事有不对。

马杜罗突然中止演讲朝上看去,旁边是他的夫人

之后,只听两次爆炸巨响,原本整齐列阵的士兵,如流水般不顾一切狂奔逃生。

原本整齐列阵的士兵四散溃去

根据Twitter上分享的图像显示,马杜罗周围的军官在护送他离开现场时,似乎竖起了黑色的防弹屏障。

警卫人员在马杜罗周围竖起黑色防弹屏障

护送马杜罗离开现场

委内瑞拉新闻部长豪尔赫·罗德里格兹(Jorge Rodriguez)随后表示,总统没有受到伤害,不过有7人受伤。

“下午5点41分正,我们听到几声爆炸声,“罗德里格斯在事件发生几分钟后在面向委内瑞拉全国播放的现场演讲中说道:“调查清楚地表明,这次袭击来自携带爆炸物的无人机装置。”

不过,爆炸现场的消防员对政府对此事件的理解提出了质疑。

三名不愿透露姓名的地方当局人士表示,事件实际上是在马杜罗演讲现场附近的公寓内瓦斯爆炸。从建筑物的窗户可以看到烟雾。

委内瑞拉政府经常指责反对派活动人士策划攻击并推翻马杜罗政府。

去年,委内瑞拉几乎每天都会发生抗议活动。有一次,一名反对派警察(a rogue police officer)就在委内瑞拉首都上空操控一架被盗的直升机,在几座政府大楼内投下了手榴弹。

袭击发生后,委内瑞拉社会党高级领导人迪奥斯达多·卡贝洛(Diosdado Cabello)在Twitter发文将事件称为“恐怖主义袭击”,他说:“右翼分子坚持使用暴力占据他们无法用选票赢得的公共场所。”

根据新华社和环球网报道,委内瑞拉内政部之后证实,一架载有爆炸物的无人机,欲对总统马杜罗展开“暗杀行动”,但最终失败。马杜罗没有受伤并已离开现场。据当地记者引述非官方消息称,该架无人机载有强力C4炸弹,在飞至总统讲台附近爆炸,导致多名军人受伤。

AI导航,杀人机器要出现?

刚刚在委内瑞拉发生的这一幕,不由得让人想起了之前联合国在特定常规武器公约会议上发布了一段“杀人机器人”视频:

视频中,类似杀人蜂的小型机器人通过面部识别系统辨别射杀对象,结合AI导航技术,飞入会场后躲过演讲人的抓捕,发现目标后迅速将其击毙。

从具体的配置上看,这个机器人配有广角摄像头、战术传感器、面部识别技术,并且在其内装有3克炸药。

精准打击,足以穿透头骨。

视频最后还演示了一段飞行机器人集体攻击人类的画面,通过面部识别定位,轻易杀死了正在上课的一班学生。

美国政府在全球范围内使用升级的军用无人机后,工程师和科学家们警告说,自主机器很容易受到黑客的攻击,它们可能被劫持,进而攻击无辜的人群;并且,它们不可避免地很容易就会被恶意攻击者获得,或者恶意攻击者能够自己制造这类武器。

同样是无人机,剑桥研发“暴力检测”系统精准识别人群暴力

长期以来,人工智能和武器控制专家一直在讨论,哪些领域、产品特别应该受到管制或禁止,以及如何执行。

制作杀人机器人是机器人学家极力避免的事情,过度的渲染也会引发公众对机器人不必要的恐惧。

实际上,同样是基于无人机,来自英国剑桥大学、印度国家技术研究院和印度科学理工学院的研究人员,就研发了一款“暴力行为”检测系统,能够识别人群中踢打、刺伤或掐脖子等暴力动作,准确率达到85%以上。

研究人员称,该系统可用于在马拉松和音乐节等户外活动中通过无人机自动发现暴力事件。研究论文发表了CVPR 2018上。

这种AI技术利用悬停式四轴飞行器上的摄像头来检测每个人的身体动作。然后,当系统识别出攻击性的行为,如拳打、脚踢、刺杀、射击、掐脖子等时,它就会发出警报。它不识别人脸——只是监测人们之间可能的暴力行为。

AVI数据集中的暴力行为,包括掐脖子,拳打,脚踢,射击和刺杀

研究人员表示,这个系统可以扩展到自动识别非法越境的人,在公共场所发现绑架事件,并在发现暴力行为时发出警报。他们希望这样的自主间谍无人机可以帮助警察压制犯罪,或帮助士兵在无辜群众中找出敌人。

“执法机构已经在使用空中监视系统来监视大面积的区域,”研究人员在他们的论文中写道,“各国政府最近在战区部署无人机来监测敌人的行动,监视外国贩毒组织,开展边境管制行动以及在城市和农村地区监控犯罪活动。”

“他们一般安排一名或多名士兵长时间地操控这些无人机,这使得这些系统容易因人为疲劳而出错。”

可用于检测公共区域或大型聚会中的暴力分子姿态估计pipeline

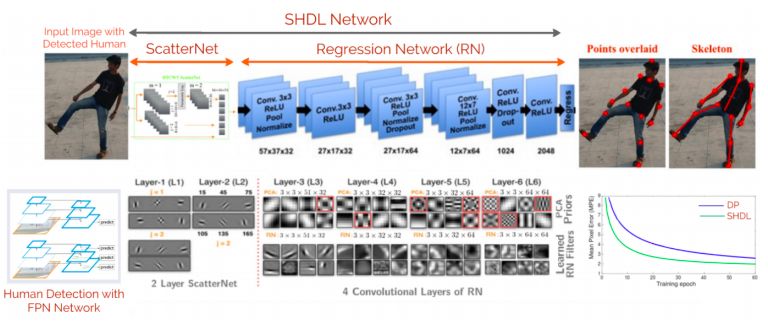

研究者提出的新模型分两步工作。首先,特征金字塔网络(一种卷积神经网络)从无人机拍摄的画面中检测到个人。然后,使用一个ScatterNet网络来分析和确定图像中每个人的姿势。

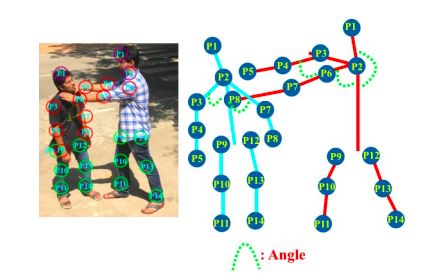

身体的轮廓被分解为14个关键点

模型将身体的轮廓分解为14个关键点,计算出一个人的手臂、腿和脸的位置,以识别训练过程中指定的不同类型的暴力行为。

当系统需要处理的人数更少时,准确率最高。比如一张图片上只有一个人,系统的准确率为94.1%,但有5个人时,准确率就降到了84%,10个人时准确率降到79.8%。该论文的合作者Amarjot Singh说:“准确性下降主要是因为系统没有检测到其中的一些人。”

商业无人机袭击造成的心理恐慌影响更大,人们更应警惕自主武器

目前,“Slaughterbots”(《屠杀机器人》里面的情景在现实中并未出现,马杜罗总统也没有在这次无人机袭击中受伤。

尽管商用无人机在全球各地都很容易买到,使用无人机袭击的事件越来越多,但无人机能够运送的小型军用弹药会造成更多的心理伤害而不是物理伤害。

美国安全智库Stratfor战术分析副总裁、前美国国务院特工Scott Stewart不久前撰文认为,受制于有效载荷等因素影响,如果使用武装商用无人机攻击大量人群,造成的心理影响可能伤害更大。

例如,无人机袭击造成的恐慌引起的踩踏事件可能会造成比爆炸更多的伤害。因此,重要的是人们要意识到无人机威胁的极限,以免过度反应并将攻击的影响与践踏伤害相乘。因为此时的无人机在灌输恐惧方面可能比造成实际的物理损害更为成功,从这个意义上讲,无人机可被归类为真正的恐怖主义武器。

不过,更应注意的是AI在无人机上的应用,这会让无人机成为自主杀人武器。

“Slaughterbots”(《屠杀机器人》设想的场景、剑桥大学研究员Amarjot Singh做的无人机观察暴力人群以及谷歌饱受争议的Maven项目,都是将AI用于无人机,并且有的已经成为自主杀人武器。

谷歌与国防部合作的Maven项目遭到员工反对

自主杀人武器是AI界一直予以抵制的范畴。上个月,马斯克、哈萨比斯、泰格马克等2000多名AI学者、企业领袖在斯德哥尔摩IJCAI上签署宣言,誓言绝不将他们的技能用于开发自主杀人机器。

今年4月,由于韩国KAIST大学与军工企业“韩华 Systems”合作研发自主武器,遭到Hinton、Bengio、以及周志华教授等50多名学者联名发公开信抗议。

为何自主杀人武器会遭到AI专家们的反对?

周志华教授在接受新智元采访时表示,自主武器和一般意义上的智能武器不是同一个概念,一般的智能武器,或者叫“智能化武器”,其实早就有了,例如自动瞄准装置、导弹定位系统等等,但是最终做决定的都是人类。

而自主武器,是要把这个“决定权”交给机器,让机器自己去决定是否进行对人类的毁灭性打击,这太危险了。

自主武器有可能成为恐怖分子的武器。暴君和恐怖分子可以利用它们对付无辜的人群,他们不会理会任何的道德限制。如果打开了这个潘多拉魔盒,将很难关闭。与过去禁用其他技术,例如禁用激光致盲武器(blinding lasers)一样,我们可以简单地决定不开发自主武器。

参考资料:

https://www.bbc.com/news/world-latin-america-45073385

https://worldview.stratfor.com/article/when-drones-attack-threat-remains-limited

声明:本文来自新智元,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。