作者简介

王玮

天融信科技集团股份有限公司咨询顾问,主要从事数据安全、个人信息保护等工作。

曹京

中国信息通信研究院安全研究所工程师,主要从事数据安全、网络安全、个人信息保护等工作。

程赓

中国铁塔股份有限公司业务支撑部总监,主要从事信息化架构和数据治理等工作。

李雪莹

天融信科技集团股份有限公司董事长,主要从事网络与数据安全、网络空间安全与产业化研究等工作。

论文引用格式:

王玮, 曹京, 程赓, 等. 降低自动化决策对个人信息安全影响的研究[J]. 信息通信技术与政策, 2022,48(8):52-58.

降低自动化决策对个人信息安全影响的研究

王玮1 曹京2 程赓3 李雪莹1

(1. 天融信科技集团股份有限公司,北京 100193;2. 中国信息通信研究院安全研究所,北京 100191;3. 中国铁塔股份有限公司,北京 100029)

摘要:自动化决策依赖用户所产生的数据进行分析评估和决策,一方面提升了企业的工作和服务效率,另一方面也导致用户被窥探、被杀熟、被操纵的感受日渐强烈。在涉及自动化决策的业务场景之下,如何降低个人信息安全影响成为难点。通过分析自动化决策对个人信息安全影响的决定因素来探讨个人信息安全影响的降低方法,为企业在自动化决策过程中的个人信息保护提供参考。

关键词:自动化决策;个人信息安全影响;个人信息权益;特征标签;数据安全

中图分类号:D922.16;TP309.2 文献标志码:A

引用格式:王玮, 曹京, 程赓, 等. 降低自动化决策对个人信息安全影响的研究[J]. 信息通信技术与政策, 2022,48(8):52-58.

DOI:10.12267/j.issn.2096-5931.2022.08.008

0 引言

人工智能时代,万物皆可计算。自动化决策将人作为纯粹的数据,进行纯粹的计算。在自动化决策算法之下,用户与企业之间明显处于弱势关系,这使得自动化决策带来的担忧尤为突出[1-2]。当今,很多企业都已进行了数据安全的相关能力建设,其中也对作为有特定权属的个人信息进行了保护。但数据安全与个人信息保护之间的侧重亦有所不同,在运用自动化决策的各类业务场景之下,如何降低个人信息安全影响、如何缓解个人信息价值的发挥与保护之间的矛盾成为难点。本文浅析企业在自动化决策过程中降低对个人信息安全影响的方法,为涉及相关场景的企业提供参考,研究结果也将有助于识别自动化决策对个人信息安全的影响。

1 自动化决策的界定

数据作为生产要素成为经济增长的核心资源,无论是在政务领域、商业营销领域,还是在智能科技领域,自动化决策都被广泛地运用,但自动化决策的边界仍然有一些模糊。《中华人民共和国个人信息保护法》(简称《个人信息保护法》)第七十三条第二款中给自动化决策下了明确的定义,“通过计算机程序自动分析、评估个人的行为习惯、兴趣爱好或者经济、健康、信用状况等,并进行决策的活动”[3]。从定义中可以发现自动化决策包含了分析、评估、决策的过程,并且限定在应用技术的自动化上。若过程中有人工干预决策的结果,理论上应不属于自动化的一种。

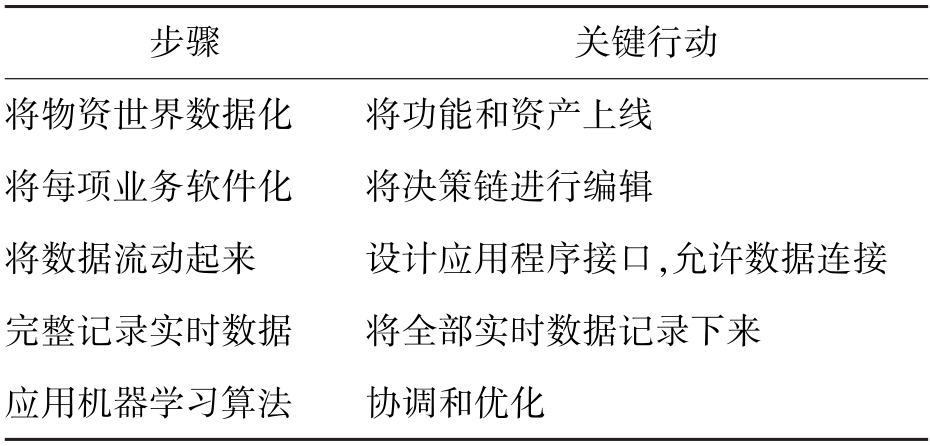

《智能战略》[4]将自动化决策分为了五个步骤(见表1):一是将物资世界数据化,这是数据资产化的起步环节;二是将每项业务软件化,这是数据高效流动的基础;三是将数据流动起来,在自动化办公和业务开展时将数据跟随业务流动起来;四是完整记录实时数据,将所有的数据作为资产留存起来,作为自动化决策的数据集输入;五是应用机器学习算法,输出包括自动化决策的结果。按照此思路,在利用个人信息进行自动化决策的前提是将人的各类特征和行为数据化,并且算法是自动化的关键特点。

表1 自动化决策的步骤

在欧盟的《通用数据保护条例》(General Data Protection Regulation,GDPR)中,自动化决策定义为完全自动的决策,即在没有人为参与下的以技术的方式做出决策,随着技术的进步和社会的发展,自动化决策需要从多个维度去解读[5]。根据其性质不同分为三大类:程序性和实质性自动决策,是指获取了程序性或实质性的决策结果;算法性和非算法性自动决策,是指通过算法或者未使用算法的方式做出的决策;基于规则和基于法律的决策,是指基于规则和基于法律做出的决策,如交通违规判别、考试录用系统等[6]。笔者认为自动化决策应当包含如下特征:采集一定数量的数据集;通过使用计算机程序、算法或规则进行的结果输出;通常会经过数据的收集、评估分析和决策三个环节,但不一定都经过评估或分析。

2 自动化决策对个人信息安全的影响

2.1 个人信息安全影响

《信息安全技术 个人信息安全影响评估指南》将个人信息安全影响认定为对个人信息合法权益的影响,包括个人权益影响和安全措施有效性两个维度[7]。欧盟数据保护委员会为应对GDPR中的相关条款给出的《法规2016/679关于数据保护影响评估(DPIA)和确定处理是否“可能导致高风险”的指南》中数据保护影响的因素,包括权益和自由面临的风险以及为应对风险所设置的措施两个方面[8]。因此,本文中关于对个人信息安全的影响同样关注两个方面:个人信息安全管控的有效性和个人信息主体权益的保护性。

2.2 个人信息安全管控

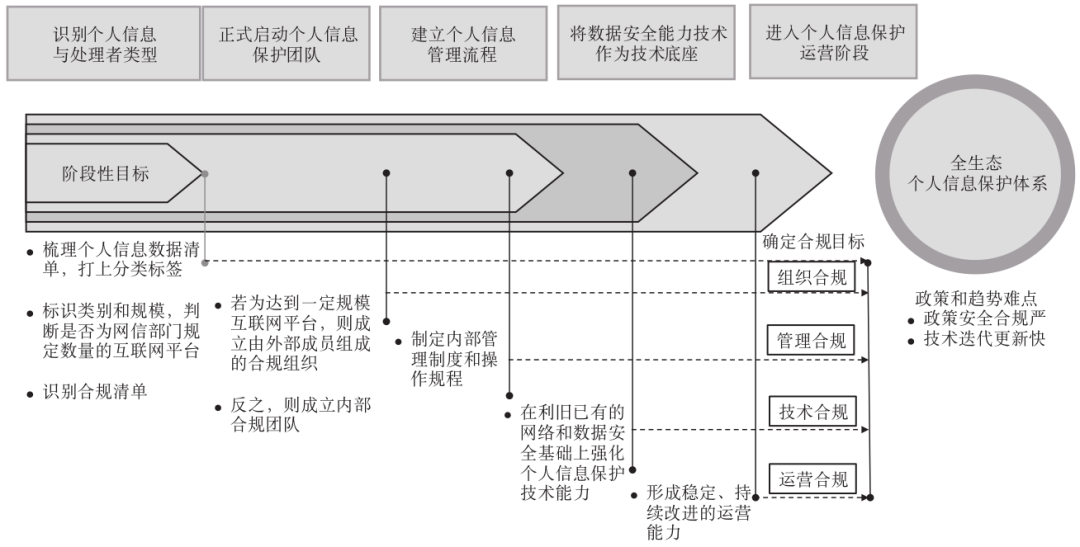

个人信息作为一种特殊的数据资产被存放在企业,需要满足不被泄露的基本安全要求。企业将已有的数据安全能力作为基础,以合规要求为抓手,做好个人信息保护,是当前的一种可行的解决方法。具体的路径包括:识别个人信息和处理者自身的类型,从而确认合规目标,启动个人信息保护团队,建立管理流,确定管控策略,通过对数据安全技术能力利旧,固化流程进入稳定的个人信息保护运营阶段,从而形成全流程、全生态的个人信息保护体系(见图1)。在数据安全技术能力的利用上需要特别注意的是在收集阶段,采用个人信息识别技术,打上个人信息种类标记,关注敏感个人信息安全;在存储阶段,应注意个人信息存储时间最小化的原则。

图1 全生态、全流程的个人信息保护体系

2.3 个人信息合法权益保护

《个人信息保护法》是以宪法为基础,关乎人权,保护个人信息权益、尊严和自由,所以在个人信息不被泄露之外,还需要保障个人信息主体的其他个人信息权益得以被响应,包括一些基本权益的响应,如知情权、决定权、撤回权、访问权、可携带权等。同时,《个人信息保护法》中除敏感个人信息主体权益外,也提出了不同类型处理者需要满足的一些具体的要求,包括在重要互联网平台服务、用户数量巨大、业务类型复杂的个人信息处理者需要履行的相关义务。

2.4 自动化决策对个人信息安全影响

在自动化决策场景下,对个人信息安全管控上的要求没有什么不同,在个人信息权益上有突出的特点。自动化决策对人的数据化、计算过程的去人性化,造成了人类主体性危机;自动化决策以轻推与操纵的方式构建人的自主决策,使人丧失自由意志,引发了人的自治性困境[2]。在《个人信息保护法》中对自动化决策下的个人信息主体权益做了更进一步的要求[3],主要包括:公平公正的权益,保证决策的透明度和结果公平、公正,不得对个人在交易价格等交易条件上实行不合理的差别待遇;提供拒绝的选项,通过自动化决策方式向个人进行信息推送、商业营销,应当同时提供不针对其个人特征的选项,或者向个人提供便捷的拒绝方式;要求解释的权益,当自动化决策对个人权益有重大影响时,个人有权要求个人信息处理者予以说明,并有权拒绝个人信息处理者仅通过自动化决策的方式做出的决定。《互联网信息服务算法推荐管理规定》对于用算法推荐技术进行服务的组织提出了相关要求[9],包括算法模型的合法合规、健全用于识别违法和不良信息的特征库、加强用户信息的标签管理等,同时也明确了相应用户的相关权益。

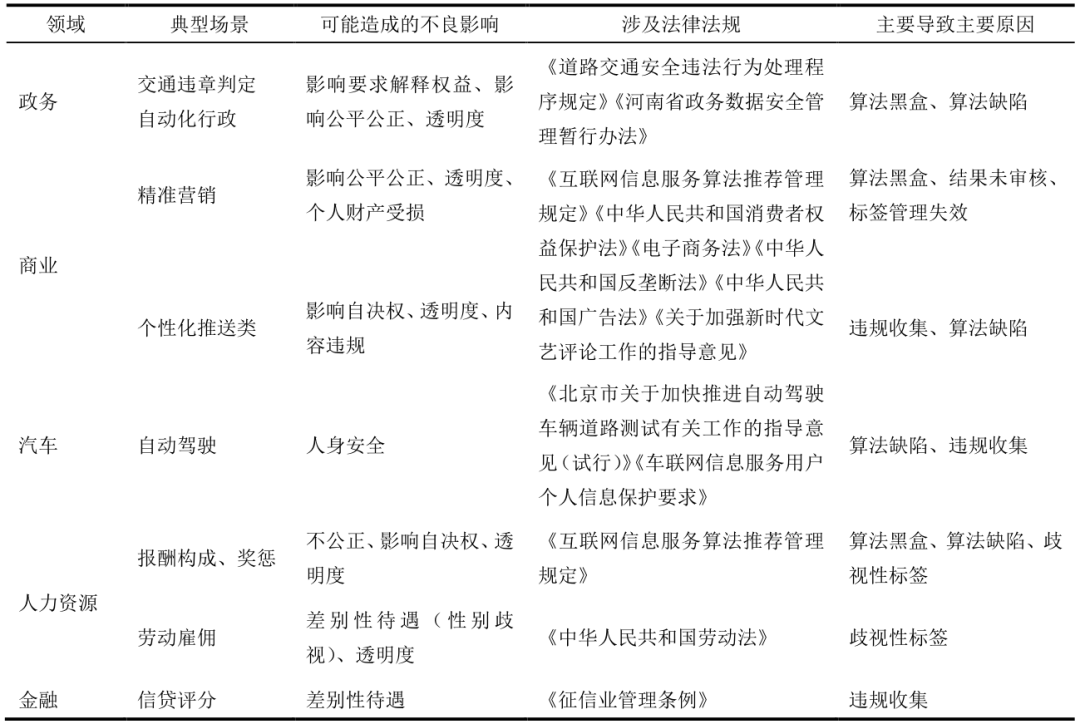

由于自动化决策的场景非常广泛,会与实际的业务和服务所处的行业有紧密的关联,各行业也陆续形成相关的法规赋予个人信息主体相关的权益,同时也给予老人、未成年人等人群特定的保护要求。由表2可见,在自动化决策的各个场景之下,导致个人信息权益受影响的原因包括:违规收集分析数据,数据的输入未经过授权收集,比如违规个人特征标签;算法黑盒,算法的原理不公开、不透明,无法向用户解释其运行机制;算法缺陷,算法自身存在不准确、不安全的问题;算法结果未审核;使用违规标签,主要是使用用户未授权标签,或者使用歧视性标签;未提供拒绝的方式。其中,由于个人科技认知的差异,透明化和进行解释成为最关键的难点。

表2 自动化场景下个人信息合法权益影响与原因分析表

3 降低自动化决策对个人信息安全的影响

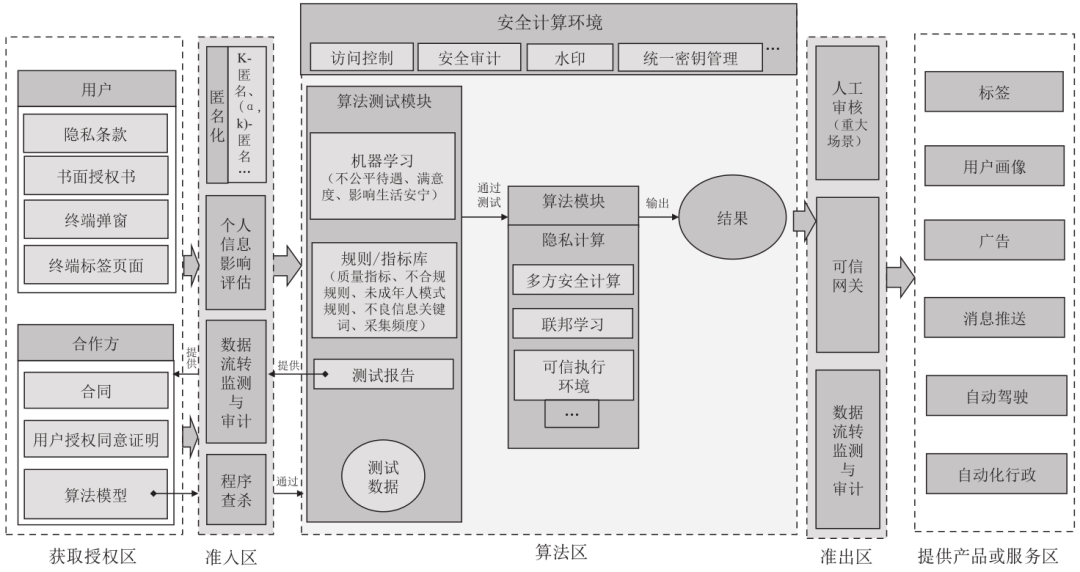

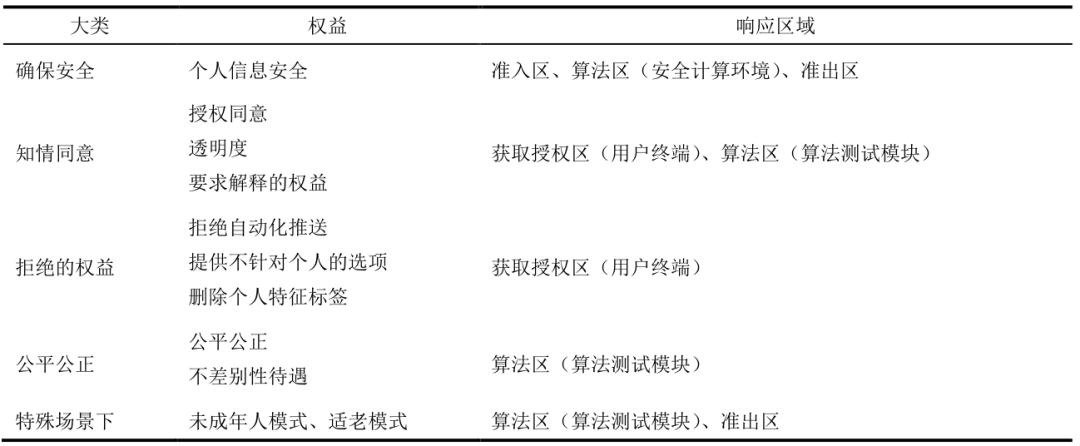

本文以健全自动化决策场景下个人信息安全管控为手段,保障个人信息主体合法权益为目的,搭建了降低自动化决策对个人信息安全影响的模型(见图2),主要包括获取授权区、准入区、算法区、准出区、提供产品或服务区,个人信息权益响应的对应关系参见表3。

图2 降低自动化决策对个人信息安全影响的模型

表3 个人信息权益响应的对应关系

3.1 获取授权区

知情同意是处理个人信息使用的先决条件。在自动化场景下,获取授权同意的对象主要包括两大类:一类来自个人信息主体,通常因提供产品或服务而收集;另一类来自合作方,如受合作方委托处理或者直接向合作方提供产品或服务,甚至运算环境。当然,在《个人信息保护》中规定的无需取得同意的例外情形,如为应对突发公共卫生事件时,可以直接进入准入区。

(1)当直接收集来自用户个人信息时,主要是通过容易触达的用户终端使用隐私条款、弹窗告知用户同意,并使用标签页,告知并会采集的相关标签;在隐私政策中,明确告知使用自动化决策或者进行用户画像分析的业务场景,对所使用的个人信息类型、目的和方式、算法推荐服务的基本原理、目的意图、运行机制等基本要素进行明示,并在具体的业务模块中使用弹窗、页面标签等形式向用户明确告知自动化决策机制的使用,并接收算法区的测试报告,以供需要时使用。

(2)涉及合作方的情况,若合作方仅仅希望得到产品或者服务(如画像等),则需要签订满足合规要求的合同;若合作方提供相关的个人信息数据,希望借助当前的计算能力获取相关数据时,则需要提供所携带相关个人信息的个人主体授权同意的证明。值得注意的是,匿名化处理后进行自动化决策的,也同样需要注意自动化决策给个人主体带来的影响。例如,在利用用户画像所做的一系列决策,可能会对个人主体造成一定的影响。

3.2 准入区

个人信息在商业应用场景下大多是通过匿名化的方式得到合法正当的支撑,当前匿名化技术主要包括K-匿名、(α, k)-匿名等,需确保匿名化的个人信息不可恢复。另外,也需通过管理手段,对当下的情景进行个人信息安全影响评估,发现当前存在的短板,采取一系列的控制措施,从而降低对个人信息安全的影响。同时,也需要使用数据流转监测与审计的技术手段保障采集的数据源安全。若合作方提供算法模型,则需要对相关的程序进行查杀,从小范围试算起步,待验证各方面符合要求方可进入计算环境。

3.3 算法区

算法区包括数据安全的保护能力应是个人信息保护的底座,故而需要使用一系列的数据安全技术手段来保障在自动化决策中的个人信息不会泄露或者过程可追溯,主要包括访问控制、安全审计、水印等,同样也包括对日志进行记录,确保所有的人为干预都被记录下来。另外,使用统一的密钥管理模块,在隐私计算所使用的秘密传输、不经意传输等密码学技术基础上,支撑各类场景下的各类计算。在数据进入自动化程序时,需检验算法是否会对个人信息权益造成影响,主要通过算法测试模块实现。算法测试模块主要包括机器学习子模块、规则/指标库子模块、测试报告子模块。

(1)机器学习子模块利用一定数量的测试数据集进入机器学习,检验相关标签的组合是否会产生不公平公正、影响到个人安宁以及客户满意度的结果。其中,除了需考虑自动化决策本身所造成的影响外,还需重点考虑在包含敏感个人信息时所造成的影响。

(2)规则/指标库子模块包括了对不合法标签的发现,主要通过测试模块内置的合规标签库,发现违法违规、不良信息的关键词。例如,职业录用时,涉及性别标签,或者其他的带有侮辱性的标签(如暴力、色情等情况)。另外,也对质量、性能指标做测试,发现算法的缺陷;针对个人信息的采集频次做指标,保证最小频率地采集个人信息。

(3)测试报告子模块,对算法的测试进行记录,形成测试报告,以通俗易懂、简洁明了的形式呈现算法的运行机制,决定算法结果的参数、算法结果的性质和类型、算法的质量,以供在自动化决策过程中,用户提出质疑或请求解释时,提供给授权区给予用户做出解释说明时使用,在此过程中也需注意企业自身的商业秘密不被泄露。在涉及与合作方合作形成数据共享和开发利用产品或服务时,可选择多方安全计算、联邦学习、可信执行环境等技术来实现涉及个人信息的数据可用而不可见,从而最大限度保障在数据开放流通的过程中个人信息安全不受影响。

3.4 准出区

在分析结果对外提供时,应通过准出区,方可提供算法结果。需要注意的是在对于个人信息主体会造成重大影响的场景下,需要人工审核的接入,来降低对个人信息的影响,例如涉及到个人征信、身体健康、教育的情形时。同时,部署数据流转监控、安全网关等设备,保障数据在传输过程中的敏感数据传输被记录和监控,确保数据提供过程中的安全。

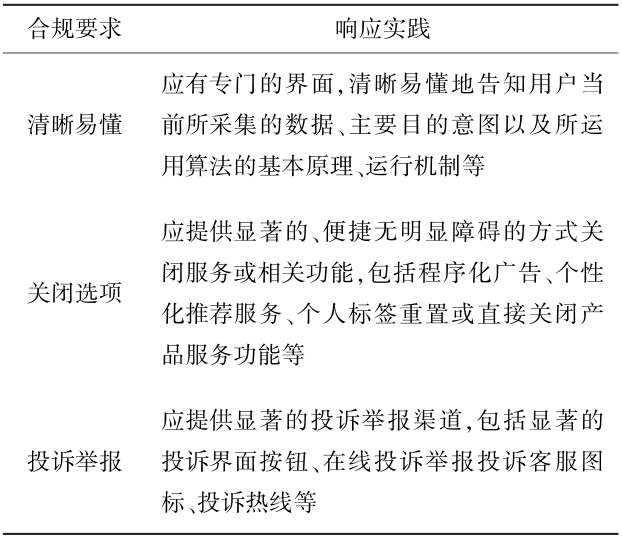

3.5 提供产品或服务区

在提供产品和服务的过程中,应当时刻关注当前所涉及到的法律法规和行业标准的监管要求,从而保障数据和产品的合规性。同时,也应当注意用户在使用服务过程中的相关诉求,如给用户设置关闭推送的功能、提供便捷的投诉和举报的途径等,具体参照表4示例。

表4 提供产品和服务过程中合规实践示例

4 结束语

数据作为生产要素成为经济增长的核心资源,掌握大量个人信息的企业也无疑掌握了一笔不小的财富,大数据技术的发展满足甚至超越了每个人的想象力,不断涌现的技术逐渐影响着人们生活的安宁,例如消费者面对大数据杀熟的无奈、乘客面对驾驶权在算法上的恐惧、弱势群体被贴上标签被不公平对待等。在自动化场景之下,每个人都让渡了自身部分自决权时,这些掌握了大量个人信息,对个人信息的处理方式具有一定决策权的组织,有义务从不同的纬度来约束自身,从而最大限度维护个人信息主体权益和自由。

参考文献

[1] 陈璞. 论网络法权构建中的主体性原则[J]. 中国法学, 2018(3):71-88. DOI:10.14111/j.cnki.zgfx.2018.03.004.

[2] 张凌寒. 自动化决策与人的主体性[J]. 人大法律评论, 2020(2):20-48.

[3] 全国人民代表大会常务委员会. 中华人民共和国个人信息保护法[Z], 2021.

[4] 曾鸣. 智能战略[M]. 北京:中信出版社, 2019.

[5] 欧洲联盟. 通用数据保护条例[Z], 2018.

[6] 孙跃元. 《通用数据保护条例》框架内的自动化决策与数据保护[J]. 网络安全技术与应用, 2020(9):53-55.

[7] 全国信息安全标准化技术委员会. 信息安全技术 个人信息安全影响评估指南[Z], 2021.

[8] 欧盟数据保护委员会. 法规2016/679关于数据保护影响评估(DPIA)和确定处理是否“可能导致高风险”的指南[Z], 2017.

[9] 国家互联网信息办公室, 工业和信息化部, 公安部, 等. 互联网信息服务算法推荐管理规定[Z], 2021.

Research on reducing the impact of automated decision on personal information security

WANG Wei1, CAO Jing2, CHENG Geng3, LI Xueying1

(1. Topsec Technologies Group Inc., Beijing 100193, China; 2. Security Research Institute, China Academy of Information and Communications Technology, Beijing 100191, China; 3. China Tower Corporation Limited, Beijing 100029, China)

Abstract: Automated decision-making relies on data generated by users. Although it improves work efficiency, it also makes users feel snooped and manipulated. In business scenarios involving automated decision-making, it is difficult to reduce the impact of personal information security. This paper analyzes the determinants of the impact of automated decision-making on personal information security, and discusses methods to reduce the impact, so as to provide a reference for enterprises to protect personal information in the process of automated decision-making.

Keywords: automated decision making; impact of personal information security; personal information rights; characteristics of the label; data security operation

本文刊于《信息通信技术与政策》2022年 第8期

声明:本文来自信息通信技术与政策,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。