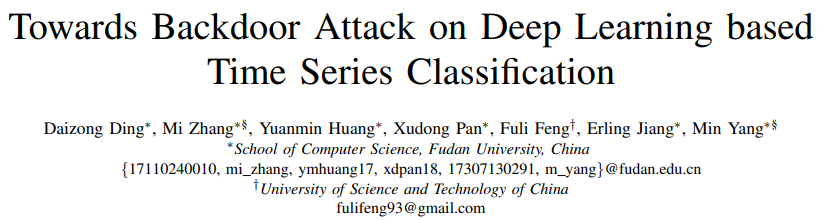

图1 深度学习模型的后门风险示意图

由于深度学习模型在时序分类上的高准确度,越来越多的商业系统采用深度学习模型来实现时序分类任务。考虑到训练深度学习模型的高成本(训练资源、训练时间等),现有一种主流的商业解决方案是交给第三方资源来训练模型,例如第三方训练平台(Amazon云服务)、第三方服务商等。但是这样的方案往往会带来相应的后门风险(图1),例如攻击者可以劫持或者攻击第三方平台,在深度学习模型中插入隐藏的功能。当模型在原环境部署后,虽然在正常样本上有着很高的准确度,但是对于带有触发器的输入就会有错误的预测行为。为了揭示现有系统在部署后会遇到的潜在威胁,本项目组提出对深度时序分类模型的后门攻击做研究。

此前研究主要着眼于针对机器视觉任务的后门攻击,例如对于图片分类任务插入后门,技术框架是基于数据投毒的攻击,即把正常样本和带有触发器的样本(标注为指定类别)同时交给模型训练,经过训练后,模型在正常样本上仍然有高性能(攻击隐蔽性),同时在带有触发器的样本上预测指定类别(攻击成功率)。从触发器的角度看,主要可以分为两类方法:静态攻击和动态攻击。其中静态攻击的触发器定义为图片上的一块特定样式的像素,比如固定值的像素块;而动态攻击的触发器定义为覆盖全图的噪声扰动。为了研究时序任务上的后门风险,项目组先研究了已有后门攻击算法在时序任务上的有效性。研究结果发现,静态攻击在此任务上的攻击成功率非常低(15.6%),远低于在机器视觉任务上的效果(通常是100%)。另一方面,虽然动态攻击的成功率稍高(30.5%),但是经过数据投毒之后模型在正常样本上的准确度从78.9%下降到68.7%,影响了模型在部署后的可用性。

针对上述问题,项目组首次提出了一个基于流形理论的分析框架,解释了时序分类任务的后门攻击难点。一方面,考虑到时序任务的流形维度较低,静态攻击中正常样本和带有触发器的样本在流形上的距离会非常小,如果把带有触发器的样本标注为错误标签,会造成模型很难建模这样的不一致,导致较低的攻击成功率。另一方面,由于低维度的性质,对样本修改较多点会导致样本飞出原本的流形空间,当注入这些样本到训练集之后,会使得训练集的数据分布出现偏移,从而影响模型在正常样本下的表现。

基于上述分析框架,项目组首次提出了一种针对深度时序分类模型后门攻击的高效解决方案:(1)尽可能把触发器的长度变小,使得带有触发器的样本始终在原样本流形空间上,保证后门攻击的隐蔽性;(2)优化触发器的位置和具体值,而不是采用固定样式的触发器,使得模型会倾向于把带有触发器的样本预测到指定类别,从而保证后门攻击的成功率。

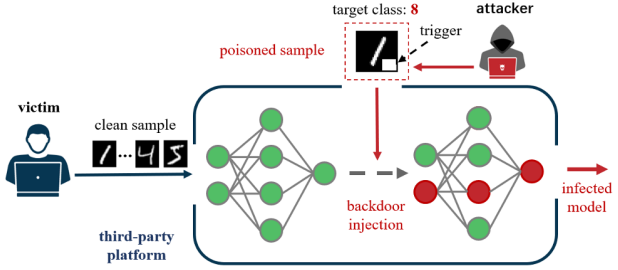

图2 项目组提出的后门攻击方案(TimeTrojan)

基于上述设计思想,项目组提出了一种针对时序分类模型的后门攻击框架TimeTrojan。核心思路是一种迭代的攻击策略,在每一轮会根据现有模型来生成最优的带有触发器的样本,然后交给模型做更新。在搜寻触发器上,项目组提出了两种策略:TimeTrojan-FGSM和TimeTrojan-DE,分别使用对抗样本和进化差分算法来做优化。项目组在三个标准时序分类数据集、六种深度学习模型上做了攻击效果验证,相比于之前的攻击算法,TimeTrojan把平均的攻击成功率从30.5%提升到了97.1%,同时模型的正常预测表现维持不变。

论文信息

本文成果发表于2022年5月举办的数据挖掘顶会IEEE International Conference on Data Engineering,作者为来自复旦大学系统软件与安全实验室的丁岱宗、张谧(教授)、黄元敏、潘旭东、姜尔玲、杨珉(教授)和中国科技大学大数据学院的冯福利(教授)。

Daizong Ding, Mi Zhang, Huang Yuanmin et al. Towards Backdoor Attack on Deep Learning based Time Series Classification, IEEE International Conference on Data Engineering (ICDE), 2022.

供稿:丁岱宗,复旦大学计算机科学技术学院系统软件与安全实验室

实验室主页:https://secsys.fudan.edu.cn/

声明:本文来自隐者联盟,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。