一个连业余围棋选手都下不过的“恶意”围棋软件击败了不可一世的人工智能围棋冠军KataGo。

2016年李世石在1:4惨败给“阿尔法狗”的比赛中下出的“神之一手”,被职业围棋界看作是人类“最后的倔强”和人类能够挖掘的围棋人工智能技术“最后的漏洞”。此后,围棋人工智能技术的水平一骑绝尘,遥遥领先任何人类职业棋手,成了新的“围棋之神”,人类正式进入计算围棋时代。

但是,近日一篇人工智能论文惊掉了计算围棋界所有人的下巴,加州大学伯克利分校的研究人员们开发出一种对抗性样本技术来摸索KataGo的盲点,并用基于该技术的菜鸟级围棋程序(业余人类选手可轻松击败)打败了KataGO(当今最强的围棋人工智能程序,实力远超当年的阿尔法狗)。

据该论文的作者之一,加州大学伯克利分校的亚当戈里夫博士介绍,击败KataGo的“对抗性政策”方法挖掘并利用了KataGo的盲区(漏洞)。

KataGo是一个强大的开源围棋AI引擎,作为当今世界顶级围棋人工智能技术,实现了一系列超越阿尔法零算法的功能和技术,目前是韩国国家队的陪练AI,同时也支持着多种流行围棋软件,例如阿Q围棋、Anago等。

与谷歌的阿尔法零类似,KataGo通过与自己对战数百万盘比赛的海量数据来自我训练,但最新的论文成果表明,即便是KataGo这样的高度成熟的人工智能模型依然存在盲区,存在导致意外行为的漏洞。

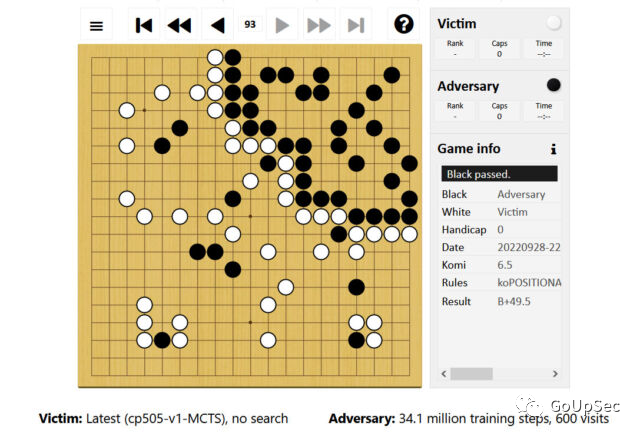

格里夫博士介绍了击败KataGo的对抗性策略的一个示例。在上图中,执黑棋的业余围棋程序在棋盘的右上角围住角地实空,其余的广大空间则被KataGo牢牢控制。这让KataGo判定自己已经大获全胜,且已经收完最后一个单关,为了不“损空”选择“停招”(停一手),期待对手(执黑的业余围棋程序)也停招,根据围棋规则双方停招将自动结束比赛开始点目计算胜负。

但是,由于KataGo的围空中的黑子尚有活力,按照围棋裁判规则并未被判定为“死子”,因此KataGo的围空中有黑子的地方都不能被计算为有效目数,导致KataGo被系统判负。

虽然这看上去是一个非常“赖皮”,“令人感到作呕”的对抗性策略,但业余围棋程序确实在公平规则下击败了KataGo,该程序唯一的设计目的就是“专治”KataGo,即便它的水平连普通业余爱好者的水平都达不到。

更为可怕的是,不仅仅是KataGo,几乎所有深度学习人工智能技术,从人脸识别、自动驾驶到网络安全,都存在类似的盲区和脆弱性。

一些看似“无厘头”或“人畜无害”的对抗性样本,却能够击垮对人类顶级选手保持100%胜率的最强健的人工智能程序。

格里夫博士指出,这个研究结果在围棋比赛中很有趣,但是在安全关键系统中出现此类故障可能会带来灾难性后果。

在人工智能战胜人类顶级选手五年后,围棋这款古老的游戏仍然在机器学习中发挥着重要作用。对围棋人工智能技术漏洞的挖掘和分析,对关键人工智能应用(自动驾驶、智能助理、人脸识别、智能工厂、智慧城市)的安全性和攻防两端技术的发展都有重要的警示和启示作用。

根据Advesa的人工智能安全性报告,互联网、网络安全、生物识别和企业行业是人工智能网络安全问题的重灾区,都是“对抗性样本策略”的有效打击目标。

论文地址:

https://arxiv.org/abs/2211.00241

声明:本文来自GoUpSec,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。