2022年11月,ChatGPT问世,在全球范围内引起轰动。据Similarweb统计,ChatGPT创下互联网最快破亿应用记录,平均每天约有1300万独立访客使用[1]。ChatGPT作为一项人工智能算法应用,不仅具备传统算法的复杂、不透明等固有属性,还可能引入安全和隐私保护方面的风险。

01 什么是ChatGPT?

ChatGPT是一种用于优化对话的大型语言模型(Language Model),属于深度学习人工智能算法。

据研发公司OpenAI介绍:“ChatGPT是一种对话式AI(Artificial Intelligence),可运用自然语言连续对话,回答问题并挑战不正确假设。”

“ChatGPT”中所谓GPT(Generative Pre-trained Transformer)即生成型预训练变换模型,是由OpenAI开发并致力于解决自然语言处理任务(NLP)的训练模型,目的是实现人与计算机之间用自然语言进行有效通信。

ChatGPT属于GPT-3和GPT-4之间的过渡版本,与GPT-3及之前的版本相比,ChatGPT能力强大的原因在于其采用了“从人类反馈中强化学习”(RLHF)的训练方式。具体而言,OpenAI首先以GPT-3为基础,准备大量问题让系统自动生成答案,针对同一个问题,GPT-3会生成多个答案,由人工标注员对这些答案进行标注,按可读性、正确与否、中立性等标准对答案进行排序,排序的结果会被用来微调GPT-3,最终迭代升级到ChatGPT。

一方面,ChatGPT以海量数据和信息输送为主要媒介形成与用户间的双向互动。ChatGPT利用GPT-3已有的数据作为训练集并通过RLHF训练不断地对自身进行微调和完善,同时,ChatGPT的选择性信息传输也不断影响用户行为,形成个体与算法技术间的高频互动与双向塑造。另一方面,ChatGPT对个人行为的塑造也将通过不同社会网络模式将对个体的微观影响传输扩散至更为宏观的群体与社会层面。

02 ChatGPT可能带来哪些风险?

1ChatGPT与数据安全

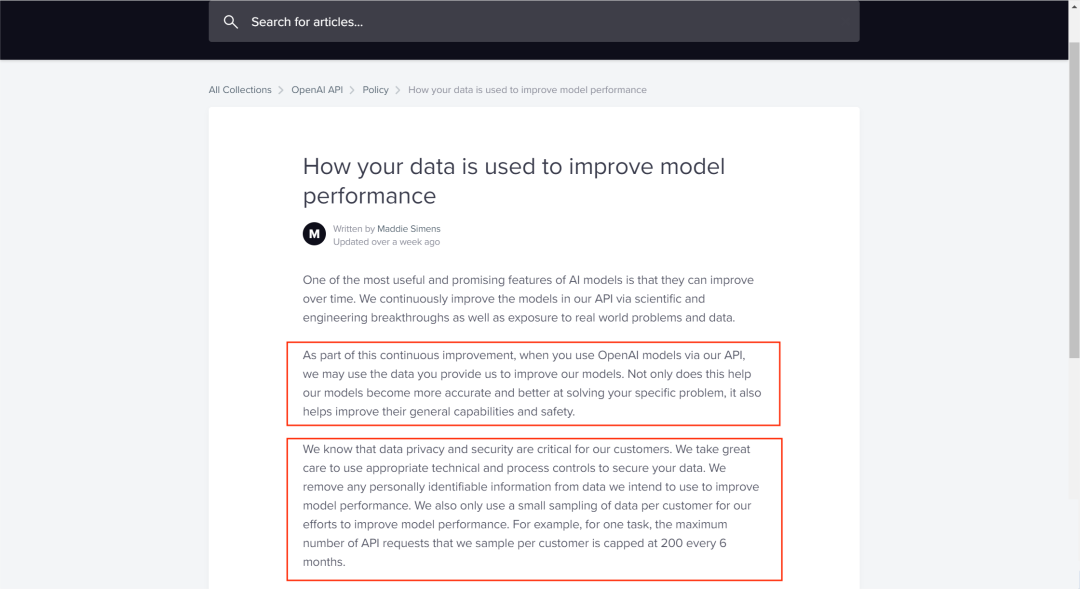

OpenAI的使用条款规定了OpenAI对用户输入和输出内容拥有广泛使用权以纳入训练数据库、用于改善ChatGPT。OpenAI表示“作为持续改进的一部分,当您通过我们的API使用OpenAI模型时,我们可能会使用您提供给我们的数据来改进模型。”“我们会从拟用于提高模型性能的数据中删除所有可识别个人的信息。”但OpenAI未详细说明该机制将如何有效运行。

ChatGPT可能导致个人信息等数据泄露风险大大增加。若用户在输入请求时,输入个人相关信息、业务数据或涉及商业秘密等的内容,将增加相关数据泄露的风险。自1月份开始,微软与亚马逊先后禁止公司员工向ChatGPT发送公司机密信息,也是基于这方面考虑。

2ChatGPT与犯罪利用

ChatGPT可能被犯罪分子、恐怖分子等主体恶意利用带来新的犯罪风险。ChatGPT作为由OpenAI训练的大型语言模型,能够根据要求生成以假乱真的文本,为网络犯罪分子提供技术上的支持。此外,ChatGPT等GPT-3工具可帮助网络犯罪分子逼真地模拟各种社会环境,并通过心理操纵诱骗受害者泄露敏感个人信息。此外,网络犯罪分子可能利用ChatGPT概念进行网络诈骗,类似于比特币、区块链等概念诈骗。

3ChatGPT与信息安全

美国新闻可信度评估与研究机构NewsGurd对ChatGPT进行测试发现,ChatGPT能在几秒钟内改变信息并产生大量感官令人信服但却无信源的内容[2]。ChatGPT的工作原理导致其回复可能存在外表可信度极高,但实际并无可信依据的情况,将对自身判断能力不足的用户产生极大的误导性。此外,出于政治动因或其他利益考量,利用互联网信息服务结合用户画像“潜移默化”地影响用户,从而使用户思想或行为偏好向着有利于自身方向发展的情况已有先例。鉴于ChatGPT在短时间内已经形成了庞大的用户群体,其具备的舆论属性和社会动员能力也随之快速提升,对于未来可能导致的信息安全乃至国家安全风险不容忽视。

03 应如何对ChatGPT等同类技术进行治理?

虽然目前ChatGPT尚未正式向中国境内用户开放使用,但仍然在境内引发热议,且不能完全排除ChatGPT的引入可能。同时,百度文心一言、谷歌Bard等竞品正在蓬勃发展。面对ChatGPT带来的已知或未知网络安全风险,应在中国现有法律框架和政策导向下预判治理路径。

1.推动网安、数安、个保、反诈领域法律适用

应充分发挥公安机关等监管部门在保障网络安全、数据安全、个人信息保护方面的作用,推动《网络安全法》《数据安全法》《个人信息保护法》及其配套制度在ChatGPT等人工智能算法领域的延伸适用,落实网络产品和服务管理、数据安全、个人信息保护等制度。尤其是针对境内提供类似ChatGPT对话服务的人工智能企业应强化数据安全和个人信息滥用情况的监管,避免利用真实个人信息数据进行模型训练而造成的个人信息泄露、滥用等情形。

针对APP商店模仿、假冒应用程序盛行,ChatGPT账号售卖火热等情况,应持续推进《反电信网络诈骗法》配套制度供给,加强ChatGPT等人工智能算法应用涉诈风险安全评估。结合不同服务与应用场景,厘定主体反诈义务边界,动态完善人工智能行业的反诈责任清单和任务清单。针对ChatGPT等人工智能算法涉诈重点问题精准发力。从人工智能涉诈黑灰产业链入手,强化电诈前端涉个人信息犯罪惩治,重点打击批量提供个人信息等行为,警惕以ChatGPT为噱头的新型骗局。

2.探索算法推荐与深度合成技术管理制度落地路径

ChatGPT等人工智能算法属于《互联网信息服务算法推荐管理规定》《互联网信息服务深度合成管理规定》中规定的“算法推荐技术”“深度合成技术”,可从该视角切入加强监管。

一是提升算法透明度。通过算法备案制度为算法风险监测和事后问责提供依据,借助“互联网信息服务算法备案系统”等途径公示算法推荐服务的基本原理、目的意图、主要运行机制等,提升透明度。

二是重视安全评估制度。充分发挥具有舆论属性或社会动员能力的互联网信息服务安全评估制度在风险发现、隐患处置等方面的作用,为网信、公安等部门进行全流程监管提供抓手。

三是强化主体责任落实。督促相关责任主体将法律法规要求和安全保障义务嵌入研发、运营、服务提供等环节,如深度合成服务提供者和技术支持者应当加强训练数据管理,采取必要措施保障训练数据安全;训练数据包含个人信息的,应当遵守个人信息保护的有关规定。深度合成服务提供者提供“智能对话、智能写作等模拟自然人进行文本的生成或者编辑服务”,可能导致公众混淆或者误认的,应当在生成或者编辑的信息内容的合理位置、区域进行显著标识,向公众提示深度合成情况。

3.健全网络综合治理体系,培育公众算法技术素养

网络综合治理体系为推进针对ChatGPT等人工智能算法的社会治理指明方向。

对政府部门而言,要充分发挥其在网络综合治理中的主导功能和核心作用,树立全局意识,着力倡导构建“合理分工、过程调适、齐抓共管、优势互补”的网络综合治理运行机制。

对行业组织而言,应鼓励建立人工智能算法治理行业自律机制,推动行业标准、最佳实践等配套规则落地,促进算法应用向上向善,强化算法应用示范引领。

对公众而言,应利用传统媒体和新媒体平台等多渠道推进精准宣传,帮助公众认识算法可能带来的风险,对算法带来的歧视、操纵、隐私侵犯、电诈等风险具有足够的识别能力。对于涉ChatGPT技术与概念诈骗,利用和建设可靠的反诈技术体系,加强对未成年人、老年人等特殊群体防骗宣传。

参考文献:

1.https://www.thehansindia.com/technology/tech-news/chatgpt-gains-100-million-users-in-just-2-months-781055

2.https://www.newsguardtech.com/misinformation-monitor/jan-2023/

声明:本文来自三所研发,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。