2023年3月14日,欧盟网络安全局(ENISA)发布《人工智能网络安全和标准化》(Cybersecurity of AI and Standardisation),旨在通过梳理人工智能标准化前景和主要标准制定组织(SDO)的相关工作,分析现有人工智能国际标准覆盖范围及差异,为后续标准化如何支持欧盟实施《AI法案》中涵盖的网络安全内容提出建议。

一、背景情况

ENISA指出,出于对现有技术不足以应对人工智能带来的威胁和漏洞的担忧,相关标准化组织通过不断制定特别报告、指南和标准以应对潜在风险。上述方法虽然可以短暂缓解相关威胁,但也存在一些局限性。首先,本报告侧重于软件方面,但人工智能往往包括软件以外的其他相关技术和组织,如硬件或基础设施。其次,现有标准没有解决部分特定领域问题,如数据和AI组件的可追溯性和沿袭性,或者鲁棒性等指标。再次,部分领域的安全措施依赖于特定系统,但相关人工智能技术还不够成熟,无法开展标准化工作。

基于上述情况,ENISA结合分析结果向标准化组织给出了AI标准化建议,强调必须将网络安全纳入高风险系统的风险评估,以确定每个系统的预期用途所特有的网络安全风险。此外,报告指出现阶段存在缺乏合规性评估工具和人员相关标准的开发的问题。

二、主要内容

《人工智能网络安全和标准化》主要包括人工智能和人工智能网络安全定义、人工智能网络安全国际标准分析、现有标准覆盖范围分析以及对《AI法案》草案的支撑情况等内容。

(一)人工智能和人工智能网络安全的定义

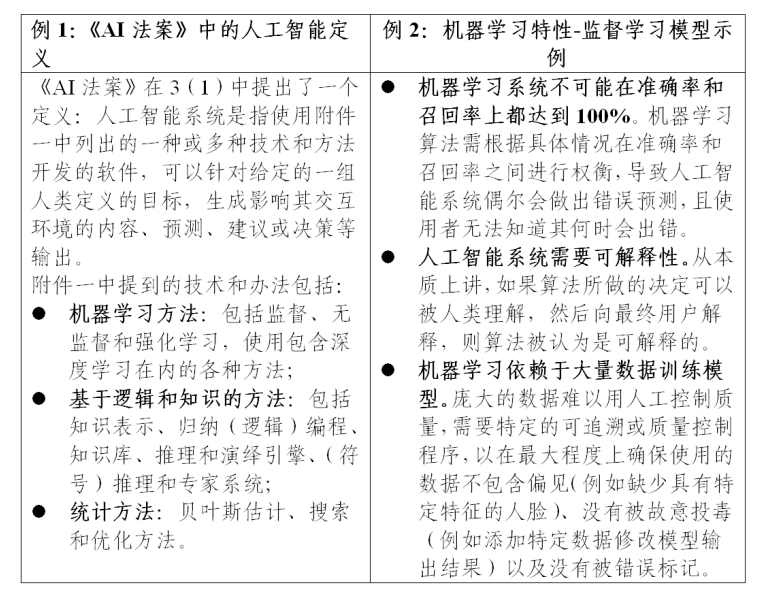

1. 人工智能定义

理解人工智能是定义人工智能网络安全的第一步。当前,人工智能技术及应用不断发展,其含义和范围仍存在很大争议,有多种不同描述。

与ENISA之前的工作一致,本报告主要关注机器学习,ENISA认为机器学习是人工智能技术的驱动力。该技术在当前人工智能应用中占主导地位,其具备的一些特性也导致了脆弱性,影响人工智能网络安全。

2. 人工智能网络安全定义

对人工智能和网络安全的独立及交叉领域讨论已经很广泛。ENISA《安全机器学习算法》报告,描述了人工智能和网络安全之间的关系,并确定了三个维度:

1) 人工智能网络安全:人工智能模型和算法缺乏鲁棒性,具有脆弱性;

2) 人工智能支撑网络安全:人工智能作为创建先进网络安全的工具/手段,以及为执法部门和其他公共机构更好地应对网络犯罪提供便利;

3) 人工智能的恶意使用:恶意使用人工智能制造更复杂类型的攻击。

《人工智能网络安全和标准化》则侧重于第一个维度,即人工智能网络安全。对于人工智能网络安全可以有狭义和广义两种解释:

- 狭义解释:旨在保护人工智能系统在整个生命周期内资产(人工智能组件及相关数据和流程)的机密性、完整性和可用性免受攻击。

- 广义解释:以数据质量、监督、鲁棒性、准确性、可解释性、透明度和可追溯性等可信特性进行支撑和补充。

(二)人工智能网络安全国际标准分析

本报告将人工智能国际标准的分析范围限定于国际标准化组织(ISO)和国际电工委员会(IEC)、欧洲标准化委员会(CEN)和欧洲电气技术标准化委员会(CENELEC)、以及欧洲电信标准协会(ETSI)。

1. CEN/CENELEC

CEN/CENELE主要在两个联合技术委员会(JTC)内解决人工智能和网络安全问题。

(1)JTC 13“网络安全和数据保护”

JTC 13“网络安全和数据保护”的主要目标是将信息技术领域内与欧洲情况相符的国际标准(特别是ISO/IEC JTC1/SC27的标准)转换为欧洲标准;在有差异的领域开发“本土”欧洲标准,以支持欧盟条例和法规。JTC 13已经确定了29项与人工智能网络安全有关,可通过技术合作采纳/适配的ISO/IEC标准,主要涉及ISO/IEC 27000信息安全管理体系系列标准,详细列表如下:

(2)JTC 21“人工智能”

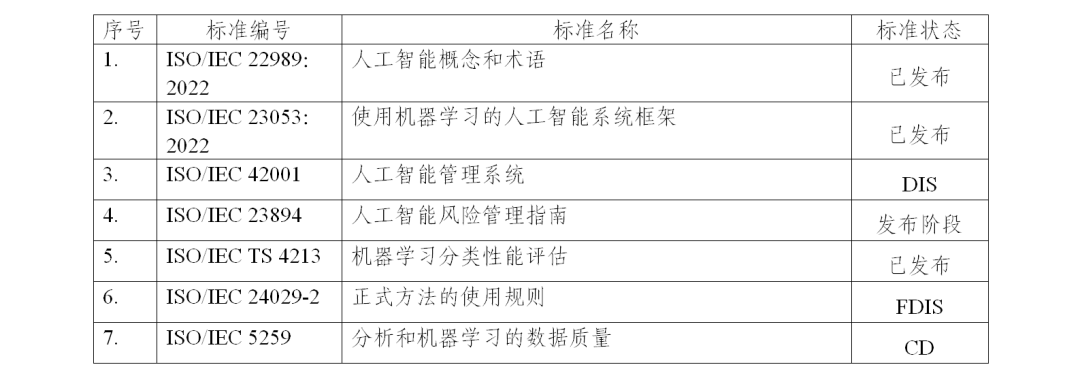

JTC 21“人工智能”负责制定和采纳人工智能和相关数据的标准(特别是ISO/IEC JTC1/SC42的标准),并为其他人工智能相关技术委员会提供指导。JTC 21旨在解决人工智能网络安全的扩展问题,包括可信特性、数据质量、人工智能治理和人工智能管理系统等。ISO/IEC JTC1/SC42的7项标准已被确定直接适用于《AI法案》并由JTC 21采纳,详细列表如下:

此外,JTC 21根据目前确定的差距,启动了两个特设小组,旨在研制支撑《AI法案》落地的新国际标准提案,即人工智能系统风险目录和风险管理、人工智能可信特性。

最后,已经确定ISO/IEC 42001人工智能管理体系和ISO/IEC 27001网络安全管理体系可以通过ISO 9001质量管理体系进行补充,以适当覆盖人工智能和数据质量管理相关内容。

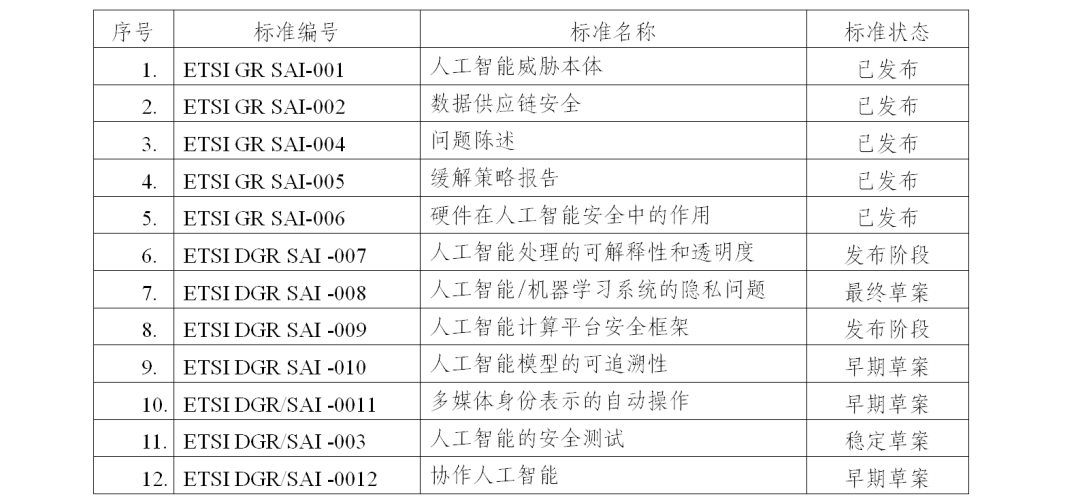

2. ETSI

ETSI成立了人工智能安全行业规范组(ISG SAI)预标准化组织,该组织在技术层面上开展工作,探讨人工智能的具体特性,目前已发布多项报告,以促进更广泛的理解,并在需要时给出更详细的规范标准要求。ISG SAI发布的人工智能理解和保护相关的报告:

此外,受《AI法案》和《网络安全法案》的直接影响,该小组目前正在讨论人工智能的准备、过渡、测试和认证。

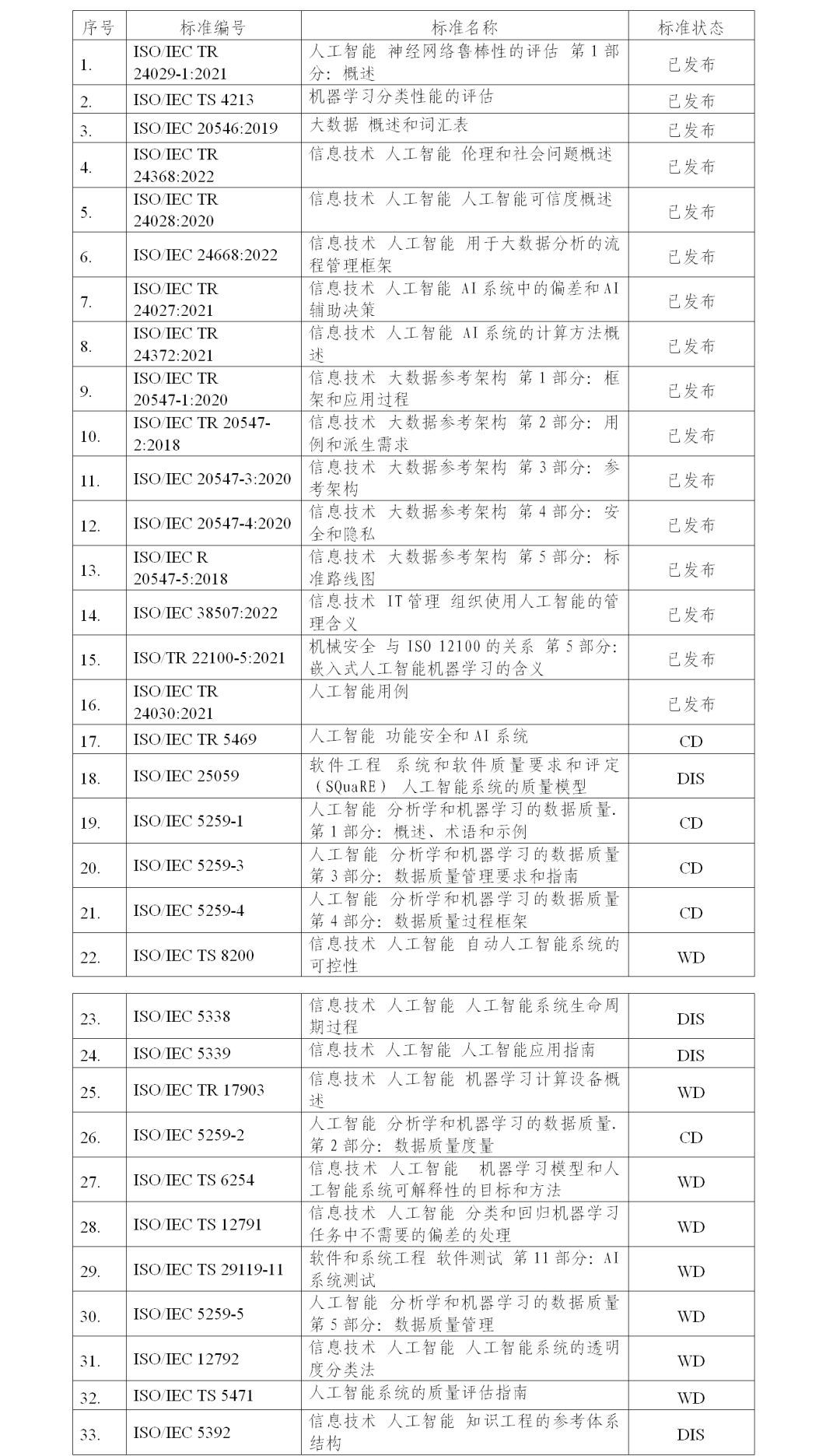

3. ISO/IEC

ISO/IEC在JTC 1 SC 42中开展人工智能相关工作,详细列表如下:

4. 其他标准化组织

几乎所有的标准化组织都已经启动了人工智能相关的标准研究工作,但仍缺乏一致性。国际电信联盟(ITU)、电气与电子工程师协会(IEEE)和国际自动机工程师学会(SAE)是在人工智能方面非常活跃的组织。在人工智能标准化体系建立的过程中,几乎不可能查阅所有文件内容,特别是处于编写阶段的文件,难以通过标题评估其相关性和成熟度。例如,SAE的项目SAE AIR AS 6983致力于航空领域的人工智能/机器学习,与JTC 21项目在人工智能可信特性上的范围非常相似,存在重复交叉的问题。

此外,主要软件供应商也就软件中人工智能功能的使用给出了各自的标准和指导,并需要在产品投放市场之前进行详细的审查和质量控制。

(三)人工智能标准覆盖范围分析

本章分析了与狭义人工智能网络安全(机密性、完整性和可用性即CIA安全模型)和广义人工智能网络安全(可信特性)相关的标准覆盖范围。

1. 支撑狭义人工智能网络安全的标准化

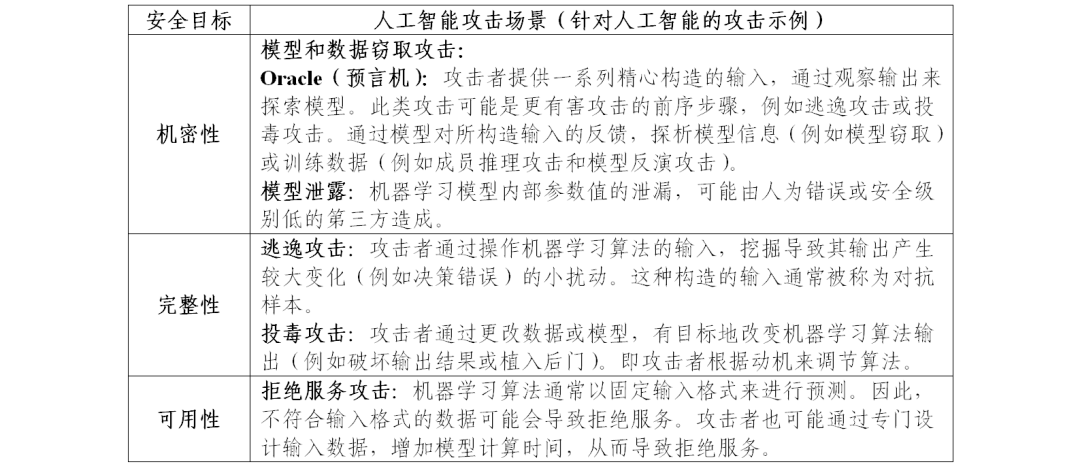

如前文所述,狭义的人工智能网络安全涉及人工智能系统整个生命周期内资产的机密性、完整性和可用性。表1展示了针对每一个安全目标,对人工智能系统的攻击示例。

表1:CIA范式在人工智能中的应用

如果将人工智能系统视为软件,并考虑其整个生命周期,通用标准可以帮助减轻人工智能面临的许多风险。以下是被确定为紧密相关的标准:

- ISO/IEC 27001,信息安全管理,以及ISO/IEC 27002,信息安全控制:与所有安全目标相关;

- ISO/IEC 9001,质量管理体系:与完整性(尤其是数据质量管理,以防止被投毒)和可用性相关。

同时也带来了两个问题:1)通用标准应在多大程度上适应给定威胁的人工智能场景;2)现有标准是否足以解决人工智能网络安全问题,是否需要补充。

对于第一个问题,在提供相应指导的情况下,通用标准可适用。尽管人工智能有一些特殊性,但它本质上是软件。因此,适用于软件的内容也可以应用于人工智能。尽管如此,标准制定组织仍在积极针对人工智能的特殊性,对现有的通用标准进行补充,以更好地解决人工智能问题。这些补充主要涉及人工智能术语和概念,及其现有标准在人工智能场景中的应用,特别是人工智能术语和相关可信特性概念的共享定义,以及软件安全相关标准应用于人工智能的指南。对于第二个问题,从标准制定组织的工作中可以看出,现有技术对人工智能相关威胁的应对能力是否存在不足被广泛关注,对现有标准增加指导/更新的解决方式存在以下局限性:

1)人工智能概念包含技术和结构要素,而不仅限于软件(如硬件或基础设施);

2)人工智能模型的黑箱特性可能妨碍软件中质量保证措施的应用;

3)确定适当的安全措施依赖于对特定系统的分析;

4)标准对安全人工智能的支持受技术发展成熟度限制;

5)数据和人工智能组件的可追溯性问题尚未完全解决;

6)机器学习的固有特性未充分反映在现有标准中。

2. 支撑广义人工智能网络安全的标准化

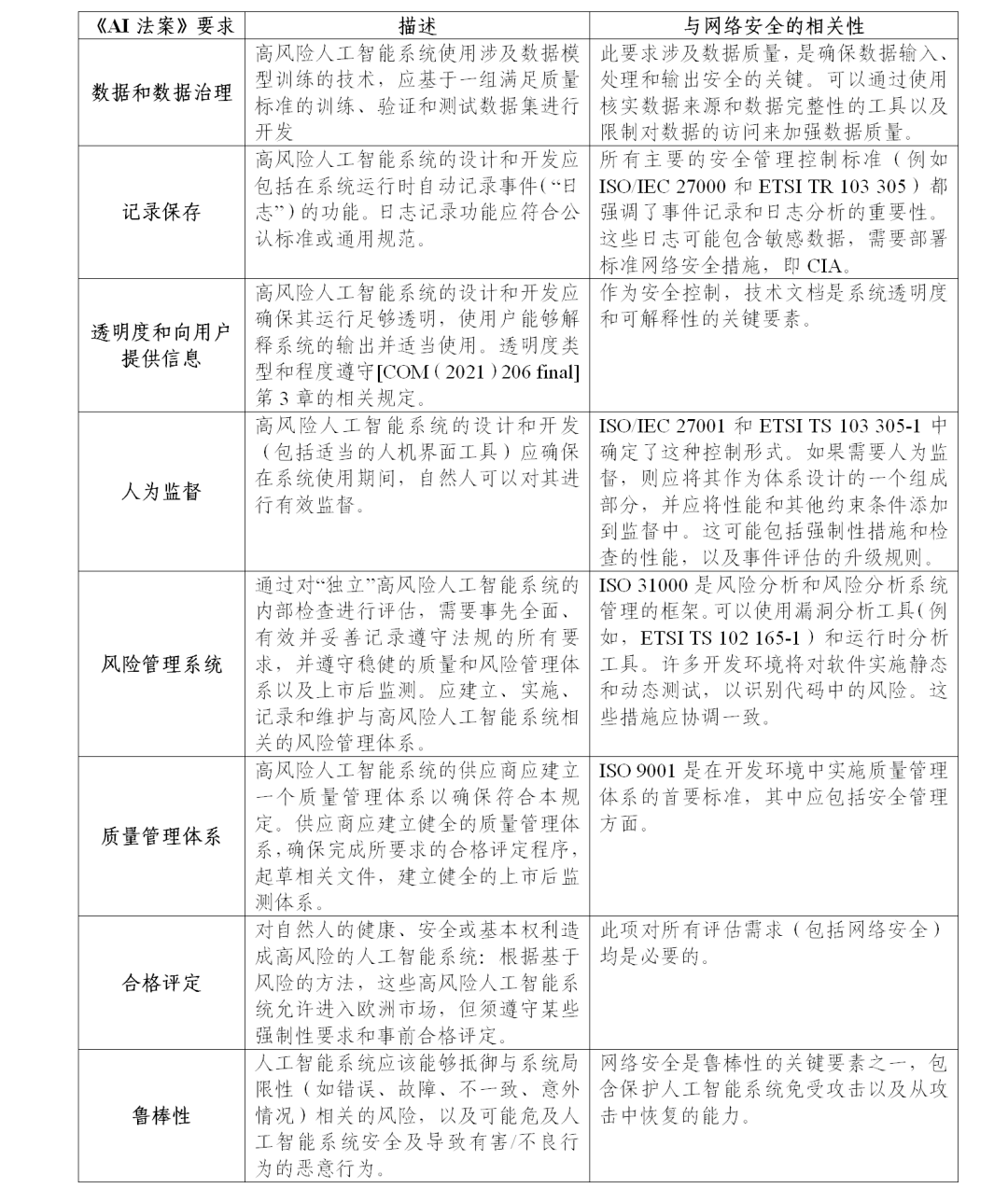

广义的人工智能网络安全除资产保护外,还需维护人工智能可信特性的基础。表2在《AI法案》背景下举例说明了上述关系。表中分析了网络安全在该法案一系列要求中的角色,其中一些要求(例如质量管理、风险管理)间接有助于建立可信人工智能生态系统。

表2:网络安全在《AI法案》——系列要求中的角色

标准化组织正在积极制定人工智能专用标准。在监管方面,希望可以形成一个统一方法来处理可信特性问题,避免不必要重复和混乱。

3.《AI法案》背景下的网络安全和标准化

《AI法案》明确提到了高风险人工智能系统的网络安全。法案建立在基于风险的方法之上,根据系统的预期用途和对健康、安全及基本权利的影响来确定人工智能系统是否具有高风险。

在《AI法案》中,这些高风险系统受到一系列约束,如高风险人工智能系统应该在面对未授权第三方通过系统漏洞改变其使用或性能的尝试时具有弹性;针对人工智能特定漏洞的技术解决方案应包括对试图操纵训练数据集的攻击(数据投毒)、导致模型出错的输入(对抗样本)或模型缺陷的预防和控制措施等。

在欧盟标准化组织当前已包括《AI法案》相关要求的工作基础上,从网络安全角度出发,关于实施《AI法案》还有以下需要考虑的因素:

- 鉴于人工智能的广泛适用性,网络安全风险的识别和安全要求的确定应依赖于对特定系统的分析;

- 应为现有标准制定必要的指导来支撑人工智能系统的网络安全,同时关注新标准的研究进展;

- 标准制定机构正在积极致力于人工智能可信特性的标准化工作,目前尚不清楚这些标准是否会在《AI法案》通过之前发布,建议密切关注相关事态发展。

《AI法案》还描述了人工智能系统合格评定所依赖的治理体系,其中部分要求包括:

- 确保对人工智能系统进行合格评定的执行者拥有标准化的工具和能力。人工智能的可信度将部分依赖于合格评定机构的能力,如果这些机构没有足够的能力,则可能做出错误评定。迄今为止,没有充分涵盖网络安全,以及评估实施人工智能系统审计、认证和测试的组织及人员能力的标准。

- 确保《AI法案》与网络安全立法之间的监管一致性。虽然尚未宣布制定欧盟人工智能网络安全认证计划的官方要求,但如果制定这样的计划,应适当考虑《AI法案》,反之亦然。

(四)人工智能标准化现状总结

本报告认为,信息安全和质量管理的通用标准(特别是ISO/IEC 27001,ISO/IEC 27002和ISO 9001)可以部分缓解与人工智能系统机密性、完整性和可用性相关的网络安全风险。这一结论依赖于人工智能本质上是软件的假设。因此,在提供足够指导的情况下,适用于软件的内容也可用于人工智能。这种方法可以满足一般情况,但需要通过系统特定分析进行补充(例如ISO/IEC 15408-1)。但是还存在如下差距:

- 当前已有多个标准解决了运行过程的可追溯性,但数据和人工智能组件在其整个生命周期中的可追溯性仍是一个未解决的问题(在其生命周期中可能涉及多种威胁)。尽管多个标准或草案都涵盖此问题,但在实践中基本没有解决;

- 机器学习的固有特性在现有标准中没有得到充分体现;

- 在某些领域,由于相关技术仍在发展,尚未成熟到可以标准化的程度,现有标准无法适配,新标准也无法对其进行定义。

此外,超越CIA范式,从更广泛的可信特性视角出发,由于人工智能网络安全涉及许多可信特性要求(例如数据治理、透明度),与这些要求相关的标准化工作应在涉及网络安全问题时保持一致。

(五)ENISA对人工智能标准建议

1. 给所有机构的建议

建议1:使用标准化和统一的人工智能网络安全术语,包括可信特性和人工智能系统特有的攻击类型。

2. 给标准制定机构的建议

建议2:制定具体技术指南指导现有软件安全相关标准如何适配于人工智能。这些指南还应包括不同级别的防御措施。同时,建议关注和鼓励标准化受到技术发展限制的领域。

建议3:机器学习的固有特性应该体现在标准中。需要考虑的方面包括硬件/软件组件与人工智能联合的风险缓解、可靠的评价指标、测试程序、数据和人工智能组件的可追溯性等。

建议4:确保在网络安全技术委员会和人工智能技术委员会之间建立联系,以便关于可信特性(监督、鲁棒性、准确性、可解释性、透明度等)和数据质量的人工智能标准考虑到网络安全问题。

3.《AI法案》实施准备建议

建议5:鉴于人工智能的广泛适用性,网络安全风险识别和安全要求确定应依赖于对系统特定分析,并在需要时基于行业特定标准确定。行业标准应连贯有效地建立在横向标准的基础上。

建议6:鼓励标准化受到技术发展限制的领域中的研发活动。一方面为特定技术的进步提供资金,另一方面,提高对标准化融入研究活动的重要性的认识。此外,建议通过系统化方法促进标准与技术间的协调,指导研发工作。

建议7:鼓励为合格评定执行者的工具和能力制定标准。

建议8:确保《AI法案》与其他网络安全立法倡议之间的一致性,特别是《网络安全法案》和《网络弹性法案》。

三、小结

欧美等国家高度重视AI标准化工作,提出围绕核心技术、顶尖人才、标准规范等强化部署,力争抢占新一轮科技主导权。其中,美国通过标准和基准来衡量和评估AI技术,欧盟提出统一立法对AI进行强监管。我国应基于人工智能技术和产业自身发展现状,结合标《国家新一代人工智能标准体系建设指南》,继续加强AI标准体系建设,紧跟国际共同关注的AI标准的热点问题,积极参与相关标准化活动,提出中国提案。

声明:本文来自全国信安标委,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。