内容摘要:随着ChatGPT的出现和使用,许多语言模型已经展示了更多新的功能。但是随之而来的是社会和政治影响,大量互联网用户获得便利性的同时,被恶意行为者滥用也使得人工智能的监管问题日益严峻。另外,各国语言开发和创新能力发展不一,语言模型被置于国家技术竞争的中心位置,以中美为代表的技术竞争已经成为国际社会的新焦点。

1.模型激增

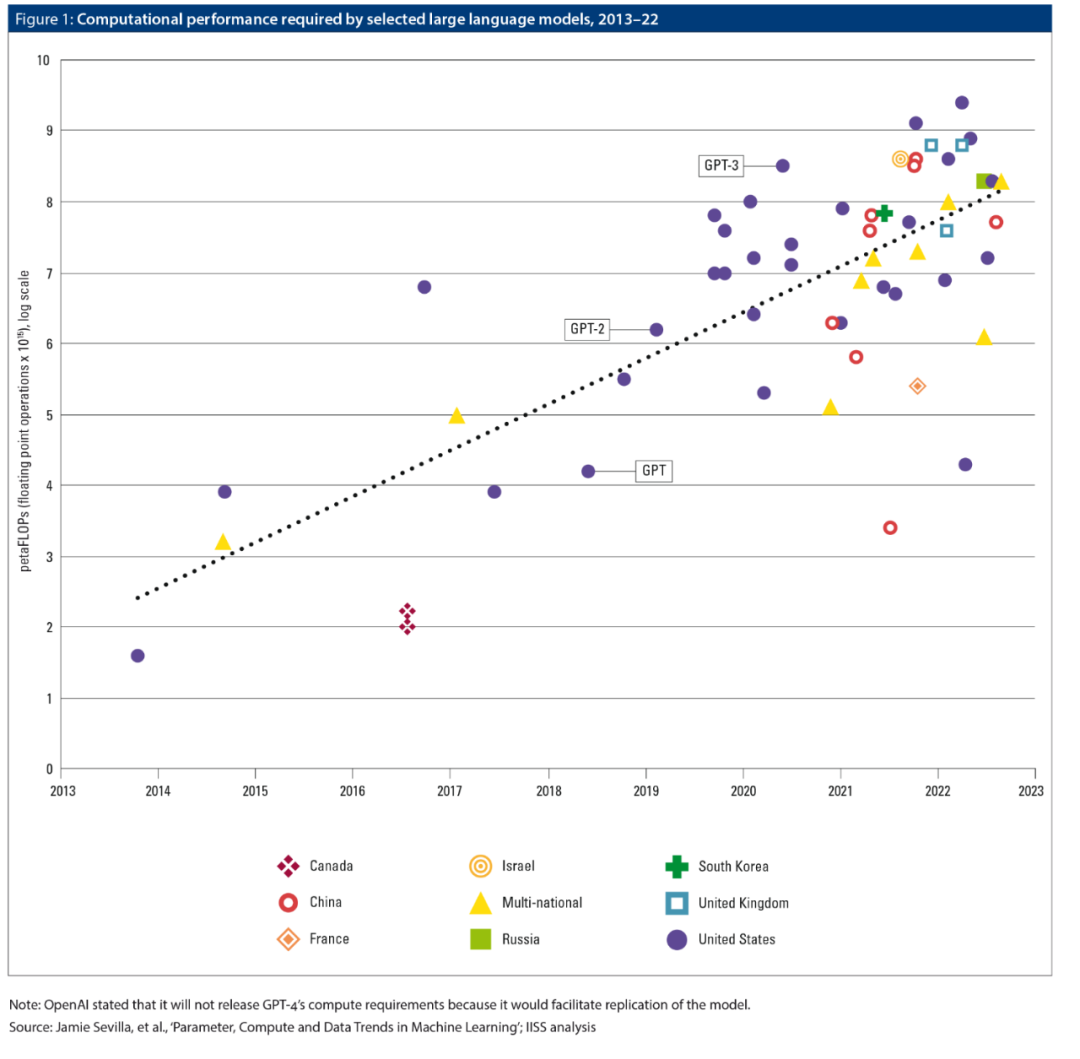

近年来,大型语言模型的能力有了很大的提高,OpenAI在2020年创建的GPT-3是一个重要的里程碑。这些改进是由于创建了更大、更多的模型架构,以及数据集大小的增加和技术公司为增加训练模型所花费的计算能力而花费的金额。经验研究表明,数据集的大小、计算预算和特定模型的参数数量之间有很强的关系,在实践中,计算预算是对模型改进的最强制约。

此外,更多的参与者正在开发大型语言模型,其扩散发生在三个方面。首先,如图1所示,大型语言模型的研究主要发生在美国,但其他国家的研究人员(特别是中国),以及其他地方的特定研究机构(如英国的DeepMind),已经投入大量资源建立自己的模型。其次,开发语言模型的机构类型已经扩大,既包括谷歌和微软这样的大型技术公司,也包括分散的研究人员群体。第三,开发者已经探索了越来越广泛的发布策略,包括扣留模型不发布(谷歌的策略直到2023年3月21日有限发布Bard),在应用编程接口(API)后面限制对输出的访问(像OpenAI对ChatGPT所做的那样),在非商业许可下发布模型(像Meta对其模型所做的那样,称为Open Pre-trained Transformers和LLaMA),以及在互联网上发布完整、可下载的模型(像研究集体EleutherAI和BigScience所做的那样)。这些模型的扩散对国内和国家安全有两个近期影响:这些模型可能会使影响行动的内容质量更高、数量更大,而对语言模型开发的竞争可能会使地缘政治紧张局势升级。

图1

2.作为影响工具的语言模型

国内或国际宣传者有两种广泛的选择来获取大型语言模型:使用不太复杂但公开可用的模型,或依靠人工智能公司,通过API提供结构化的输入/输出访问他们更强大的模型。第一种选择允许宣传者自由地进行微调,对模型的训练数据做出小的贡献,以诱导其行为的变化,并对模型的输出施加更多的控制。

公共模型必须在本地运行以产生输出,但许多语言模型非常大,甚至不能装入目前最具有内存能力的处理器。大多数国家的政府有可能在相关的安全机构内建立必要的计算基础设施来克服这一障碍,但除了成本之外,技术问题也可能成为一个障碍。尽管深度伪造视频技术已经存在了几年,但它还没有成为宣传者的常用工具,部分原因可能是它仍然需要熟练的技术才能使用。然而,这种情况也可能发生变化,因为较新的“文本-图像”模型,如Midjourney或Stable Diffusion,可以更容易操作,能够只通过文本提示就生成看起来很真实的照片,而不需要进行编码。

相比之下,私人模型则不能被微调。但私人开发者已经试图从他们的模型输出中清除敏感或煽动性的内容,他们还可能阻止来自某些国家的访问,或禁止那些似乎在恶意使用模型的个人用户。尽管有这些风险,通过API访问模型,即使被发现也不会给宣传者带来直接成本,这意味着它可能仍然是首选的访问方法。

3.国际竞争

10月,美国总统拜登政府宣布对流向中国的先进半导体芯片实施新的出口管制,部分原因是这些芯片对人工智能发展而言至关重要。虽然出口管制的公开意图是限制用于监控或军事应用的人工智能系统的发展,但语言模型也高度依赖于这些先进的半导体。实施出口管制的部分动机可能是试图保持美国在语言模型方面的优势,无论是作为更广泛的人工智能技术竞争战略的一部分,还是因为政府希望特别抑制中国对语言模型的开发(例如,因为担心这种模型会被用于增强现有的中国影响行动)。

然而,目前还不清楚这些措施是否会有效。虽然语言模型由于计算能力的提高而得到了改善,但它们不可能继续以目前的速度进行改善。这部分是由于继续扩大模型的财政限制,也因为训练大得多的模型需要先进的半导体和互连速度,这在目前是不可行的。研究人员正在积极寻求开发计算效率更高的方法来训练类似的模型。一个国家试图限制另一个国家的计算能力作为竞争人工智能发展的手段,可能会激励目标国家在这些计算效率更高的人工智能方法中发展竞争优势。此外,互联网上只有那么多的“高质量”文本(例如书籍和学术期刊文章),这可能很快就会成为语言模型发展的一个比计算能力的可用性更紧迫的制约因素。最后,虽然从头开始训练语言模型的计算成本很高,但对现有模型进行微调的成本并不高,在许多情况下,这些模型在执行特定任务(如生成虚假信息)时同样有效。各国也可能越来越多地将语言模型的发展视为国家的骄傲,这种看法会加剧对其发展的竞争企图。

但是,尽管美国以外的公司渴望生产出能与ChatGPT相媲美的模型,他们可能会面临美国没有的监管障碍。例如在欧洲,监管机构目前正试图阐明“通用人工智能”,一个包括大型语言模型的类别,将如何适应欧盟人工智能法案草案中基于风险的整体结构。语言模型的训练并没有考虑到具体的任务,它既可以用于良性目的,也可以用于《人工智能法》可能视为“高风险”的目的。

正因为如此,至少有一些监管机构希望让通用人工智能系统的开发者遵守与高风险人工智能系统开发者相同的法律要求。欧盟也在考虑采取更温和的监管方式,但即使是这样,对语言模型开发者施加的责任也比美国多得多,而且可能会减缓欧洲的技术发展。

在中国存在类似的监管模糊性,与欧盟相比,更多的中国公司明确表示希望开发ChatGPT的竞争对手,百度在3月16日发布了一个竞争产品(称为Ernie Bot),腾讯也宣布计划这样做。但是,2023年初颁布的中国新法规禁止所谓的“深度合成服务提供商”,包括语言模型提供商,“制作、复制、发布或传播”假新闻信息。尽管由于对ChatGPT和其他西方语言模型的访问进行了打击,中国的科技公司拥有相对清晰的竞争领域,但训练明确符合这些法规的模型的难度可能会阻止他们快速部署自己的语言模型。

发布时间|2023年4月

文章来源|国际战略研究所

原文标题|Large language models: fast proliferation and budding international competition

原文地址|https://www.iiss.org/publications/strategic-comments/2023/large-language-models-fast-proliferation-and-budding-international-competition/

声明:本文来自上海市人工智能与社会发展研究会,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。