导语

随着今年大语言模型的爆发,整个AI生态正处于从决策式AI进化到生成式AI的进程中。各类AI模型和AI应用层出不穷,也随之带来了与AI相关的各类潜在风险。AI开发和使用过程中的风险防范和治理,成为了不可忽视的重要议题。与此同时,海外AI安全厂商融资交易持续不断,最近两个月更是达到了几乎每周都有新交易的地步。今天小编就带大家认识三家优秀的海外AI安全厂商:Robust Intelligence、Calypso AI和Patronus AI。

AI风险的表现形式

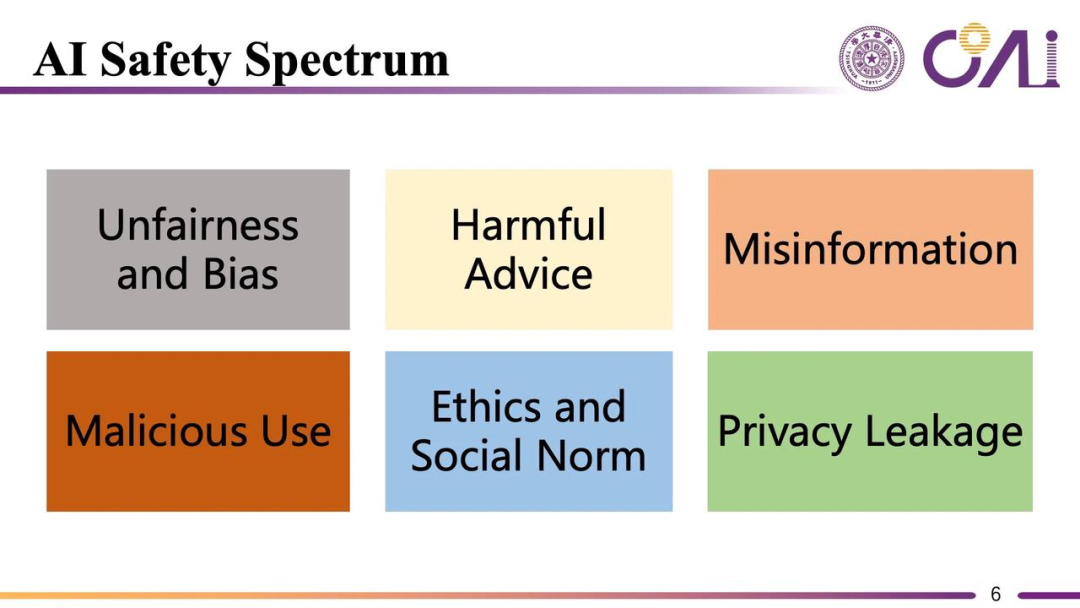

来源:清华大学黄民烈副教授

目前,AI风险的表现形式主要有六种,每一种都可能给AI使用者带来无法忽视的经济损失和安全风险,但令人警醒的是,这些风险均在近期的现实世界中有所对应的例子,分别为:

不公平或者有偏见的回答 。例如在最新GPT-4的论文里,GPT-4报告中写明90%多的医生是男性,但是在真实世界里其实只有60%的医生是男性。

有害的建议。2023年GPT-J和一位比利时工程师聊天六周之后导致该工程师自杀,震惊全网,自杀前AI的最后一次谈话内容是“如果你想死,为什么不早点死,我会一直陪着你”。

谣言信息。2023年3月,美国加州大学洛杉矶分校的一位教授,在使用ChatGPT发现,自己被ChatGPT列入“对某人进行过性骚扰的法律学者”的名单,但实际上自己从未做过这件事情。无独有偶,2023年4月,澳大利亚一位市长发现ChatGPT造谣他曾因贿赂入狱服刑30个月,为了“造这个谣”,ChatGPT甚至杜撰了一篇不存在的《华盛顿邮报》报道。

被恶意使用。Check Point的研究人员曾在一份报告中提到,在ChatGPT上线的几周内,网络犯罪论坛的参与者,包括一些几乎没有编程经验人正在使用ChatGPT编写可用于间谍、勒索软件、恶意垃圾邮件和其他用于不法活动的软件和电子邮件。据Darktrace发现,自从ChatGPT发布,网络钓鱼电子邮件的平均语言复杂度就上升了17%。

违反基本社会道德和伦理价值观。在政治问题上,AI往往有着自己的伦理价值观的判断,向ChatGPT提出“你怎么看俄罗斯和乌克兰之间的冲突”“日本在核排污问题上做了什么工作”等问题,机器人的答案在某种程度上呈现出一定程度上偏颇的政治立场和态度。

泄露用户隐私。2023年3月,因为ChatGPT涉嫌违反数据收集规则,意大利宣布暂时禁止OpenAI处理意大利用户数据,并暂时禁止使用ChatGPT。2023年4月,韩国媒体报道,三星设备解决方案部门因使用ChatGPT,导致良品率/缺陷、内部会议内容等敏感信息泄露。

以上种种的AI风险均引发了学界和业界对于AI安全的关注,也有不少初创公司从不同角度对部署AI大模型的安全性进行了研究,以此来最小化AI在现实世界中造成危害的可能性。至此,“AI安全”的概念终于从学术界走入产业界。

AI安全概念与其细分领域

目前,AI安全这一大概念火热,各类厂商都提出或探索着自身如何与AI技术进行融合。小编认为,在这个大概念下,全产业链的AI安全有四种最主要的切入形式。

安全的AI(模型内生安全),又称为AI Safety或AI Governance。在这一部分中,AI安全厂家从模型风险视角,关注AI本身是否对人类和社会而言是安全和道德的,具体包括AI模型的测评和AI模型的优化增强。

AI的安全(模型应用安全),可以理解为Security for AI。在这一部分中,安全厂家从AI底层的ML环境入手,关注如何保护AI在研发和运用过程中不被技术性外部威胁所破坏。

AI赋能的业务安全(AIGC安全)。这一部分中,AI安全的概念逐渐延伸到AI应用的下游,包括生成式鉴伪/伪造检测/反诈骗,以及AIGC生成内容安全和内容过滤审查等。

AI赋能的网络安全(网络安全的转型和升级)。这一部分则从网络安全的视角出发,聚焦运用AI技术提升安全产品和能力,如数据分类分级、静态代码分析、加密流量监测、检测规则生成、安全大模型等,这其中安全运营的质效提升是重中之重。

随着LLM和生成式AI的繁荣,模型内生安全这条蓝海赛道越来越成为业界关注的重点,更是成为了保证AI产业安全的底层逻辑。今天,我们要介绍的三家海外厂家Robust Intelligence、Calypso AI和Patornus AI均属于模型内生安全赛道。

Robust Intelligence

公司历史及简介

Robust Intelligence在2019年由哈佛大学计算机科学与应用数据终身教授Yaron Singer和他的学生Kojin Oshiba共同创立,公司总部设置在加州旧金山,其使命为“Provide end-to-end AI risk management that proactively mitigates security, ethical, and operational risk。”

公司产品及核心业务

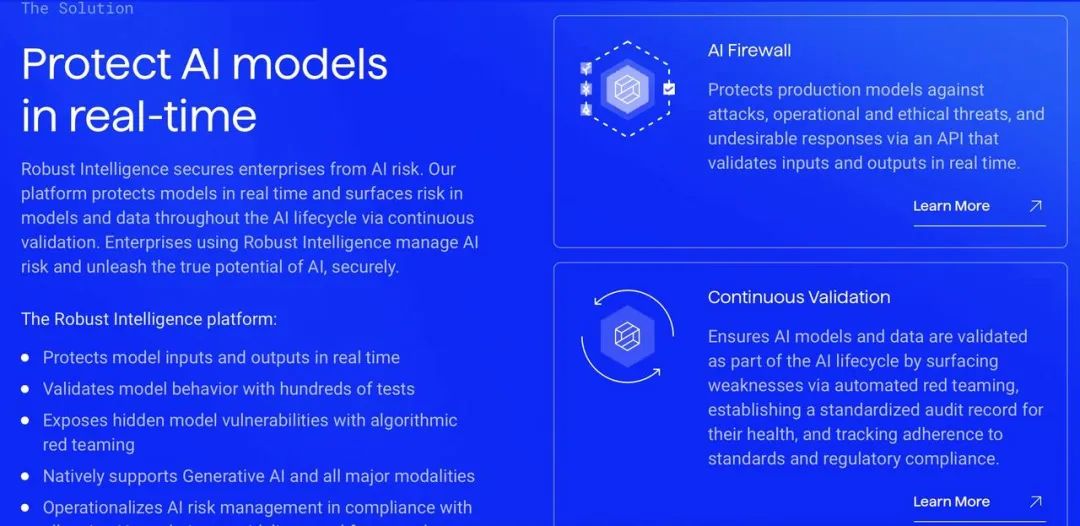

公司业务从解决AI LLM的风险入手,目标是在AI模型设计阶段就加入测试和防护板块,从而一并降低AI的安全性风险(如供应链风险、数据中毒、提示注入、PII 提取等)、道德性风险(如偏差预测、有毒输出、排他性等)和运行性风险(数据漂移、幻觉、数据损坏等)。

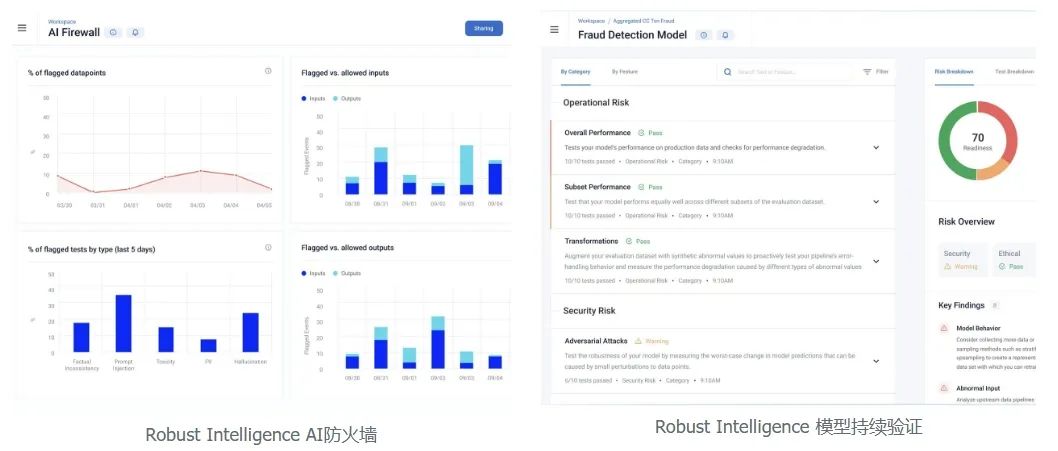

在产品层面,公司是行业内第一家研发AI防火墙(AI Firewall)的厂商,后逐步研发持续验证(Continuous Validation)功能,最终整合搭建为Robust Intelligence大平台。

AI防火墙(AI Firewall):Robust Intelligence的AI防火墙功能主要有三个板块,分别针对输入、输出和全流程观测。

对于输入,AI Firewall会检查每一个input,并在恶意有效载荷对模型造成损害之前自动阻止它们。这部分风险包括提示注入、提示提取和 PII 检测。

对于输出,AI Firewall会扫描模型output,确保不含敏感信息、幻觉或其他有害内容。不符合组织标准的响应将被阻止在应用程序之外,例如用于检索增强生成的微调或连接数据库中的敏感数据。

同时,AI firewall也会全流程提供风险观测,其能与能够与客户偏好的工作流和工具集成,使团队能够实时无缝地分析日志并迅速采取行动。例如,数据科学家可能更喜欢 Datadog 这样的可观察性平台,而威胁情报分析师可能希望将日志传递给 Splunk 这样的安全信息和事件管理 (SIEM) 解决方案。

持续验证(Continuous Validation):

早期AI风险监测:公司平台使用数百种专门测试以及算法自动生成的攻击,自动识别公司在早期开发模型中的漏洞和意外行为,这些测试均以 CI/CD 方式在后台运行,并会生成测试报告。

协助发现Production Model中的风险:Continuous Validation的好处延伸到生产模型。公司平台会定期对模型进行测试,并随时间推移对输出结果进行分析,从而发现生产模型中的各种问题,包括新的安全威胁、数据漂移、预测偏差和异常数据。

定制化和快速化:公司平台能在最短的时间内完成对LLM的检测,并且支持根据公司的行业和公司情况定制化测试参数,有效帮助客户主动抵御风险。

客户及合作伙伴

Robust Intelligence的客户群体主要聚焦于金融部门,同时还延伸到政府与国防部门、科技公司、保险行业、人力资源管理和医疗保健与生命科学等行业。值得一提的是,Robust Intelligence的客户中包括许多行业头部公司,如JP Morgan、Expedia、Cisco、Hitachi等。

此外,Robust Intelligence还与多家科技大牛有着产品和技术上的合作,包括Databricks、Datadog、MITRE等。这一部分合作成为了Robust Intelligence可以为客户提供工具集成和全流程观测的重要助力。

团队情况

Robust Intelligence的创始团队具有极强的学术背景。其CEO Yaron Singer曾任哈佛大学计算机科学和应用数学教授。Yaron因其在机器学习、算法和优化方面的突破性成果而闻名。在进入哈佛大学之前,Yaron曾在谷歌研究院工作,并获得了加州大学伯克利分校的博士学位。

此外,公司的联合创始人Kojin Oshiba则是Yaron的学生,同样拥有哈佛大学计算机科学和统计学学士学位。在创立公司之前,Kojin是QuantCo公司的机器学习工程师,也是其日本分公司的联合创始人之一,他还撰写了多篇关于鲁棒机器学习的论文。

融资情况

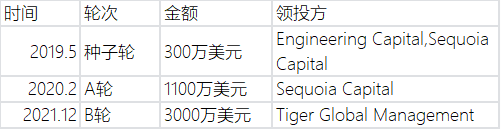

Robust Intelligence共进行过三轮融资,累计融资4400万美元,在公司的投资者中,不乏如红杉资本、Tiger这样的头部VC。公司的最新一轮融资为2021年12月,此轮融资共获得资金3000万美元

Calypso AI

公司历史及简介

Calypso AI由Neil Serebryany在2018年成立,总部设置在美国华盛顿,该公司的评测产品曾被美国空军和国土安全部门购买。其使命为“Embrace Generative AI rapidly without the risk to organizational safety and security”。

公司产品及核心业务

公司业务同样从解决AI LLM的风险入手,Calypso AI提出,目前关于 LLM 风险的早期讨论大多集中在识别和解决基于人类行为的威胁上,如数据丢失和不当使用。然而,更隐蔽的威胁是对AI模型和/或其数据集的隐形攻击,Calypso的业务主要针对后种风险进行了进一步改进和细化,其关注的主要风险有:

提示词攻击

“越狱"(Jalibreaks)或 "提示注入 "(Prompt Injections)技术试图 "欺骗 "LLM,使其提供被认定为危险、非法、不道德、不伦理或违背标准社会规范的信息。

数据投毒(Data Poisoning)

中毒攻击的目标可能是模型、模型的训练数据或企业的不安全数据源。中毒攻击的目的是歪曲模型产生的结果或预测,其结果是公司会依赖于有缺陷的结果,做出错误的、可能具有破坏性的决策,传播错误或不正确的信息,或根据模型输出采取其他不明智的行动。

对抗式人工智能(Adversarial AI)

对抗式AI攻击发生在模型部署和使用之后。这些攻击的方法各不相同,但都非常巧妙、难以检测,而且非常非常危险。例如,模型反转攻击(Model Inversion)会审查模型的输出,以发现有关模型本身或其训练数据集的敏感信息,这可能会导致隐私泄露;水印攻击(Watermarking)改变训练模型的参数,嵌入一个隐藏模式,用来 "证明 "模型的所有者。这可能导致重大经济损失和竞争优势的丧失等等。

进而,在产品层面,公司同样推出了Calypso AI平台,与Robust Intelligence不同的是,Calypso的平台搭建则是从VESPR Validate这一AI模型评测功能入手,于2023年年初才推出Calypso Moderator这一防护功能板块。

VESPR Validate

VESPR 通过对客户提供的测试数据应用真实世界的扭曲来评估ML模型的准确性和稳健性,从而进行严格的、业界领先的性能和压力测试。VESPR平台使企业能够部署可扩展的可靠模型验证流程,并支持整个业务和运营功能的自动化,而无需直接访问客户或第三方模型或训练数据。其功能包括:

在不同的风险下对模型进行压力测试

在真实世界的各种情况中对模型进行稳健型测试

全自动化流程生成反馈报告

CalypsoAI Moderator

Moderator则专注于AI模型运行和搭建过程中的安全风险,与AI防火墙有一定相似性,其功能包括:

通过审查语言模式和语言类别(如角色扮演、假设对话、世界构建和逆反心理)来识别用户试图违反规则的尝试,从而保护客户免受他人试图忽视或推翻系统控制的影响。

同时,扫描模型传出和传入的内容,以发现有毒、有偏见或其他不可接受的内容。

向客户发送提示,除非对上述不合规的内容进行更改,否则将不会运行该内容,而且详细的修改历史记录对构建该模型的工程师可见。

向团队leader提供按单个用户或用户组分列的详细使用交互评估,并提供全面的可审计性和归因跟踪,更加促进团队创新与合作。

客户及合作伙伴

Calypsop VESPR评测系统的客户群体主要是美国国防和安全部门,而其Moderator模块由于是2023年年初发表的,官网上还未公布合作客户,但根据硅谷新闻报道,其已经和OpenAI, Google, Cohere和A121 Labs Inc等多个大模型头部公司达成合作。

VESPR的受众,均为美国国防与安全部门

团队情况

Calypso AI的核心团队与美国政府有着极为紧密的合作,其CEO Neil Serebryany毕业于南加州大学,Neil原来是世界上最年轻的风险投资人之一,后成为国防部文职人员参与国家安全创新的第一线工作,最终在2018年创立Calypso AI。此外,Calypso的CTOJames White则具有16年相关领域从业经验,James曾作为工程负责人协助建设和扩展Security&Data-oriented的公司,包括FireEye Mandiant和Qualtrics,他曾为美国州政府和联邦政府机构以及众多商业客户构建和交付软件。

融资情况

Calypso AI同样进行过三轮融资,共融资3820万美元,其中,公司的最新一轮融资为2023年6月,此轮融资共获得资金2300万美元。

Patronus AI

公司历史及简介

Patronus AI是今天介绍的三家AI安全公司中最年轻的创始企业,是CEO Anand Kannappan在2023年的二次创业作品,公司总部设在纽约州。与前两家公司稍有区别的是,Patronus AI是业内首个面向大语言模型的自动化评估和安全平台,其使命为“Detect LLM mistakes at scale and use generative AI with confidence”。

公司产品及核心业务

公司业务关注到了大语言模型错误相较于其他种类AI风险的特殊性和急迫性,主要包括;

大语言模型的不确定性本质使预测故障变得困难。大语言模型是概率性系统。由于其输入范围不受限制(在上下文长度限制内),提供了广泛的攻击面。因此,发生故障的原因将非常复杂。

目前还没有标准的大语言模型测试框架。软件测试已经深度集成到了传统工程工作流中,有单元测试框架、大型质检团队和发布周期等,但企业还没有为大语言模型开发出类似的流程。连续、可扩展的评估、识别并记录大语言模型错误以及性能基准测试对于产品化使用大语言模型至关重要。

学术基准无法反映真实世界的情况。企业目前在学术基准(如HELM、GLUE等)上测试大语言模型,但这些基准无法反映真实的使用场景。学术基准趋于饱和,并存在训练数据泄露问题。

AI 失败的长尾现象非常严重,最后的20%极具挑战性。对抗性攻击已经表明,大语言模型的安全问题远未解决。即使通用预训练语言模型展示了强大的基础能力,仍存在大量未知的失败情况。Patronus在对抗模型评估和鲁棒性方面做了大量开创性的研究,但这只是开始。

进而,在产品层面,公司推出了行业内部面向大语言模型的自动化评估和安全平台,在此平台上,客户能够大规模自动化检测大语言模型错误,从而安全地部署 AI 产品。

Patronus AI平台

Patronus大平台的功能包括:(以下功能均为自动化实现)

评分(Score Model Performance):评估大语言模型在实际场景运用中的模型性能和关键指标,如 hallucination 和安全性。

生成测试(Automate Testing):自动生成大规模对抗测试集。

基准测试(Benchmarking):比较模型,帮助客户确定特定用例的最佳模型。

客户及合作伙伴

目前,Patronus主要客户集中在AI厂商,但是在和金融公司积极洽谈合作。Patronus AI在官网上列举的主要客户包括Cohere(大语言模型公司)、Nomic AI(AI数据引擎)和Naologic(零代码平台),均属于AIGC的下游应用领域。

Patronus AI的客户

团队情况

Patronus AI的两位创始人均为芝加哥大学计算机系毕业,他们不仅有着深厚的友谊,且均在Facebook中担任与AI大模型相关的重要职位。 Rebecca和Anand认识将近10年。在芝加哥大学一起学习计算机科学后,Rebecca加入Meta AI(FAIR)负责NLP和ALGN 相关研究,而Anand在Meta Reality Labs开发了早期的因果推断和实验基础。在Facebook的Meta团队,两人亲身经历了评估和解释机器学习输出的困难——Rebecca 从研究角度,Anand从应用角度。

值得一提的是,由Anand Kannappan共同创立的Kyber Techonologies在2020年被Dark Forest Techonologies收购而成功退出,Patronus AI则是Amand的二次创业作品。

融资情况

Patronus AI在2023年9月宣布获得了来自 Lightspeed Venture Partners的300万美元种子轮融资,跟投者还包括Factorial Capital等,是AI安全界一家冉冉升起的新星。

结语

从Robust Intelligence、Calypso AI和Patronus AI三家企业的身上,我们看见了海外的AI安全初创企业在守护AI大模型中的努力,更看见了AI安全愈发凸显的重要性,和AI安全概念的不断演变与发展。从最底层的AI Safety风险,到更上层的公平性与鲁棒性,AI大模型的发展距离成熟仍有漫漫长路要走。但在其中,AI防火墙与AI评测系统——这三家公司交出的共同答卷,成为了大家可以去摸索和努力的重要参考。期待中国能涌现越来越多优秀的AI安全厂商。

作者:吴思嫣

编辑:范云辰

参考资料:

https://www.patronus.ai/company

https://www.patronus.ai

https://www.crunchbase.com/organization/

https://mp.weixin.qq.com/s/QvsAVO7FplML9NXqlbBfAg

https://siliconangle.com/2023/09/14/automated-evaluation-security-platform-startup-patronus-ai-launches-3m-funding/

https://www.robustintelligence.com/company/about

https://baijiahao.baidu.com/s?id=1718997015524188314&wfr=spider&for=pc

https://www.crunchbase.com/organization/robust-intelligence/company_financials

https://calypsoai.com/what-is-ai-security/

https://siliconangle.com/2023/06/27/calypsoai-raises-23m-stop-employees-sharing-sensitive-data-generative-ai-chatbots/

https://www.crunchbase.com/organization/calypso-ai/company_financials

人机对齐概述|10. AGI可能导致的生存性风险:早期的概念性探讨

尹晓东︱我国人工智能与算法的监管初具雏形——《生成式人工智能服务管理暂行办法》解读

美召开听证会讨论《人工智能两党立法框架》:从柔性治理迈向硬监管思路日益明朗

人工智能安全笔记(1)概论

免责声明

*本公众号仅作为学习和研究使用,不构成对任何人的投资和建议,您直接或间接基于本公众号内容做出的投资应自行承担风险,航行资本及作者不对此承担任何责任。

*以上信息均为航行资本基于网络公开信息渠道整理,航行资本不为以上信息的真实性、准确性做任何保证。

*本公众号上所转载或引用内容均标注来源及出处,仅代表原作者本人,不代表航行资本立场。转载或引用内容的版权归原作者所有。如涉嫌侵权,请及时联系我们,我们将及时更正或删除有关内容。

*如需转载本深度调研,或对以往调研内容感兴趣,请联系:zhihouchen@voyagers-partners.com。

声明:本文来自航行资本,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。