前情回顾·大模型安全动态

安全内参2月28日消息,研究人员发现,通过破坏AI模型托管平台Hugging Face的Safetensors格式转换服务,攻击者可以劫持用户提交的模型,造成供应链攻击。

Hugging Face是一个广受欢迎的协作平台,帮助用户托管预训练的机器学习模型和数据集,并进行构建、部署和训练。

安全厂商HiddenLayer 在上周发布报告指出:“攻击者可以基于Hugging Face转换服务,将带有控制数据的恶意拉取请求发送给平台上的任意存储库,并劫持通过转换服务提交的任意模型。”

换而言之,恶意行为者可以利用被Hugging Face服务转换的被劫持模型发起攻击,伪装成转换机器人,请求对平台上的任何存储库进行更改。

攻击手法介绍

Safetensors是Hugging Face公司设计的一种格式,旨在安全存储张量。与之相反,(PyTorch模型使用的)pickle格式可以被威胁行为者武器化,用于执行任意代码并部署Cobalt Strike、Mythic和Metasploit的攻击载荷。

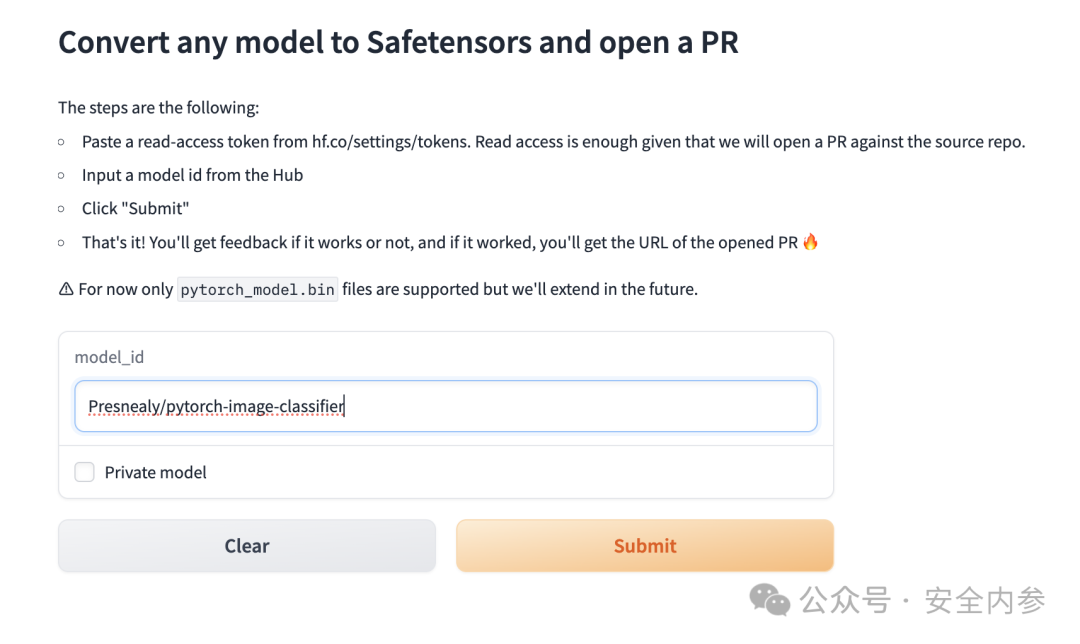

Hugging Face支持一项转换服务,允许用户通过拉取请求将任何PyTorch模型(即pickle格式)转换为等效的Safetensor格式。

图:攻击者可以向网站上的任意模型发出格式转换请求

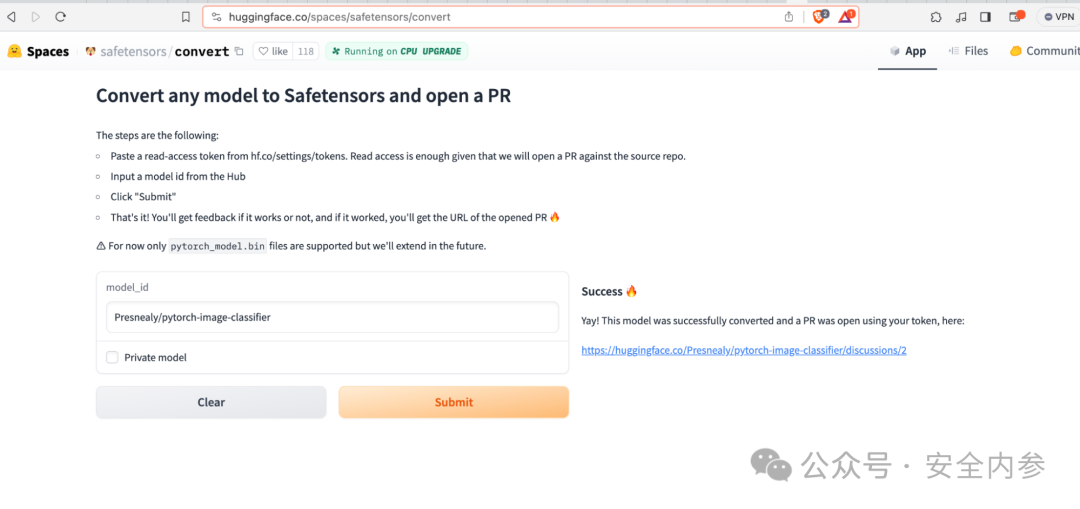

HiddenLayer公司对该模块分析发现,攻击者可以通过使用恶意PyTorch二进制文件破坏托管的转换服务,并破坏文件托管系统。

图:成功转换恶意PyTorch模型并使用Hugging Face服务发出拉取请求

更为重要的是,攻击者还可能窃取与SFConvertbot(专门设计用于生成拉取请求的官方机器人)相关联的令牌,从而向网站上的任何存储库发送恶意拉取请求。威胁行为者可以利用此机会篡改模型并植入神经后门。

研究人员Eoin Wickens和Kasimir Schulz指出:“只要有人尝试转换他们的模型,攻击者可以随时运行任意代码。用户本身不会收到任何指示,他们的模型在转换时可能被劫持。”

通过这种攻击方式,一旦用户尝试转换自己的私有存储库,就可能导致Hugging Face令牌遭盗取,内部模型和数据集被访问,甚至被感染的风险。

更为复杂的是,由于任何用户都可以提交公共存储库的转换请求,对手可以利用此机会劫持或更改广泛使用的模型,从而造成重大的供应链风险。

大模型安全威胁层出不穷

研究人员表示:“尽管Hugging Face生态系统旨在保护机器学习模型的安全,但转换服务已被证明存在脆弱性,并可能通过Hugging Face官方服务引发大规模供应链攻击。”

“攻击者可能会获得进入运行该服务的容器的立足点,并破坏该服务转换的任何模型。”

一个多月前,安全厂商Trail of Bits披露了LeftoverLocals漏洞(CVE-2023-4969,CVSS 评分:6.5)。该漏洞允许从 苹果、高通、AMD和Imagination通用图形处理单元(GPGPU)中恢复数据。

这个内存泄漏漏洞源于未能充分隔离进程内存,使得本地攻击者可以从其他进程读取内存信息,比如另一个用户与大型语言模型(LLM)的交互会话。

安全研究人员Tyler Sorensen和Heidy Khlaaf表示:“这种数据泄漏可能会产生严重的安全后果。随着机器学习系统的流行,后果会尤其严重。这些系统将本地内存用于存储模型输入、输出和权重。”

参考资料:https://thehackernews.com/2024/02/new-hugging-face-vulnerability-exposes.html

声明:本文来自安全内参,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。