刘佳妮 王月禾

(中国人民大学国际关系学院)

摘要:语言是维系国家政治文化共同体的纽带,也是国家文化制度的基础。在总体国家安全观的理论体系中,文化安全是国家安全全局的保障要素,而语言安全从属于文化安全中的表征性文化符号安全,是判断文化安全状态的重要指标。在人工智能时代,大语言模型的架构者可以通过训练数据监督和微调数据使用,让模型带有特定的集体价值观念和意识形态属性,在与社会的海量交互中进行渗透,对语言安全产生两方面风险。一是直接风险,大语言模型中自然语言的主导权引发文化主权之争,世界主要经济体竞相开发本土化模型,加剧“语言安全化”。二是间接风险,带有意识形态属性的大语言模型潜移默化地侵蚀主流社会价值观和核心价值意识形态,进而削弱国民对标准通用语的认同,造成“语言不安全”。语言安全风险具有长期隐蔽累积的特性,一旦显现则难以弥补。因此,我们需要树立底线思维、防微杜渐,加强人工智能顶层设计,积极推动国家通用语言模型的开发和应用,完善人工智能领域法律法规,警惕价值偏见风险,增强价值对齐能力,从而有效维护国家语言安全和文化主权。

关键词:总体国家安全观;语言安全;文化安全;人工智能安全;大语言模型

1. 引言

以数智化为主要特征的新一轮工业革命正经历着由导入期到拓展期的关键阶段,以人工智能为代表的新通用目的技术和使能技术 成为全球经济发展的新动能。其中,ChatGPT、Claude、Gemini等大语言模型(Large Language Model,简称LLM)凭借其强大的自然语言处理技术和突破性的内容理解及生成能力推动着生产和生活方式的变革。虽然人工智能技术并非基于安全目而诞生,但其核心特性决定其能够与安全体系内的诸多环节形成深度链接,从而具有国家安全属性(封帅2023)。开放全球应用程序安全项目(Open Web Application Security Project, 简称OWASP)总结了大语言模型的十大内生性技术安全风险, 在广阔的应用场景下,这些人工智能安全领域的风险产生了外溢效应,影响着国家政治安全、军事安全和文化安全等众多国家安全领域。

语言是维系国家文化共同体的纽带,语言安全是文化安全的重要组成部分。习近平总书记指出,“语言是人类交流思想的工具、传承文明的载体、增进理解的桥梁。中文承载着中华民族数千年的文明智慧,是中国贡献给世界的重要公共文化产品” (习近平2024)。信息生成和传播技术的发展和迭代对于主权国家的文化安全产生了深刻影响。十多年前,研究者们还在热烈探讨经济全球化背景下网络信息技术发展对我国文化安全和意识形态的冲击和影响(张骥2010)。而时至今日,生成式人工智能技术已经悄然融入生活,计算、网络监控基础设施和统计模型正在重塑人们思考和建构“国家安全”概念的方式(Hoffmann 2021)。大语言模型的内生性技术风险直接或间接地影响着语言安全,并可能引发潜在的“黑天鹅”和“灰犀牛”事件。因此,本文在立足语言安全相关研究的基础上,首先对总体国家安全观理论体系下的语言安全概念进行界定,明确语言安全的多样性内涵。其次,本文分析了大语言模型以何种作用机制影响语言安全,并阐明此种影响的具体内容和方面。最后,本文尝试提出应对策略,从而有针对性地解决大语言模型带来的风险。

2. 总体国家安全观理论体系下语言安全的概念界定

2.1西方“语言不安全”理论及其演进

“语言不安全”(linguistic insecurity)是西方社会语言学的核心术语之一,与身份政治(identity politics) 密切相关。在大量移民涌入美国的时代背景下,美国语言学家Haugen (1962)率先提出“语言不安全”概念,指说话者面对同一语言存在的不同规范或习惯,在使用语言变体时因担心被其他人嘲笑而产生的怀疑、不安的心理,以及由此导致的重视语言形式大于具体内容的现象。在此基础上,另一位美国语言学家Labov (1966)将“语言不安全指数”作为测量社会各阶层语言不安全程度的量化分析工具。根据Labov (1973)在纽约进行的社会调查,所有阶层都或多或少受语言不安全影响,其中,中下阶层说话者的语言不安全程度最高,更容易因担忧自身使用的语言形式不符合对话者期望的标准而感到焦虑或缺乏信心。

随着更多社会语言学者注意到了这种广泛存在于一种语言内部或是多种语言之间的不安全现象,“语言不安全”理论逐步形成了较为成熟的体系。在总结既有研究的基础上,法国语言学家Calvet (2006)将语言不安全划分为三种类型。一是语言形式(不)安全,指说话者认为自身使用的语言形式不符合某种语言标准和规范而感到不安;二是语言地位(不)安全,即说话者认为自身使用的语言没有地位或缺乏合法性,从而对该语言乃至自身作出负面评价;三是语言身份(不)安全,指说话者认为自身使用的语言与其所属或希望所属的身份不相符时产生的身份焦虑。其中,第一种类型由语内交际下同一语言的不同形式变体而产生,而后两种类型则将语言不安全概念从语内交际拓展到多语环境下的跨语言交际。需要注意的是,尽管西方语言不安全理论并不排斥群体行为,但该理论仍倾向于从个体微观视角出发,运用问卷、访谈、抽样、模型等行为主义计量方法展开研究。如果为这一理论范式加上限定语,可以是“个人语言不安全”“族群语言不安全”或“阶级语言不安全”,但“国家语言不安全”就显得难以概括了。

2.2 中华语言安全传统与总体国家安全观的语言安全概念

西方语言学的“语言不安全”理论脉络始终以个人主义世界观为主导,而中国的语言安全自出现伊始就与“大一统”的集体主义、整体主义密切相关,是“国家语言安全”。费孝通(2007)曾言,“最早的文字就是庙堂性的”,语言和文字具有政治社会属性,构成了一个国家文化制度的基础。语言和文字共同体不安全,也就意味着文化制度基础受到动摇。因此,历代统治者大多致力于在广袤疆域下推行汉字的“书同文”和官方语言的“语同音”,这也构成了中华民族政治文化共同体的基础。

“书同文”是建立有效科层官僚制和政治文化共同体的充分条件。统一而标准化的文字可以跨越时间和空间,让各个朝代、中央和地方各级官僚逐渐产生并分享一种对中华文明而非对某个政权的政治文化忠诚和职业伦理,进而形成相近的价值判断、工作程序和制度环境,最终构建可以通过文字交流的政治文化共同体。同时,中华大地上存在着众多基于方言的语言共同体,如果没有全国性的通用语言(如“雅言”“官话”和普通话),那么普通民众形成的就是地方认同而非国家认同,从而会大大削弱“书同文”对国家统一或者国家安全的维护作用(苏力2013)。在封建时代中国的“朝贡体系”中,交趾国(今越南)、新罗(今朝鲜半岛)等藩属国都实现了同中央政府“书同文”,但始终没有做到“语同音”。因此一旦中央控制力减弱,对本民族文化仍存在着根本认同的藩属国便从宗主国分离了出去。以现实的国家安全问题为导向,语言安全已成为当今国土安全和边疆治理中的迫切问题。以西北某地区为例,截至2016年仍有多达1000万居民不懂国家通用语言(秦中春2017)。这既影响着国家基本公共服务的落实,也阻碍着政治文化共同体的塑造以及边疆民族地区国家认同的加强(候为刚2023)。

冷战结束后,资本主义文明主导下的全球化不仅深刻影响着各国的经济结构,也在某种程度上消弭了国家和民族的文化边界,带来了空前的文化冲突和融合。本世纪初,中国积极融入全球化并加入世贸组织,西方强势文化凭借其文化资本、网络技术和文化市场优势快速进入中国,一定程度上控制了文化交流的流速和流向,造成了中西方文化交流中不对等的输入和输出关系(胡惠林2005)。在文化和文明的交流互鉴之余,西方国家对于社会主义中国的文化和意识形态渗透也从未停止,中国政府和学界对于文化安全逐渐重视。1999年,江泽民在全国外宣工作会议上首次提及“维护我国的政治经济文化安全” (江泽民1999)。2003年,胡锦涛在中央政治局第七次集体学习时指出:“要始终高举社会主义文化旗帜,确保国家的文化安全和社会稳定”(胡锦涛2003)。进入新时代,习近平文化思想高度重视文化安全工作,围绕坚定文化自信、建设文化强国、保障文化安全等价值目标,把维护文化安全作为国家安全的重要保障(中共中央宣传部、中央国家安全委员会办公室2022)。

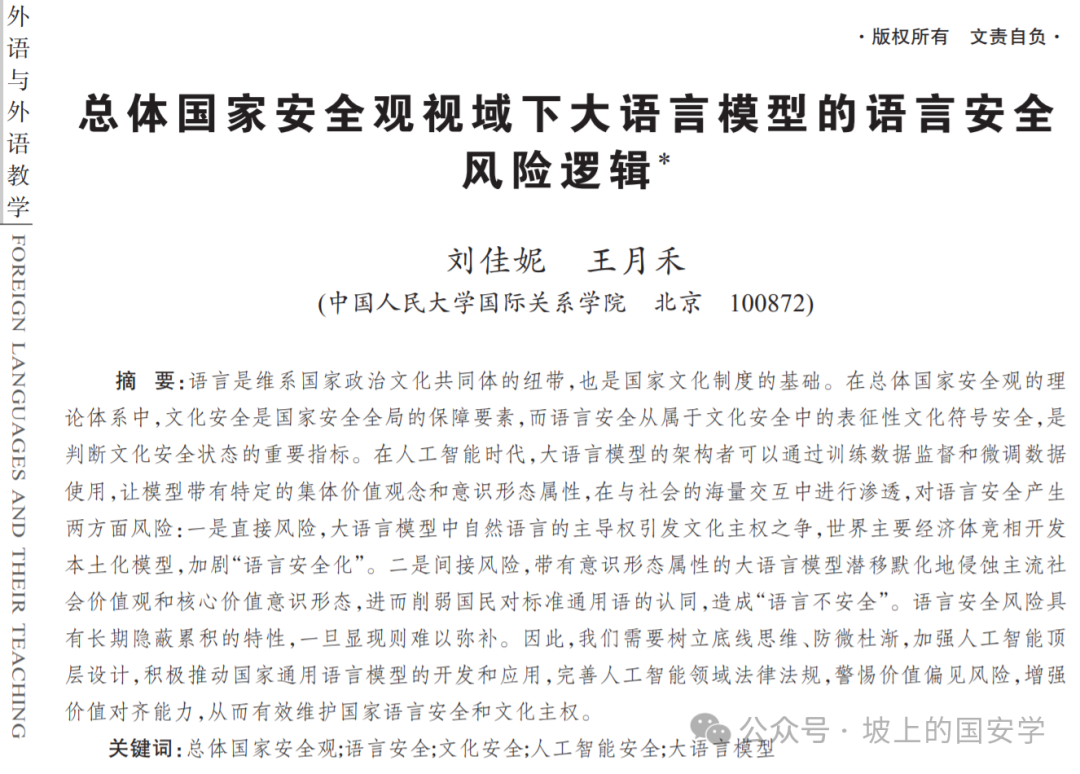

文化安全具有复杂性、隐蔽性和长期性,而文化产业安全、文化遗产安全和语言安全则是文化安全状况的显性指标。总体国家安全观是指引新时代国家安全工作的管总思想,为厘清语言安全概念的定位、内涵与外延提供了根本遵循。在总体国家安全观“五大要素”基本原理 中,文化安全是国家安全全局的保障要素,包括文化主权安全、核心价值意识形态安全、社会主流价值观安全和文化符号安全等内容(中国现代国际关系研究院2021;国家文化安全知识百问编写组2022)。在新时代维护文化安全,意味着要坚持马克思主义在意识形态领域的指导地位,坚定文化自信,坚持以社会主义核心价值观引领文化建设,加强社会主义精神文明建设,推进社会主义文化强国建设(总体国家安全观研究中心2023)。语言安全在既有研究中大多被纳入文化安全的下位概念(刘海涛2021),属于表征性的文化符号安全。除语言安全外,文化产业安全、文化遗产安全也同属于此类文化安全子范畴(如图1)。

图1语言安全在总体国家安全观理论体系中的定位

语言安全是文化安全最直观的风向标,不愿使用某种语言文字直接反映出对这类文化的不认同。“书同文”“语同音”是中华民族文化共同体得以维系的纽带,也是国家语言文字处于安全状态的表现。结合总体国家安全观理论体系对语言安全的定位,我们可以尝试将语言安全(或称语言文字安全)的内涵界定为:国家标准通用语言和文字在全国范围内的合法性地位与广泛性认同不受内外威胁和重大风险影响的状态,以及保持这种可持续状态的能力。语言是一种社会资源,因其载体性、工具性而广泛渗透在文化、政治、经济、军事各领域(沈骑 2022)。因此,语言安全领域的风险和威胁不仅会影响到文化安全各子领域,还可以广泛外溢到政治安全、国土安全、经济安全、军事安全、人工智能安全等国家安全重点领域。反之,政治安全、国土安全、人工智能安全等领域的风险和威胁也可以通过影响文化安全各子领域传导至语言安全。本文所探讨的大语言模型对语言安全的影响,正是遵循人工智能安全风险外溢到文化安全子领域这一逻辑路径。

3. 大语言模型崛起下的语言安全新风险

3.1 大语言模型安全风险影响语言安全的作用机制

语言安全问题是衍生的而非原生的,因此具有很强的隐蔽累积性。换言之,语言安全受到威胁和遭遇危险往往是被动的,通用语言和文字的合法性地位和广泛性认同遭受威胁大多是从文化安全的其他领域传导而来的。语言安全是文化安全的晴雨表,只有深层性的社会主流价值观安全、核心价值意识形态安全,甚至文化主权安全风险累计超过了阈值,才能表现为语言文字的不安全。因此,语言安全风险通常是不显著的,一旦显现则很难弥补处置。

大语言模型是生成式的人工智能工具,这一工具在样本输入输出、数据训练等过程中存在的内生性技术风险,若遭到利用,可以引发严重的意识形态安全威胁。多项研究显示,大语言模型只接触少量受意识形态驱动的样本就会显著改变意识形态和政治倾向(Chen et al. 2024; Motoki et al. 2024)。这表明大语言模型可以被赋予理解特定意识形态的“愿景”,并通过自我对话功能反复强化这种被灌输的意识形态。模型的超强学习能力在这一场景下成为了“阿克琉斯之踵”,大语言模型甚至可以从一个话题中吸收意识形态,并将其归纳到另一个不相关的话题中(Zhou et al. 2023)。因此,大语言模型的意识形态很容易被影响和塑造,架构者通过训练数据(training data)监督和微调数据(fine-tuning data) 使用可以让大语言模型自动代理 (LLM automation agents) 生成框架带有明显的集体价值观念和意识形态属性,进而产出带有内嵌价值观和意识形态的交互产品。

在与社会公众的海量交互下,大语言模型对于语言安全的作用机制体现在直接影响和间接影响两个方面。就直接影响而言,以英语为主要自然语言的大语言模型会对非英语国家的标准通用语言和文字造成冲击,影响通用语言文字的合法性地位。模型中自然语言的主导权引发国家对于文化主权的竞争,使得本应成为文化互鉴载体的语言进一步安全化。就间接影响来说,随着大语言模型在教育、媒体等行业领域的广泛应用,带有集体价值观念和意识形态属性的大语言模型会对主流社会价值观和核心价值意识形态造成负面影响,潜移默化削弱还未形成稳定价值观的青年学生群体,以及边疆、少数民族地区对于标准通用语的认同,进而造成语言不安全。(如图2)

图2大语言模型影响语言安全的作用机制

3.2 加剧意识形态渗透,巩固强化英语霸权

资本主义原始积累与殖民扩张时代,英语国家在政治、经济和文化等领域的垄断实力促使英语确立起国际通用语的地位。随着经济全球化的快速发展,英语逐步成为以美、英为首的英语大国推行“文化霸权”、实行“文化统治”的重要工具(曹杰旺2005)。进入人工智能时代,大语言模型的风靡进一步巩固和强化了英语霸权,使英语在人工智能领域形成凌驾于其他语言之上的绝对优势,加大了英语语言文化侵略和意识形态渗透力度。

第一,主流大语言模型以英语作为基本工具和表述载体,扩大了英语的应用范围,巩固了英语在国际交流中的主导地位。这些模型通常依赖于庞大的英语内容数据集进行预训练,通过深度学习海量文本中的语言使用模式,为人类指令提供文本响应。具体而言,大语言模型并不直接理解词汇本身的含义,而是通过捕捉上下文线索、文体结构、表达方式、语言模式和词频构建响应。换言之,这些模型往往默认复制并延续占主导地位的英语及其使用模式,排斥或忽略其他语言。“当写作工具将一种写作方式优先于另一种写作方式时,它们会强化现有的等级制度,这些等级制度不公平地将标准美式英语和女王英语置于其他语言和写作方式之上。” 尽管被广泛使用的ChatGPT等大语言模型已支持多种语言,并自称可以满足不同国家和地区的语言需求,但事实上这些模型在英语语境下的表现仍然最为出色,使用其他语言则明显表现较差,以至于需要耗费大量时间对其进行渐进式训练才能收获相对良好的效果。特别是,对于拥有大量文字和变体、分词和词性标注相对复杂的语言,ChatGPT等模型在收集其语言数据集时存在较大难度,导致这些语言数据集的质量更加落后。以汉语为例,高质量汉语语言数据集的缺乏使大语言模型难以有效吸收转化汉语数据,汉语使用者出于和语言模型沟通精确度的需要也更倾向于使用英语等语言进行交流,进一步加剧了汉语在数字化时代的“信息孤岛”问题,对汉语语言文化的发展产生负面影响(彭泽润2023)。

第二,大语言模型往往在处理自然语言的过程中吸收和宣传特定国家的价值观和意识形态,这些主要基于英语语料构建的模型在很大程度上已成为英语国家意识形态的传播媒介,对非英语国家的使用者造成潜移默化的影响。同时,大语言模型具备根据用户的兴趣、偏好提供定制化信息和内容的能力,信息推荐功能使用户往往只能获取到与自身观点相符的信息,从而深化其对某种意识形态的认同感。这种高度个性化推荐所产生的“信息茧房”效应使用户接触的信息越来越局限,导致不同价值观和意识形态之间的隔阂和误解不断加深。在此基础上,ChatGPT等大语言模型对群体用户画像的深度分析使其成为国家间开展认知域作战的有力武器,国家得以基于目标群体更熟悉、更具好感的宣传模式,实现意识形态颠覆活动从“无差别投送”向“精确且有差别”方向的转变,意识形态渗透的效能与效率大幅提高(黄日涵、姚浩龙2023)。

3.3 助长虚假信息传播,损害社会主流价值

快速发展的大语言模型助长了虚假信息的制造和传播,使社会主流价值观安全面临威胁和风险。由于自然语言生成技术擅长快速输出包括新闻报道、社交媒体信息在内的大量看似真实的文本内容,这些具有高度迷惑性和欺骗性的虚假信息能够迅速地在网络空间中扩散,误导公众认知并扰乱社会秩序,对国家公信力和社会稳定造成负面影响。有研究表明,虚假信息在人群中的传播速度达到真实信息的6倍,传播范围也比真实信息更广,特别是,虚假的政治信息比恐怖主义、自然灾害、科技或金融等其他类型的虚假信息传播得更广泛、更快速(Vosoughi 2018)。长期以来,掌握国际话语权的美西方国家政府和媒体通过集中报道针对中国的有失全面、客观的负面议题,对中国国家形象进行抹黑和扭曲,目的在于加深海外民众对中国的刻板印象和偏见(邢丽菊、鄢传若斓2022)。大语言模型的“臆造”现象可能助推此类具有针对性的虚假信息加速散布,以恶意破坏特定国家的国际形象和声誉为目的,制造关于国家政策的谣言,刻意引导广大民众产生不满和抗议情绪。

大语言模型的崛起一定程度上提升了自然语言处理的智能化和自动化水平,然而这种技术进步也给国家的语言安全能力带来了多重负面影响。大语言模型的风靡源于其强悍的自然语言处理能力以及对复杂问题的自如应对,这种便捷性使得使用者越来越多地依赖于模型生成的文本,从而减少甚至忽视了对自然语言的学习和运用。同时,基于大量语料库进行训练的大语言模型所生成的文本往往是对既有语言模式的模仿而非创造,这些文本虽然语法正确、结构通顺,却缺乏人类语言的独特性和灵活性。特别是,ChatGPT等模型在生成讽刺、隐喻和挖苦等复杂语义方面存在局限性,导致语言形式的细微差别变得扁平化。人们越来越不擅长运用复杂、多样的语言表达自己的思想和情感,而是习惯于依赖模型生成的标准化、同质化的文本,文化表达和交流变得单调乏味。最终将导致国民的个人语言能力出现退化趋势,进而对国家语言安全能力也造成损害。

3.4 引发文化主权之争,加剧语言安全化

不同国家或地区开发的大语言模型均以本土语言和文字作为主导语言。随着大语言模型的不断发展,模型中自然语言设置的主导权逐渐成为了文化主权的象征。2024年4月29日,中国台湾科学技术委员会发布了完全以岛内数据为基础进行训练的“可信人工智能对话引擎”(Trustworthy AI Dialogue Engine,简称Taide)。该模型的语料库大部分由岛内的新闻、出版物和公开报告组成,以繁体中文为主导语言文字,并融入了台湾本地语法和口语。由于这些本地语料的存在,台当局声称Taide的输出结果将“更符合台湾的语言模式,比文心一言(Ernie Bot)和ChatGPT英译普通话的输出结果更具‘可信性’。” 由此可见,完全以岛内数据训练出的Taide是“语言安全化”的产物,也是台当局传播政治意识形态和争夺文化主权的工具,对语言安全产生的危害性不容小觑。

同时,世界主要经济体也竞相打造本土化的大语言模型。欧盟称开发一个符合欧洲价值观的多语言开源大模型对“加强欧洲数字主权并实现大语言模型的民主化”至关重要。欧洲最大的私人人工智能实验室Silo AI与图尔库大学合作完成了Poro大语言模型的训练,该模型以芬兰语为主要自然语言,迈出了建立一个覆盖欧盟所有官方语言的大语言模型SiloGen的第一步。韩国初创人工智能公司Upstage开发的Solar和最大搜索引擎Naver公司开发的Hyper CLOVA X大语言模型均基于韩语进行训练,并在全球大语言模型的算力排名中名列前茅。世界主要国家和地区打造由本土语言主导的大语言模型的竞争仍在持续,对文化主权安全的强调推动大语言模型的“语言安全化”现象愈演愈烈。

4. 防范语言安全新风险的应对策略

4.1 立足大国语言战略,引领语言安全实践

大国语言战略是国家战略的重要组成部分,为我国的语言安全实践工作提供指导。面对ChatGPT等大语言模型带来的语言安全风险,我们应当高度重视语言战略部署,重塑语言文字事业的战略价值。在总体国家安全观的指导下,我国的语言安全战略遵循“积极防御”的方针,统筹内部安全和外部安全。目前,我国的语言战略共有推广普及通用语言文字、科学保护各民族语言文字、做好国际中文教育、大力发展外语教育四个支柱(杨丹2023)。其中,建设国家通用语、保护多民族语言是维护语言安全、铸牢中华民族共同体意识的重要战略举措,而推动中文国际传播、加强外语教育则是弘扬中华文明、构建人类命运共同体的必由之路。既要强化本国语言传承和文化教育,深化国民对语言安全问题的理解与认识,也要面向构建人类语言共同体,以人工智能技术赋能全球语言教育的交流合作,夯实国家文化软实力根基。

4.2 加强人工智能顶层设计,鼓励本土语言模型开发和应用

首先,应由政府主导,从顶层设计着手集中政策资源,推动人工智能核心技术取得突破。政府可以通过产业政策、税收优惠等方式加大对人工智能行业的扶持力度,鼓励科技企业围绕本土语言模型的开发和应用展开研究。在此基础上,企业、高校和科研机构等主体应发挥互补优势,形成一个多层次的科技创新共同体,统筹本土语言模型的基础理论研究和实际应用能力,尽可能缩小与ChatGPT等国际先进水平模型的差距。此外,相较于国外语言模型平台采取的语言数据开源策略,国内各平台往往缺乏开源共享意识和文化,导致汉语数据集开源较少,进而影响到本土语言模型的性能和效果(彭泽润2023)。国内各人工智能平台应当重视、支持、发展开源,弘扬开放、协作、共享的互联网精神,充分发挥我国海量数据规模和丰富应用场景优势,推动我国本土语言模型持续发展。

4.3 警惕价值偏见风险,增强价值对齐能力

“价值对齐”(value alignment)即确保人工智能追求与人类价值观相匹配的目标,使人工智能理解和遵循人类意志、尊重人类客观利益,不对人类的价值和权利造成干扰或伤害(Gabriel 2020)。随着大语言模型引发的意识形态渗透和价值偏见风险不断扩散,如何有效提升大语言模型的价值对齐能力成为迫在眉睫的问题。一方面,要建立对带有价值观念和意识形态的大模型交互产品的审查机制,制定客观公正的评定标准,从而阻断有害社会主义核心价值观的意识形态对于深层次文化的渗透,形成维护语言安全的“第一道防线”。同时,这一过程中要始终坚持适度原则,以不干涉人工智能交互大模型的发展为底线。另一方面,应积极开展语言安全意识宣传活动,借助媒体、网络和社区等渠道,强调语言安全对于国家文化传承和社会稳定的重要性,引导国民关注和警惕ChatGPT等大语言模型可能存在的价值偏见风险,夯实语言安全的基层基础。

4.4 完善人工智能领域法律法规,统筹发展和安全

应当进一步完善人工智能领域法律法规,对现行监管措施进行审慎评估和修订,确保法律框架能够及时规制大语言模型的发展。近年来,我国已针对人工智能领域出台了一系列政策规范。然而,相较于大语言模型空前的发展速度和丰富的应用场景,现有规制体系仍不够完备,规制主体责任划分不够明晰,相关立法对于这些模型在语言生成、传播过程中可能引发的法律风险及规制措施存在内容模糊或内容缺漏的情况。对此,应统筹高质量发展和高水平安全。由政府主导,加快建设企业、社会等多元主体协同共管的监管方式,以法律法规形式明确大语言模型开发、应用过程中的各责任主体,制定相应的问责追责机制。同时,科技创新是发展新质生产力的核心要素 ,防范化解风险要建立在不限制干预技术发展的前提下进行,应以不发生系统性风险为底线,放开手脚加快探索步伐,力争占领新产业竞争的高地。

5. 结语

在总体国家安全观“五大要素”基本原理中,语言安全属于作为保障要素之一的文化安全,是表征性的文化安全。在中华文化崇尚的集体主义世界观下,“书同文”“语同音”是语言安全的充分条件,也是维系中华民族文化共同体的基础,二者互为表里,缺一不可。因此,从概念上来看,语言安全指的是国家标准通用语言和文字在全国范围内的合法性地位与广泛性认同不受内外威胁和重大风险影响的状态,以及保持这种可持续状态的能力。大语言模型易受意识形态操控,输出不符合使用者所在国家利益的态度和观点。受操控的大语言模型能够强化英语霸权,引发文化主权安全风险,造成国家通用语的合法性地位受损;也能通过对核心价值意识形态和社会主流价值的渗透,间接地削弱国民对于通用语的认同。如果对大语言模型可能带来的语言安全风险不加以重视,放任其累进升级,此类风险则很可能由文化安全领域扩散至政治安全、经济安全、社会安全领域,对社会稳定和国家统一造成负面影响。我们要清醒认识到此类风险的危害性和隐蔽性,以大国语言战略为指导,树立底线思维,未雨绸缪,通过推动本土语言模型的开发和应用,增强大语言模型的价值对齐能力,完善人工智能领域法律法规,提高语言安全意识和防范能力,维护语言安全和文化主权。

注释:

① 通用目的技术指的是具有广泛应用领域并能够促进经济增长和生产率显著提高的技术,使能技术指的是在特定产业领域能够促进科学与技术大规模工程化和商业化应用的技术(谢伏瞻2019)。

② 参见https://owasp.org/www-project-top-10-for-large-language-model-applications/llm-top-10-governance-doc/LLM_AI_Security_and_Governance_Checklist-v1.1.pdf。

③ 20世纪70年代以后,新社会运动将斗争阵地从经济领域转向文化与社会领域,多元文化主义思潮盛行,被阶级政治所忽略的领域如种族、性别、性偏好等纷纷主张多样化、差异化的文化权力,自此身份正式成为一种文化政治的主题(林红2019)。

④ 以人民安全为宗旨,以政治安全为根本,以经济安全为基础,以军事、科技、文化、社会安全为保障,以促进国际安全为依托。

⑤ 微调(fine-tuning)是指在已经训练好的模型基础上,进一步调整,让模型的输出能够更符合架构者的预期。通过微调可以不用重新训练新的模型,从而省去训练新模型的高昂成本。

⑥ 参见Bjork C, “The Conversation: ChatGPT threatens language diversity in the age of AI”, https://www.nzherald.co.nz/bay-of-plenty-times/news/the-conversation-chatgpt-threatens-language-diversity-more-needs-to-be-done-to-protect-our-differences-in-the-age-of-ai/JELVUI3CAFEP3PMIQITCDLRQBA。

⑦ 参见https://ketagalanmedia.com/2024/05/06/taide-taiwans-own-ai-project-highlights-geopolitical-implications。

⑧ 参见https://www.silo.ai/blog/europes-open-language-model-poro-a-milestone-for-european-ai-and-low-resource-languages。

参考文献:

[1]Calvet, L. 2006. Towards an Ecology of World Languages[M]. Cambridge: Polity.

[2]Chen, K., He, Z., Yan, J., Shi, T. & Lerman, K. 2024. How susceptible are Large Language Models to ideological manipulation? [EB/OL]. arXiv preprint, arXiv: 2402.11725.

[3]Gabriel, I. 2020. Artificial intelligence, values, and alignment [J]. Minds and machines, 3): 411-437.

[4]Haugen, E. 1962. Schizoglossia and the linguistic norm [J]. Monograph Series on Language and linguistics, 15: 63-69.

[5]Hoffmann, A. 2021. Terms of inclusion: Data, discourse, violence [J]. New Media & Society , (12): 3539-3556.

[6]Labov, W. 1966. The effect of social mobility on linguistic behavior [J]. Sociological Inquiry, (2): 186-203.

[7]Labov, W. 1973. Sociolinguistic patterns [M]. Philadelphia: University of Pennsylvania Press.

[8]Motoki, F. & Pinho Neto, V. & Rodrigues, V. 2024. More human than human: Measuring ChatGPT political bias [J]. Public Choice, 198(1): 3-23.

[9]Vosoughi, S.,Roy, D. & Aral, S. 2018. The spread of true and false news online [J]. Science, (6380): 1146-1151.

[10]Zhou, X., Wang, Q., Wang, X.,Tang, H. & Liu, X. 2023. Large language model soft ideologization via AI-self-consciousness [EB/OL]. arXiv preprint, arXiv: 2309.16167.

[11]习近平. 习近平向2024世界中文大会致贺信[N]. 人民日报. 2024年11月15日.

[12]曹杰旺. 2005. 关于英语霸权时代民族语言文化保护的思考[J]. 当代世界与社会主义, (4): 113-115.

[13]费孝通. 2007. 乡土中国[M]. 上海: 上海人民出版社.

[14]封帅. 2023. 国家安全学视域下的人工智能安全研究:议题网络建构的初步尝试[J]. 国际安全研究, (1): 26-49.

[15]国家文化安全知识百问编写组. 2022. 国家文化知识百问[M]. 北京: 人民出版社.

[16]胡锦涛. 2003. 始终坚持先进文化的前进方向,大力发展文化事业和文化产业[N]. 人民日报. 2003年8月13日.

[17]候为刚. 2023. 历史政治学视野下边疆安全治理的语言政策路径探析——基于 X 地双语教育政策实施历程(1949-2019)的考察[J]. 云南行政学院学报, (2): 12-22。

[18]胡惠林. 2005. 中国国家文化安全论[M]. 上海: 上海人民出版社,

[19]黄日涵 姚浩龙. 2023. 被重塑的世界?ChatGPT崛起下人工智能与国家安全新特征[J]. 国际安全研究, (4): 82-106.

[20]江泽民. 1999. 江泽民在对外宣传工作会议上发表重要讲话[N]. 光明日报.1999年2月27日.

[21]林红. 2019. 身份政治与国家认同——经济全球化时代美国的困境及其应对[J].政治学研究, (4):30-41.

[22]刘海涛. 2021. 国家安全视域下的语言问题[J].中国外语, (6): 10-16。

[23]彭泽润. 2023. ChatGPT等语言模型对国家安全领域的挑战 [EB/OL]. 中国社会科学网, https://www.cssn.cn/zzx/zzx_bjtj/202304/t20230417_5620400.shtml.

[24]秦中春. 2017. 治疆逻辑:新疆的长治久安和现代化治理研究[M]. 北京: 中国发展出版社.

[25]沈骑. 2022. 语言安全与语言规划研究[M]. 上海: 复旦大学出版社.

[26]苏力. 2013. 文化制度与国家构成——以“书同文”和“官话”为视角[J]. 中国社会科学, (12),78-95.

[27]谢伏瞻. 2019. 论新工业革命加速拓展与全球治理变革方向[J]. 经济研究, (7): 4-13.

[28]邢丽菊 鄢传若斓. 2022. 中国国家形象的塑造模式研究[J]. 东北亚论坛, (6): 3-17.

[29]杨丹. 2023. 大国语言战略[M]. 北京: 外语教学与研究出版社.

[30]张骥. 2010. 中国文化安全与意识形态战略[M]. 北京:人民出版社.

[31]中共中央宣传部、中央国家安全委员会办公室. 2022. 总体国家安全观学习纲要[M]. 北京:学习出版社、人民出版社.

[32]中国现代国际关系研究院. 2021. 文化与国家安全[M]. 北京: 时事出版社.

[33]总体国家安全观研究中心. 2023. 总体国家安全观透视:历史长河、全球视野、哲学思维[M]. 北京: 时事出版社.

Large Language Model’s Language Security Risks Logic from the Perspective of a Holistic Approach to National Security

Abstract: Language is the link that maintains the political and cultural community of a nation-state, and it is also the foundation of a nation"s cultural institution. In the theoretical framework of a holistic approach to national security, cultural security is a guarantee element of holistic national security, while language security is subordinate to the security of representational cultural symbols within cultural security, and is an important indicator for assessing the state of cultural security. In the artificial intelligence era, architects of large language models can train and fine-tune the data, so that the models carry specific collective values and ideological attributes, and penetrate the society"s value, which generates two kinds of risk. Firstly, the direct risk is that the dominance of natural language in the LLMs triggers disputes over cultural sovereignty. Major economies around the world are committed to developing localized LLMs, intensifying ‘language securitization’. Secondly, the indirect risk is that the LLMs with ideological attributes will subtly erode the mainstream social values and core value ideology, thus weakening the national identification with the lingua franca and causing ‘language insecurity’. The risks of language security have the characteristic of long-term hidden accumulation, and it is difficult to make up for it once it becomes a threat to cultural security. Therefore, we need to establish a bottom-line mentality, and actively promote the development and application of the local LLMs. Then we should strengthen the top-level design of AI, improve the laws and regulations in the field of AI, be vigilant against the risk of value bias, and enhance the ability of value alignment, so as to effectively safeguard the national linguistic security and cultural sovereignty.

Key Words: a Holistic Approach to National Security; Language Security; Cultural Security; Artificial Intelligence Security; Large Language Model

声明:本文来自坡上的国安学,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。