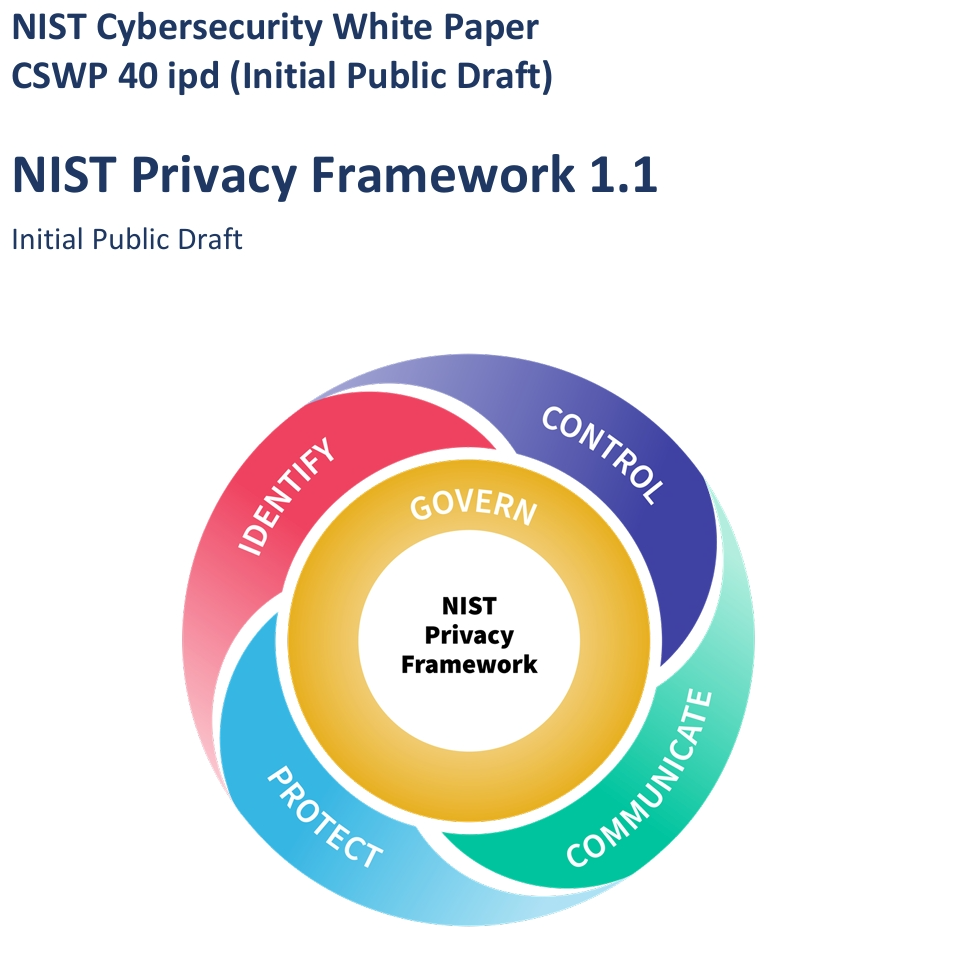

4月14日,美国国家标准与技术研究院(NIST)发布了新版NIST隐私框架(NIST Privacy Framework)并开始向公众征求意见。

与旧版相比,新版隐私框架增加了有关人工智能和隐私风险管理的章节,明确概述了人工智能与隐私的关系,以及如何使用隐私框架来管理人工智能隐私风险。

一、主要内容

新版隐私框架指出,人工智能系统可能因数据处理方式(如未经同意收集数据、隐私保护不足)或技术特性发隐私风险。例如:

1.数据训练问题:AI模型可能使用未经授权或敏感数据训练,导致隐私泄露。

2.隐私攻击:如数据重构、成员推断攻击等,可能暴露个人属性或行为。

3.偏见问题:AI系统中的统计或算法偏见可能导致歧视性结果,影响个人权益。

人工智能技术可能引发从尊严损害到具体危害(如经济损失、人身伤害)的多层次隐私问题,并可能波及群体或社会层面。

当前,人工智能与隐私风险的关系高度依赖具体应用场景,隐私保护措施可能与用户控制需求冲突。因此,各实体应当隐私风险评估(Privacy Risk Assessment)量化风险,选择包括缓解、转移、避免等方法在内的响应策略。

二、相关背景

NIST在3月24日发布的《有关对抗性机器学习(AML)攻击和缓解措施指南》(Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations)显示,人工智能系统在训练、部署和应用的全生命周期中,面临规避攻击、中毒攻击、隐私攻击、滥用攻击四大安全威胁,通过反复提问AI系统,攻击者能逆向推演出训练数据中的敏感信息。例如,医疗AI可能泄露患者病史,推荐算法可能暴露用户消费习惯。这些风险不仅威胁个人隐私,更可能危及公共安全与国家利益。

更深层的矛盾在于数据伦理的失控。以谷歌为例,其更新的隐私政策允许抓取所有公开网络内容(包括博客、代码甚至含个人信息的发帖)用于人工智能训练,引发“版权消亡”与“数据殖民”的争议。此类行为暴露了技术巨头在数据垄断与用户权益间的失衡,也凸显了现有法律对人工智能数据滥用的监管乏力。

本次更新的NIST隐私框架可以看作对此前发布的指南的回应与更新,体现了NIST控制人工智能隐私风险的尝试。

来源|NIST官网

编译 | 尚健

审核 | 唐巧盈

声明:本文来自上海市人工智能与社会发展研究会,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。