本文由冯登国院士、黄欣沂教授等18家单位的29位专家合作撰写,即将在SCIENCE CHINA Information Sciences上正式出版。

研究简介

人工智能(AI)正迅速改变各行各业,并重塑全球经济。从传统的人工智能到生成式人工智能,这些技术和应用带来了前所未有的效率和创新。在医疗、金融和交通等领域,AI的应用提升了服务的准确性和效率,推动了社会的发展。然而,随着AI技术的迅猛发展,安全和隐私问题日益突出。近期的事件表明,AI系统中存在许多安全漏洞,如数据泄露和恶意代码注入,这些漏洞导致了严重的财务损失和隐私泄露。尽管现有研究已探讨了AI系统中的特定安全威胁,但大多数研究缺乏系统性综合分析。为应对这些挑战,AI领域亟需更为深入和全面的安全性研究。

本文旨在系统性地分类和分析AI系统中的安全威胁及其防御策略,涵盖了人工智能生命周期中的训练阶段和推理阶段,既包括集中式设置,也包括分布式设置,同时涉及传统人工智能模型和基础模型。具体来说,本文工作包括以下几个部分:

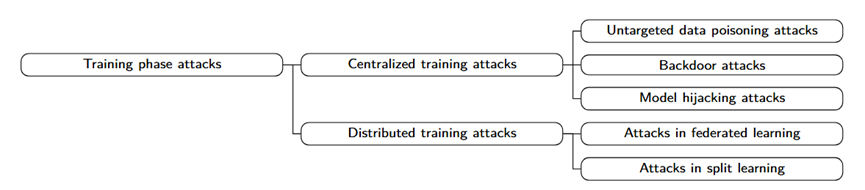

第二章介绍了集中式和分布式环境中的安全威胁。在集中式设置下,本文重点分析了数据中毒攻击,后门攻击和模型劫持攻击,探讨这些攻击如何在训练过程中影响模型的可靠性和安全性。在分布式设置下,本文首先讨论了联邦学习中的数据中毒和隐私推断问题,分析攻击者如何通过联邦学习的分布式特性进行恶意操作。其次,针对分割学习框架,本文分析了隐私推断和后门攻击的风险。

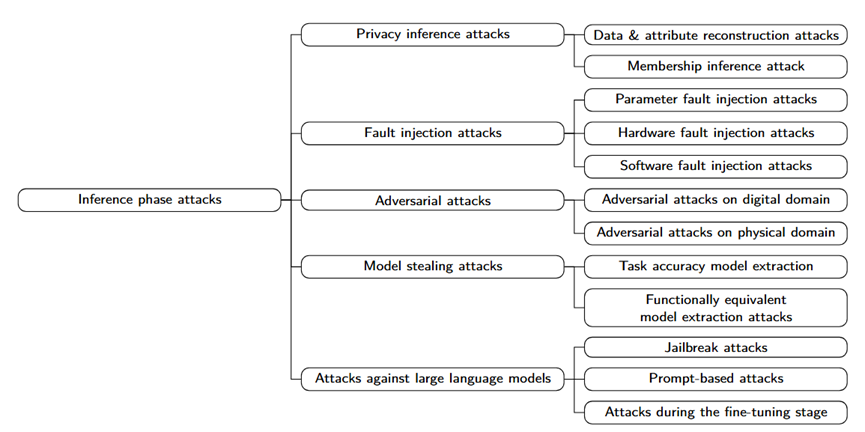

第三章聚焦于人工智能模型在推理阶段的安全威胁。在传统的集中式机器学习设置中,本文讨论了包括模型窃取、隐私推断、故障注入、对抗性攻击等常见攻击形式。随着基础模型的兴起,本文还对大语言模型中的特有攻击进行了简要探讨,包括越狱攻击,基于提示的攻击以及经过微调的攻击,并分析这些攻击如何破坏基础模型的安全性和隐私性。

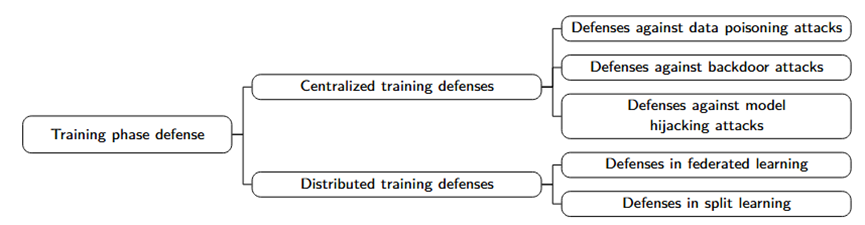

第四章介绍了针对训练阶段攻击的防御方法,涵盖了集中式和分布式人工智能系统的防御策略。针对集中式环境,本文讨论了针对数据中毒、后门和模型劫持攻击的防御技术,并分析了现有的防御方法的效果和局限性。针对分布式学习环境,本文重点分析了联邦学习和分割学习中的隐私保护技术和防御措施,探讨了如何在保证安全的前提下,优化数据处理和模型训练的效率。

第五章聚焦于人工智能模型在推理阶段的防御技术。在传统的集中式机器学习环境中,本文讨论了应对模型窃取、故障注入和对抗性攻击的策略,并介绍了隐私保护技术,如差分隐私和安全多方计算等。在大语言模型的推理阶段,本文探讨了如何应对越狱攻击和基于提示的攻击,介绍了针对这些新型攻击的防护方法,包括对抗训练、模型加固和内容过滤等技术。

通过全面分析人工智能模型在训练和推理阶段的安全威胁与防御策略,本文为人工智能研究人员和从业者提供了详细的系统性框架,帮助他们更好地理解AI系统中存在的漏洞,并为后续研究提供了有价值的参考。

https://dds.sciengine.com/cfs/files/pdfs/1674-733X/A5847D8A0FF745FEBC038ECE2755C50B-mark.pdf

声明:本文来自中国科学信息科学,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。