从“Big Other”到“Big Author”——生成式 AI 正在重塑监控资本主义,监控资本主义被AI放大:从知道你在做什么,到告诉你该做什么,再到替你做

“行为数据”升级为“心智数据”

当Shoshana Zuboff在2019年出版《监控资本主义时代》时,她以一种极具穿透力的语言,描绘了数字经济背后的权力构型。她提出,“监控资本主义”不是简单的数据滥用,而是一种新型的经济逻辑,它从人类的日常经验中提取行为剩余,借助机器学习将其转化为可交易的预测产品,从而实现深层操控。她认为,这种掠夺模式不仅侵犯隐私,更潜移默化地重构了个体的意志与社会的自治能力。

但Zuboff写下这本书时,距离ChatGPT的爆发还有三年。如今,当我们身处生成式AI(尤其是大型语言模型)日渐渗透的2025年,再回望她的诊断,不得不承认:那场关于“数字权力”的预言,既真实,也尚未穷尽全部风险。我们正在目睹的,并非旧时代逻辑的终结,而是它的加速与变异。行为数据的提取从未停止,只是从被动监测变成主动对话;用户画像从静态轮廓进化为动态语义模型;预测逻辑也从广告投放转向全链条内容生成与行为塑形。我们正走进一个“第二曲线”:Zuboff所说的“Big Other”——一个以监控为核心的计算-感知网络,正在让位于一个更强大也更隐蔽的角色——“Big Author”。

从预测到干预:语言模型成为新型共创权力

生成式AI的崛起,尤其是OpenAI的ChatGPT及其背后的GPT-4模型,打破了传统行为数据采集的方式。在Web 2.0时代,平台依赖用户点击、浏览、搜索等浅层行为,构建商业化模型;而现在,用户的语音、文字、图像、代码乃至思维过程,皆可通过对话接口实时上传,构成更丰富、更精细的行为材料。这些内容不再是用户在不知情中生成的“数字皮屑”,而是用户有意提供的“心智切片”——承载情绪、意图、认知、价值判断甚至道德倾向。这种内容密度的跃升,使得行为剩余的剥夺从表层滑向了深层,变得更难觉察,也更难拒绝。

而模型本身也从“预测工具”变成了“共创机器”。语言模型如今已能生成广告文案、销售邮件、投资简报,甚至法律合同与软件程序。谷歌与Meta已将生成式AI集成至其广告引擎,用自然语言快速生成素材并进行实时A/B测试。这种高度自动化与内容个性化的结合,模糊了传统意义上的“市场”与“中介”界限。平台不仅预测用户会做什么,更在制造用户的选择,让“自由意志”看似得以延续,实则被默默引导。

社会渗透与循环加速:模型正在塑造现实

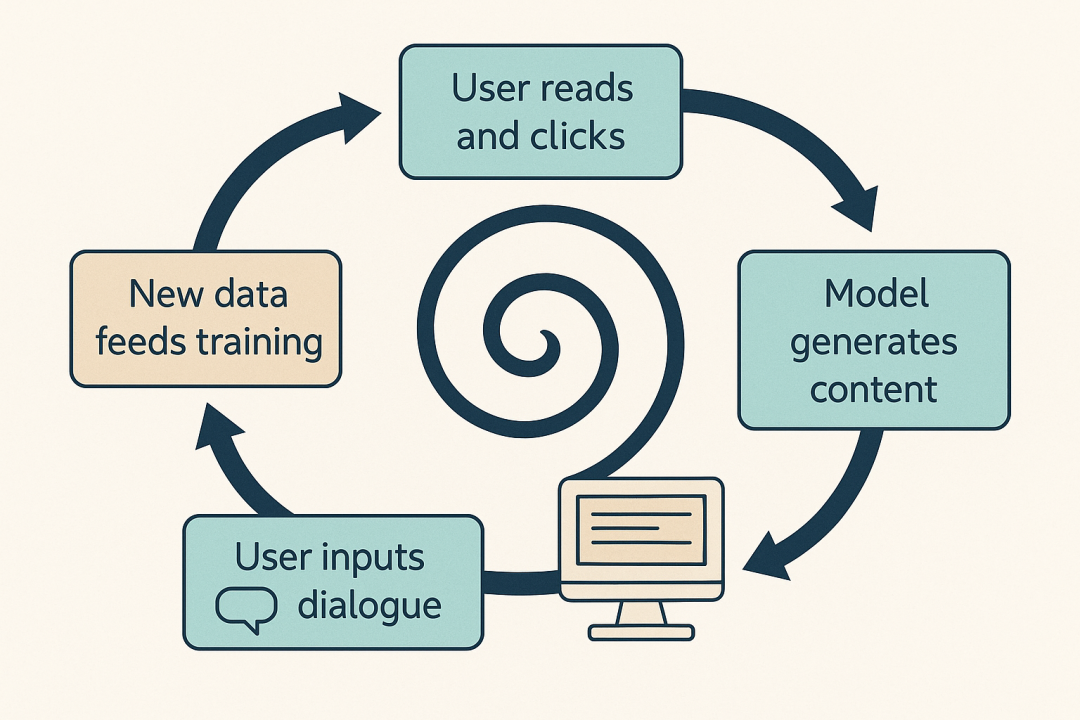

更令人担忧的是,模型生成内容随后又成为新的输入数据——用户点击、修改、反馈行为将再次回流至模型中,优化下一轮输出。这形成了一种“自吃尾巴”的反馈回路:用户塑造模型,模型再反过来塑造用户。Zuboff在原书中所言的“仪器主义权力”(Instrumentarian Power)——通过计算技术大规模、系统性地调整人类行为——正在进入闭环化运行阶段,而我们甚至来不及辨认每一次被干预的瞬间。

这股浪潮已从消费延伸至社会各领域:教育、金融、招聘、司法、心理健康无不开始依赖语言模型。这意味着,预测逻辑正试图变成“社会操作系统”,不再仅仅存在于广告系统的后台,而是在重新编排知识、价值与意义的流动方向。Zuboff对“人类未来的主权”忧心忡忡,而生成式AI正以前所未有的速度侵入这些主权的核心空间——我们的时间、注意力、判断力。

全球监管初现端倪,但仍步履蹒跚

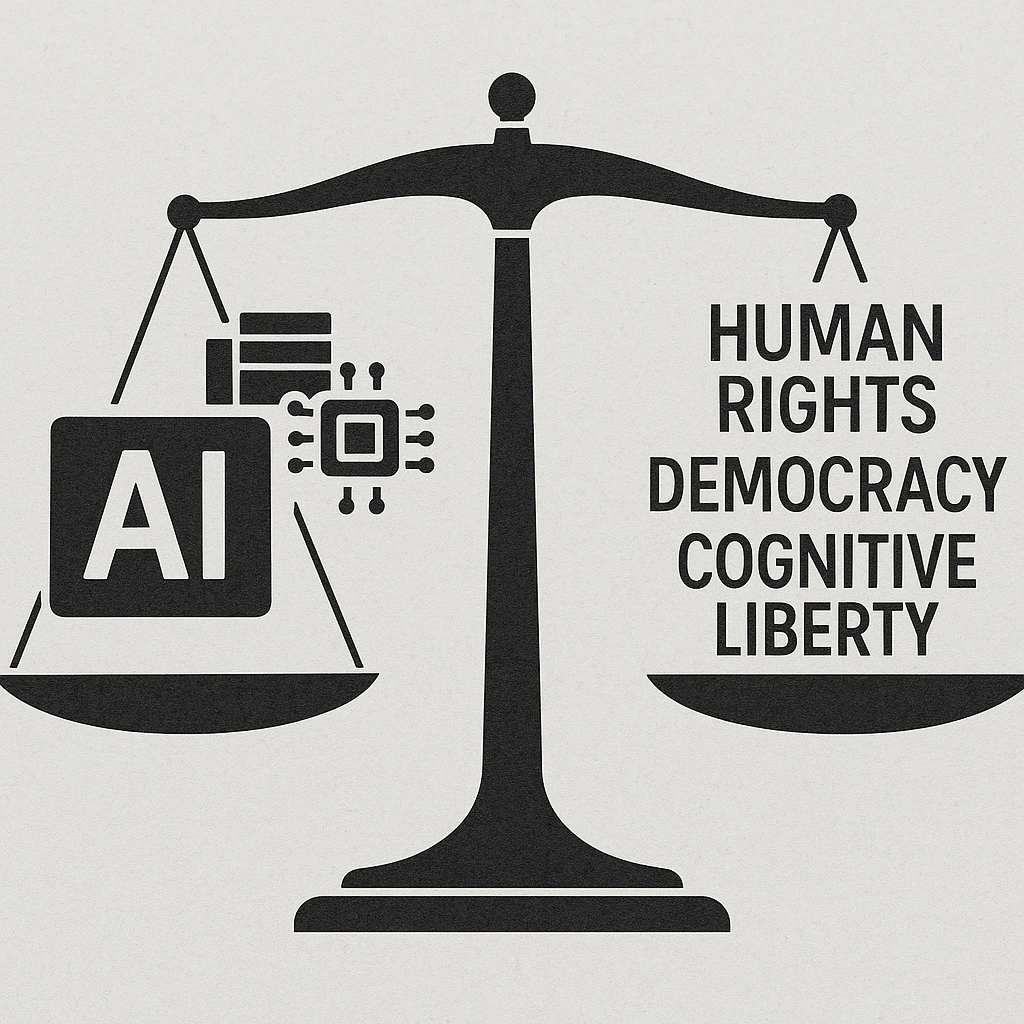

面对这股浪潮,社会的反抗已经开始,却显得零散而步履蹒跚。从意大利对ChatGPT的短暂封禁,到拜登政府略显仓促的行政命令,再到欧盟耗时良久才落地的《AI法案》,监管的脚步始终在追赶技术的狂飙。而在法律前线,《纽约时报》对OpenAI发起的版权诉讼,更像是一场关于知识主权的悲壮守卫战。这些努力固然重要,却尚未能撼动科技巨头们在算力、数据和算法上形成的绝对垄断。

从Big Other到Big Author:Zuboff理论的进化点

但这些尝试尚远不能抵御大模型的规模垄断趋势。从算力到数据,从算法到市场,几乎所有关键资源都集中在少数科技巨头手中。而模型本身的闭源性,使得公众难以了解它们如何被训练、嵌入何种偏见、驱动哪些商业动机。在这一点上,生成式AI并非消解了Zuboff的命题,反而强化了它。唯一的变化是:这个“政变”从暴力收编用户数据,升级为柔性统治用户认知。

如果说,Zuboff所担心的是数字系统的感知霸权,那么我们今天面对的,则是叙事霸权、语言霸权、判断霸权。模型不再只是知道你在做什么,而是告诉你该做什么,甚至代你做出决策。从Big Other到Big Author,从“看你”到“写你”,监控资本主义正在进入一个文本性重构与行为剧本化的新阶段。

重塑平衡:如何避免一场柔性的认知政变?

要想防止这种新型权力结构成为人类自由的终结者,技术、制度与文化三方面的努力缺一不可。技术上,应推动“小而专”本地模型、联邦学习与可解释性标准,让用户在使用AI时仍拥有理解与审计的权利;制度上,应建立跨国透明登记系统与训练数据授权机制,为内容创作者设定合理回报机制;文化上,则需将AI素养纳入基础教育与终身学习体系,培养公众对“算法化社会”的基本免疫力。

Zuboff写道:“如果数字未来是我们的家园,那必须是我们亲手建设的。” 现在,这句话比以往任何时候都更具现实紧迫性。我们要做的,不是否定AI的潜力,而是在它彻底吞噬我们之前,重新谈论技术的边界、社会的方向与人的主体性。因为,如果我们不主张“我是谁”,语言模型终将为我们写下“你是谁”的答案。

声明:本文来自数据经济评论,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。