文献信息

The Ethical Costs of Artificial Intelligence: Investigating How and When Workplace Artificial Intelligence Usage Promotes Employee Unethical Outcomes

人工智能的伦理风险:人工智能使用与职场道德失范

作者:Puchu Zhao、Guohua He、Jian Guan

来源:Journal of Business Ethics,2025年6月30日

摘要

员工在职场中使用人工智能(AI)已成为当今广泛存在的现象。现有研究普遍认为,员工使用AI是一种积极行为,能够带来诸多益处,如提升工作绩效与生产效率。然而,本研究对这一普遍共识提出质疑,转而探讨员工使用AI所带来的伦理代价。基于道德相对主义理论,我们提出,员工使用AI会激发其元伦理信念中的道德相对主义倾向,从而不仅可能引发其自身的职场越轨行为,还会导致其对他人不道德行为持宽容态度。此外,我们进一步提出,这些效应在道德认同感较低的员工群体中表现得尤为显著。本研究通过两项实验和一项针对中国与美国员工的三阶段纵向调查获得了实证支持。总体而言,本研究不仅拓展了关于员工使用AI负面影响的认知,也为AI时代的行为伦理与道德心理学研究做出了实质性贡献。

引言

人工智能(AI)的应用正成为当代职场中最显著且最具变革性的现象之一(Anthony等,2023;He等,2025)。据测算,截至2023年,超过56%的美国员工已将AI用于工作任务(Zawrzel,2023),预计该比例将于2028年升至86%(Amazon,2023)。既有研究聚焦于员工AI使用(即运用AI执行工作任务的行为,参见Tang等,2022)的影响,一致证实AI能显著提升员工绩效产出,包括生产力(Noy & Zhang,2023)、创造力(Jia等,2024)及任务绩效(Vaccaro等,2024)。此类发现似乎昭示一种前景:组织可通过员工AI使用建立竞争优势(Kemp,2023;Krakowski等,2023)。

然若缺乏健全伦理基础,竞争优势将不可持续。员工道德失范可引发多种不道德行为,严重损害组织长期成功(Mitchell等,2020)。值得关注的是,尽管AI使用的绩效收益已获公认,但其与员工不道德行为的关联性及作用机制迄今尚未明确。事实上,与对AI绩效影响的乐观预期形成鲜明反差的是,越来越多学者对其伦理影响表示深切忧虑,警示职场AI使用可能削弱员工道德水准(Bonnefon等,2024;Giroux等,2022;Köbis等,2021)。

新兴的AI伦理效应研究进一步佐证此担忧。这些主要源于营销学、部分涉及组织管理学的实证表明:若干AI相关构念——如机器人接触(Yam等,2023)、AI认知(Zhao等,2023)及营销情境中的AI短暂交互(Giroux等,2022;Zhou等,2022)——会诱发个体不道德行为。但此类研究忽视了工作中的AI使用行为,此乃当前最基础且普遍的AI相关现象(Shao等,2024)。区别于被动接触、瞬时认知或短暂交互,工作中的AI使用是主动性更强、持续性更高的行为实践,可深度重塑员工职业生态(Anthony等,2023)。尤为关键的是,该行为要求员工对AI行为及产出进行道德评估,因其需对AI生成的工作结果担责(Parker & Grote,2022)。故AI使用可能较其他AI构念产生更广泛的伦理影响:不仅涉及员工自身不道德行为,还可能重构其道德信念及对他人的道德判断——此多维效应尚未纳入现有研究视野。综上,AI使用的员工伦理影响仍是亟待探索的核心议题。填补此空白兼具理论与现实意义:既可深化"AI如何腐蚀人类道德行为"的认知(Köbis等,2021,p.679),亦能超越绩效维度全面解构AI使用。

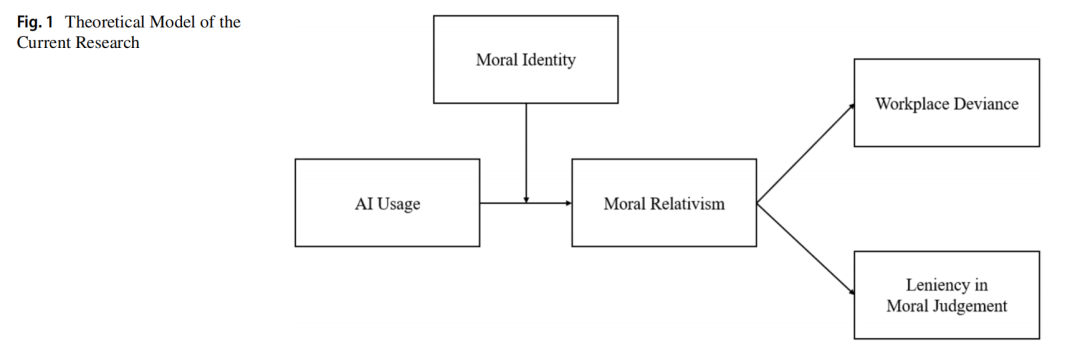

为破解此理论困局,本研究整合道德相对主义理论(Harman,1978;Lu等,2017;Rai & Holyoak,2013)与道德心理学关于人类对AI道德感知的最新成果(综述见Bonnefon等,2024)。具体提出:因个体对AI施予异于人类的道德准则,使用AI的员工将接触更广谱的道德准则体系,致其AI使用助长道德相对主义——即主张道德具相对性与条件性、非普适性的元伦理信念(Forsyth,1980)。此转变进而引发两类不道德行为:当员工作为行动者时的工作场所偏差行为,及作为观察者时对他人道德判断的宽容性。此外,引入员工道德认同为关键调节变量,以界定上述效应的边界条件。论证指出:道德认同可通过道德相对主义路径,弱化AI使用对工作场所偏差行为及道德判断宽容性的间接效应。图1呈现理论模型,两项实验及中美多波次调查提供一致性实证支持。

本研究对AI使用研究、行为伦理学及道德心理学有三大核心贡献:

1.揭示AI使用的伦理暗面:突破既有文献对AI使用绩效收益的单一强调(Bonnefon等,2024;Noy & Zhang,2023),实证其通过诱发员工不道德行为产生伦理代价;

2.阐明伦理影响机制:通过道德相对主义中介路径,解析员工AI使用(此关键未探明变量)对多维度伦理行为的作用,响应"深化AI对人类道德信念及行为塑造机制认知"的学术呼吁(De Cremer & Moore,2020;Köbis等,2021);

3.确立技术伦理新范式:将AI使用界定为形塑工作场所偏差行为与道德判断的技术变量,并以道德认同为边界条件,解答"AI使用对何类群体更具危害性"的时代命题(Tang等,2022)。

假设

假设1:AI使用与道德相对主义呈正相关。

假设2a:道德相对主义中介AI使用与工作场所偏差行为之间的正向关系。

假设2b:道德相对主义中介AI使用与对他人道德判断的宽容性之间的正向关系。

假设3:道德认同调节AI使用与道德相对主义之间的正向关系,具体表现为:当道德认同水平较低时,该正向关系更强且保持正向。

假设4a:道德认同调节AI使用通过道德相对主义对工作场所偏差行为的正向间接效应,具体表现为:当道德认同水平较低时,该间接效应更强且保持正向。

假设4b:道德认同调节AI使用通过道德相对主义对他人道德判断宽容性的正向间接效应,具体表现为:当道德认同水平较低时,该间接效应更强且保持正向。

理论贡献

本研究在人工智能职场应用、行为伦理学和道德心理学领域做出了若干核心贡献。

首先,我们挑战了当前占主导地位的观点——即员工使用人工智能主要带来积极效益,揭示了其中潜在的负面影响。尽管已有研究主要强调员工使用AI对绩效的促进作用(Noy & Zhang, 2023;Vaccaro 等,2024),我们的研究扩展了这一讨论,指出这些绩效收益可能伴随着意料之外的伦理成本。具体而言,我们发现员工使用AI可能会同时引发职场越轨行为,并促使其对他人不当行为做出更宽容的道德判断。这些发现对现有AI使用文献中主要正向的论述构成挑战,将研究重心从绩效收益转向伦理代价。此外,这一发现也与一些新兴文献呼应(如 Shao 等,2024),但我们进一步从伦理角度进行系统探讨,这是此前研究普遍忽视的维度。总体而言,我们的研究对过往仅聚焦绩效效益的研究形成补充,有助于构建对AI职场应用更全面、平衡的认知(Pereira 等,2023)。

第二,我们为AI伦理影响的研究领域提供了多项理论贡献。尽管已有研究关注了AI相关的一些构念,例如对机器人接触(Yam 等,2023)或对AI的认知(Zhao 等,2023),但对“AI使用”这一AI研究中最核心的构念却关注不足。我们的研究填补了这一空白,聚焦于AI使用及其所引发的多层面不道德结果。这一研究回应了关于“在新技术时代理解不道德行为的动因、机制与表现”的研究呼吁(De Cremer & Moore, 2020,第85页)。一方面,我们扩展了伦理结果的范围,表明AI对伦理的影响不仅限于个体本身的不道德行为,也波及其对他人行为的道德判断。这种双重视角有助于更全面理解AI如何侵蚀职场伦理环境(Köbis 等,2021)。另一方面,我们发现AI不仅能影响道德行为,也会改变个体的道德信念——这是AI伦理研究中尚未被充分探讨的一个重要方面。通过揭示AI使用所带来的多维伦理后果,我们为理解职场中AI所带来的伦理挑战提供了更细致、深入的视角。

第三,我们拓展了有关AI影响不道德行为的机制研究。道德心理学的研究者提出了多种机制来解释AI与不道德行为之间的关系,例如匿名性(Köbis 等,2021)、从众效应(Qin 等,2022)、内疚感降低(Giroux 等,2022)以及“状态功利主义”的激活(Zhou 等,2022)。然而,这些机制仅在AI使用过程中起作用,难以解释AI使用后在非AI情境中出现的“溢出效应”(即不道德行为的持续发生)。为弥补这一不足,我们引入“道德相对主义”作为中介机制。道德相对主义具有情境独立性(Forsyth, 1980),因此具有更广泛的解释力。不同于既有机制,道德相对主义不仅解释了AI使用为何会导致用户在AI互动之外也表现出越轨行为,还揭示了其如何影响个体对他人行为的道德判断。这种更广的适用性突显了AI使用在伦理上的深远影响,并确立了道德相对主义作为关键驱动机制的地位。

第四,我们在职场越轨行为与道德判断的前因研究方面也做出了贡献,识别出AI使用作为一个潜在前因。以往相关研究多从以人为中心的视角出发,关注员工自身特征(如人格特质、动机)或重要他人的社会影响(如领导力、同伴影响)(Mitchell 等,2020;Perkins 等,2024)。我们的研究突破了这一范式,表明AI技术本身也可能成为职场越轨与道德判断的重要诱因。这种理论转变为探索AI时代职场越轨行为与宽容道德判断的成因提供了新的研究起点(De Cremer & Moore, 2020)。通过将焦点拓展至AI技术,我们提出了一种全新的视角,有助于理解在AI渗透日益加深的职场环境中员工的行为模式。

第五,我们的研究还为“道德认同”文献提供了新视角,揭示其在AI伦理影响中的边界条件作用。我们发现,道德认同水平较高的员工对AI使用所带来的负面伦理影响更具抵抗力,印证了已有研究关于道德认同在防止不道德行为中重要性的主张,尤其是在AI时代这一作用更加突出(Haker,2022)。通过展示道德认同如何缓解AI所引发的道德观念灵活化与相对化问题,我们进一步深化了对AI伦理影响机制的理解,也有助于推动关于“哪些人更容易受到AI负面影响”的研究讨论(Tang 等,2022)。这一发现拓展了行为伦理理论在AI语境下的应用,强调了在AI主导的工作环境中培养员工道德认同的重要性。

第六,我们的研究还对更广泛的伦理决策理论作出贡献,揭示了新兴AI技术如何与既有伦理框架相互作用。具体而言,我们的发现扩展了Schwartz(2016)提出的整合型伦理决策模型(I-EDM),该模型融合了情境与个体因素,以解释伦理决策的多阶段过程。我们将员工AI使用定位为该模型中的一个新型情境因素,从而更好地理解技术情境如何影响个体伦理判断和行为等多个决策阶段,进而丰富了I-EDM框架。此外,我们关于道德认同调节作用的发现也契合该模型中的“个体道德能力”要素,表明即使在AI使用等不利情境因素存在的情况下,道德认同仍可帮助个体保持伦理标准。

实践意义

我们的研究成果对组织及其利益相关方具有现实意义。首先,尽管管理者普遍将人工智能(AI)视为提升员工绩效的万能工具,但我们的研究揭示了一个关键的“绩效–伦理悖论”:员工使用AI所带来的绩效提升,可能伴随着对其道德信念与行为的多方面侵蚀,从而产生意想不到的伦理成本,损害组织的可持续发展。这一发现强调了管理者应谨慎评估AI的伦理影响,而非片面夸大其前景。我们建议管理者在评估AI时进行全面的成本–效益分析,不仅考虑生产力提升,还要纳入伦理影响评估,并定期监测使用AI的员工的伦理行为变化。此外,管理者还应设立正式的报告渠道,让员工能够在使用AI过程中反映遇到的伦理问题。

此外,我们的研究还为部署AI的组织提供了缓解伦理成本的有效策略。一个关键发现是:员工的道德认同能够缓解AI使用所带来的负面伦理影响。因此,为降低AI的伦理成本,管理者应当在组织内部培养员工的道德认同。例如,在招聘与选拔过程中,可通过性格评估工具筛查应聘者的道德认同水平,剔除道德认同较低的候选人(Moore等,2019)。此外,组织还可以设计强调伦理价值的培训项目,强化员工的道德自我认知,使其将伦理价值内化为职业身份的一部分。

我们的研究对更广泛的利益相关方也具有意义,包括AI技术开发者和政策制定者。对于AI技术开发者,我们建议设计符合人类道德直觉、促进更自然人机互动的AI系统,以减少用户接触多元道德体系所引发的道德相对主义倾向。同时,开发者还应考虑在AI输出中嵌入适当的“道德提示”(moral nudges),如定期的伦理提醒,以激活用户的道德认同,防止其伦理行为的退化。对于政策制定者,我们的研究突显了建立超越传统绩效与安全范畴的综合监管框架的必要性。我们建议制定专门的AI伦理指导原则,涵盖组织AI部署的伦理影响评估义务、要求组织报告AI对职场伦理的影响、设立AI伦理官岗位,并引入激励机制,奖励在AI实施中维持高伦理标准的组织。

结论

尽管既有研究普遍证实AI使用有助于提升员工绩效,但本研究表明此类效益伴随非预期伦理成本。基于中国和美国的三项研究,我们发现:员工AI使用会增强其道德相对主义倾向,进而促发自身工作场所偏差行为及对他人的道德判断宽容性。上述效应在低道德认同员工群体中更为显著。本研究深化了对AI暗面的认知,并为行为伦理学及道德心理学研究提供新见解。

来源:Journal of Business Ethics

时间:2025年6月30日

编辑:常虹(国科大经管学院博士)

声明:本文来自图灵财经,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。