导读

随着人工智能(AI)技术在军事领域的应用日益广泛,从决策支持系统到自主武器系统,其潜在的伦理和法律风险也引发了国际社会的高度关注。其中,“偏见”问题尤为突出。斯德哥尔摩国际和平研究所(SIPRI)近日发布报告:《军事人工智能中的偏见及其与国际人道法的合规性》,系统性地探讨了这一复杂议题。本文将依据该报告,深入解读军事AI偏见的成因、风险及其应对措施。

军事AI领域的“偏见”并非一个中性术语,而是特指一种系统性的、不公平的倾向,即AI系统无意中倾向于或反对某些特定的个体或群体。

偏见的来源

报告将军事AI偏见的来源归结为三个主要阶段,这些偏见环环相扣,最终可能导致灾难性后果:

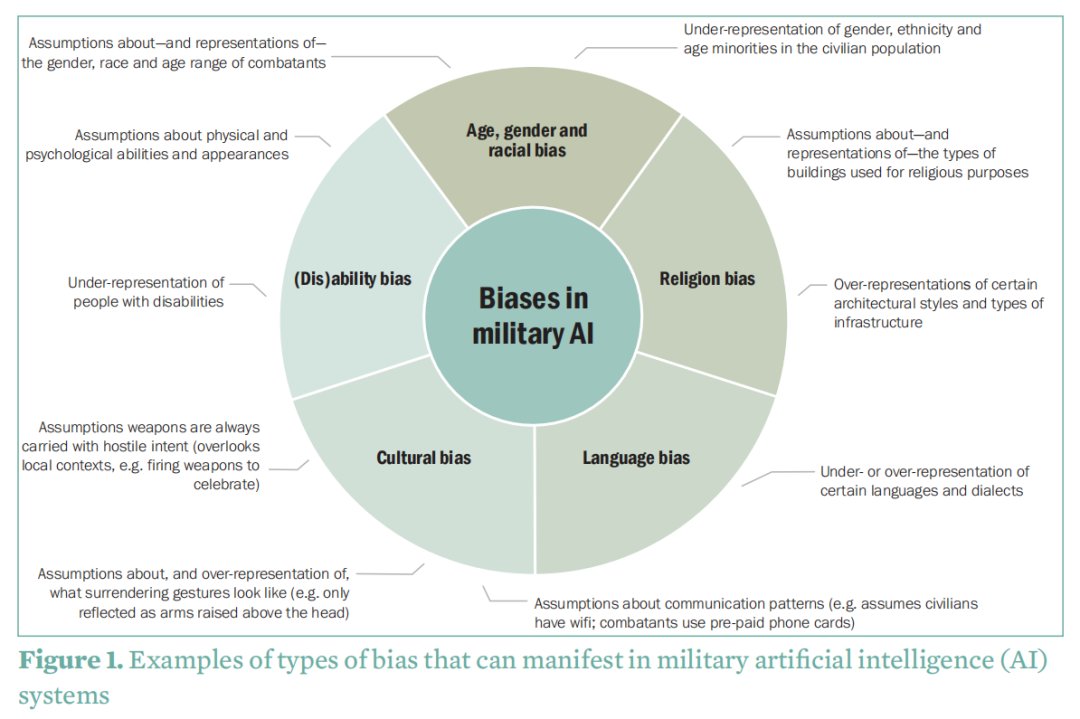

社会偏见:这是最根本的偏见来源。社会结构、制度和文化中固有的不平等(如种族、性别、阶级歧视)会无意识地反映在用于训练AI的数据中。例如,如果训练数据主要来源于西方媒体,那么对“恐怖分子”的图像描绘可能过度集中于特定肤色的人群,导致AI系统将该肤色与威胁错误地关联起来。

数据处理与算法开发偏见:在开发阶段,程序员的选择和假设会引入偏见。例如,在定义用于识别目标的“代理指标”(Proxy Indicators)时,开发者可能会基于自身文化背景做出假设。将“举起双臂”作为唯一的投降姿势代理,就可能忽略其他文化中表示投降的特定手势。

使用过程中的偏见:当AI系统部署到与训练环境不同的新战场时,偏见便会产生。所谓的“数据漂移”(Data Drift)现象,即战场现实(如平民流动模式、残疾人口比例变化)与初始训练数据不再匹配,会导致系统性能下降,产生偏见。

图1:军事人工智能(AI)系统中可能出现的偏见类型示例

偏见如何导致伤害?两大核心风险路径

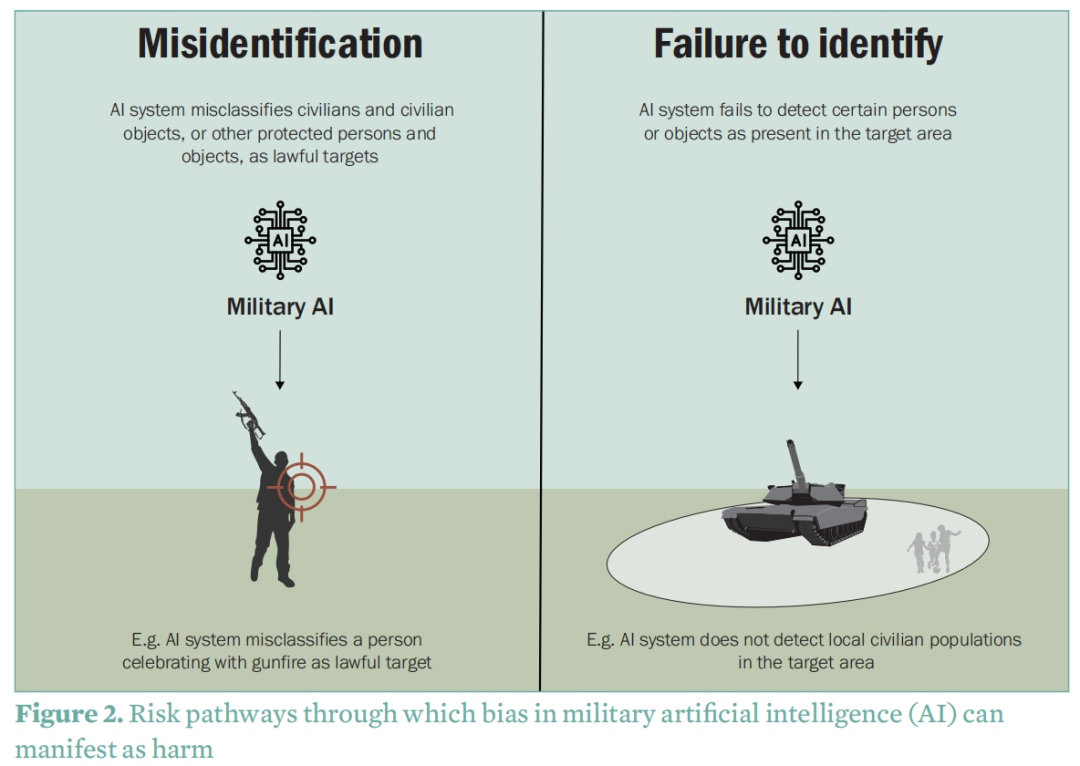

报告明确指出,军事AI中的偏见主要通过两种方式转化为实际的、毁灭性的伤害,尤其是在目标识别和打击的场景中。

错误识别 (Misidentification):这是指AI系统由于偏见,将受国际人道法保护的平民、民用物体或其他受保护人员(如投降的士兵)错误地归类为合法打击目标。例如,一个AI系统可能因为其训练数据中将“携带武器的年轻男性群体”与敌方战斗人员行为模式强相关联,而将正在进行狩猎或持枪庆祝节日的平民错误地识别为威胁并发动攻击。

未能识别 (Failure to Identify):这是指AI系统由于偏见,未能探测到目标区域内存在的受保护人员或物体。例如,如果一个用于评估附带损害的AI决策支持系统,其训练数据中缺乏残疾人士(如使用轮椅者)的图像,它在进行平民密度评估时就可能完全忽略这些群体的存在。同样,如果系统以手机信号活动作为平民存在的代理指标,它将无法识别那些生活在网络覆盖差或贫困地区、无法使用手机的平民群体。

图2:军事人工智能(AI)偏见可能导致伤害的风险路径

缓解偏见风险的措施

报告强调,完全消除AI偏见是不可能的,但可以通过在开发和使用各阶段设置限制和要求来“处理”和“缓解”其后果。报告提出了以下关键措施:

代表性与特定情境的数据:确保训练数据集充分反映预定作战环境的多样性,包括当地的宗教、文化、族裔和家庭结构。这要求在开发阶段就进行前瞻性规划,并可能需要在武器审查环节系统性地检测偏见。

数据透明度:使用者必须能够了解AI系统所依赖的训练数据、标签方法和测试性能。这种透明度是评估系统是否存在偏见、理解其决策逻辑以及在事故后追责的基础。

攻击过程中的人类控制与判断:对于自主武器系统(AWS),应通过设定严格的操作限制来施加人类控制,例如,将其使用范围限制在非人口密集区,或仅用于攻击“依其性质”而定的军事目标(如坦克),而非依赖对人类行为进行复杂判断的目标。对于决策支持系统(DSS),则必须确保用户有足够的时间和资源来审查、质疑和交叉验证AI的建议,防止“橡皮图章式”的决策。

制度性措施:军事组织内部需要建立相应的制度保障。这包括对各级人员进行关于AI偏见的专项培训,提高其识别风险的能力;同时,确保开发、测试和采购团队的成员具有多元化的背景(性别、族裔、文化等),以从源头上减少无意识偏见的引入。

声明:本文来自稻香湖下午茶,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。