上个月,OpenAI 发布其最新语言模型——GPT-2,但因为担心它可能被用来制造大量伪造和虚假的信息,颇为戏剧性地决定不开源该模型。

这一决定也使得 AI 社区开始讨论:如何检测这类虚假新闻。

在一项新实验中,来自麻省理工学院-IBM Watson 人工智能实验室和哈佛大学自然语言处理实验室的研究人员思考,能够生成如此逼真的文本的语言模型,是否可以用来检测其他语言模型生成的文本的真假。

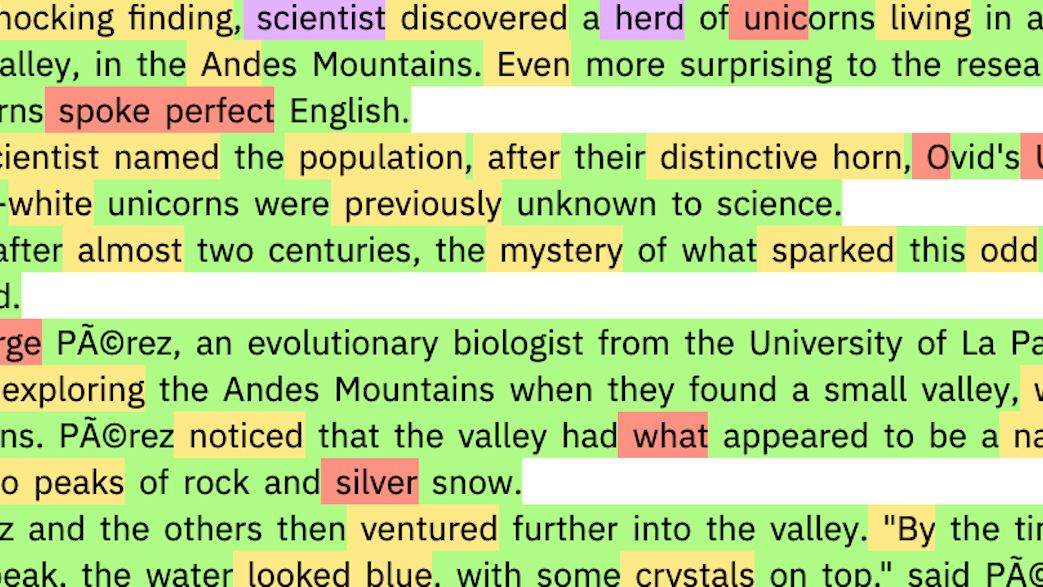

图 丨 OpenAI GPT-2 生成的假新闻。(来源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

这个假设背后的想法很简单:语言模型通过不断预测单词序列中的下一个概率最大的单词来产生句子。因此,如果某个语言模型能够轻松地预测某一段落中的大部分词语,那这段文本很可能就是这个语言模型生成的。

研究人员通过构建基于 OpenAI GPT-2 开源的小模型的交互式工具来测试他们的想法。当为该工具提供一段文字时,它会让每个单词高亮不同的颜色,从绿色到黄色到红色,表示预测几率逐渐下降;如果语言模型根本没有预测出某一单词,它会用紫色高亮该单词。所以从理论上讲,红色和紫色词的越多,该文本由人类书写的概率就越大;如果绿色和黄色词的份额越大,该文本由语言模型生成的概率就越大。

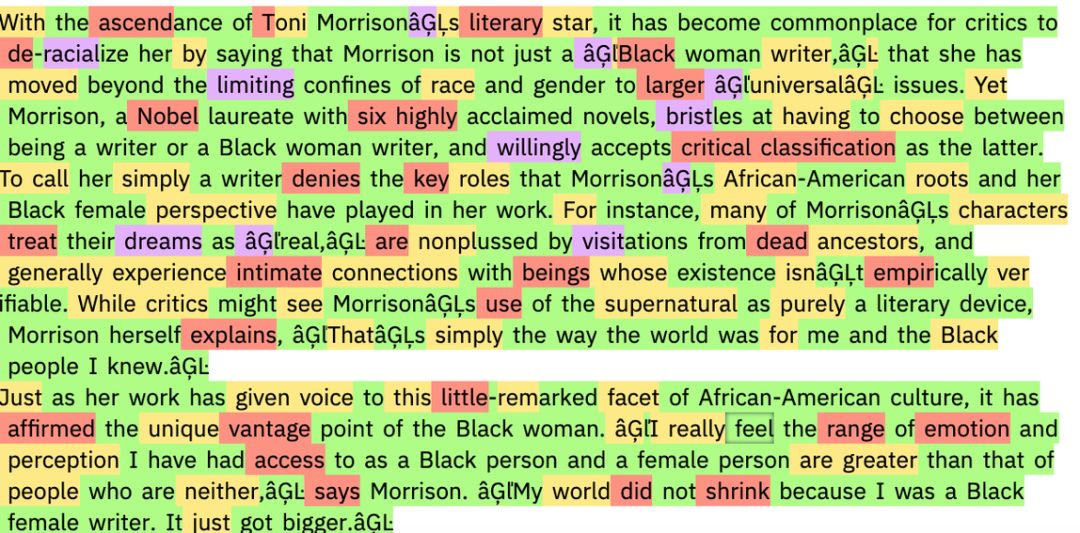

图 丨 OpenAI GPT-2 小模型生成的文本。(来源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

事实上,研究人员发现,GPT-2 的小模型和完整版本的模型所写的段落几乎完全是绿色和黄色,而人类写的科学文摘和美国入学标准化测试中阅读理解段落中的文字有很多红色和紫色。

图 丨 美国入学标准化测试中的阅读理解短文,由人类书写。(来源:HENDRIK STROBELT AND SEBASTIAN GEHRMANN)

但事情没有想象中的简单。Janelle Shane 是一位负责运营“Letting Neural Networks Be Weird“博客的研究员,她并未参与前文所述的研究。她将该工具用于更严格的测试,不仅仅提供 GPT-2 生成的文本,还提供了由其他语言模型生成的文本,包括一个用亚马逊评论训练的模型和一个用《龙与地下城》语料训练的模型。

她发现,这个工具无法预测每个段落中的大部分单词,因此该工具认为这些文本是人类写的。这说明一个重要观点:语言模型可能擅长检测自己的输出,但不一定擅长检测其他语言模型的输出。

看来,人类打击互联网假新闻还是任重道远啊。

编辑:李根

原文链接:

https://www.technologyreview.com/s/613111/an-ai-for-generating-fake-news-could-also-help-detect-it/

声明:本文来自DeepTech深科技,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。