《美好AI社会的伦理框架》报告了“AI4People(AI4P)倡议”的研究成果。AI4People倡议由原子塔——欧洲科学、媒体和民主研究所(Atomium—EISMD)倡导,希望为构筑“美好AI社会”奠定基础。报告介绍了人工智能可为社会带来的主要机遇和风险,指出应该加强发展和采用的五项伦理原则,最后提出了20项具体建议可用来评估、发展、激励和支持友好的人工智能技术,涵盖国家或国际层面,可由政策制定者直接实施,在其他情况下也可由利益相关者来组织,为建立美好人工智能社会的提供坚实基础。

一、人工智能给社会带来的的机遇与风险

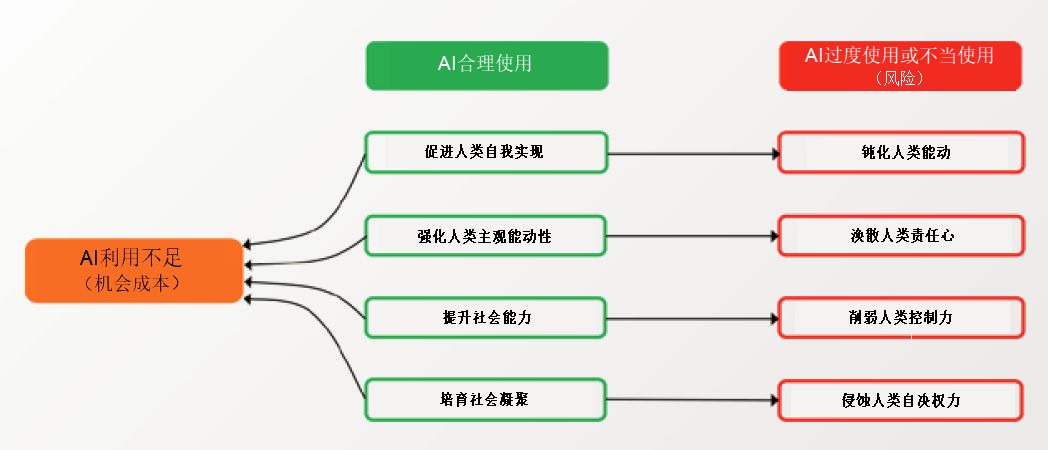

设立美好社会人工智能的伦理框架,首先要对此类技术设计和技术使用带来的机遇和风险进行评估,报告选定了四个方面:1)我们要走向哪里(能成为谁):促进人类自我实现而不钝化人类能动性;2)我们能做什么:强化人类主观能动性而不涣散人类的责任心;3)我们能到哪里(达成何等目标):提升社会能力而不削弱人类控制力;4)我们如何在彼此之间及这个世界进行互动:培育社会凝聚力而不侵蚀人类的自决权力。如果人工智能技术的设计和使用得当,将对社会产生积极影响,这四大机遇的背面是四大风险,风险通常由过度使用或误用而产生。此外,人工智能的首要风险在于未被充分利用,相对于潜在的积极影响,将产生机会成本。人工智能伦理框架的设计必须最大可能地趋利避害。

图:AI的四大核心机遇、相应的风险以及未充分利用造成的机会成本

二、人工智能的统一原则框架

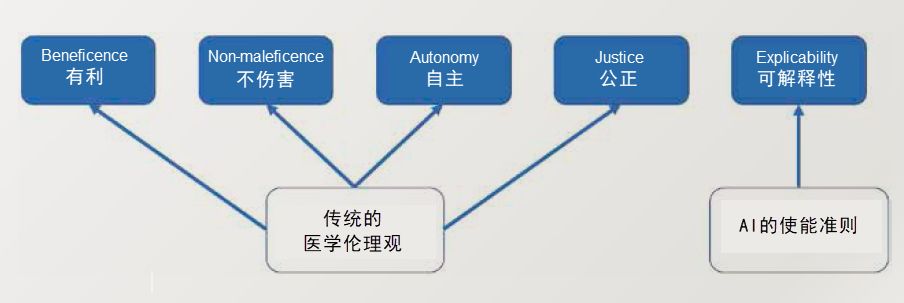

已有多个团体发布过伦理原则声明,这些声明应指导人工智能的发展和采用。本报告不再赘述各自的进展,仅比较分析部分原则。每个文件中的原则都可归结为五大原则,其中四个:有利、不伤害、自主和公正等均是医学伦理的既定原则,但第五个原则即“可解释性”较为独特地体现了人工智能带来的新的伦理挑战。

人工智能的伦理框架:四项传统原则和一项新原则

三、关于美好人工智能社会的20条建议

报告提供20项适用于欧洲的具体建议,若采用可有助于发展和利用人工智能技术,同时最大限度发挥机遇并降低风险,并尊重所确定的核心伦理准则。

1、评估

(1)评估现有制度,如国家民事法庭,以便对AI系统的犯错或损害作出赔偿。

(2)评估不宜采用AI系统的业务和决策范围。

(3)评估当前的法律法规是否充分满足伦理要求,法律框架是否能与技术发展同步。

2、开发

(1)侧重强化AI系统的可解释性,从而为从事社会决策功能的AI系统开发框架。

(2)制定一个合适的法律程序并改进法律系统的信息基础设施,并确保能在法庭对算法决策进行审查。

(3)制定审计机制,对偏见等意外结果进行监测,建立AI技术密集型行业应对严重风险的机制。

(4)制定补救流程或机制,对AI造成的错误或不当后果作出补救或补偿。

(5)设定一致同意的标准,用来评估AI产品及服务的可信性。可成立新组织或由已存在的组织来执行该标准。

(6)欧盟应设立一个新的监督机构,负责对AI产品、软件、系统及服务进行科学的评估和监督,以保障公共福祉。

(7)欧洲可设立一个AI观察中心,负责观察AI发展,提供交流平台。

(8)拟订法律文件或合同模版,为促进工作环境中平滑有益的人机协作奠定基础。

3、激励

(1)在欧盟层面,通过财政实施激励,促进AI的发展及使用,促进社会使用AI的意愿,促进AI环境友好。

(2)通过财政激励,促进可持续、增长型、连贯性的研究活动。

(3)通过财政激励,促进跨学科、跨部门的合作,促进有关技术、社会议题、法律研究、伦理道德的讨论。

(4)通过财政激励,促进在AI研究项目融入伦理、法律和社会的考虑。同时,激励依法进行定期审查,测试AI能在多大程度上促进社会正向创新。

(5)通过财政激励,在欧盟成立AI实验和开发沙盘(合法的免监管特殊区域)。

(6)通过财政激励,研究如何增进公众对AI的认知和认同,采取结构化的公共咨询机制,设计AI相关的政策和规则。

4、支持

(1)支持制定自我规制性质的行为准则。

(2)支持企业董事会建立承担在企业中应用AI技术的伦理责任的能力。

(3)支持围绕人工智能技术对社会、法制及伦理等冲击而创建教学课程并促进公众意识。

https://www.eismd.eu/wp-content/uploads/2019/03/AI4People%E2%80%99s-Ethical-Framework-for-a-Good-AI-Society.pdf

声明:本文来自赛博安全,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。