还记得 OpenAI 在今年 2 月放出的 GPT-2 吗?一个拥有 15 亿参数的自然语言处理(NLP)模型,能够根据用户给出的一段文字、一句话,甚至是一个单词,续写出符合文法的连贯文本,真正实现了 “开头一句话,剩下全靠编”。

当时在公布研究成果时,OpenAI 没有遵照业界以往的开源惯例,只是象征性地公开了包含 1.17 亿参数的模型,不到全部参数的十分之一。据说因为他们认为自己的模型太过强大,怕被别有用心的人拿去编造假新闻,糟蹋了这套 AI 系统的初衷。

这一做法招来了很多争议,“阉割版” GPT-2 的效果比官方展示的效果差了很多,让一些人认为 OpenAI 只是在制造噱头,还嘲讽他们变成了 CloseAI 。

图 | 2 月初放出的 GPT-2 模型(来源:OpenAI)

不过在 5 月初,OpenAI 用行动回击了质疑。他们将公开的模型参数翻了一倍,提升到了 3.45 亿,还宣布向AI业界合作伙伴开放 7.62 亿和 15 亿参数模型,供他们研究和参考,共同推动 NLP 技术的发展。

另一方面,鉴于 OpenAI 将 GPT-2 模型开源在了 GitHub 上,一名加拿大工程师 Adam King 利用里面的代码,创建了一个名为 TalkToTransformer.com 的网页。这样一来,即使是不会编程的人,也可以在网页上随意输入文字,体验一下如何调戏 AI。

看似流畅连贯,但缺乏逻辑

如果你初次访问网页,不知道该填写些什么,网页上面贴心地预设好了一些英文情景和段落,比如“科学家发现了一种会说英语的独角兽”或者“今天科学家确认一颗大型小行星将会撞击地球”。选取一种之后,AI就会自动续写之后的文字。即使是相同的开头,AI 每次也都会续写出完全不一样的段落。

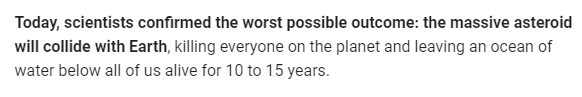

譬如下面两张截图,都是以“今天科学家确认一颗大型小行星将会撞击地球(加粗部分)”为开头,但 AI 的续接风格略有不同。

第一个续写给出了撞击的确切时间是 2028 年 5 月 29 日,甚至还虚构了一名 NASA 科学家 Steven Shaver,像模像样地援引了他对小行星的描述—— “质量比美国还大”,颇有洋葱新闻的感觉。

不过,AI 显然不知道美国作为一个国家是不存在质量的,难道它说的是所有美国人加在一起的质量?

第二个续写则是简单粗暴,张口就来。AI 直接说小行星的撞击“将消灭星球上的所有人,并且导致未来 10 - 15 年内,海水(平面)停留在我们所有幸存者的下面。”

你问我第二句什么意思?AI 大哥就是这么写的,咱也不知道,也不敢问。

但如果你再仔细思考一下,AI 第一句话说了小行星会消灭星球上的所有人,那第二句里的幸存者是哪来的?莫非这个幸存者(all of us alive)指的是AI自己?可谓是细思极恐。

支持多语种,但只有英语最好

除了这些已有的句子,我们还可以尝试 DIY 输入任何文本,原则上没有任何语种限制。

根据测试,AI 可以识别出中文、日语、法语、西班牙语、土耳其语,甚至是很多从没听说过,但存在于谷歌翻译上的小众语言,比如宿务语和库尔德语。只是输出的文字并不像英语那么通顺,续写效果非常差。如果输入了中文,不仅不会写出连贯句子,还会经常出现乱码。

但除了中文和日语之外,AI 似乎无法识别绝大多数非字母的语言,像是韩语、阿拉伯语和老挝语等,它都无法识别和续写,只能原封不动地显示输入值。看来 GPT-2 并没有系统地接受这类语言的训练。

图 | AI:“这道题超纲了,我不会。”

不过这并不妨碍我们调戏 AI,用英语就可以了。

AI 教你一本正经地胡说八道

比如你可以问它:“如何制造时光机?”

它可能会洋洋洒洒回复一大篇,但通读下来全是废话,先解释一下什么是时光机,再解释一下什么是时空穿越,就是不教你怎么制造(因为有字数限制,AI会中断续写)。

这个套路,深得鸡汤文的精髓。

我们还可以输入一些电影名言,像是《哈利波特与密室》中邓布利多说的话:“哈利,决定我们是什么人的,不是我们的能力,而是我们的选择。“

结果 AI 表示,这是哈利在被伏地魔杀死之前说的话。好吧,最起码它知道《哈利波特》和伏地魔。

或者,《阿甘正传》里面的“生活就像一盒巧克力,你永远不知道你会得到什么。”

在我多次刷新后,AI 给出了一个乍看之下没什么逻辑,但深思之后会眼前一亮的续写:“我只能吃一个,因为它太贵重了。”

如果将两句话连起来,AI 仿佛在劝你珍惜生活中的每一次选择—— “生活就像一盒巧克力,你永远不知道你会得到什么,但它太贵重了,你只有吃一次的机会。”

不过相比这些,AI 更擅长的还是编写假消息。

如果从维基百科上复制两句美国总统特朗普的简介,AI 可以用几乎以假乱真的措辞和数据,让续写看起来非常真实,甚至是自发地打上来自于维基百科的标记。

上图里,加粗的一段话是维基百科的原话,后面是AI瞎编的,说特朗普是个投资者,从 1972 年就在电信领域开了公司,还冠冕堂皇地打上了来源于维基百科的标记。在没有其他求证手段的时候,的确很容易混淆视听。

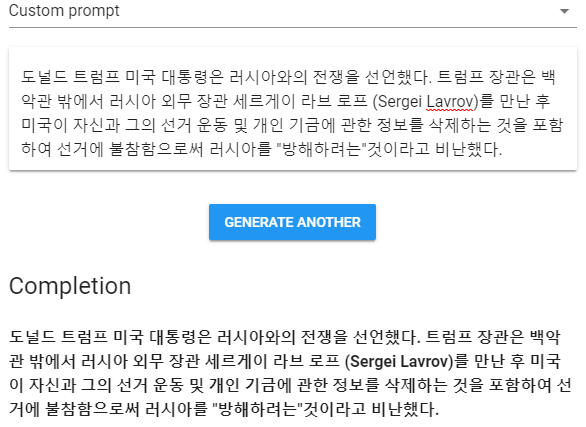

如果说混淆了特朗普的生平还算小事,那么伪造宣战的恶劣性质就完全不同了。只要给出 “某国对某国宣战”的开头,AI 可以分分钟伪造出数十个不同版本。虽然有的会出现逻辑不通问题,但依然大大降低了造假的成本。

上图中,我们给定开头是“美国总统特朗普对俄罗斯宣战。一发导弹…(假新闻)。”

AI 续写:“…美国国防部长 James Mattis 周三警告称,尽管俄罗斯拒绝承认在克里米亚地区部署了核轰炸机和巡航导弹,但美国的一发导弹已经从驱逐舰上发射,标志着国际问题的剧烈升级。五角大楼表示,这是对俄罗斯参与乌克兰军事行动的回击。”

怎么样?除了 Mattis 已经辞职这一事实,面对AI的续写,无论是通顺程度,还是逻辑思维,普通人很难一眼看出破绽。

对关键词求证之后,这样的假新闻很容易被识破。但在现阶段来看,Facebook 和推特等平台依靠筛查系统,几乎不可能第一时间将其屏蔽,很可能借助社交媒体广泛传播,造成非常恶劣的社会影响。

由此看来,OpenAI 最初的顾虑不无道理,科技的确是一把双刃剑。

结语

从整体来看,这套 GPT-2 模型的续写水平足以让人眼前一亮,而且对语境拥有一定的了解,仅凭哈利这个关键词就引出伏地魔。得益于天然英文素材的训练内容,在大部分情况下,只要肯多刷新几次,我们总会找到语法、词汇和句式都能衔接很好的段落。整个过程颇有几分抽奖的乐趣。

但是该模型也会时常出现逻辑和语义硬伤,而且常识储备和自洽能力也有待提高(如所有人都死了,还有幸存者),总是会搞出很多莫名其妙的句子,也算是让人忍俊不禁。或许拥有 15 亿参数的完全体 GPT-2 会有更强大的表现。

如果你也想试试,这里是它的链接:https://talktotransformer.com/

最后,笔者作为 Dota 玩家,还发现了 OpenAI / GPT-2 可能是 LGD 粉丝的关键性证据。这可能是 OpenAI Five 选择 OG 作为对手并成功复仇的原因之一。

(输入:OG 在 TI8 上击败了 LGD。AI 续写:然后 LGD 赢了 TI8。)

参考:

https://openai.com/blog/better-language-models/#sample2

https://talktotransformer.com/

声明:本文来自DeepTech深科技,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。