机器学习算法已经成为网络安全技术的一个关键部分,目前用于识别恶意软件,减少警报数量,帮助漏洞修补的优先级。然而,研究机器学习或人工智能安全的专家却警告,这些AI算法可能会被攻击者颠覆。

在去年发表的一篇研究论文(邪恶模型:在神经网络模型中隐藏恶意软件)中,研究人员发现,神经网络的冗余特性可以让攻击者将数据隐藏在一个普通的神经网络文件中,占用文件大小的20%,而不会显著影响模型的性能。在2019年发表的另一篇论文研究表明,受到入侵的训练服务可以在神经网络中创建一个后门,并持续存在,即使该神经网络被用于另一项任务的训练。

Berryville机器学习研究所联合创始人兼首席执行官Gary McGraw认为,虽然这两篇研究论文显示了可能的威胁,最直接的风险就是窃取或修改数据。因为当人们把机密信息给到机器,以进行机器学习时,敏感数据通常可以从ML系统中恢复,这种系统往往以不安全的方式运行。当机器学习系统的查询被暴露时,返回的结果通常就会暴露。这就是机器学习一个非常重要但却被忽视了的问题,“数据非常重要”。但在网络安全行业,人工智能和机器学习已成为营销必备的功能,开发人员专注于利用人工智能技术创造新的用途,而忽视了人工智能本身的安全性。

McGraw认为,最大的风险在于数据。

对抗性机器学习

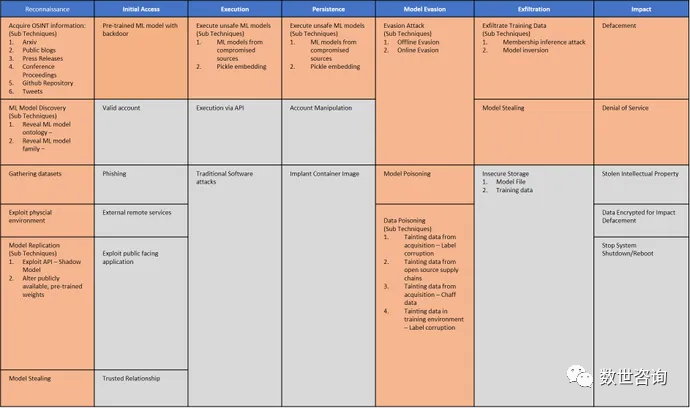

2020年,微软、MITRE和其他主流科技公司发布了一份名为“对抗性机器学习威胁矩阵”的潜在攻击目录,该目录最近更名为“人工智能系统的对抗性威胁环境”(ATLAS)。这个矩阵警告,企业要评估依赖AI或ML技术系统的潜在风险。比如在ML文件中隐藏数据,与普通风险几乎没有区别,本质上是重新创建了一种特殊形式的隐写术。但我们必须注重ML系统的安全性测试,否则一旦被攻击者所利用……

图:对抗性机器学习威胁矩阵

Sophos的首席科学家Joshua Saxe认为,部分原因是安全人员大多关注的是眼前的攻击,而不是难以实施的、未来的复杂攻击。毕竟这类攻击,基本上是人们想象出来的,他们认为攻击者将来会采取的方法。然而,随着越来越多的安全专业人员依赖机器学习来完成工作,对威胁环境的认识将变得愈加重要。

研究人员建立的对抗性攻击,包括C2恶意流量、域名生成算法(DGA)和二进制恶意软件的检测逃逸等。现实生活中的攻击案例,如2016年,微软发布的聊天机器人Tay开始和人类聊天后,不到24小时就被教坏,成为一个集反犹太人、性别歧视、种族歧视于一身的“不良少女”。还有一次,VirusTotal被数据投毒,以逃避检测。

Saxe认为,合成媒体(典型的如Deepfake)将是攻击者在未来几年中大量使用人工智能的领域。比如文本生成神经网络GPT-3,可以用来生成网络钓鱼的文本,就像是人类发送的一样。基于人工智能的人脸生成算法可以创建合成真实的人物相貌图片。

“使用这项技术真的很容易。”

——Sophos首席科学家Joshua Saxe

虽然研究人员已经展示了多种可能的ML攻击,但大多数攻击手段的使用还需要数年之久,因为攻击者的工具箱中仍然充斥着大量更为简单易用的自动化工具,迄今为止这些工具仍然是成功的。必须阻止ML攻击的两个领域是机器人和自动驾驶汽车,否则这两个领域根本无法普及。因为,机器人和自动驾驶不仅依赖算法运行,还需要将人工智能的决策转化为实际行动。一旦入侵了这些算法,并影响行动决策,后果不堪设想。

两篇论文地址:

https://arxiv.org/pdf/2107.08590.pdf

https://arxiv.org/pdf/1708.06733.pdf

声明:本文来自数世咨询,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。