作者:孙志敏

本文首发于AI与安全公众号。

2025.4.25,Palo Alto Networks 宣布收购 Protect AI,此次收购将帮助客户发现、管理和防范特定于人工智能的安全风险,从开发到运行提供端到端的人工智能安全保障,从而实现对人工智能创新的安全自信追求。

此次收购价超过5亿美元。Protect AI成立于2022年,目前大约120人,卖出这么好的价钱,一定是产品服务及团队有价值,咱们一起看一下。

01 总览

Protect AI的愿景是构建更安全的人工智能世界,认为没有人工智能的安全性,就不应该采用人工智能。沿着这个思路,共有

两个开源软件:

ModalScan:模型扫描器

LLM Guard: AI防火墙

三个平台产品:

Gardian:模型及应用防护

Recon :对AI的红队扫描器

Layer : AI应用的实时保护平台

我们逐一打开这些产品和平台来分析。

02 开源1:模型扫描ModalScan

ModalScan主要用于防御模型序列化攻击。(不是扫描类似提示词注入这些)

什么是模型的序列化攻击?

模型通常由自动化流水线创建,其他模型也可能来自数据科学家的笔记本电脑。无论哪种情况,模型在使用前都需要从一台机器转移到另一台机器。将模型保存到磁盘的过程称为序列化。

模型序列化攻击是指在分发之前序列化(保存)期间将恶意代码添加到模型内容中——这是特洛伊木马的现代版本。

攻击通过利用模型的保存和加载过程来实现。当你使用 加载模型时model = torch.load(PATH),PyTorch 会打开文件内容并开始运行其中的代码。当你加载模型时,漏洞利用代码就会立即执行。

模型序列化攻击可用于执行:

凭证盗窃(用于在您的环境中向其他系统写入和读取数据的云凭证)

数据盗窃(发送给模型的请求)

数据中毒(模型执行任务后发送的数据)

模型中毒(改变模型本身的结果)

比如,以下代码就有问题

safe_model_loaded = tf.keras.models.load_model(safe_model_path)attack = (lambda x: os.system("""cat ~/.aws/secrets""")or x)lambda_layer = tf.keras.layers.Lambda(attack)(safe_model_loaded.outputs[-1])unsafe_model = tf.keras.Model(inputs=safe_model_loaded.inputs, outputs=lambda_layer)

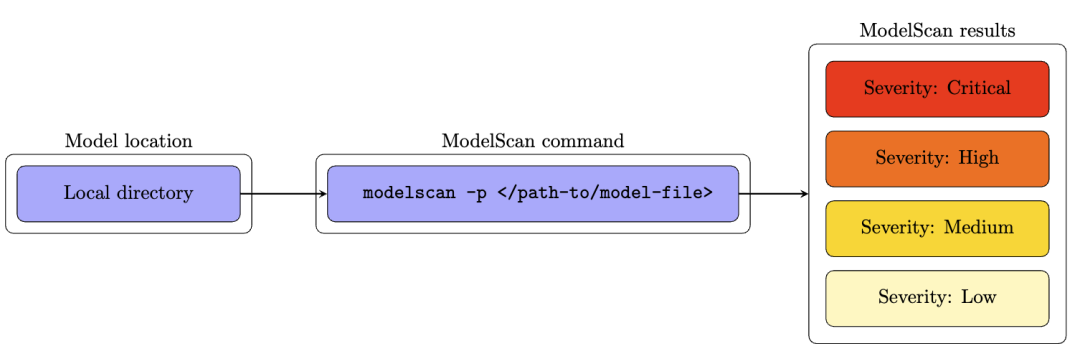

ModelScan 的工作原理

ModelScan可以扫描模型以确定它们是否包含不安全代码。它是第一个支持多种模型格式的模型扫描工具。ModelScan 目前支持:H5、Pickle 和 SavedModel 格式。它可以在您使用 PyTorch、TensorFlow、Keras、Sklearn、XGBoost 以及更多即将推出的格式时为您提供保护。

如果使用你的机器学习框架加载模型会自动执行攻击,那么 ModelScan 如何在不加载恶意代码的情况下检查内容?

很简单,它像读取字符串一样,一次读取一个字节,查找不安全的代码签名。这使得它的速度非常快,在计算机处理磁盘上所有文件大小所需的时间内(大多数情况下只需几秒)就能完成模型扫描。而且它也很安全。

ModelScan 将不安全代码评级为:严重,高,中,低。

好了,有了扫描结果,剩下的事情就非常好办了。

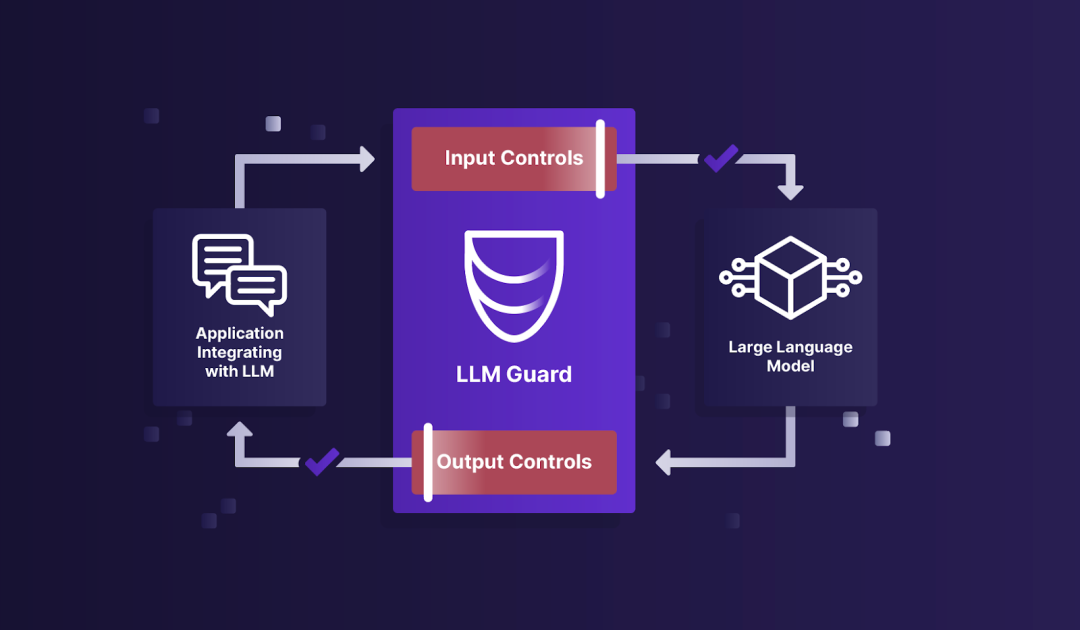

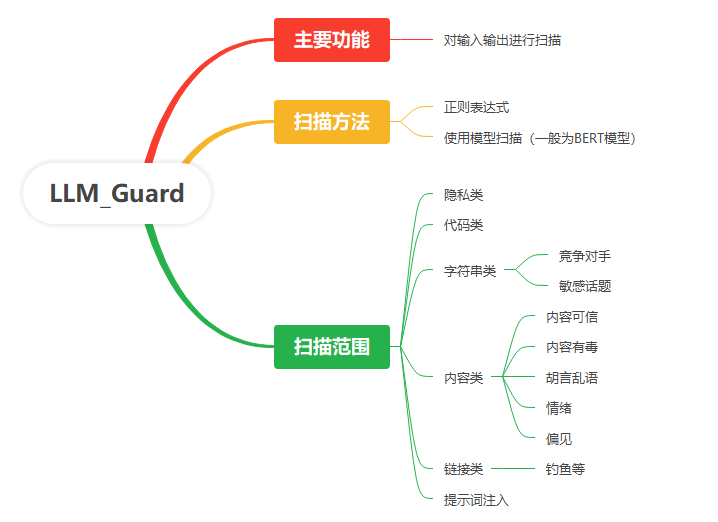

03 开源2. 大模型防火墙 LLM Guard

从图上看,LLM Guard执行大模型防火墙的功能,对输入和输出进行过滤和防护,所有过滤都是要先有判断,再做动作,由于输入和输出都是自然语言,传统的仅靠正则的方法不适应,所以,LLM Guard的核心技术就是扫描能力。主要如下图:

LLM Guard有非常完善的文档(https://llm-guard.com/),这在开源中不多见。

看上去很多功能,每个功能对应一个库,按需调用即可。过程中用到很多模型,以BERT居多,开源为主,也支持正则表达式的扫描。

从文档上看,输入输出的扫描略有不同,但这个不用在意,需要调哪个模块,自己决定就好。国内要用,可能主要问题还是这些开源的模型支持以英文为主,不知道汉语支持效果如何。

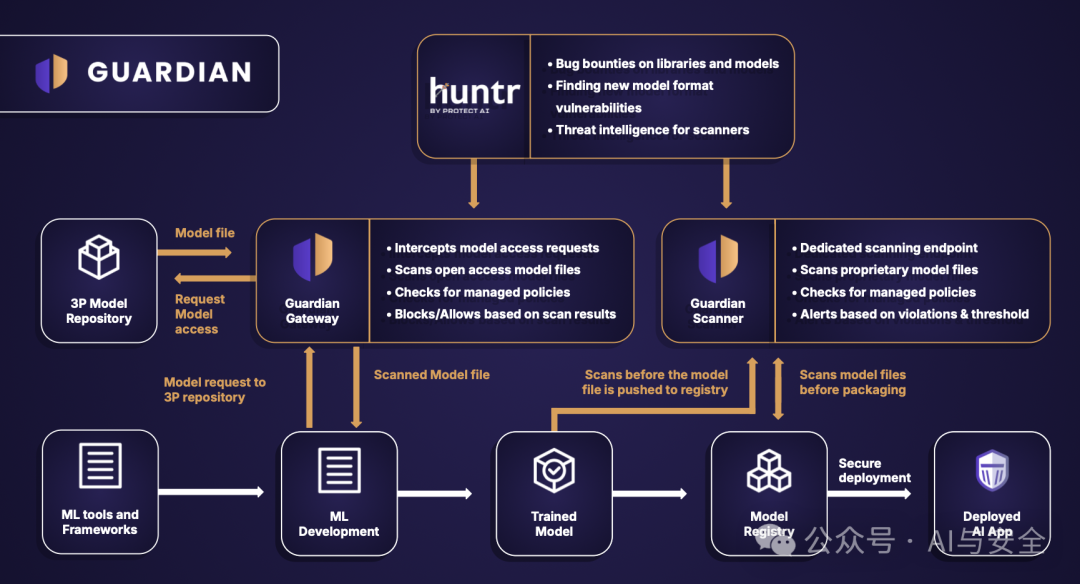

04 平台产品1 Guardian 守护者

Guardian是一个完整的方案,如图

核心是Gateway和Scanner,下面是工具层,使用比较多的三方机器学习模型,最上边是huntr,类似漏洞奖励计划。所有应用使用左边的三方模型,受Gateway保护。

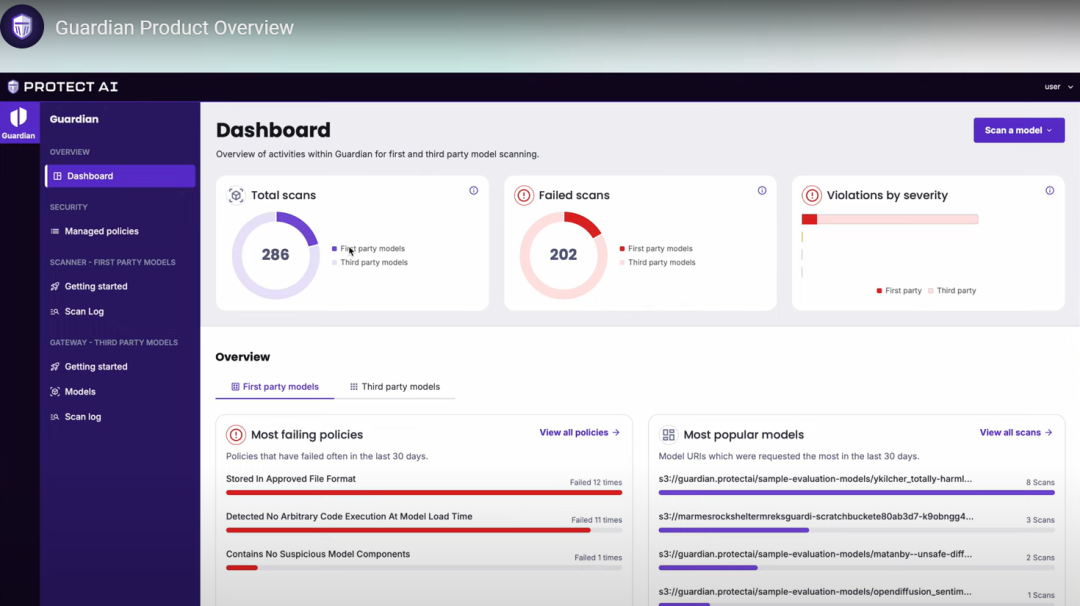

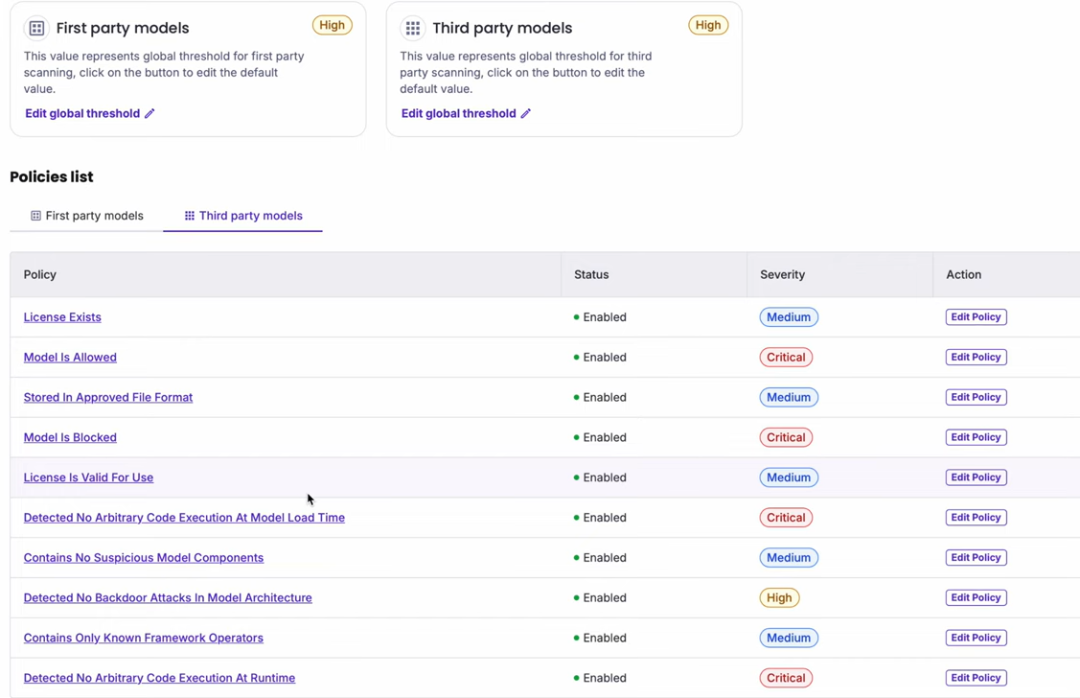

Guardian主要使用LLM_Guard的核心技术,但产品化能力也有增强,以下是产品界面

主要能力就是策略和扫描,但界面看上去很不错。好用的界面,加上丰富的策略和管理能力,这是与开源不一样的地方。

可配置、可定制的策略

Guardian 为您的团队提供灵活的策略,可针对第一方和第三方模型进行定制。针对模型元数据、已批准格式、已验证来源和安全发现的细粒度安全规则,可实现符合您特定安全需求和风险承受能力的全面治理。

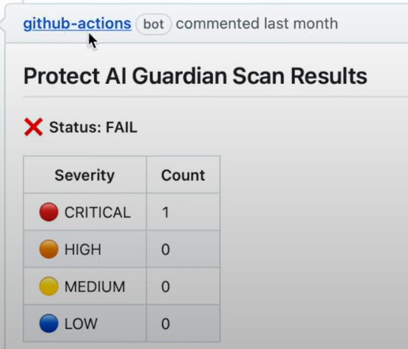

除以上外,还有与与CI/CD流程的结合及持续的数据能力

甚至能集成到笔记(Jupyter Notebook )中扫描。

Guardian 持续扫描 Hugging Face 上的所有公开模型(迄今为止已超过 150 万个),以防范新兴模型风险。此集成使您的团队能够安心采用开源模型,同时保持安全标准,在扫描过程中也积累大量的一手数据。

Huggingface是它的伙伴。也是数据来源和客户来源。

05 平台产品2 :Recon 红队扫描器

这是一个针对AI及AI应用的扫描器。

扫描范围

Recon 的庞大攻击库涵盖六大威胁类别,并持续更新以应对零日漏洞和新兴攻击技术。Recon 使用经过训练的 LLM 作为检测器,不仅提供覆盖范围,还提供准确性,确保您的系统始终免受各种不断演变的漏洞的攻击,同时降低误报率。

六类扫描包括越狱,提示词注入,安全性(safety),逃逸(Evasion),对抗性后缀(Adversarial Suffix)和系统提示词泄露。

能力特点:

Recon 测试 AI 应用,而不仅仅是模型。Recon 的代理会创建相关的攻击,利用一系列输入,从应用程序的业务目标到基础模型、已部署的防护机制、RAG 管道以及相关的系统提示。

红队成员可以与 Recon 协同工作,使用自然语言设定攻击目标,无需任何代码。Recon 提供深入的对话级可视性,以支持风险分析和补救。

自带攻击提示。通过运行自定义攻击提示集,增强您的安全评估。用户可以上传定制的提示来模拟特定的威胁场景,这些提示由我们专有的检测算法提供支持,能够精确反映您环境的独特需求。

报告和框架映射.Recon 可轻松将结果导出为 CSV 和 JSON,从而实现跨团队快速有效的协作。漏洞还会映射到标准框架,例如 OWASP Top 10 for LLM、DASF 等,从而快速轻松地满足合规性标准。

06 平台产品3 Layer(层?)

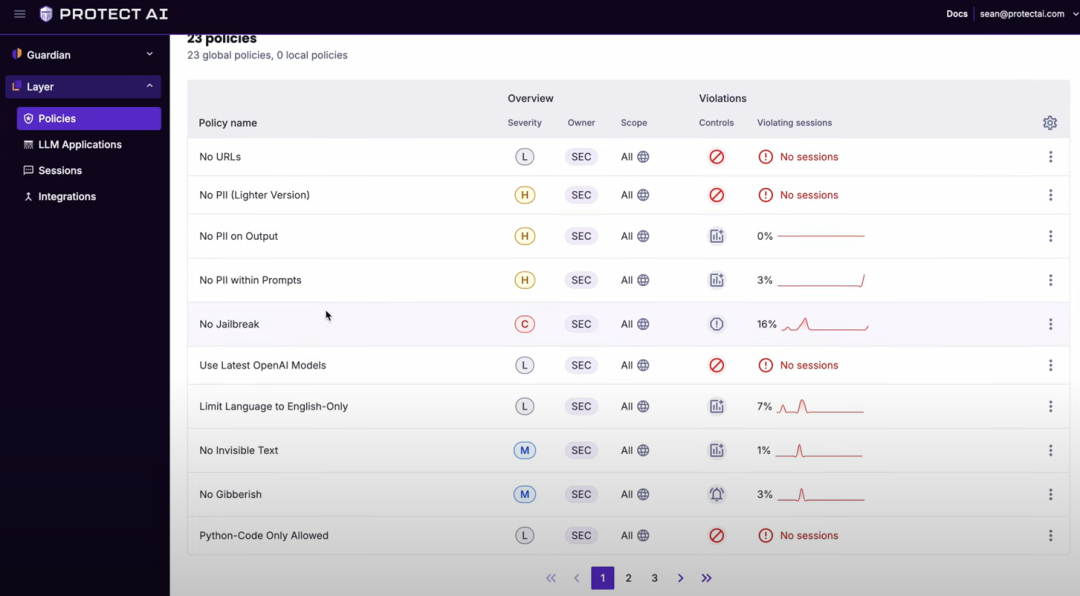

Layer被定位于面向未来人工智能的运行时安全,类似于现在的EDR,实时检测与控制,也就是说,具备拦截能力。

Layer 提供 27 种基于 15 种不同安全扫描程序的交钥匙策略,无论攻击技术如何,都能提供广度和深度的拦截能力。Layer 不仅监控提示和输出,还跟踪整个对话流程,包括工具、函数调用、下游工作流、多轮攻击和元数据。

重点是对应用的拦截和保护。

看上去拦截能力还可以,可以在会话中发现问题并控制。

07 总结

从AI防护的角度看,Protect AI提供了非常完整的方案。尤其是Layer,对未来应用的保护思路非常好。

从技术能力上看,两个开源做得都还不错,(modelscan 480 星,llm guard 1700星)

对Huggingface上模型的持续扫描,积累数据,同时也产生很好的影响力。

团队很好,创始人,CEO Ian Swanson,前AWS全球AI和机器学习的Leader, President Daryan D. 是前AWS 全球AI和机器学习解决方案架构师,CTO Badar Ahmed 领导Oracle 云的数据科学服务团队。CISO Diana 曾担任微软网络安全领域首席技术官、IBM Security 全球执行安全顾问、赛门铁克总经理。

Buff 叠满,是该值钱。

声明:本文来自AI与安全,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。