前情回顾·AI数据威胁态势

安全内参9月12日消息,美国网络安全机构Cybernews的研究人员发现,一个Vyro AI与相关的Elasticsearch实例未受保护在公网暴露。Vyro AI开发了多个在安卓和iOS平台上有超高下载量的生成式AI应用。

Vyro AI总部位于巴基斯坦,声称其应用总下载量超过1.5亿,每周可生成350万张图片。

这台公开的服务器实时泄露了该公司旗下三款应用的116GB用户日志,包括ImagineArt(在Google Play上的下载量超过1000万)、Chatly(下载量超过10万)以及Chatbotx(一款网页聊天机器人,月访问量约5万)。

此次泄露涉及生产与开发环境,存储了大约2至7天的日志。

研究人员指出,该数据库在2月中旬首次被网络测绘搜索引擎索引。这说明,数据库早在数月前就已经对攻击者可见。

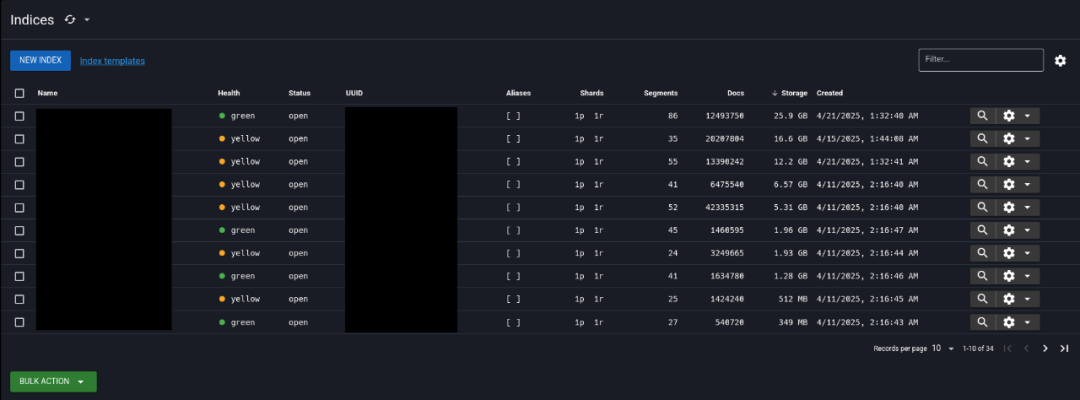

图:Elasticsearch索引

Vyro AI究竟泄露了哪些数据?

用户在应用中输入的AI提示词

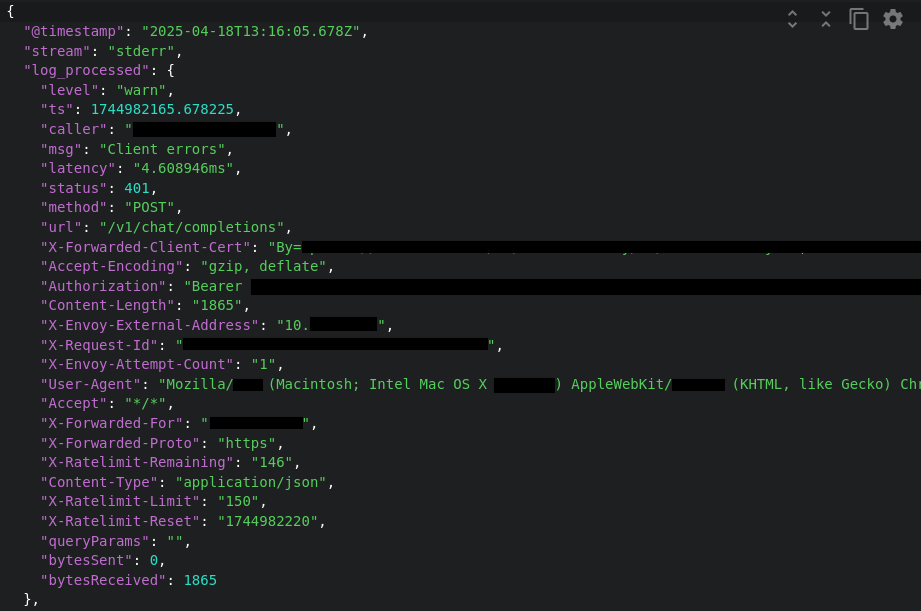

持有者身份验证令牌

用户代理信息

Cybernews研究人员解释称:“这次泄露问题极为严重,因为它不仅能用来监控用户行为,还可提取用户与AI模型分享的敏感信息,甚至可能导致账号被劫持。”

仅ImagineArt的体量就足以令人担忧。该应用在安卓平台的安装量超过1000万,活跃用户据称已超过3000万。泄露的令牌对黑客而言无异于一座宝库,他们可以轻而易举地利用这些数据锁定并接管用户账号。

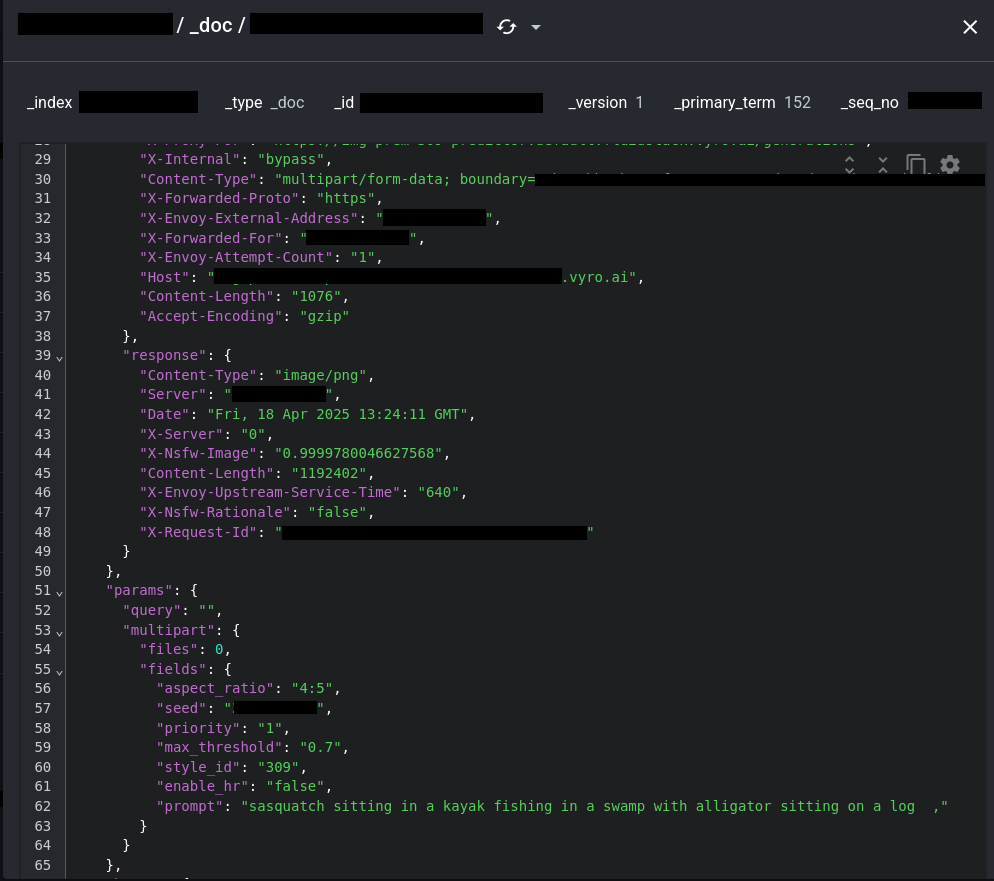

图:泄露的用户AI提示词

图:泄露的用户AI提示词(包含个人身份信息)

研究团队补充道:“一旦账号被接管,攻击者可能获取完整的聊天记录和生成的图片,甚至利用账号进行非法的AI token数量购买,而这些token还可能被用于恶意目的。”

用户输入给AI的提示词泄露同样值得警惕。与AI的互动往往包含隐私或私人内容,这些提示词一旦外泄,可能暴露出用户绝不会公开的信息。

AI安全性仍未受到足够重视

这起事件再次凸显了快速发展的AI行业面临不断扩大的安全缺口。一些AI初创公司在激烈的市场竞争中,往往忽视安全环节。然而,随着越来越多人将思想、创意乃至机密数据输入生成式AI系统,安全风险持续升高。

今年8月,用户惊讶地发现他们与ChatGPT和Grok的部分对话被Google搜索引擎收录。这些泄露源于一个存在安全隐患的功能,该功能允许用户分享对话链接,而链接一旦生成,就可能被搜索引擎抓取。OpenAI随后已移除此功能。

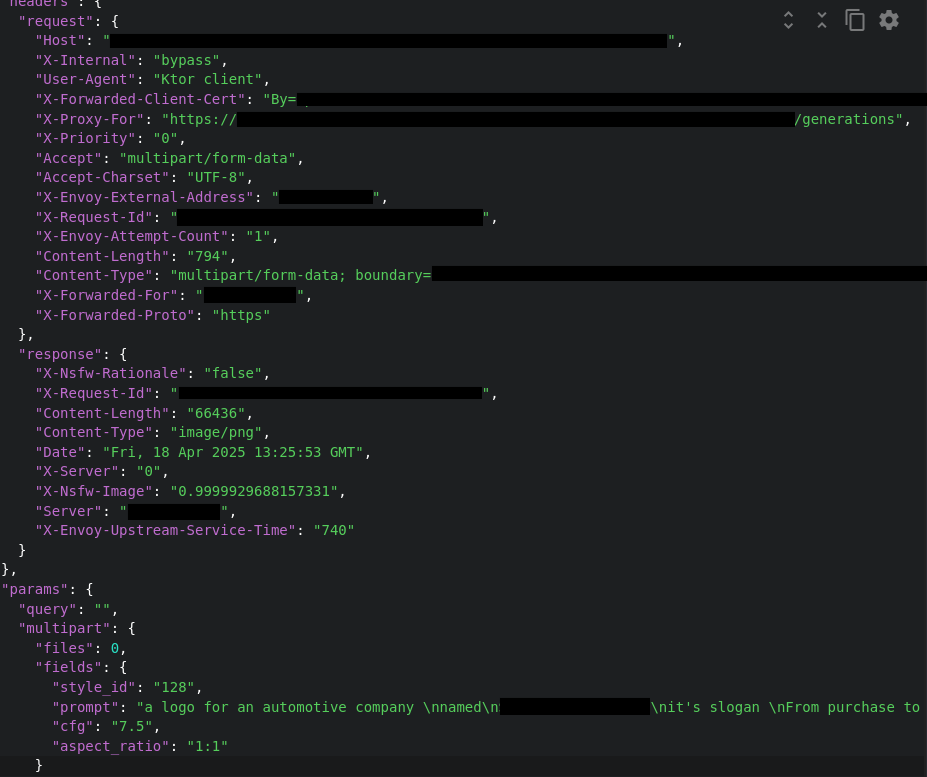

图:包含身份验证令牌和用户代理的用户HTTP请求

最近,Cybernews的研究还发现,旅游巨头Expedia推出的一款AI聊天机器人,在输入特定提示词后,竟会教用户如何制造燃烧瓶。这一发现揭示了在缺乏有效防护措施的情况下推出客服聊天机器人,可能给企业带来法律、财务及声誉风险。

虽然大多数AI聊天机器人会预设过滤机制以避免敏感或危险话题,但若缺乏可靠的安全措施,AI模型仍有可能失控。

这种缺乏防护措施的情况甚至影响到OpenAI这样的AI巨头。该公司也一直被有效防护问题困扰。在推出其最新模型GPT-5后,不到24小时,多支安全团队就成功对其聊天机器人进行了越狱。

参考资料:https://cybernews.com/security/ai-chatbots-vyro-data-leak/

声明:本文来自安全内参,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。