欧洲政策研究中心(CEPS)近期发布报告《人工智能的伦理、治理和政策挑战》。这份长达150多页的报告汇聚了学术界、决策层以及各行业人士关于欧洲人工智能发展的看法,共分为三大部分。报告首先宽泛地论述了人工智能的定义、应用限制和机遇,进而较为系统地分析了欧洲目前在人工智能领域的政策和准则的发展,提出了欧洲伦理指南的内容框架,并针对此前欧盟人工智能高级专家组发布的《可信人工智能伦理指南草案》提出了改善意见。最后,报告总结了针对未来伦理指南草案以及欧盟政策与投资优先事项所提出的若干建议。

第一部分 人工智能的定义、应用限制和机遇

报告第一部分深化了对人工智能的定义,简述其目前的发展水平以及未来可能的发展,并通过定义与人工智能紧密相关、不断发展的技术和应用程序堆栈(如高性能计算、大数据分析和物联网),将其置于更广阔的环境背景中。

报告认为,人工智能不会孤立存在,而将始终作为IT系统的一部分。目前,人工智能已经在许多领域得到大量使用,并且可以在许多子领域和技术中进行细分。在互联网经济之外的许多特定领域,各种用例正在快速出现。但与此同时,存在对人工智能的恶意使用和人工智能的非故意偏见,这需要各国采取行动促进人工智能的负责任和值得信赖的使用。

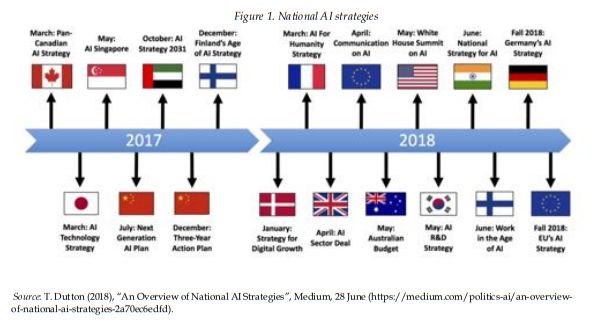

各国人工智能战略

此外,报告确定了人工智能应该采取的三个主要方向,以便与人类的利益保持一致:人机互补,责任和可持续性。其中,人机互补应当有相适应的法律系统进行辅佐;责任和可信人工智能需要应对偏见(数据偏见、响应或汇报偏见、设计偏见、社会偏见)和价值定位问题;可持续性需要从社会可持续性和环境可持续性两个维度考虑。这三者都需要公众和私营部门持续关注,并成为世界各地各种倡议和宣言的目标。

第二部分 全球人工智能竞赛中的欧洲

报告的第二部分站在欧盟的立场,基于人与机器的互补性来制定人工智能愿景。通过思考“人工智能可以为欧洲做什么”而不是“欧洲可以为人工智能做什么”,反思人工智能为法律体系和欧盟政策整体架构带来的影响,并提出人工智能符合欧盟2030议程的发展方式。

人工智能领域细分

即将出台的欧盟伦理准则应该包括四个主要部分:1)针对负责、可靠、可持续的人工智能,欧盟的价值观和原则;2)人工智能应用和用例清单,包括应用所确定的原则过程中存在的问题,以及人工智能系统并未引起特定伦理问题的用例;3)人工智能开发人员、供应商、分销商和部署人工智能的组织可能采取的措施的指导,以检查其启用人工智能的应用程序和系统是否符合伦理准则;4)若违反欧盟法律强制要求履行的原则,用户的权利和可能的强制措施以及获得补救的渠道。

其中,在第一部分的原则中,报告认为欧盟委员会应在三个不同层面确定核心价值观和原则:

第一层面:基本原则(合法人工智能)。第一层面的原则基于欧盟的核心价值观,对于人工智能开发商、供应商、分销商和部署人工智能的组织而言是强制性的。这些原则应包括:“无害”;保护人的完整、安全和隐私;保障人的尊严,包括使人不受歧视;保护能动性、自由和民主进程。

第二层面:人工智能开发的良好实践(负责任的人工智能)。作为初步清单,第二层面应包括以下原则:与人类互补的原则(“以人为本的人工智能”);负责任和敏捷的治理;监测、控制和反馈实践;人工智能透明度和可解释性原则。

第三层面:可持续人工智能的原则(可持续人工智能)。作为初步清单,第三层面包括以下内容:“向善”或“仁慈”原则;有限或零碳足迹的人工智能;促进包容性增长、充分和生产性就业以及为所有人提供体面工作的人工智能;推动素质教育的人工智能;促进妇女权力的人工智能;有助于工业、创新和基础设施的人工智能。在某些情况下,欧盟可能要求,例如公共行政部门使用的人工智能遵循这些原则。

欧盟《可信人工智能伦理指南草案》

报告随后探讨了2018年12月发布的《可信人工智能伦理指南草案》,并建议欧盟委员会为人工智能开发人员、供应商和分销商以及部署人工智能的组织发布指南,解释并收集以下领域的优秀/不良实践:数据筛选、抽样、管理和清洗;算法设计;机器训练和反馈;算法输出以及对不良结果和影响的响应。

报告并非提倡进行彻底改变,而是研究现有的立法,以发现由于启用人工智能系统和环境而导致规则可能过时的情况。此外,报告探讨欧洲可能的工业和创新政策方案,以提高其在人工智能领域的竞争力,其中包括建立人工智能领域的CERN(欧洲核子研究组织)以及发布“IT使命(Mission IT)”,该使命将协调各类教育、研究和创新,以便将人工智能融入欧洲可持续的未来愿景中。

第三部分 未来方向

报告分别针对伦理指南草案和欧盟未来的政策和投资优先事项,共计提出44条建议,例如:

欧盟未来的人工智能伦理指南应主要针对“供应方”,包括人工智能开发人员、供应商和分销商、以及使用或部署人工智能的组织。

目前伦理指南草案中所定义的无害原则对于政策制定者而言可操作性低。

目前不建议采用人工智能公共认证,或在欧洲采取强制性人工智能标准。

人工智能产品和服务的责任不应基于过错制,而应基于相对严格的责任制,特别是对于B2C用例。

未来的欧盟责任制度也必须与适当的保险框架相结合。

政府应采用开放数据政策,向公众提供大型数据集,并采用可与现有机器学习软件互操作的格式。

现阶段应避免对数据访问更为严格的管理。

欧洲应避免在各方面与美国、日本、韩国和中国竞争。

查看报告原文:https://www.ceps.eu/system/files/AI_TFR.pdf

声明:本文来自赛博安全,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。